一、项目打包

项目依赖maven、jdk8.0、前端(node、npm)

//下载代码

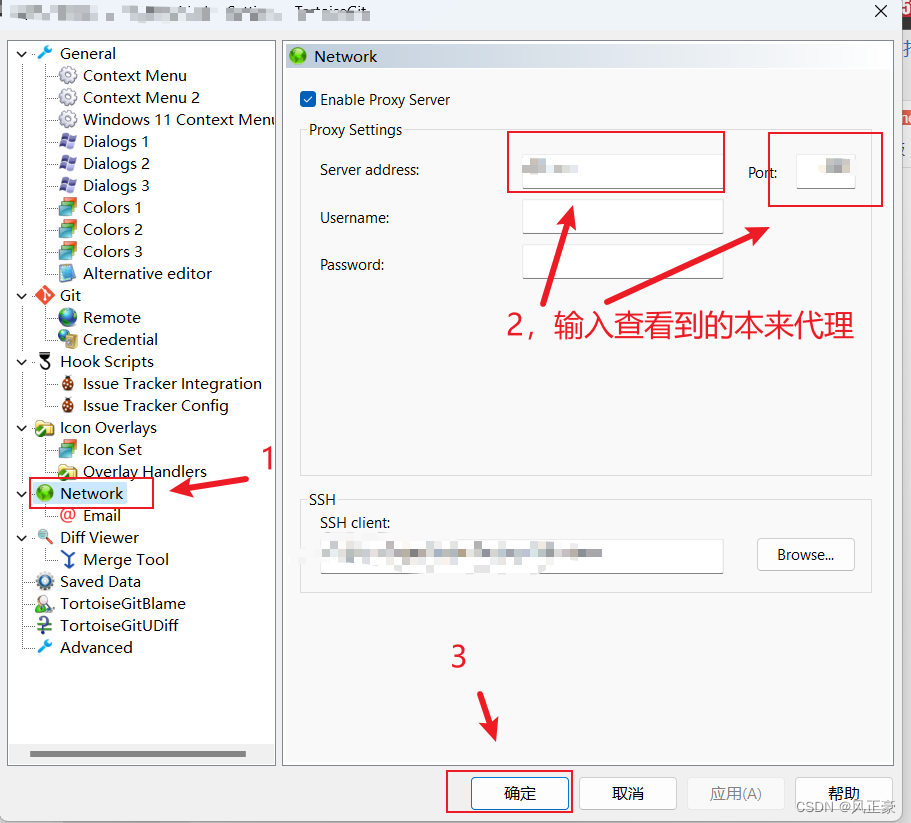

git clone

//maven打包相关内容

mvn -N io.takari:maven:wrapper

//前端打包相关内容

curl -sL https://rpm.nodesource.com/setup_16.x | bash -

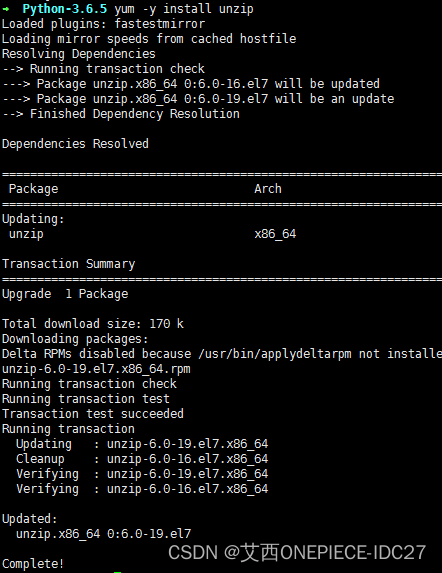

yum -y install nodejs

npm -v

npm install -g pnpm

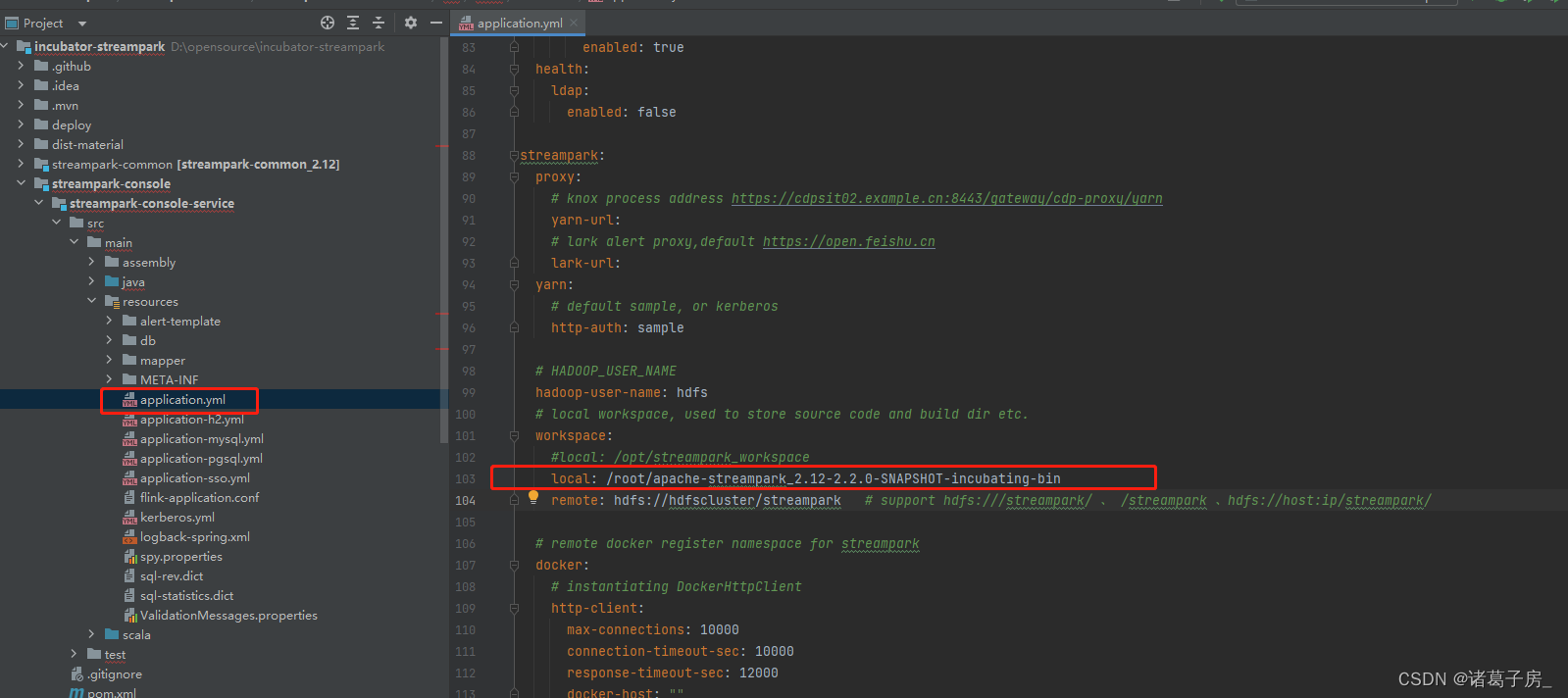

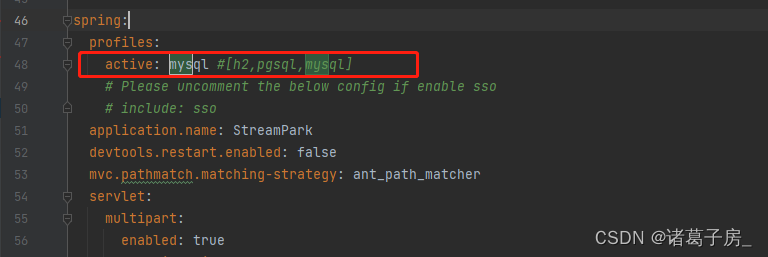

默认是h2(内存数据库,项目重新启动,数据库信息丢失),因此建议修改为mysql,同时workspace路径目录也需要修改

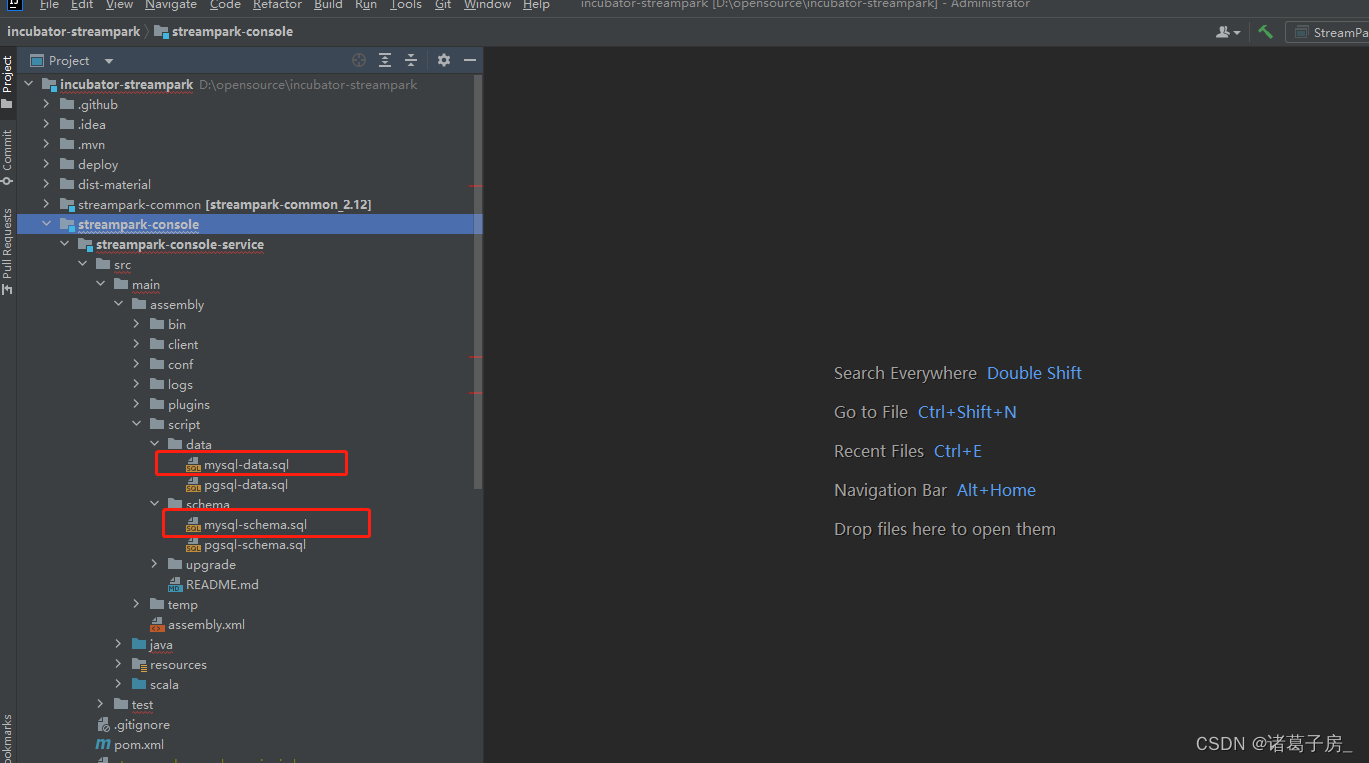

最后在mysql数据中分别执行schema和data文件,就可以正常访问streampark

修改上述配置文件信息再进行打包

//执行打包命令

sh build.sh打包完成之后

tar -zxvf apache-streampark-2.2.0-SNAPSHOT-incubating-bin.tar.gz

cd apache-streampark_2.12-2.2.0-SNAPSHOT-incubating-bin

#启动

sh bin/startup.sh

#停止

sh bin/bin/shutdown.sh访问http://ip:10000 没问题即认为启动无误

二、集群配置信息

Flink 单机版本本地安装,注意StreamPark remote 模式

wget https://dlcdn.apache.org/flink/flink-1.14.5/flink-1.14.5-bin-scala_2.12.tgz

tar -zxvf flink-1.14.5-bin-scala_2.12.tgz

cd flink-1.14.5

./bin/start-cluster.sh访问 http://ip:8081 认为无误

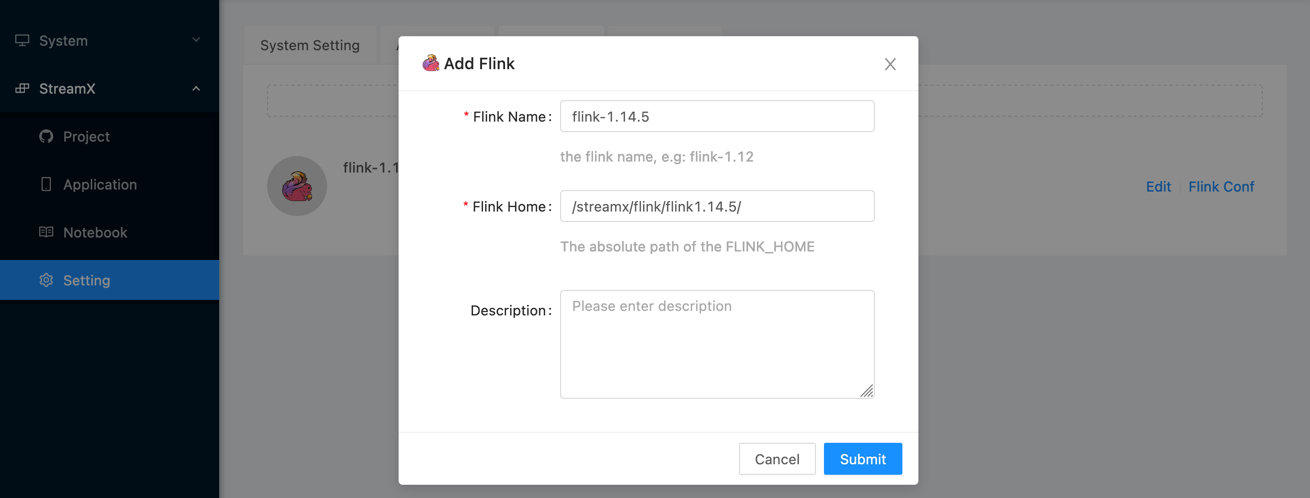

Flink Home 配置:/root/flink/flink-1.14.5 上述flink 的安装路径

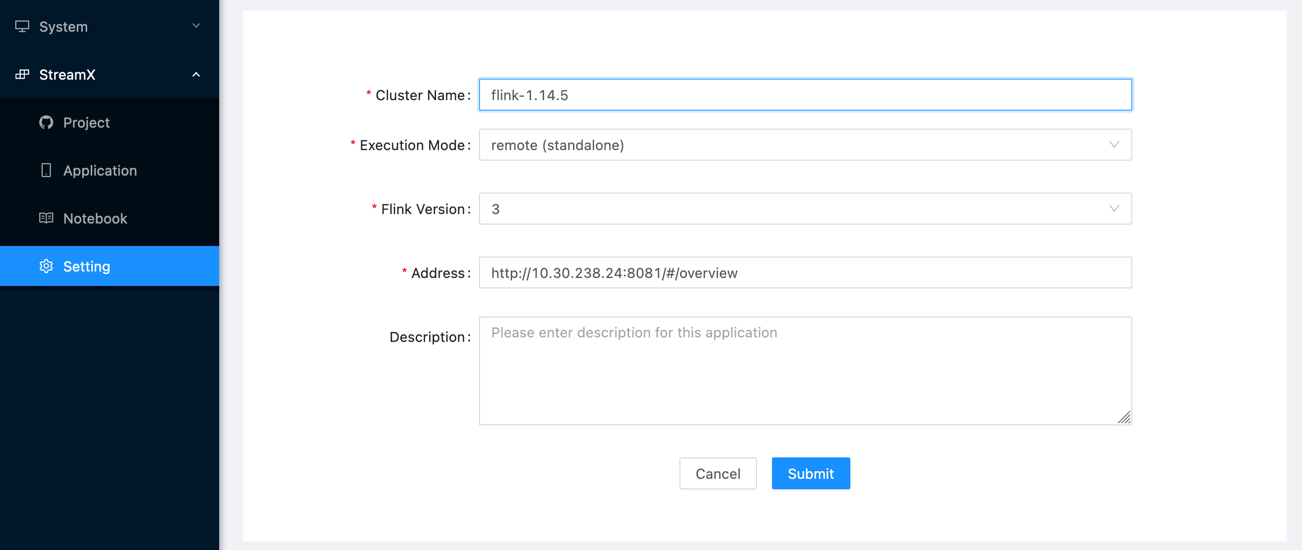

集群配置:http://localhost:8081 或者宿主机ip

修改Application里面自带的Flink SQL demo 任务,即可成功运行

修改完成之后点击release(发布作业)然后start(启动作业),任务即可启动成功。

备注:Flink SQL demo会运行一段时间之后自动结束,因为代码里面设置自动生成数据是增量数据,如果想任务一直运行

去掉自增设置同时改为最小和最大值成为随机数

'fields.f_sequence.min'='1',

'fields.f_sequence.max'='500',这样job就能一直运行起来 ,而不会运行一段时间就停止了。