论文名称:Grad-CAM: Visual Explanations from Deep Networks via Gradient-based Localization

论文下载地址:https://arxiv.org/abs/1610.02391

推荐代码(Pytorch):https://github.com/jacobgil/pytorch-grad-cam

bilibili视频讲解:https://b23.tv/1kccjmb

版权声明:本文为CSDN博主「太阳花的小绿豆」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/qq_37541097/article/details/123089851

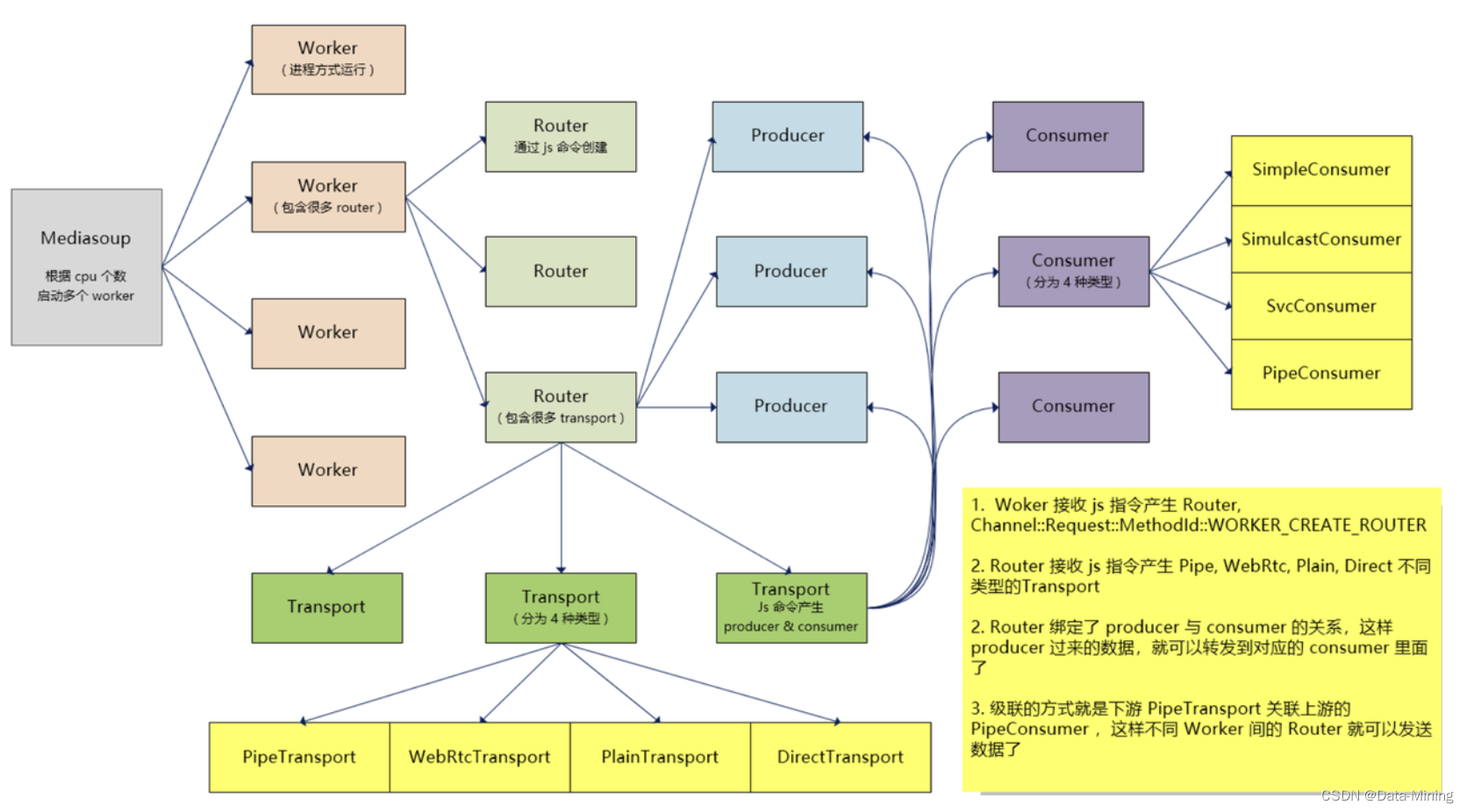

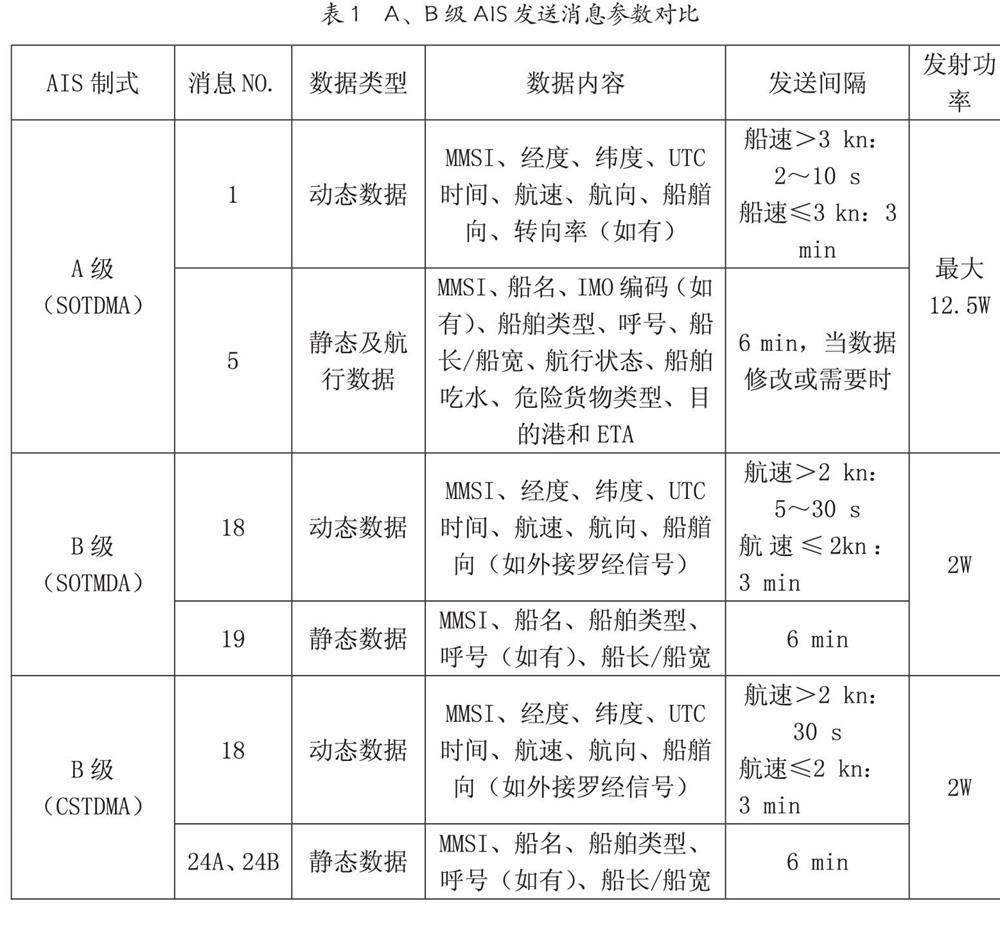

对于常用的深度学习网络(例如CNN),普遍认为是个黑盒可解释性并不强(至少现在是这么认为的),它为什么会这么预测,它关注的点在哪里,我们并不知道。很多科研人员想方设法地去探究其内在的联系,也有很多相关的论文。今天本文简单聊一聊Grad-CAM,这并不是一篇新的文章,但很有参考意义。通过Grad-CAM我们能够绘制出如下的热力图(对应给定类别,网络到底关注哪些区域)。Grad-CAM(Gradient-weighted Class Activation Mapping)是CAM(Class Activation Mapping)的升级版(论文3.1节中给出了详细的证明),Grad-CAM相比与CAM更具一般性。CAM比较致命的问题是需要修改网络结构并且重新训练,而Grad-CAM完美避开了这些问题。本文不对CAM进行讲解,有兴趣的小伙伴自行了解。

作者的想法还是比较简单的,参见下图。这里我们简单看下Image Classification任务,首先网络进行正向传播,得到特征层A AA(一般指的是最后一个卷积层的输出)和网络预测值y yy(注意,这里指的是softmax激活之前的数值)。假设我们想看下网络针对Tiger Cat这个类别的感兴趣区域,假设网络针对Tiger Cat类别的预测值为y c y^cy

c

。接着对y c y^cy

c

进行反向传播,能够得到反传回特征层A AA的梯度信息A ˊ \acute{A}

A

ˊ

。通过计算得到针对特征层A AA每个通道的重要程度,然后进行加权求和通过R e L U ReLUReLU就行了,最终得到的结果即是Grad-CAM。

————————————————

版权声明:本文为CSDN博主「太阳花的小绿豆」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/qq_37541097/article/details/123089851