在网络爬虫和数据采集过程中,代理服务器扮演着重要的角色。然而,代理服务器的可用性经常会受到影响,给爬虫工作带来一定的挑战。本文将介绍如何使用Python自动化测试代理程序的可用性,为您提供具备实际操作价值的解决方案。让我们一起来探索,提高您的爬虫效率!

在网络爬虫中,代理服务器用于隐藏真实IP地址、绕过访问限制、提高请求速度等。然而,代理服务器的可用性是一个关键问题。有时代理服务器可能无法连接、速度缓慢或被封禁,这会导致爬虫工作受阻。因此,我们需要一种方法来自动测试代理程序的可用性。

首先,确保您已经安装了Python,并安装以下库:requests、beautifulsoup4和lxml。这些库将帮助我们发送请求和解析HTML页面。

下面是一个简单的Python代码示例,用于测试代理服务器的可用性:

```python

import requests

def test_proxy(proxy):

try:

response = requests.get("https://www.example.com", proxies={"http": proxy, "https": proxy}, timeout=5)

if response.status_code == 200:

print(f"Proxy {proxy} is working fine.")

else:

print(f"Proxy {proxy} returned status code {response.status_code}.")

except requests.exceptions.RequestException:

print(f"Proxy {proxy} is not working.")

# 测试代理可用性

test_proxy("http://your_proxy_ip:your_proxy_port")

```

通常,我们会有一个代理列表,包含多个代理服务器。我们可以使用Python的文件读取和循环结构来解析代理列表,并依次测试每个代理的可用性。

```python

def test_proxy_list(file_path):

with open(file_path, "r") as file:

proxies = file.readlines()

for proxy in proxies:

proxy = proxy.strip() # 去除换行符和空格

test_proxy(proxy)

```

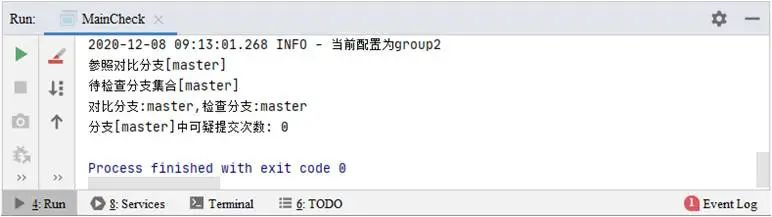

通过运行上述代码,我们可以自动化地测试代理服务器的可用性。根据测试结果,我们可以判断哪些代理可用,哪些代理存在问题。

根据测试结果,您可以选择保留可用的代理,并排除不可用的代理。这将有助于提高爬虫的效率和稳定性。

通过使用Python自动化测试,我们可以更好地管理和维护代理服务器,提高爬虫的效率和稳定性。

希望本文能够为您提供有价值的解决方案,帮助您更好地应对代理的挑战。如果您有任何问题或疑惑,欢迎随时留言,我们将竭诚为您解答。祝您的爬虫工作顺利!