多维时序 | MATLAB实现WOA-CNN-BiGRU-Attention多变量时间序列预测

目录

- 多维时序 | MATLAB实现WOA-CNN-BiGRU-Attention多变量时间序列预测

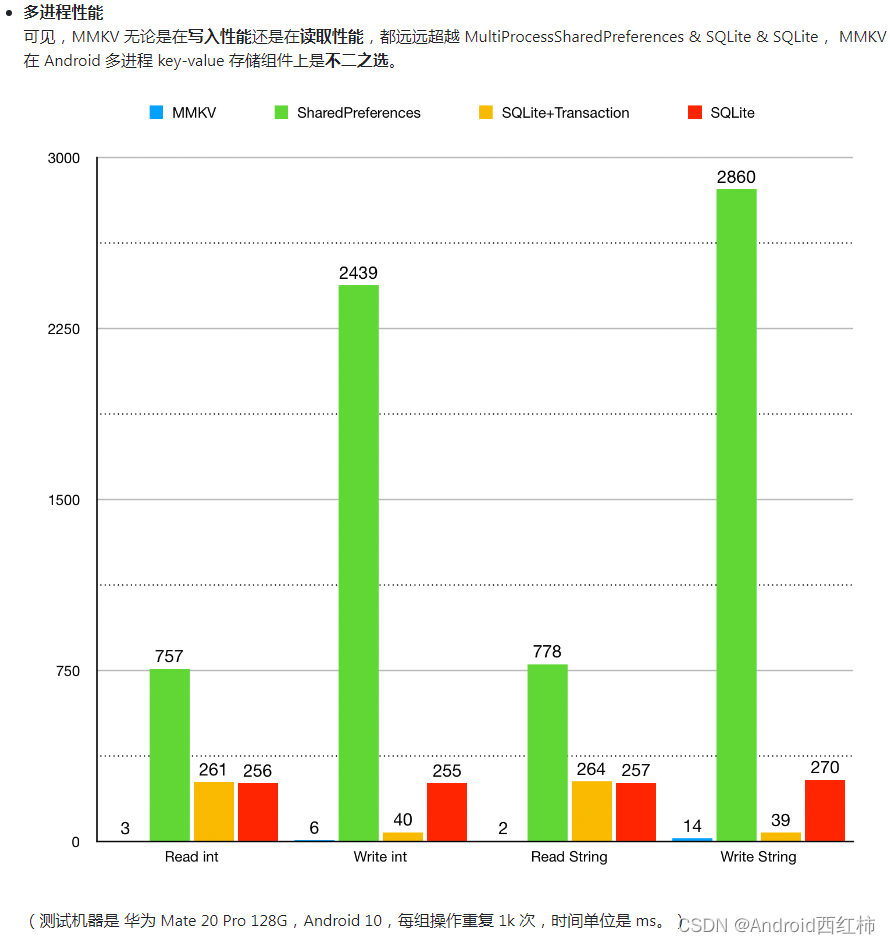

- 预测效果

- 基本介绍

- 模型描述

- 程序设计

- 参考资料

预测效果

基本介绍

多维时序 | MATLAB实现WOA-CNN-BiGRU-Attention多变量时间序列预测

1.程序平台:无Attention适用于MATLAB 2020版及以上版本;融合Attention要求Matlab2023版以上

2.代码说明:基于鲸鱼优化算法(WOA)、卷积神经网络(CNN)和双向门控循环单元网络(BiGRU)融合注意力机制的超前24步多变量时间序列回归预测算法;

3.多变量特征输入,单序列变量输出,输入前一天的特征,实现后一天的预测,超前24步预测;

4.通过WOA优化算法优化学习率、卷积核大小、神经元个数,这3个关键参数,以最小MAPE为目标函数;

5.提供MAPE、RMSE、MAE等计算结果展示。

6.适用领域:风速预测、光伏功率预测、发电功率预测、碳价预测等多种应用。

7.使用便捷:直接使用EXCEL表格导入数据,无需大幅修改程序。内部有详细注释,易于理解。

模型描述

WOA-CNN-BiGRU鲸鱼算法优化卷积双向门控循环单元多输入单输出回归预测"是一个复杂的算法模型,可以用于回归预测问题,下面对其进行解释:

WOA-CNN-BiGRU鲸鱼算法:这是一种基于鲸鱼优化算法的神经网络优化算法,用于优化神经网络的参数。

多输入单输出:该模型接受多个输入,并输出一个预测结果。

回归预测:该模型用于回归问题,即预测连续值输出。

综上所述,该算法模型可以将多个输入数据传入模型,通过卷积神经网络提取特征,然后通过双向门控循环单元处理序列数据中的长期依赖关系,最后将处理后的数据进行回归预测,输出一个连续值结果。通过鲸鱼优化算法对神经网络的参数进行优化,提高预测准确率。

程序设计

- 完整源码和数据获取方式:私信博主回复MATLAB实现WOA-CNN-BiGRU-Attention多变量时间序列预测。

%% 获取最优种群

for j = 1 : SearchAgents

if(fitness_new(j) < GBestF)

GBestF = fitness_new(j);

GBestX = X_new(j, :);

end

end

%% 更新种群和适应度值

pop_new = X_new;

fitness = fitness_new;

%% 更新种群

[fitness, index] = sort(fitness);

for j = 1 : SearchAgents

pop_new(j, :) = pop_new(index(j), :);

end

%% 得到优化曲线

curve(i) = GBestF;

avcurve(i) = sum(curve) / length(curve);

end

%% 得到最优值

Best_pos = GBestX;

Best_score = curve(end);

%% 得到最优参数

NumOfUnits =abs(round( Best_pos(1,3))); % 最佳神经元个数

InitialLearnRate = Best_pos(1,2) ;% 最佳初始学习率

L2Regularization = Best_pos(1,1); % 最佳L2正则化系数

%

inputSize = k;

outputSize = 1; %数据输出y的维度

% 参数设置

opts = trainingOptions('adam', ... % 优化算法Adam

'MaxEpochs', 20, ... % 最大训练次数

'GradientThreshold', 1, ... % 梯度阈值

'InitialLearnRate', InitialLearnRate, ... % 初始学习率

'LearnRateSchedule', 'piecewise', ... % 学习率调整

'LearnRateDropPeriod', 6, ... % 训练次后开始调整学习率

'LearnRateDropFactor',0.2, ... % 学习率调整因子

'L2Regularization', L2Regularization, ... % 正则化参数

'ExecutionEnvironment', 'gpu',... % 训练环境

'Verbose', 0, ... % 关闭优化过程

'SequenceLength',1,...

'MiniBatchSize',10,...

'Plots', 'training-progress'); % 画出曲线

参考资料

[1] https://blog.csdn.net/kjm13182345320/article/details/128577926?spm=1001.2014.3001.5501

[2] https://blog.csdn.net/kjm13182345320/article/details/128573597?spm=1001.2014.3001.5501