机器学习|Softmax 回归的数学理解及代码解析

Softmax 回归是一种常用的多类别分类算法,适用于将输入向量映射到多个类别的概率分布。在本文中,我们将深入探讨 Softmax 回归的数学原理,并提供 Python 示例代码帮助读者更好地理解和实现该算法。

Softmax 回归数学原理

Softmax 函数将输入向量的线性得分转换为每个类别的概率。给定一个输入向量 x,有如下公式计算 Softmax 函数的输出:

P ( y = j ∣ x ) = e x j ∑ k = 1 K e x k P(y=j \mid x) = \frac{e^{x_j}}{\sum_{k=1}^{K} e^{x_k}} P(y=j∣x)=∑k=1Kexkexj

其中, P ( y = j ∣ x ) P(y=j \mid x) P(y=j∣x) 表示输入向量 x 属于类别 j 的概率, x j x_j xj 是 x 的第 j 个元素, K K K 是总的类别数。

Softmax 回归示例代码

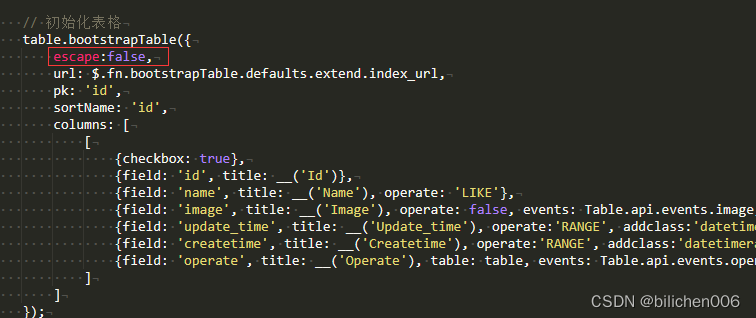

下面是使用 Python 编写的一个简单的 `Softmax 回归示例代码:

import numpy as np

import matplotlib.pyplot as plt

def softmax(z):

exp_scores = np.exp(z)

probs = exp_scores / np.sum(exp_scores)

return probs

# 生成一组随机的线性得分

z = np.array([3.0, 1.0, 0.2])

# 计算 softmax 函数的输出

probs = softmax(z)

# 打印每个类别的概率

labels = ['Apple', 'Orange', 'Banana']

for label, prob in zip(labels, probs):

print(label + ' probability:', prob)

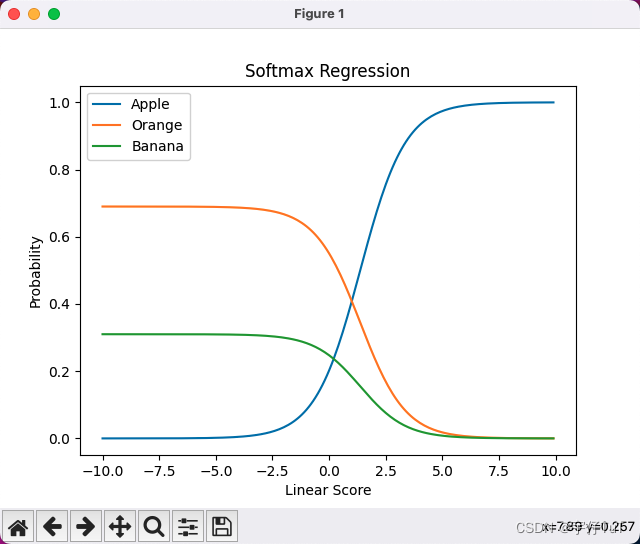

# 绘制函数图像

x = np.arange(-10, 10, 0.1)

y = np.zeros((len(x), len(labels)))

for i, val in enumerate(x):

z = np.array([val, 1.0, 0.2])

probs = softmax(z)

y[i] = probs

plt.plot(x, y[:, 0], label='Apple')

plt.plot(x, y[:, 1], label='Orange')

plt.plot(x, y[:, 2], label='Banana')

plt.xlabel('Linear Score')

plt.ylabel('Probability')

plt.title('Softmax Regression')

plt.legend()

plt.show()

在示例代码中,我们首先定义了一个 softmax 函数,用于计算 Softmax 函数的输出。然后,我们生成了一个随机的线性得分向量 z,并调用 softmax 函数获得每个类别的概率。最后,我们打印出每个类别的概率值。

该程序绘制的函数图像

结语

通过本文,我们详细讲解了 Softmax 回归的数学原理,并提供了一个简单的 Python 示例代码展示了如何实现该算法。希望本文能够帮助读者更好地理解 Softmax 回归,并能够应用到实际问题中。

如果你对 Softmax 回归或其他机器学习算法有任何疑问或想法,请在评论区留言,期待与大家的交流讨论!