-

论文题目:Spatio-temporal Relation Modeling for Few-shot Action Recognition

-

论文连接:https://arxiv.org/abs/2112.05132v2

-

代码连接:https://github.com/Anirudh257/strm

综述

我们提出了一种few-shot动作识别框架STRM,它在学习高阶时间表示的同时,增强了特定类特征的区分能力。我们的方法的重点是一个新的时空增强模块,它将空间和时间上下文与专用的局部帧级别和全局帧级别特征丰富子模块聚合在一起。局部帧级别的扩展捕获基于外观的动作特征。另一方面,全局帧级扩展明确编码了广泛的时间上下文,从而捕获了随时间推移的相关对象特征。然后,利用得到的时空丰富表示来学习查询和支持动作子序列之间的关系匹配。我们进一步在帧级丰富的特征上引入query类相似性分类器,通过在所提出的框架中的不同阶段加强特征学习来增强特定类特征的可区分性。在四个不同的少样本动作识别数据基准上进行了实验:Kinetics、SSv2、HMDB51和UCF101,我们所提的方法达到最佳水平。

少样本动作识别简介

少镜头(FS)动作识别是一个具有挑战性的计算机视觉问题,其任务是将未标记的视频分类为数据集中具有有限样本的动作类别之一。其识别问题与细粒度动作识别特别相关,因为收集足够多的标记示例是一项挑战。大多数现有的FS动作识别方法通常搜索单个支持视频或支持类视频的平均表示。然而,这些方法仅利用帧级表示,而不显式地利用视频子序列进行时间关系建模。

STRM算法介绍

-

动机:它致力于增强类特定特征的可辨别性,同时减轻灵活性问题。

-

特征可辨别性:与仅关注时间关系建模的TRX不同,我们的方法强调了在建模时间关系之前聚合空间和时间上下文以有效丰富视频子序列表示的重要性。学习丰富的空间和时间关系之后的局部表示能够增强特征的可分辨性,从而有效利用可用于FS动作识别的有限样本。

-

模型灵活性:我们提出的方法学习以较低的基数对高阶关系进行建模,减少了归纳偏差,从而提高了模型的灵活性。

STRM总体框架

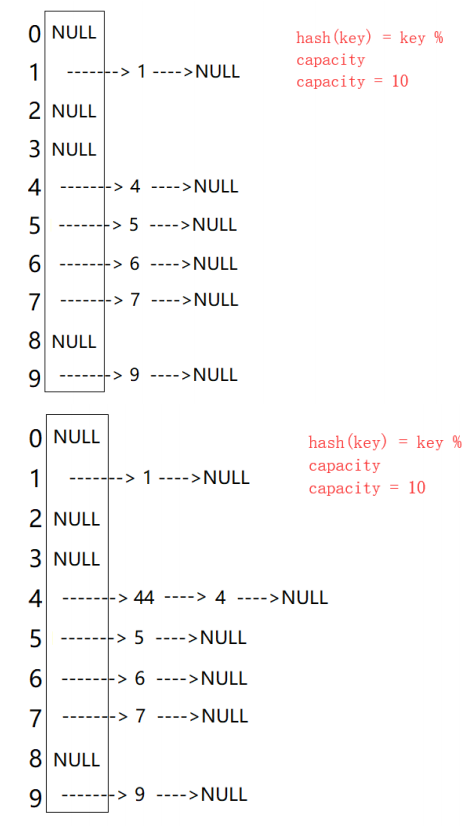

如上图所示,长度为L的视频帧通过一个图像特征提取器输出一个空间分辨率为PxP、维度为D的特征图,然后再把它展开成P^2xD的平面图。接下来,该特征图Xi输入到本文提出的PLE(Patch-Level enrichment)模块,该模块关注帧中patches的空间上下文信息,并输出空间特征丰富的, 然后对其进行空间平均以获得D维帧级表示,然后将其级联形成。接下来,帧级增强(FLE)子模块通过对视频中不同帧的时间上下文进行编码来全局增强帧表示,并输出时空增强的帧级表示。最后将E输入到时间关系建模(TRM)模块,该模块通过将查询视频的子序列与支持动作相匹配来对查询视频进行分类。此外,通过引入查询类相似性分类器对中间表示H进行分类,增强了不同阶段对应类级别信息的学习,并有助于进一步提高整体特征可辨别性。我们的框架分别使用来自TRM模块和查询类相似性分类器的类预测上的标准交叉熵损失项和来联合学习。

Spatio-temporal Enrichment

我们的方法引入时空增强模块,该模块致力于增强(i)单个帧中空间上的局部patches特征;(ii)视频中时间上跨帧的全局帧特征。

视频中空间和时间上下文信息的有效利用使得能够在建模查询和支持视频之间的时间关系之前改进特定于类别的特征可辨别性。

Enriching Local Patch Features

每帧中的patches特征一起对其空间信息进行编码。增强这些特征以编码帧中所有帧级空间上下文,这对于捕捉基于外观的相似性以及动作类之间的差异是必要的。为此,我们引入了一个patches增强(PLE)子模块,该子模块使用自注意力,通过聚合一致的patch上下文,让patch特征关注自己。PLE子模块如下图所示,具体计算公式见原论文。

PLE子模块

Enriching Global Frame Features

上述(PLE)子模块旨在在动作视频的每个帧内局部地聚集空间上下文,这使得能够聚焦于帧中的相关对象。然而,它没有明确地编码时间上下文,因此在遇到随时间推移的物体运动时会产生困难。在这里,我们通过引入包括MLP-mixer层的帧级增强(FLE)子模块,继续在视频内的帧之间全局地增强时间上下文。虽然自注意力是基于样本相关(输入特定)混合,由标记之间的成对相似性引导,但MLP- mixer中的标记混合通过独立于输入的持久关系记忆同化了整个全局感受场。token标识的这种全局同化使得MLP-mixer更适合于丰富全局帧表示。FLE子模块如下图所示。

FLE子模块

FLE子模块在时间上增强了帧表示,具有包含所有帧的全局接受场,并产生时间上丰富的特征表示。把该丰富的帧级全局表示输入到时间关系建模(TRM)模块,该模块对查询和支持动作之间的时间关系进行建模。

给定标签,TRM框架预测的结果与标签对比,使用标准交叉熵(CE)损失来进行端到端学习,损失函数如下:

总之,我们的时空增强模块利用了局部和全局、样本依赖和样本不可知的增强机制的优势,以改进行动的空间和时间上下文的聚合。结果,随着在较低基数表示中同化高阶时间关系,获得了特定于类的区分特征。

Query-class Similarity

如前面所述,包括特征提取器、时空增强模块和时间关系建模模块,是在输出概率为,损失函数为CE的基础上的进行端到端学习。然而,学习从中间层输出中分类查询视频表示增强了模型寻找在pipeline不同阶段类-特定的特征。

因此,这种多级分类提高了特征的可分辨性,导致查询和支持视频之间的更好匹配。为此,我们在patch-level增强特征表示上引入了一个查询类相似性分类器。由于公式比较复杂,具体内容看原论文。

因此,我们提出的STRM包括一个时空增强模块和一个中间查询类相似性分类器,增强了特征可分辨性(见下图),并改善了查询与其支持动作类之间的匹配。

不同模块对于结果贡献的影响

实验

模型所用的数据集:Something-SomethingV2(SSv2)、Kinetics、HMDB51和UCF101。

实验对比

不同模块对比的消融实验

增加模块对实验结果的影响

更改SSv2数据集中支持样本的数量时的性能比较

结论

文章提出了一个FS动作识别框架STRM,包括时空增强和时间关系建模(TRM)模块以及查询类相似性分类器。我们的STRM利用了结合局部和全局、样本依赖和样本不可知的增强机制的优势,以增强时空特征,以及增强不同阶段特征的可分类性。因此,这增强了时空特征的可分辨性,并且即使在较低基数表示中也能够学习高阶时间关系。我们的消融实验揭示了几个模块贡献的benefits,从而在所有基准上取得了最先进的结果。在当前工作范围之外,一个可能的未来方向是扩展少数镜头动作识别能力,以在不同领域进行推广。