一天下午,在与知名企业的技术交流会议室里,一位兄弟企业的CTO 小力苦笑着,分享了一个技术招聘的故事:

“我们有个高级工程师,为了搞定MySQL三个表Join的问题,搞了一整天都研究不出来。结果他尝试将表结构扔给AI,谁知道5分钟内就解决了这个难题。”

同时,一位知名互联网企业的技术主管小军同学,突然向我们发问:“现在大家都在用AI做测评了,你们 ShowMeBug 这样的线上技术笔面试平台,候选人复制粘贴一下,AI立刻有答案,你们这样很难再精准评估人才了吧?”

小力补刀:“是啊,你们 ShowMeBug 得换赛道啦……”

事实真的如此吗?我们道出几个关键问题……

01 症结不在AI,而是对技术招聘的认知有误

我们先反问小军:“难道没有AI,传统招聘招人就精准了吗?”

小军后仰座椅,一时无语。

“我们觉得,现行技术招聘被AI冲击,只会停留在传统方式上,因为传统方式本身问题重重,但AI对ShowMeBug平台不仅没有冲击,反而是巨大的赋能。”

“传统技术招聘的题目设置,往往仅局限于八股文、算法题,并采用闭卷形式。诚然,起初能招到一些还不错的人才。”

“但是?” 小力接着问道。

“时间一久,就变味了。候选人会针对性地刷题、死记硬背,获得岗位,但他们缺乏项目实操能力。这样人一多,企业聘用后发现他们无法胜任,又只能请人离开,浪费成本与精力。只重理论知识的招聘模式,再碰上AI高速的信息检索,自然是针尖对麦芒了。”

我们说道:“并非AI对技术招聘构成了麻烦,而是我们对技术招聘本身的认知需要改变。”

小军和小力露出了疑惑的神情,“那正确认知是什么?”

02 招聘关键——工程能力而非理论知识

我们说出了自己的观点:

不妨反过来想,传统技术招聘的闭卷形式,仅了解到候选人的理论知识,其中有很多并不符合实际工作场景的需求。有多少技术人员实际工作中,是在一个与外界绝缘的环境里,闭门造车,仅靠八股文、算法题的积累,完成项目的呢?

互联网的高速发展,开源社区的蓬勃兴旺,加上AI方兴未艾,让检索的便利程度又以指数级的方式增长,大部分技术信息与知识唾手可得。

根据国外Stack Overflow的一份研究报告显示,44% 的开发人员早已在开发过程中使用 AI 工具,26% 的人计划很快开始使用。编程学习者采用人数更多,高达 55%,这些早期采用者一旦进入专业开发人员职位,将成为技能娴熟的 AI 用户。

未来工作中程序员与AI融合共存,将是大势所趋。毕竟,工程师们在实际工作中,也会用AI工具、搜索引擎或知识站点等开放环境,来解决实际开发问题。

ShowMeBug测评本来就致力于模拟真实工作场景,所以我们不担心开卷,而且认为“开卷有益”。我们无惧AI降临,甚至主动拥抱AI,在ShowMeBug平台融合了AI,开创了模拟实战场景的“开卷测评"功能。

理论知识仅仅是考核重点之一,搜索与应用这些知识去解决实际问题背后的思维与能力,也即实战编程能力,才是Showmebug真正考核的核心。

我们提出了一个工程能力模型,除了具备匹配企业技术岗位所需要的知识技能外,还需要具备工程能力和解决问题能力等要素。

工程能力指的是工程实现能力,从代码设计、开发质量、工程效率三方面体现。而问题解决能力则注重结合经验和候选人的经历进行综合评估,了解候选人对未知问题的分析、解决和创新能力。

ShowMeBug 团队首创的“工程能力模型冰山图”

“那这又该如何考核呢?”小军问道。

03 ShowMeBug——“开卷有益”的技术能力评测环境

我们回应道:“我们的测评重点是候选人的实战技术能力,所以第一需要监测是否为本人来参加测评,二是通过模拟他真实环境下检索答案的过程,深入了解他的能力。”

我们反手掏出电脑,在办公室内投屏道:“口空无凭,直接演示吧。假设你们正在招Golang工程师,有个候选人Lucy来参加测评。”

我们滑动屏幕鼠标,说道:“我们设置如下一道题目,让她写一个工具来扫描特定的文件系统目录,并在特定条件下对找到的目录进行分类。”

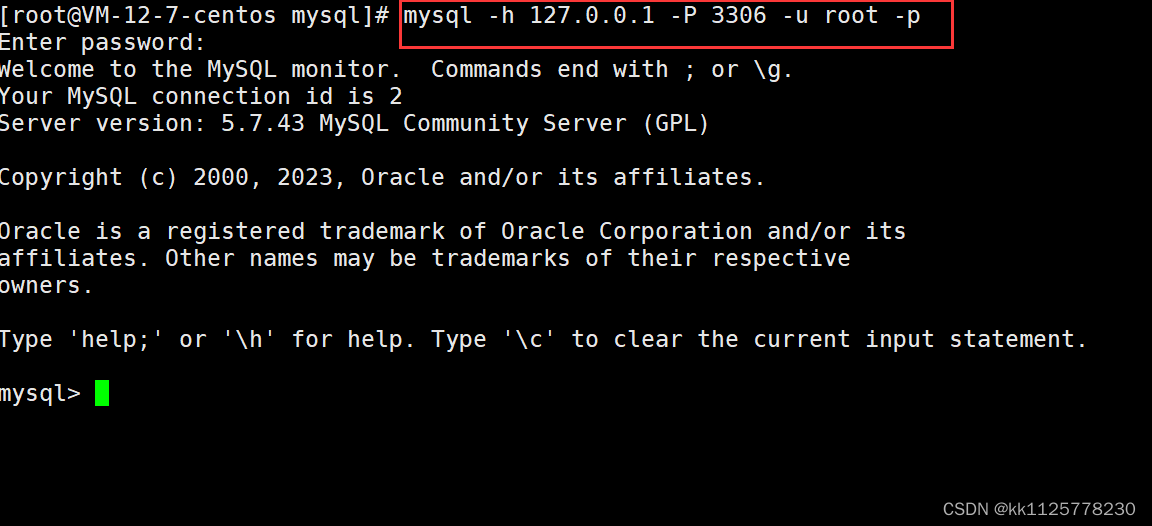

“由于该题知识点比较冷门,需要借助AI工具来检索。大家可登入平台,创建好试卷,并在防作弊选项里,选择开卷。可以注意一下,在这里可以设置开启摄像头监控和屏幕录制,如此一来,就能监测候选人是否为本人了。”

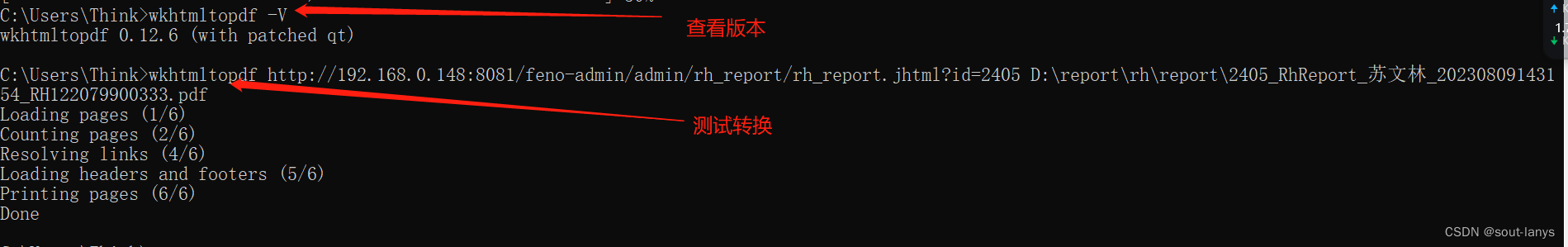

“接下来,候选人Lucy就可参与考试了。在开始前,她需要打开屏幕录制与摄像头再进入测评界面。Lucy浏览题目后,开始对问题中的业务逻辑进行拆解和分析。”

“梳理过后,她便开始向AI编程助手求助,AI编程助手反馈回代码后,Lucy可以复制代码到答题区域,再点击运行用例,诶,这时候她发现,测试用例反馈没有通过……”

“于是,她开始分析测试用例,发现了测试用例没有通过的原因,是代码没有处理扫描不存在的路径逻辑。”

“发现问题后,Lucy再次向AI求助。不同于单向搜索,Lucy可通过此功能,她可实现提问-反馈-改进-再反馈-再改进的闭环,直到得到正确答案。”

“完成答卷后,面试官可通过评卷,来查看候选人的AI交流记录,了解她解题的过程与思路,并评估她信息的检索能力与利用效率。”

“原来如此~”,小军和小力不约而同地后仰在座位上。

“而且,我们还能生成相应的人才评估报告,不仅支持Lucy与其他候选人对比,而且小军看过后也可以给小力以及其他招聘官看,避免个人的主观臆断。”

我们总结道,“这个例子中,我们让候选人在真实环境下发挥她的实战能力;考察了她的信息检索和学习能力,分析和判断能力;也了解她深入思考与思维逻辑能力。”

“所以,由本人完成+开卷+实战题目考核的形式,才是AI时代,技术人才评估最佳方式。”

ShowMeBug开卷测评功能

我们分享完观点后,大家纷纷表示赞同。

这时候小力说:“总而言之,你们内置了AI编程助手,模拟了实战工作环境,也确保了候选人本人参加,以此更精准地去挑选合适候选人。这的确颠覆了传统招聘的逻辑。”

我们笑了:“没错!而且ShowMeBug 现在就支持了,官网注册即可开始使用。”

“哈哈哈哈得叻!马上注册来看看你说的‘开卷有益’!”

谈笑间,日渐落。技术讨论会的下一场思想交锋又将开始……

![[JAVAee]多线程环境下:HashTable, HashMap, ConcurrentHashMap之间的区别](https://img-blog.csdnimg.cn/02c39faf8c794a99aa28fca022accf4e.png)

![linux学习(地址空间)[7]](https://img-blog.csdnimg.cn/1d75db10aa004095a0074a4ea85f08c1.png)