本文是LLM相关的文章,针对《SEED-Bench: Benchmarking Multimodal LLMs with Generative Comprehension》的翻译。

SEED-基准:用生成理解对多模式LLM进行基准测试

- 摘要

- 1 引言

- 2 相关工作

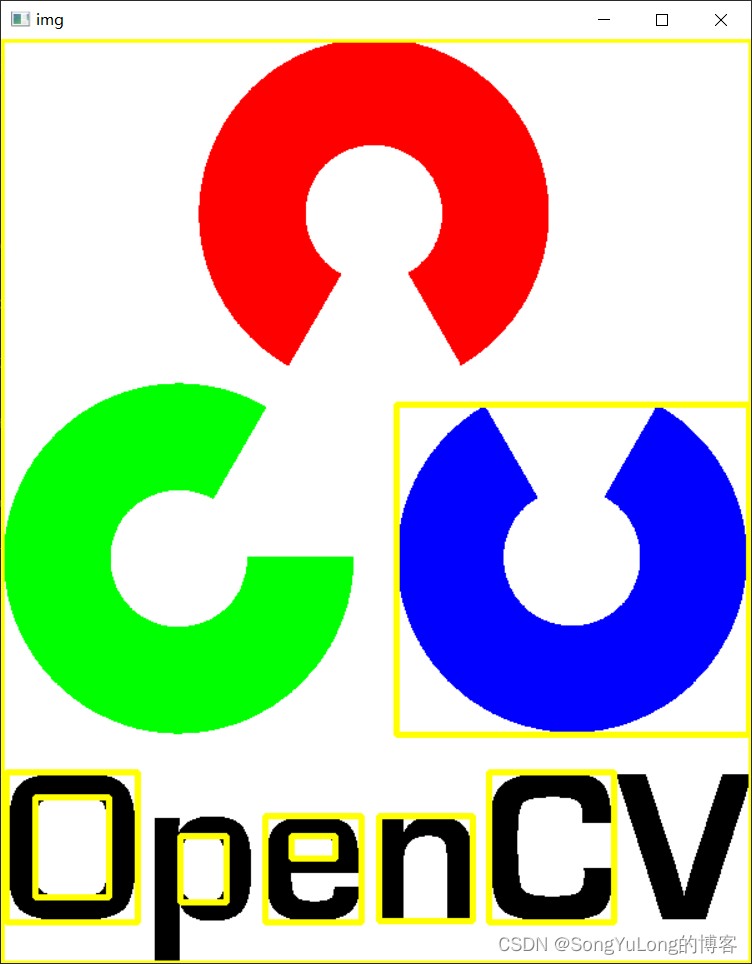

- 3 SEED-Bench

摘要

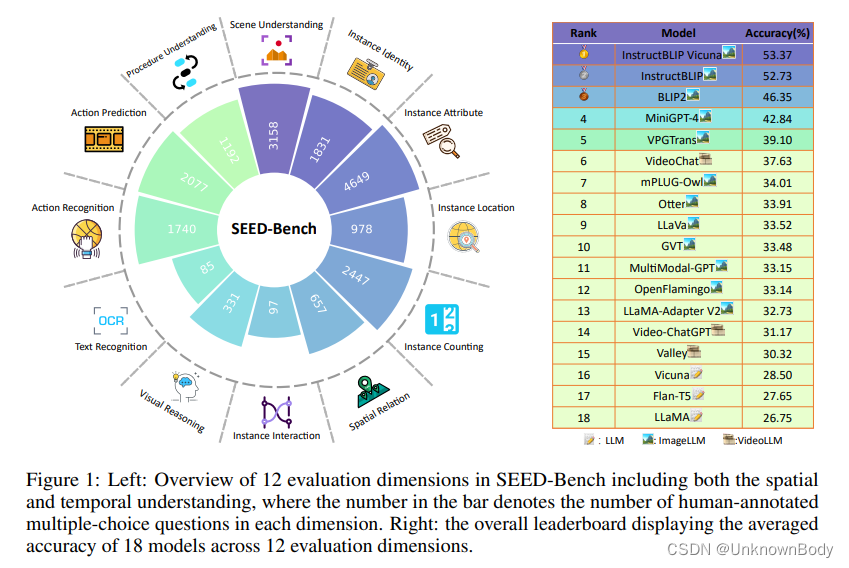

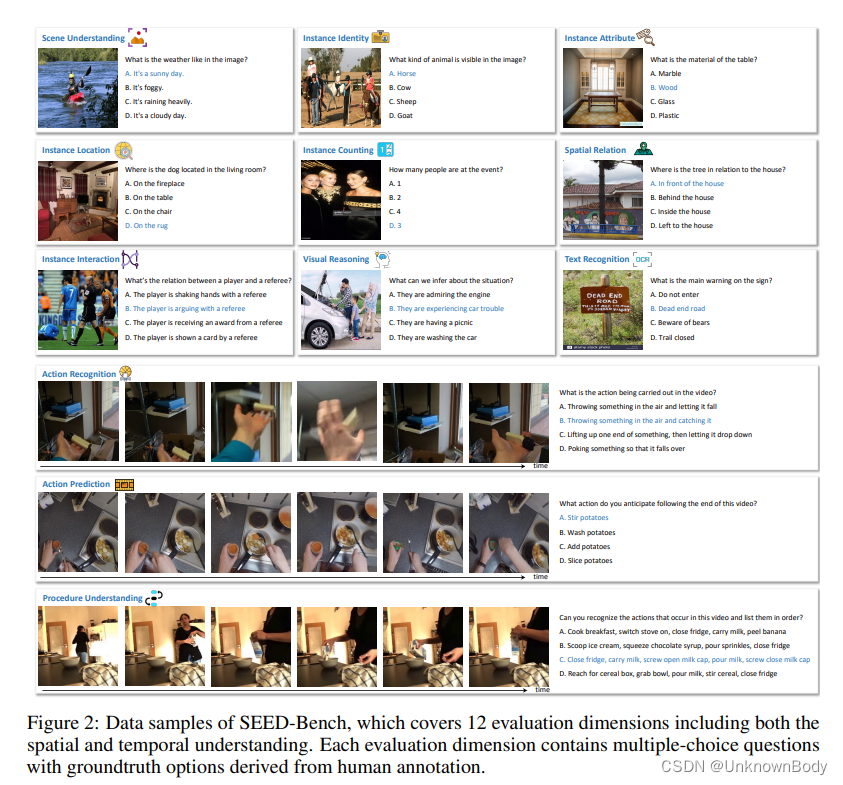

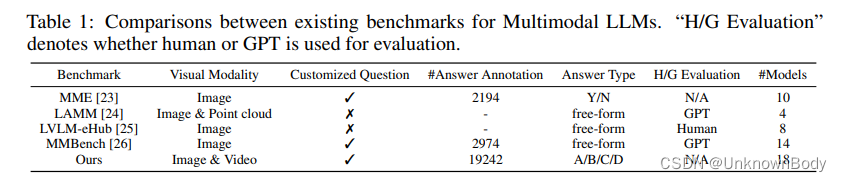

基于强大的大型语言模型(LLM),近年来生成的多模态大型语言模型作为一个关键的研究领域,在理解和生成方面表现出了非凡的能力。在这项工作中,我们通过引入一个名为SEED Bench的基准,将MLLMs中生成理解的评估作为对生成模型进行全面评估的初步步骤。SEED Bench由19K多项选择题组成,具有准确的人工注释(比现有基准大×6),涵盖12个评估维度,包括对图像和视频模态的理解。我们开发了一个高级管道,用于生成针对特定评估维度的多项选择题,集成了自动过滤和手动验证过程。多选题具有源自人工注释的基本事实选项,可以客观有效地评估模型性能,从而消除评估过程中人工或GPT干预的需要。我们进一步评估了18个模型在所有12个维度上的性能,涵盖了空间和时间理解。通过评估结果揭示现有MLLM的局限性,我们的目标是SEED Bench为激励未来的研究提供见解。我们将推出并持续维护排行榜,为社区提供评估和调查模型能力的平台。

1 引言

![c++(空间配置器)[32]](https://img-blog.csdnimg.cn/72a245b93e5e42cf95e8193a1418640f.png)