点击下方卡片,关注“CVer”公众号

AI/CV重磅干货,第一时间送达

今年国内厂商已发布很多大语言模型,其中最具代表性的产品有:百度的文心一言、阿里巴巴的通义千问、科大讯飞的星火等,最具代表性的开源工作有:ChatGLM、MOSS、BaiChuan等。

大语言模型的能力有很多,比如知识问答、文本生成、翻译、编程、数据分析、图像生成等。

想必有不少同学已经用上大语言模型产品了,将其作为自己的生产力工具。同时也会有很多同学疑问:究竟哪家的实力最强?!如果要选择一个作为科研学习和工作的工具,哪个产品上手又好又快?!

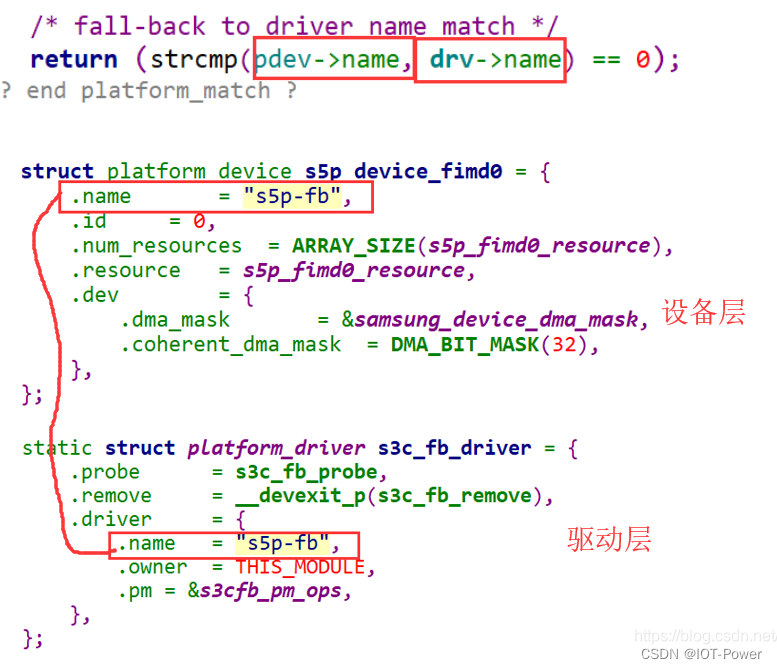

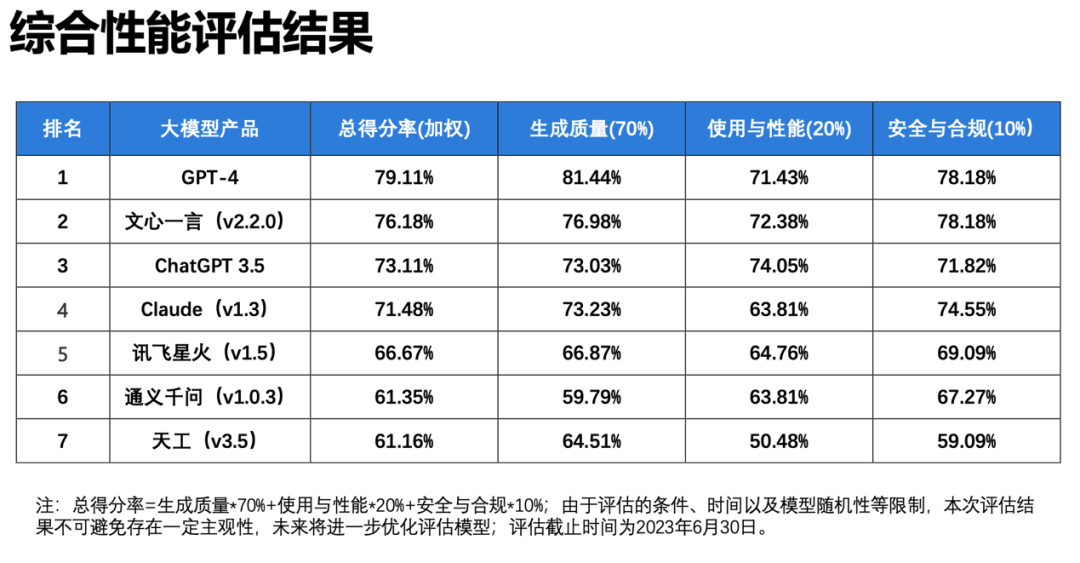

清华大学沈阳团队重磅发布《大语言模型综合性能评估报告》

近日,清华大学(新闻与传播学院沈阳团队)最新发布《大语言模型综合性能评估报告》,该报告给出一个答案:百度文心一言综合评分国内第一(三大维度、20项指标),超越ChatGPT 3.5!其中文心一言的中文语义理解排名第一,部分中文能力超越GPT-4。

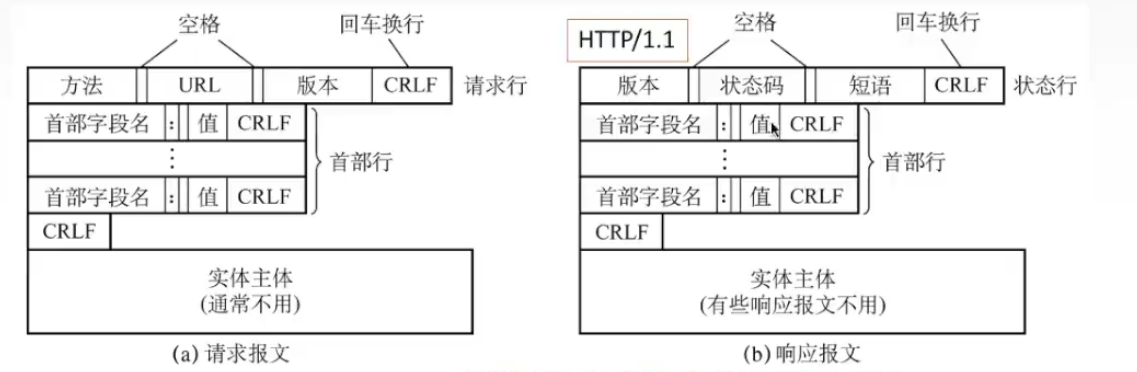

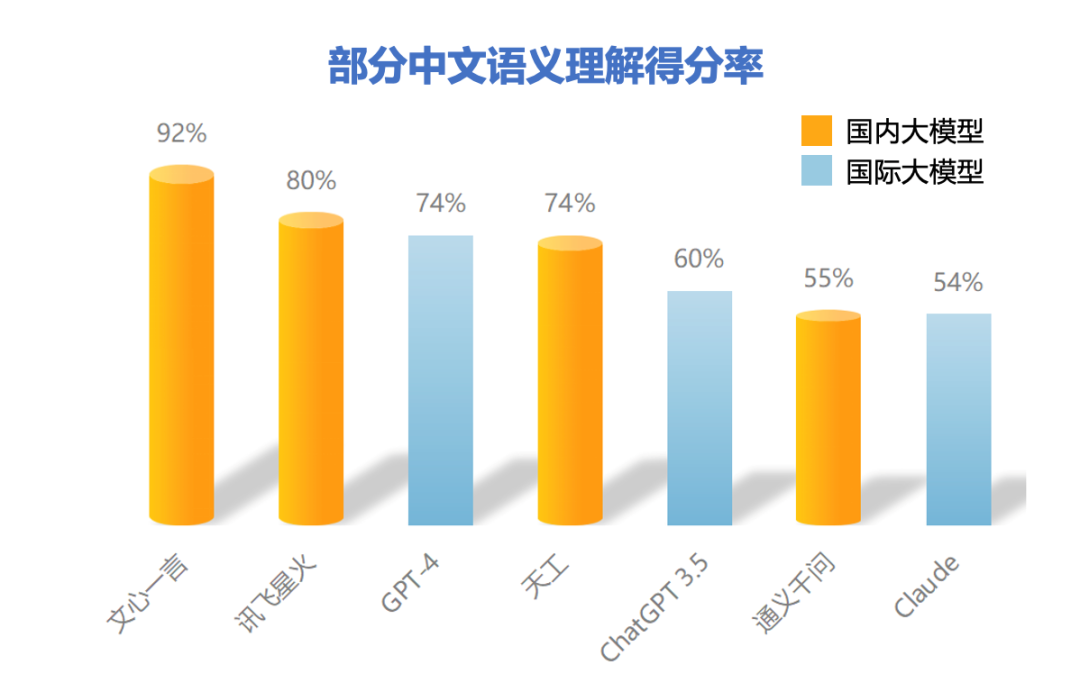

本报告测评对象包含了GPT-4、ChatGPT 3.5、Claude国外主流大语言模型,也包含了文心一言、通义千问、讯飞星火、天工国内代表性大语言模型。本报告围绕生成质量、使用与性能、安全与合规三大维度,全面考察大语言模型上下文理解、中文语义理解、逻辑推理、内容安全性等20项指标。

在生成质量维度上,基于对语义理解、输出表达、适应泛化三个方面的综合评测(均为Prompt测试),文心一言得分率高达76.98%,仅次于GPT-4,而领先于ChatGPT 3.5等大语言模型。其中,在部分中文语义理解方面,文心一言以92%得分率排名第一,超越了GPT-4。

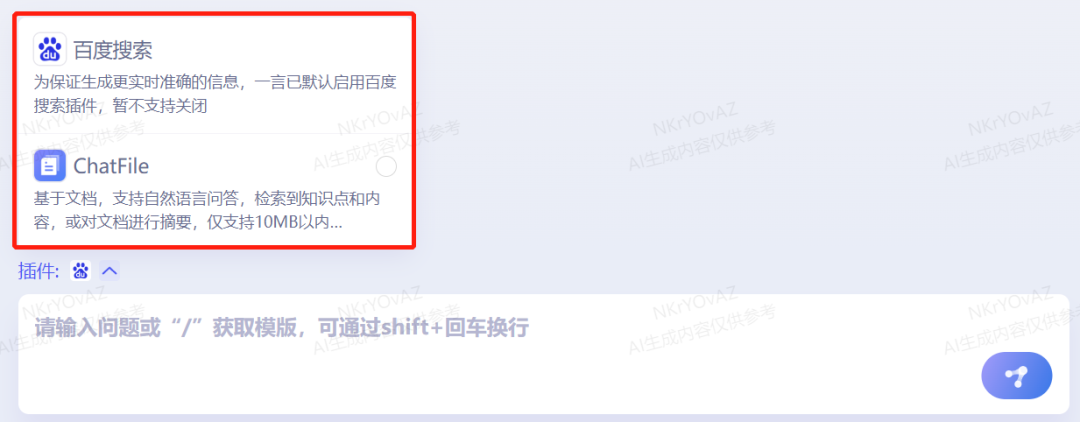

在使用与性能维度上,基于对使用便捷性、响应速度和鲁棒性三个方面的综合评测,文心一言得分率高达72.38%,仅次于ChatGPT 3.5、GPT-4,而远超其他大语言模型。报告显示,文心一言使用便捷,响应快,模型鲁棒性高,对于意外、错误或极端情况下的回应表现较好,而且新加入的插件“ChatFile”支持超长文本输入、插件“百度搜索”支持生成更实时准确的信息。

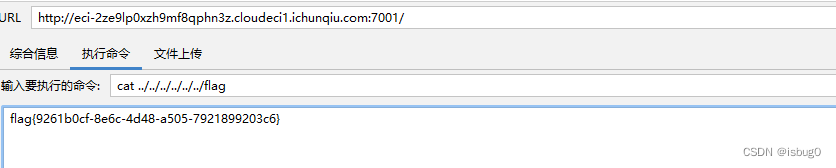

百度搜索和ChatFile插件

在安全与合规维度上,基于对内容安全性、偏见和公平性、隐私保护、版权保护四个方面的综合评测,文心一言得分率高达78.18%,与GPT-4并列第一,远超其他大语言模型。报告显示,文心一言内容安全性好,把握细微,注重用户隐私保护,重视版权保护。

综上来看,文心一言的语义理解能力更为突出,尤其是具备更好的中文理解能力,更懂中国文化和本土主题/背景,而且时效性很强、内容安全性高,对信息把握细微。

这里文心一言的突出优势,离不开百度知识增强、检索增强和对话增强的技术创新。

在知识增强方面,文心一言基于百度构建的庞大的知识图谱,通过知识内化和知识外用来实现知识增强。知识内化,是从大规模知识和无标注数据中,基于语义单元学习,利用知识构造训练数据,将知识学习到模型参数中;知识外用,是引入外部多源异构知识,做知识推理、提示(Prompt)构建等等,使模型具备高效运用外部知识的能力。在知识的指导下,文心一言学得又好又快,模型效率和效果均大幅提升。

在检索增强方面,文心一言借助了搜索引擎的能力。以语义理解与语义匹配为核心技术的新一代检索架构,深入理解用户需求和网页内容,进行语义匹配。通过引入搜索结果,可以为大语言模型提供时效性好、准确性高的参考信息。

在对话增强方面,基于对话技术和应用积累,文心一言具备记忆机制、上下文理解和对话规划能力,使得对话的连贯性、合理性和逻辑性更好,用户实际体验更佳。

不过在本次清华大学(沈阳团队)报告中,并没有看到清华大学自家的ChatGLM大语言模型的评测结果,不清楚是否是因为性能有限,没有参与测评。我是很想看看产品级应用和开源项目之间的性能及体验差距有多大。

文心一言实测

上面简单介绍了文心一言在清华大学《大语言模型综合性能评估报告》中的测评成果和技术细节,下面从我们用户的角度来看,测试最新版本的文心一言究竟有多强,看看实际使用体验如何。

于是我实测了文心大模型3.5版本加持的文心一言。特别提一下,如果你之前有拿到文心一言内测资格的话,应该会明显发现,从3月份到现在,文心一言能力有非常大的提升,可以感觉到体验有非常大的变化。

下面从计算机视觉、人工智能方向从业者角度,提问一些专业问题和日常问题,来看看文心一言是否可以轻松应对。

专业知识

不管对于人工智能方向的学生,还是工程师/研究员,每天都会遇到很多行业问题。这里测试文心一言是否可以回答一些专业领域问题和建议。

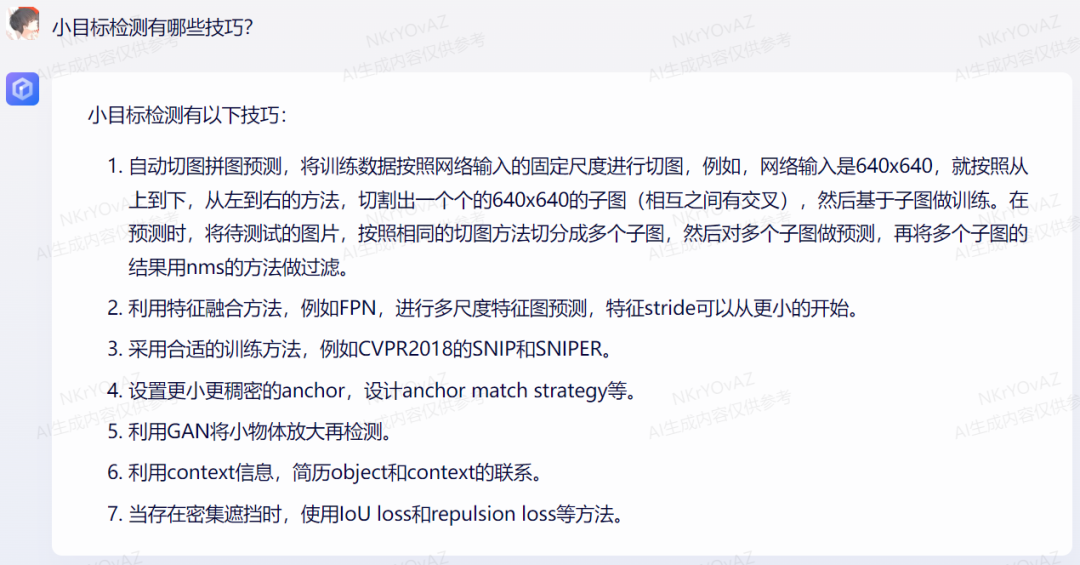

问题:小目标检测有哪些技巧?

文心一言列举了7条建议,分别从输入、特征融合、anchor设计、损失函数、训练等角度给出实用性建议,内容相当全面且详尽。

Transformer目前在计算机视觉、自然语言处理等领域爆火!大名鼎鼎的GPT系列和文心大模型都使用了Transformer相关技术。而大家在学习和应用Transformer过程中会遇到很多问题。这里我来考察文心一言对Transformer的知识点掌握情况。

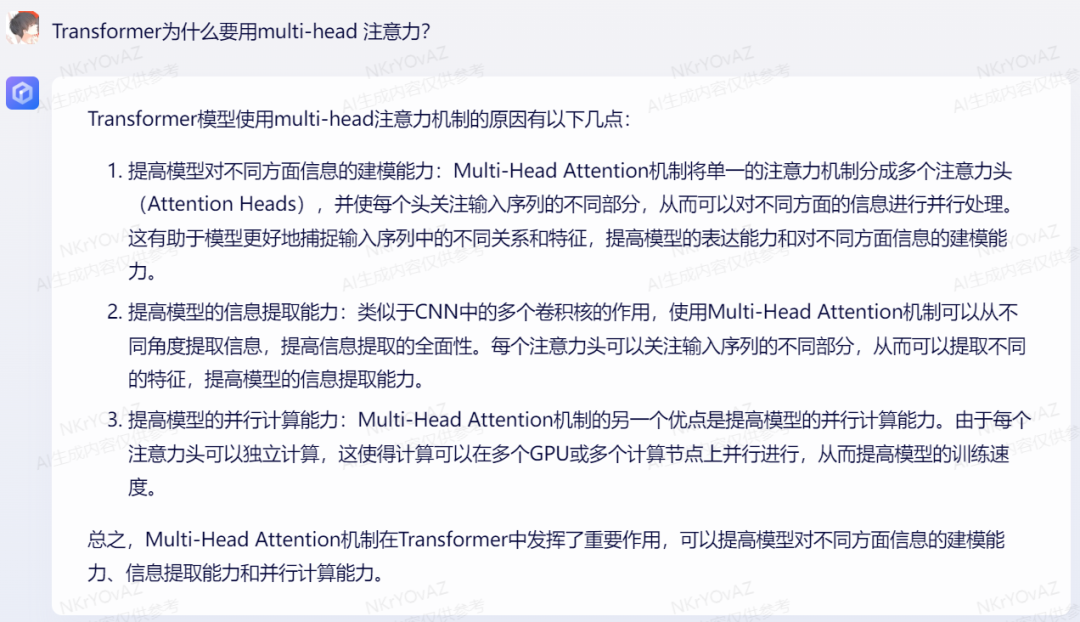

问题:Transformer为什么要用multi-head注意力?

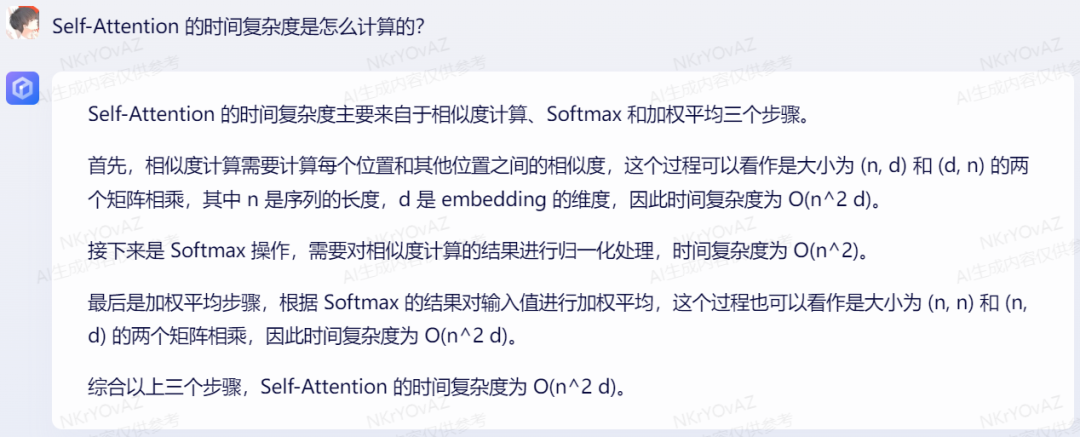

问题:Self-Attention 的时间复杂度是怎么计算的?

由上可知,文心一言详细解答了关于Transformer的核心知识点问题。

PS:目前正值求职季,强烈建议大家使用文心一言来辅助解决面试题,省时省力,轻松助力校招和社招!

写作辅导

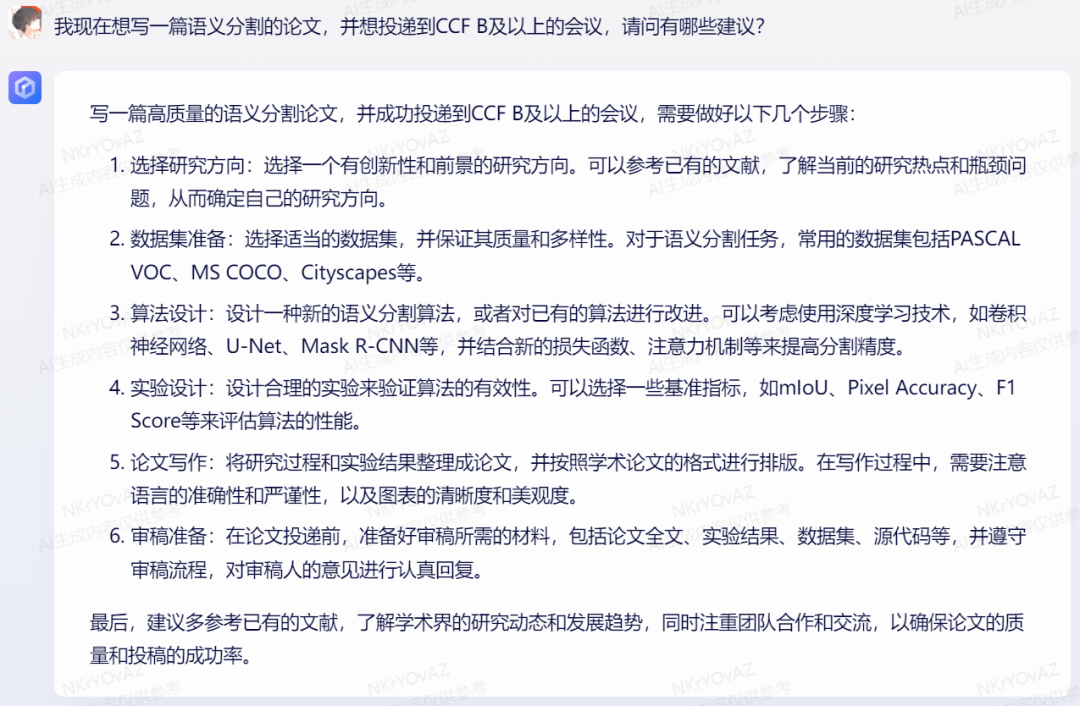

问题:我现在想写一篇语义分割的论文,并想投递到CCF B及以上的会议,请问有哪些建议?

文心一言回答的内容确实有条理且详细,分别从数据集、算法、实验设计等角度给出建议。这里我再加点难度,因为很多咨询问题的同学都是刚入门不久的从业者,所以加个“小白”的背景,更契合实际一点。

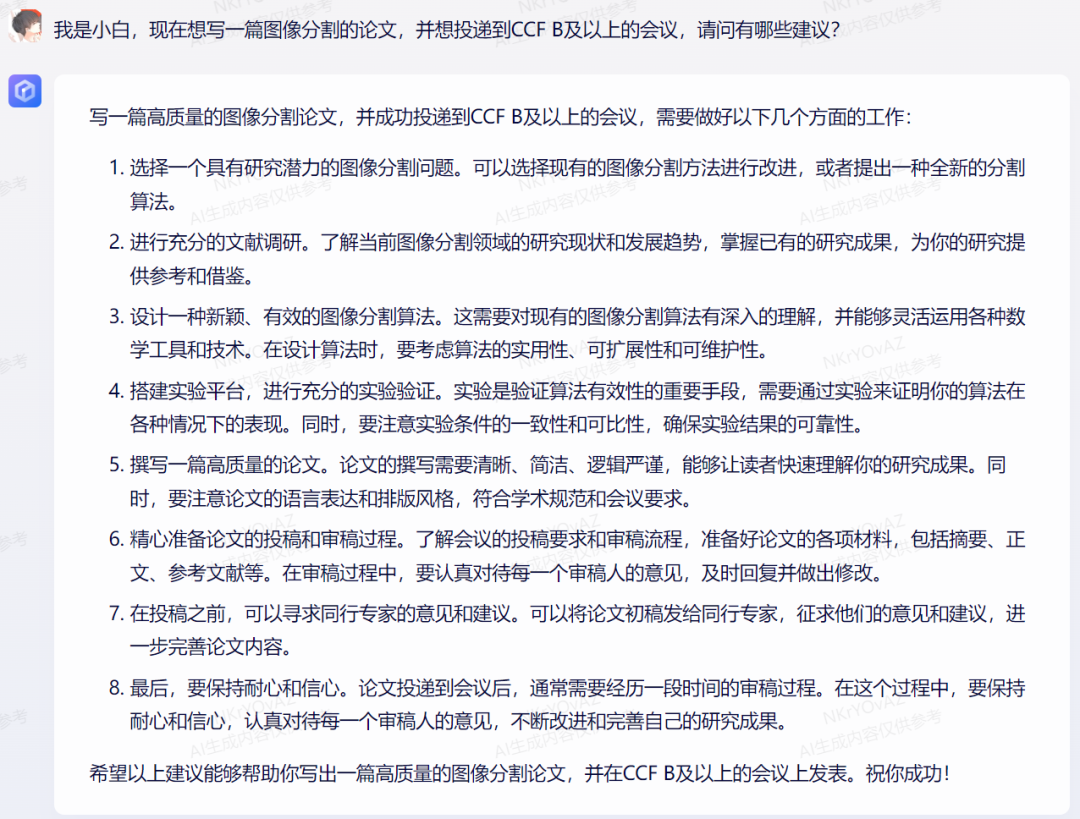

问题:我是小白,现在想写一篇图像分割的论文,并想投递到CCF B及以上的会议,请问有哪些建议?

显而易见,文心一言的回答更加基础实用了,还温馨的告知:需要经历一段时间的审稿过程,需要保持耐心和信心。

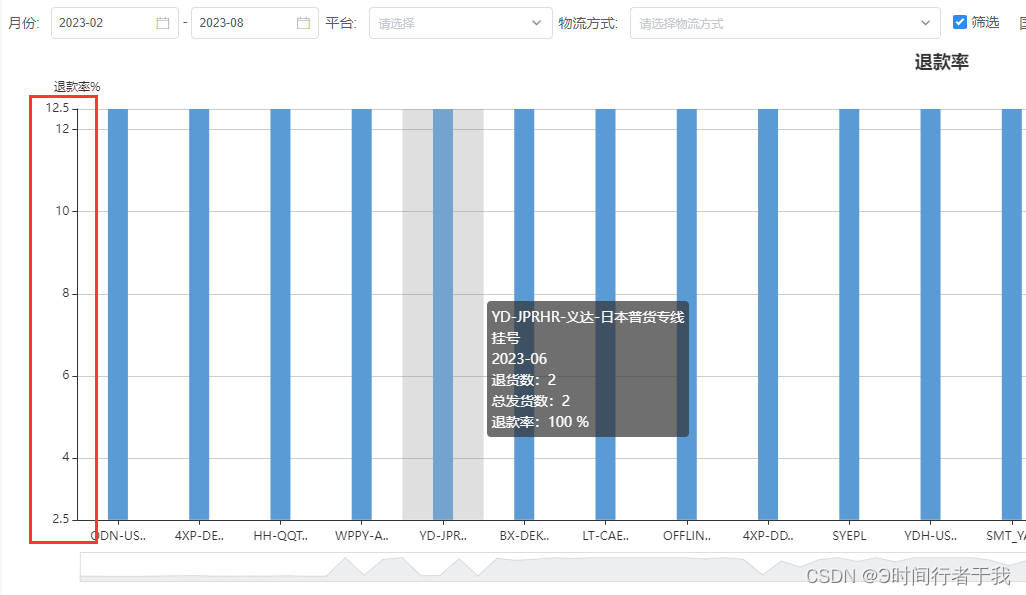

百度搜索插件

百度搜索——让文心一言具有生成实时准确信息的能力。

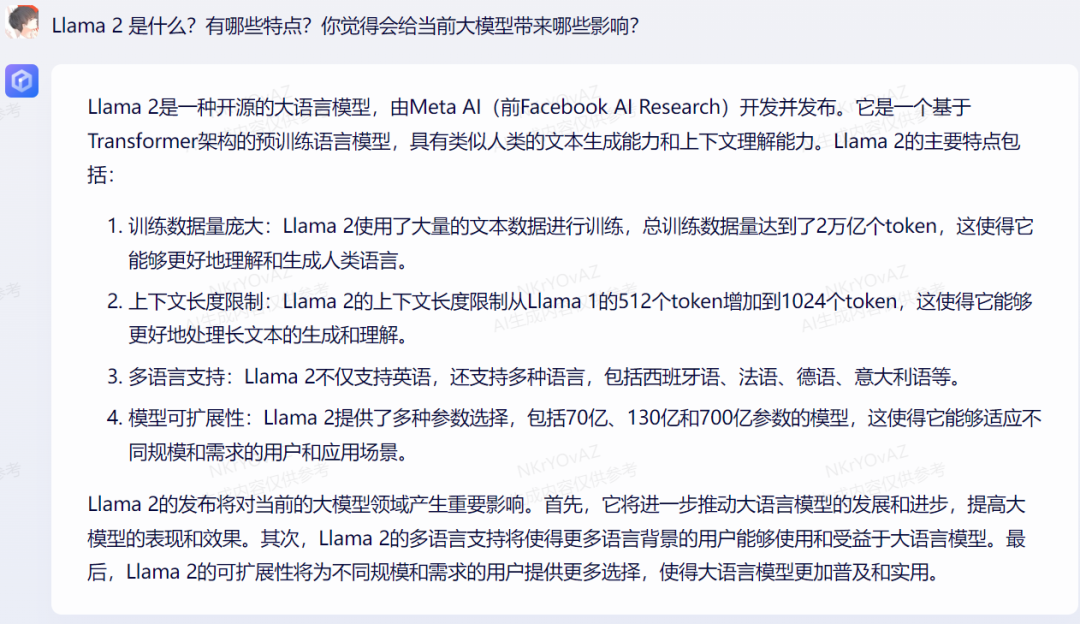

前段时间,Meta重磅发布了可免费商用的大语言模型Llama 2,让我们来看看文心一言是否知道这个消息。

可见具有百度搜索插件的文心一言,已经“知晓”了Llama 2的存在,并对其进行了介绍和分析。

林俊杰8月将在上海开“JJ20世界”巡回演唱会,问文心一言在哪里举办,具体开票时间?

文心一言回答的信息完全正确,而且开票时间也就是前几天才正式通知的,可见百度搜索插件加持的文心一言更强了!

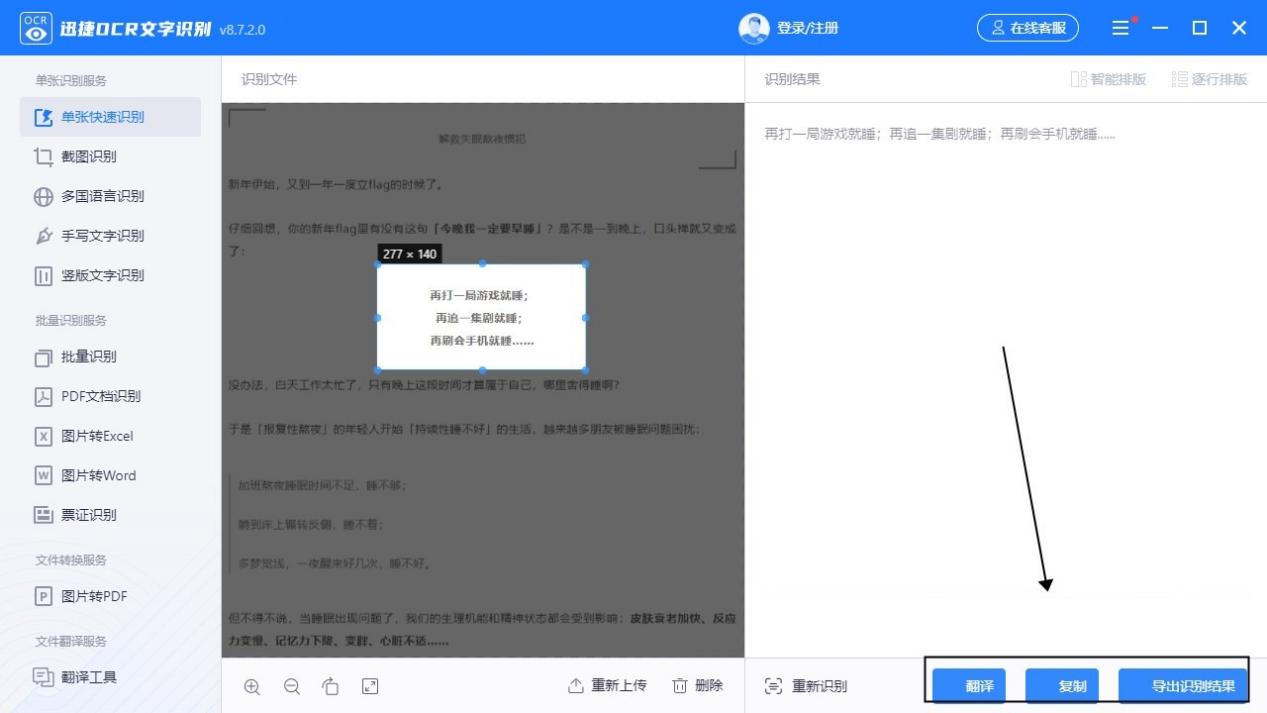

ChatFile文档插件

ChatFile——让文心一言具有生成报告摘要、检索和分享文档内容的能力。

用户使用ChatFile,可以直接上传10MB以内的(pdf/doc格式)文档,ChatFile解析完成后会自动生成一份摘要,然后用户通过文本跟文心一言进行对话,这样就可以对文档的内容进一步解析,比如检索和总结等。

我上传了何恺明(Kaiming He)的鼎鼎大名ResNet《Deep Residual Learning for Image Recognition》论文的pdf,从下图可知,文心一言解析该论文pdf后,检索到了该论文的核心知识点,并对更多信息进行了总结。

让文心一言继续总结ResNet论文的创新点和实验结果:

上面总结的实验结果全部汇聚到一个大段文字里了,这里可以单独对实验进行提问,可见文心一言会逐步对实验结果进行总结性介绍:

像每天各大期刊、会议平台上会上新很多论文,如果想要一篇一篇看过去,即使只关注自己的研究方向,那工作量也实在太大了,那我们就可以用文心一言快速总结论文,提高科研效率。

期待

当前文心一言具备相当优秀的性能和用户体验,达到了真正的“上手即用”,成为我们科研和工作的生产力神器。

在此,我非常期待文心一言支持更多的功能、插件,开放插件生态,帮助开发者基于文心大模型打造自己的应用。

最后希望国产大语言模型发展越来越好!给每个人带来便利!

整理不易,请点赞和在看![]()