LLM reasoners

Ber666/llm-reasoners

实验过程

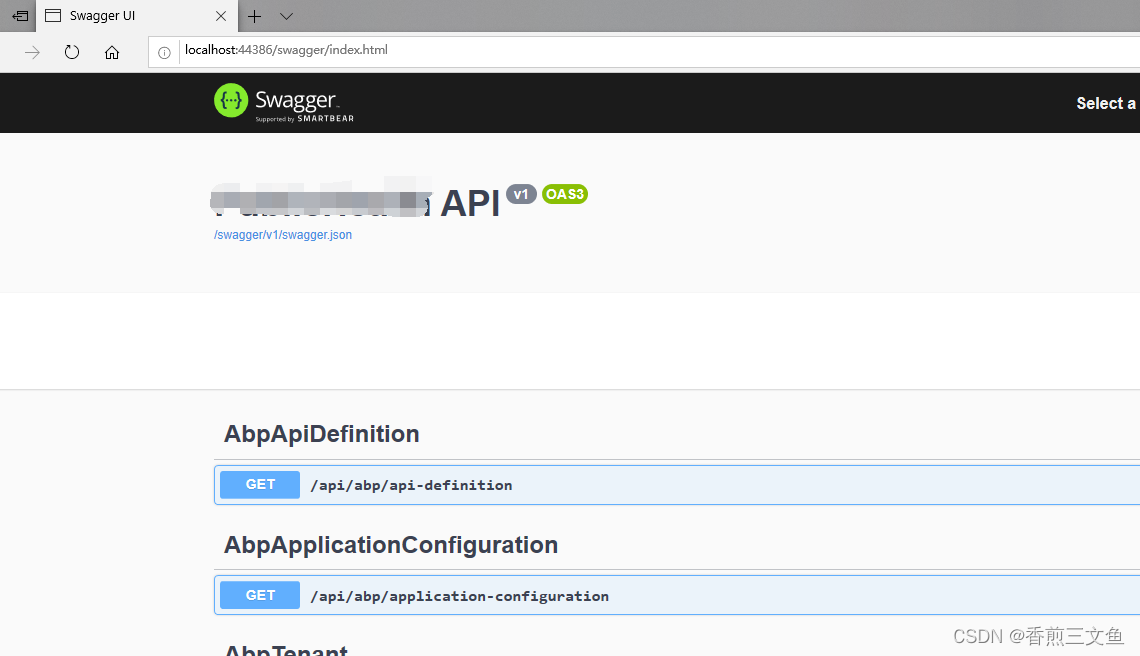

实验样例24games,examples/tot_game24,在inference.py中配置使用代理和open ai的api key。

首先安装依赖

git clone https://github.com/Ber666/llm-reasoners

cd llm-reasoners

pip install -e .

然后在多个案例中,本例使用24点游戏作为实验(因为这个案例默认使用chatgpt-3.5,相比其它要下载模型参数的实验更简单)。

放置数据集文件,刚开始只需要一个样例1 2 3 4(单单一个样例,程序都要运行几分钟才能得到最终答案)

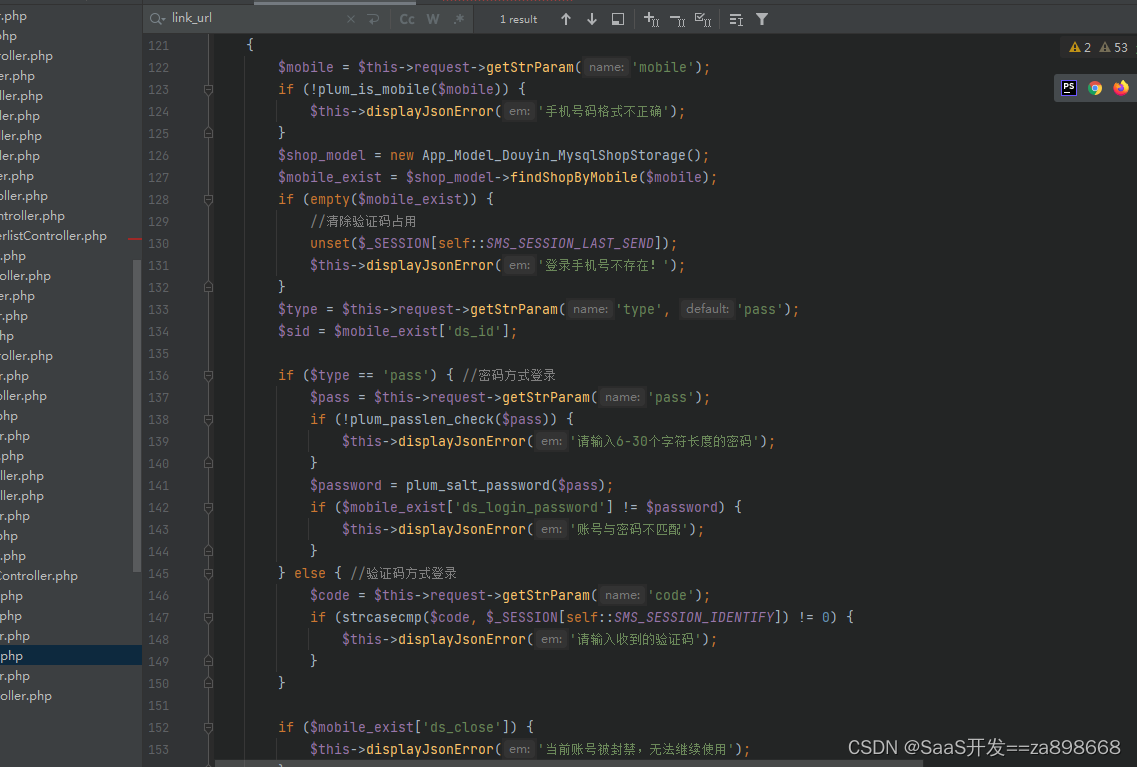

修改代码中的路径,使其指向正确文件,主要是24点数据集,以及prompt的json文件。修改后的相应代码如下:

dataset = utils.read_data(file='./data/24.csv')[0:1]

...

def main(batch_size: int = 2,

prompts: str = './prompts/game24.json',

disable_log: bool = False,

model: str = 'gpt-3.5-turbo',

temperature: float = 0.7,

**kwargs):

然后配置运行,等了几分钟,发出几十个请求后,终于看到结果。

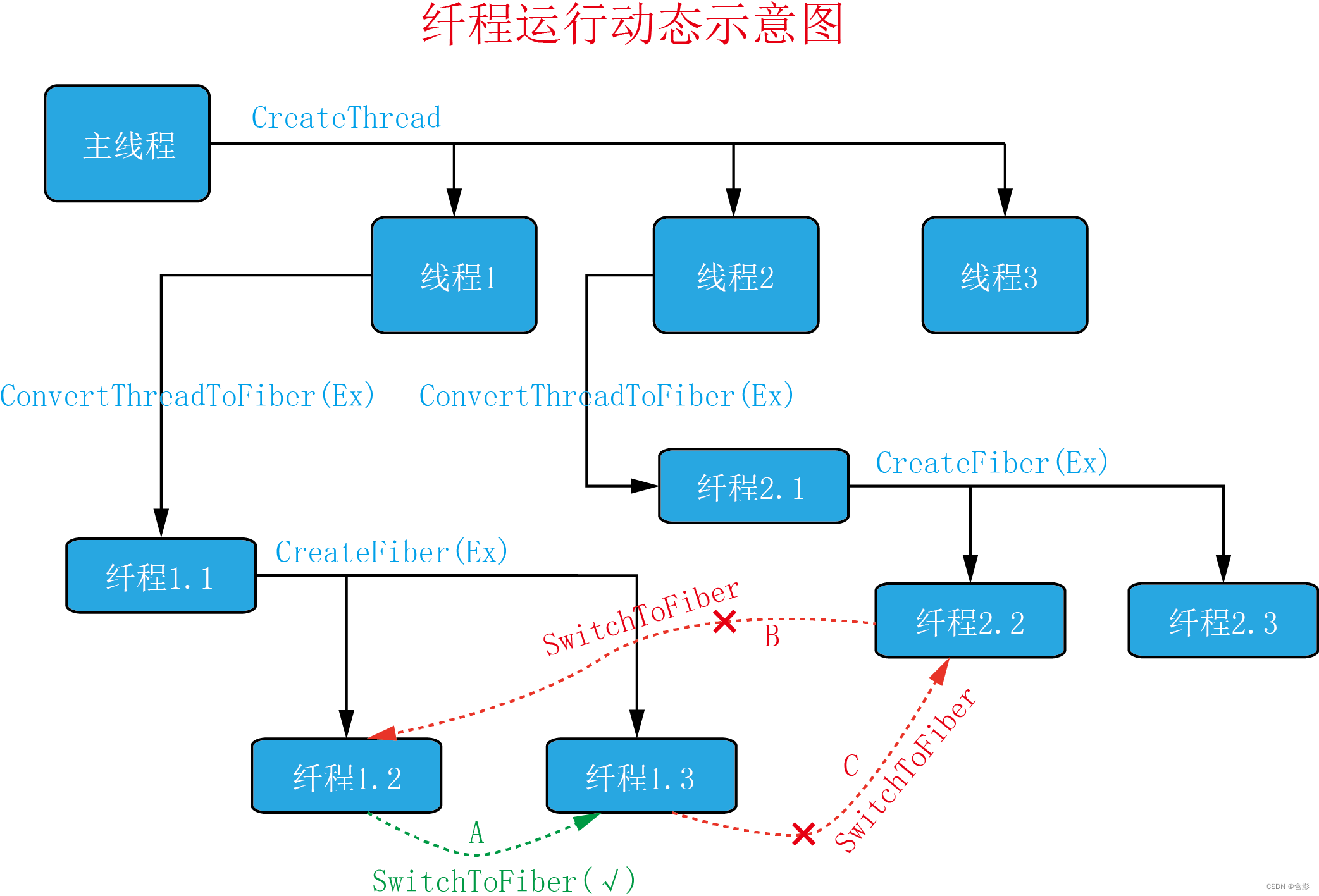

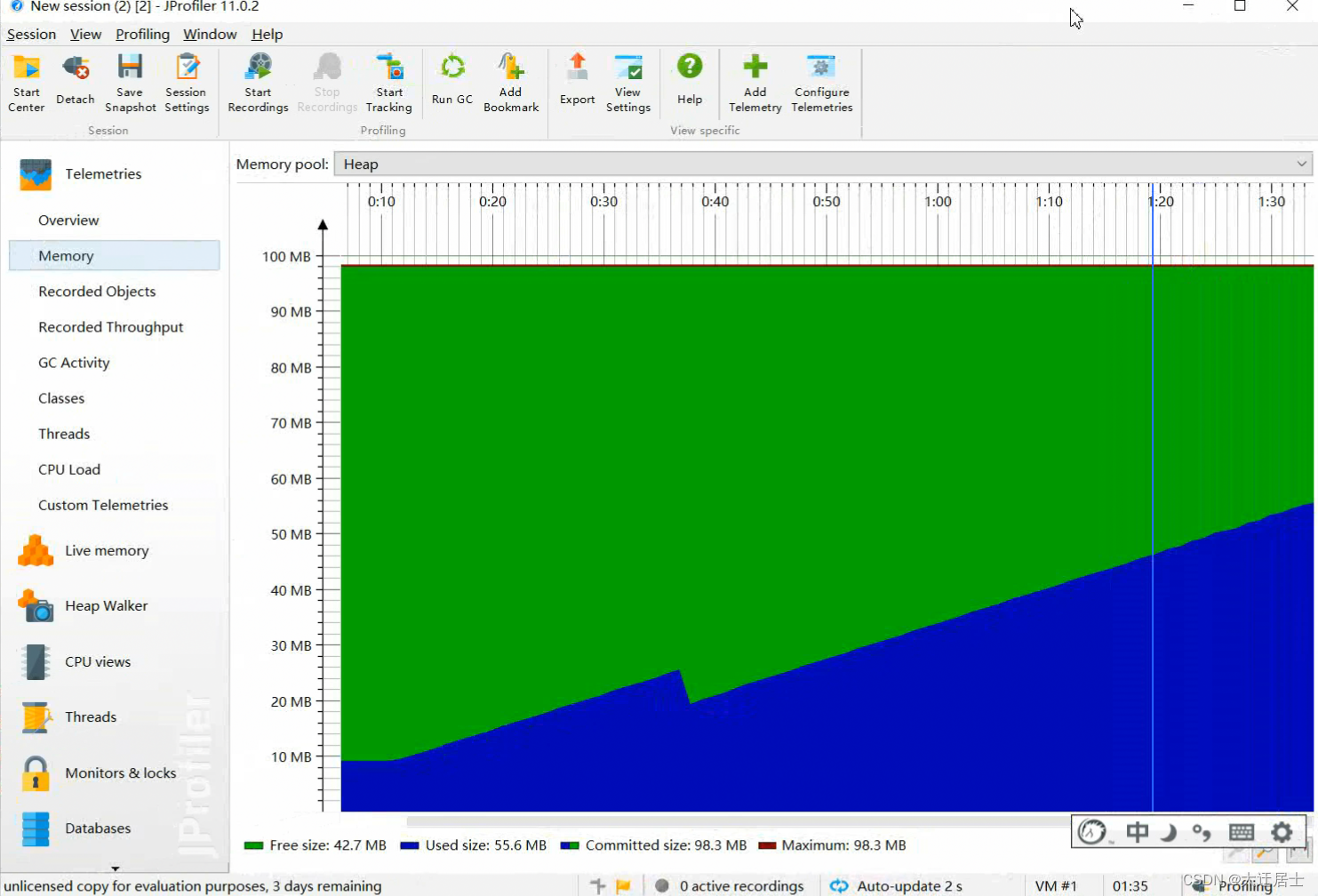

调试发现,程序大部分时间在beam_search.py的for循环内执行,从代码阅读猜测,每个beam是一个搜索路径,程序不断在规划、探索每个搜索路径,尝试找到正确的24点计算公式。

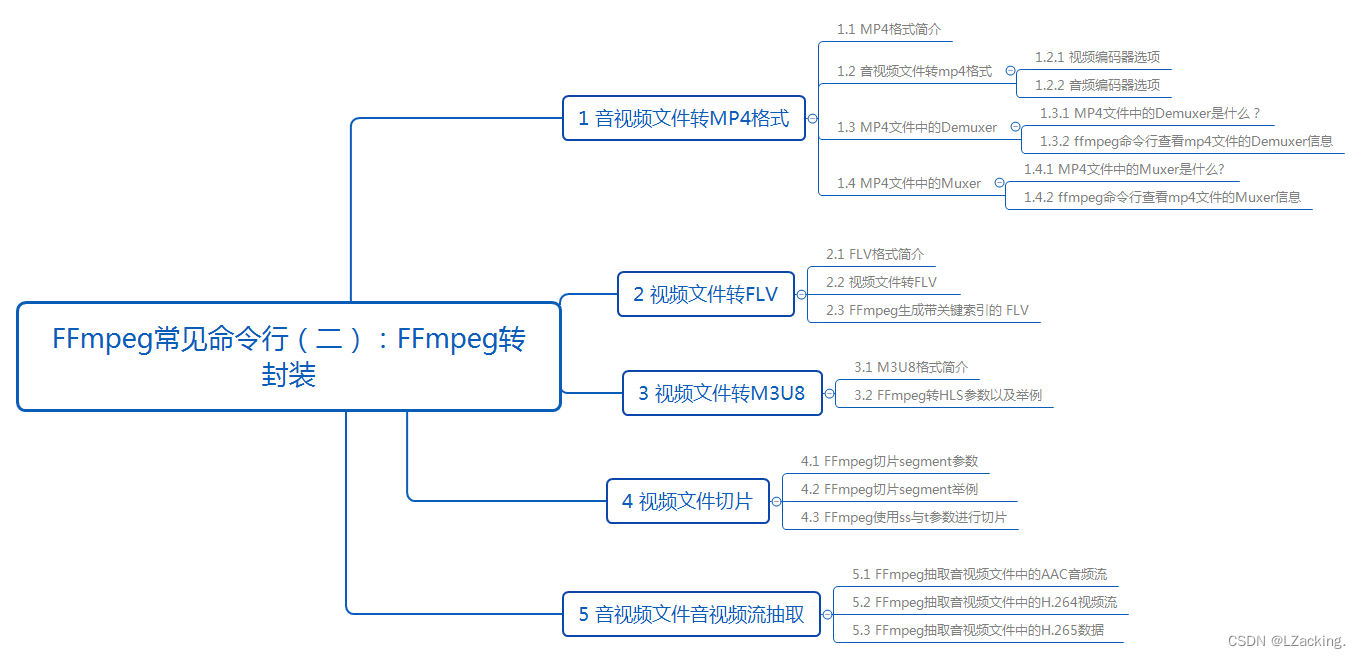

拓展阅读

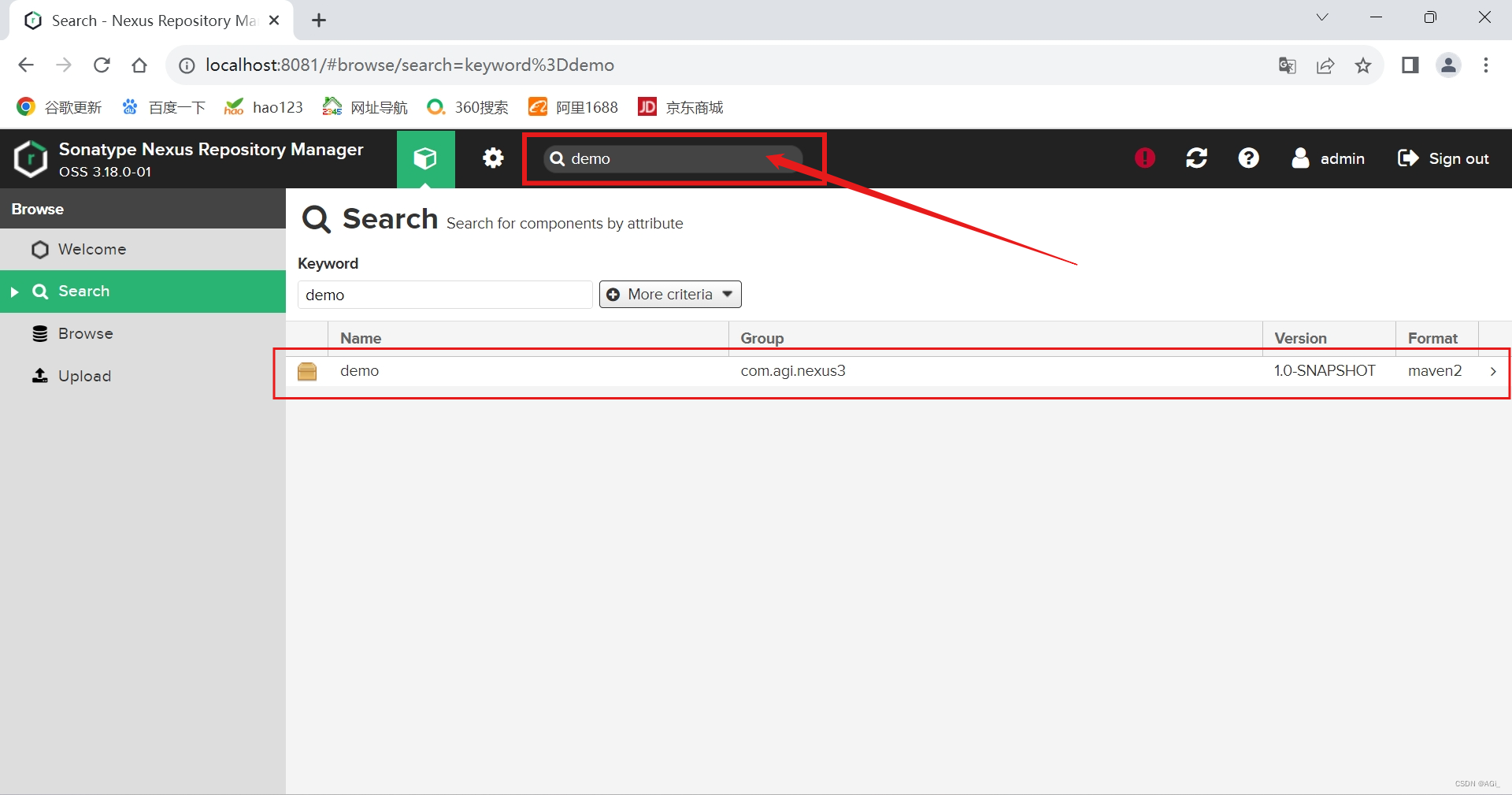

发现有其它关于TOT的仓库,且都有3K start,相比当前仓库的300 star更多。

- https://github.com/princeton-nlp/tree-of-thought-llm

- https://github.com/kyegomez/tree-of-thoughts

- https://www.youtube.com/watch?v=ut5kp56wW_4 YK解读Tree of thoughts

![[Realtek sdk-3.4.14b]RTL8197FH-VG+RTL8812F WiFi开启访客网络之后无法扫描到SSID问题分析及解决方案](https://img-blog.csdnimg.cn/1479a3b3c5834639a6c070bf80af0502.png)