论文:TransPose: Keypoint Localization via Transformer

Sen Yang Zhibin Quan Mu Nie Wankou Yang*

School of Automation, Southeast University, Nanjing 210096, China

{yangsenius, 101101872, niemu, wkyang}@seu.edu.cn

下载地址:https://arxiv.org/pdf/2012.14214v5.pdf

本周任务:代码学习

Backbone

只保留原始 ImageNet 预训练 CNN 的最初几个部分,以从图像中提取特征。 我们将它们命名为 ResNet-S 和 HRNet-S,其参数数量仅为原始 CNN 的 5.5% 和 25% 左右。

计算网络的shape

ResNet

参数详见文件:TP_R_256x192_d256_h1024_enc3_mh8.yaml

训练好的模型文件:models/pytorch/transpose_coco/目录下的对应文件

直接用下面的语句运行test文件

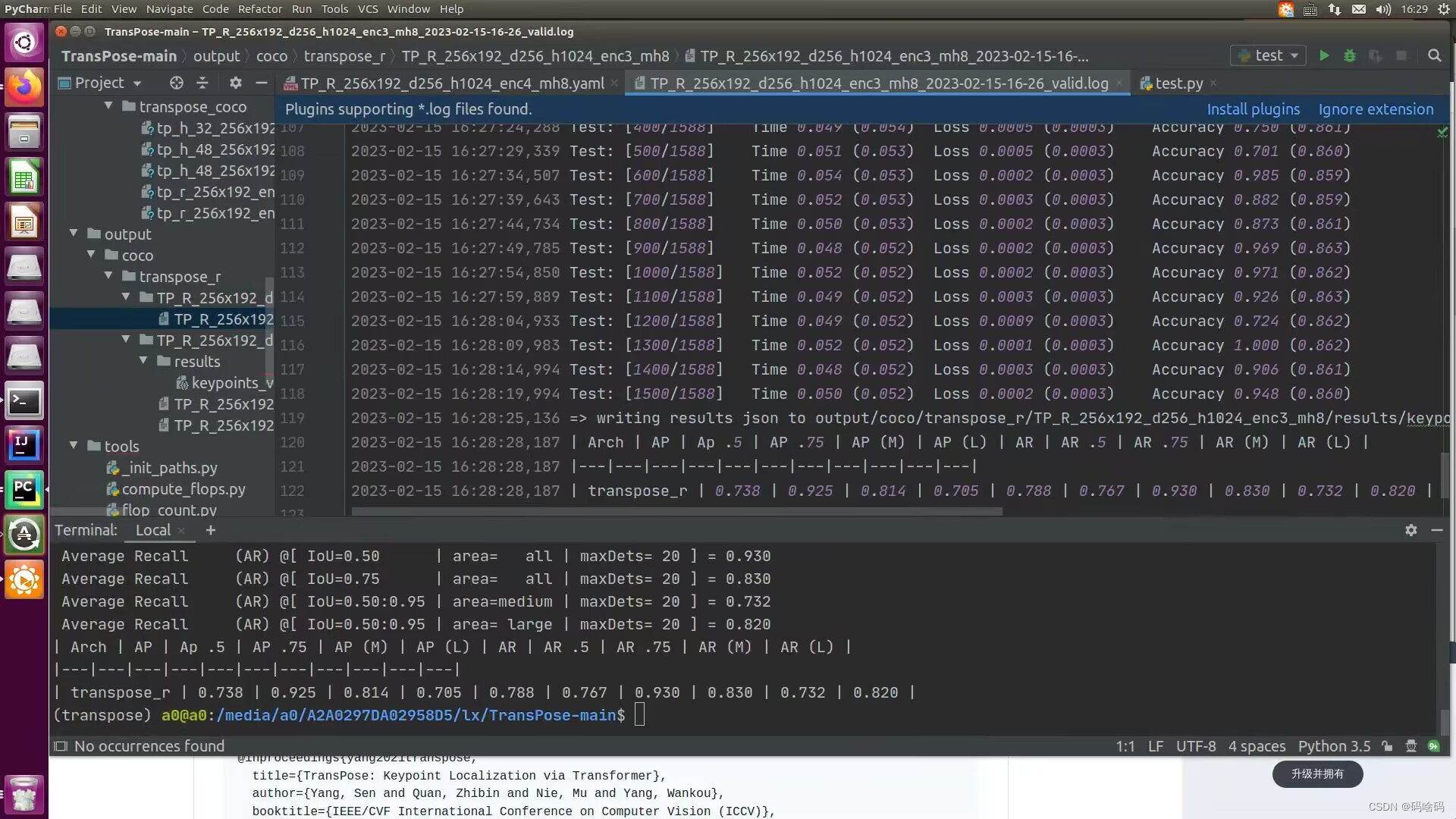

python tools/test.py --cfg experiments/coco/transpose_r/TP_R_256x192_d256_h1024_enc3_mh8.yaml TEST.USE_GT_BBOX True

得到的loss和acc

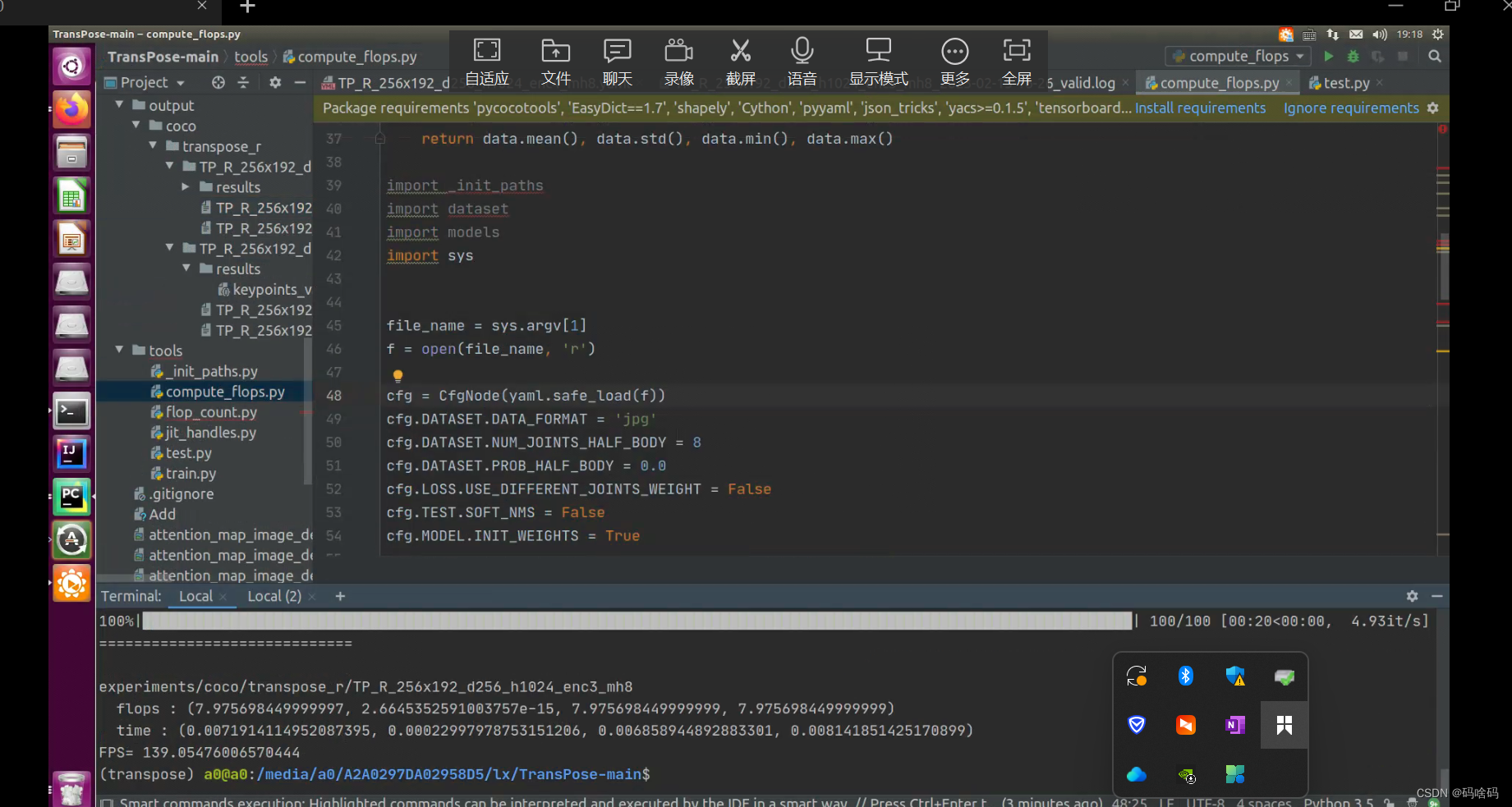

这是个主要的切入点正如我们在论文中所描述的,计算前100幅图像的flops在COCO val2017上,并报告平均结果

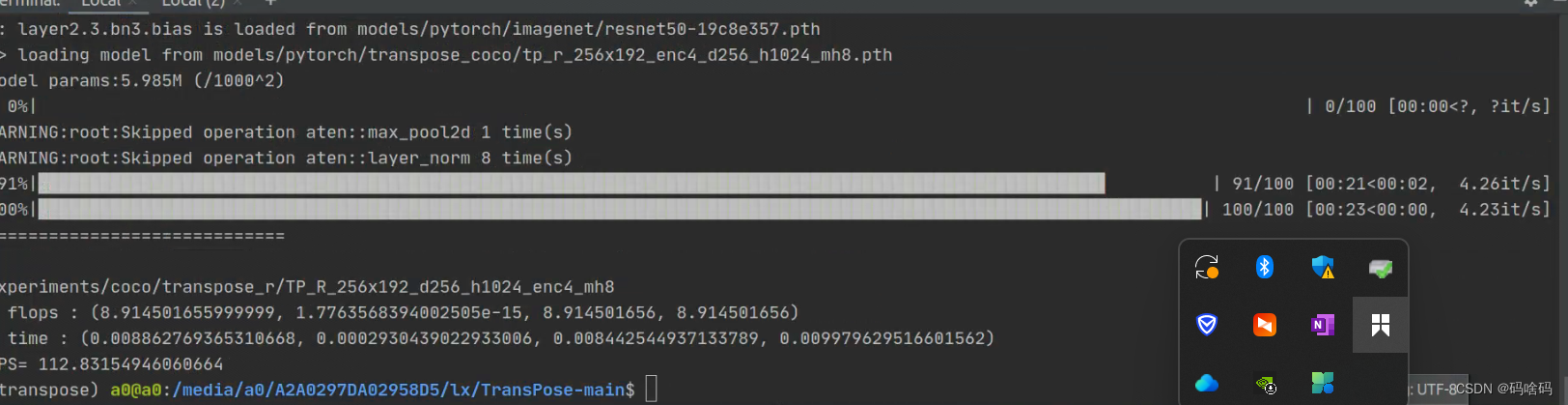

python tools/compute_flops.py experiments/coco/transpose_r/TP_R_256x192_d256_h1024_enc3_mh8.yaml

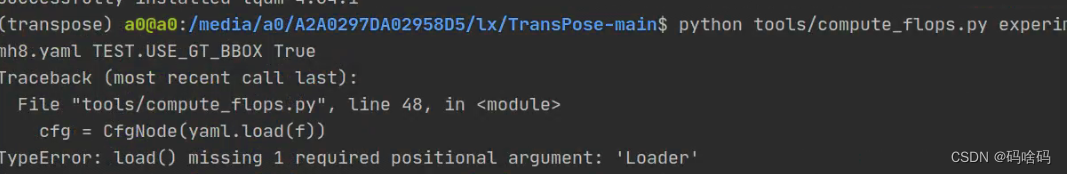

注意在compute_flops会有一个报错

解决办法:修改compute_flops 第48行

用以下三种方式都可以

d1=yaml.load(file,Loader=yaml.FullLoader)

d1=yaml.safe_load(file)

d1 = yaml.load(file, Loader=yaml.CLoader)

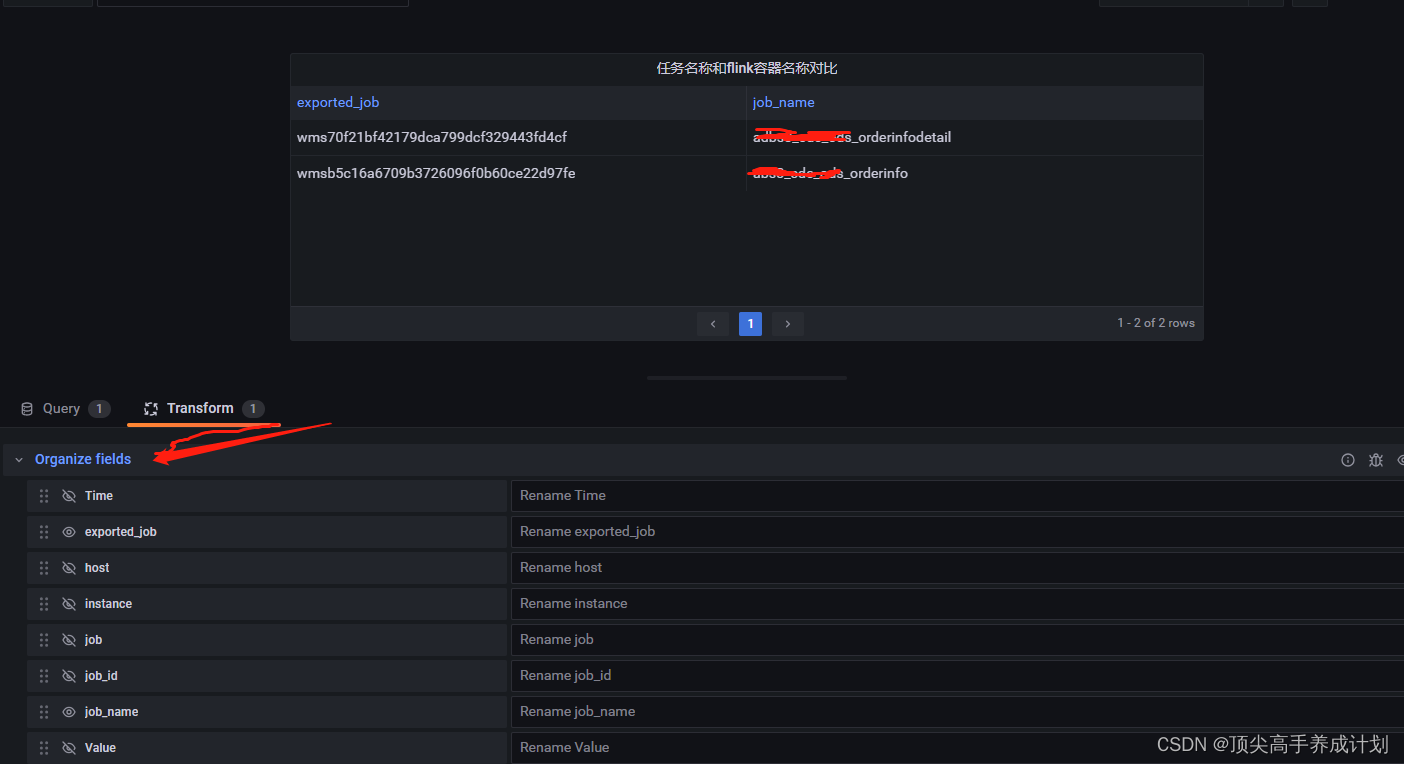

得到的FPS如下图所示:

同理可以实现HRNet