文章目录

- 1.Mysql复杂安装详细解说

- 1.1 安装mysql主从复制

- 2.Redis复杂安装详细解说

- 2.1 分布式存储算法

- 2.2 Redis主从安装

- 2.2.1 Redis集群3主3从的说明

- 2.2.2 Redis集群配置

- 2.2.3 主从容错切换迁移案例

- 2.2.4 主从扩容案例

- 2.2.5 主从缩容案例

- 3.Dockerfile解析⭐️

- 3.1 Dockerfile简介

- 3.2 Dockerfile构建过程解析

- 3.3 Dockerfile常用保留字指令

- 3.3 Dockerfile案例演示

- 3.3.1 要求

- 3.3.2 编写

- 3.3.3 构建

- 3.3.4 虚悬镜像

- 4.Docker网络⭐️

- 4.1 Docker的网络是什么?

- 4.2 网络常用的命令

- 4.3 Docker网络能干嘛?

- 4.4 Docker网络模式

- 4.4.1 网络模式介绍

- 4.4.2 容器实例内默认网络IP生产规则

- 4.4.3 案列说明

- 5.Docker-compose容器编排

- 5.1 什么是Docker-Compose?

- 5.2 Docker-Compose能干嘛?

- 5.3 Docker-Compose的安装与卸载?

- 5.4 Docker-Compose核心概念

- 5.5 Docker-Compose使用的三个步骤

- 5.6 Docker-Compose常用命令

- 6.Docker轻量化图形工具Portainer

- 6.1 是什么?

- 6.2 安装

- 6.2.1 官网

- 6.2.2 安装步骤

- 7.Docker容器监控

- 7.1 现状

- 7.2 容器监控三件套

- 7.3 三件套的docker-compose.yml

1.Mysql复杂安装详细解说

1.1 安装mysql主从复制

- 新建一个主服务器实例3307

docker run -p 3307:3306 --name mysql-master --privileged=true -v /root/mysql-master/log:/var/log/mysql -v /root/mysql-master/data:/var/lib/mysql -v /root/mysql-master/conf:/etc/mysql/conf.d -e MYSQL_ROOT_PASSWORD=root -d mysql:5.7 - 进入/mydata/mysql-master/conf目录下新建my.cnf

[mysqld] ## 设置server_id,同一局域网中需要唯一 server_id=101 ## 指定不需要同步的数据库名称 binlog_ignore_db=mysql ## 开启二进制日志功能 log_bin=mall_mysql_bin ## 设置二进制日志使用内存大小(事务) binlog_cache_size=1M ## 设置使用的二进制日志格式(mixed、statement、row) binlog_format=mixed ## 二进制日志过期清理时间。默认值为0;表示不自动清理。 expire_logs_days=7 ## 跳过主从复制中遇到的所有错误或指定类型的错误,避免slave复制中断 ## 如:1062错误是指一些主键重复,1032错误是因为主从数据库数据不一致 slave_skip_errors=1062 - 修改完配置后重启master实例

docker restart mysql-master - 进入mysql-master容器

docker exec -it 容器ID /bin/bash - master容器实例内创建数据同步用户

# 创建了一个slave用户,登陆密码为123456 CREATE USER 'slave'@'%'IDENTIFIED BY '123456' # 授予了一定的权限 GRANT REPLICATION SLAVE,REPLICATION CLIENT ON *.* TO 'slave'@'%'; - 新建从服务器实例3308

docker run -p 3308:3306 --name mysql-slave --privileged=true -v /root/mysql-slave/log:/var/log/mysql -v /root/mysql-slave/data:/var/lib/mysql -v /root/mysql-slave/conf:/etc/mysql/conf.d -e MYSQL_ROOT_PASSWORD=root -d mysql:5.7 - 进入/mydata/mysql-slave/conf目录下新建my.cnf

[mysqld] ## 设置server_id,同一区域网需要唯一 server_id=102 ## 指定不需要同步的数据库名称 binlog_ignore_db=mysql ## 开启二进制日志功能,以备slave作为其他数据库实例的Master时使用 log_bin=mall_mysql_slave1_bin ## 设置二进制日志使用内存大小 binlog_cache_size=1M ## 设置使用的二进制日志格式(mixed,statement,row) binlog_format=mixed ## 二进制日志过期时间。默认值为0,表示不自动清理. expire_logs_days=7 ## 跳过主从复制中遇到的所有错误或指定类型的错误,避免slave端复制中断 ## 如:1062错误是指一些主键重复,1032错误是因为主从数据库不一致 slave_skip_errors=1062 ## relay_log配置中继日志 relay_log=mall_mysql_relay_bin ## log_slave_updates表示slave将复制事件写进自己的二进制文件 log_slave_updates=1 ## slave设置为只读(具有super权限的用户除外) read_only=1 - 修改完配置后重启salve实例

docker restart mysql-slave - 在主数据库中查看主从同步状态

# 在mysql中执行 show master status; - 进入mysql-slave容器

docker exec -it mysql-slave /bin/bash - 在从数据库中配置主从配置

change master to master_host="宿主机ip",master_user='slave',master_password='123456',master_port=3307,master_log_file='mall-mysql-bin.000001',master_log_pos=617,master_connect_retry=30 - 在从数据库中查看主从同步状态

show slave status \G; - 在从数据库中开启主从同步

start slave; - 查看从数据库发现已经同步

- 主从复制测试

# 如果显示connecting建议运行以下操作 firewall-cmd --query-port=3306/tcp # 如果是no firewall-cmd --add-port=3306/tcp

2.Redis复杂安装详细解说

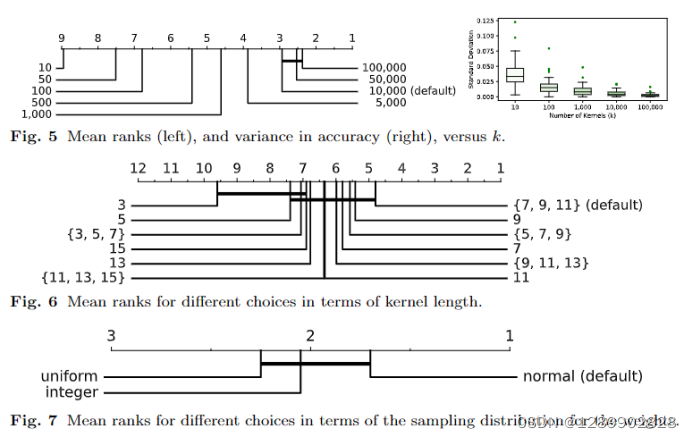

2.1 分布式存储算法

🔗点击查看

2.2 Redis主从安装

2.2.1 Redis集群3主3从的说明

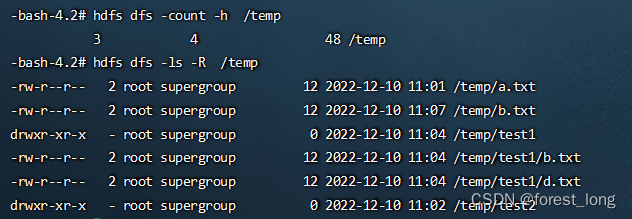

具体配置以实际输出为主

2.2.2 Redis集群配置

-

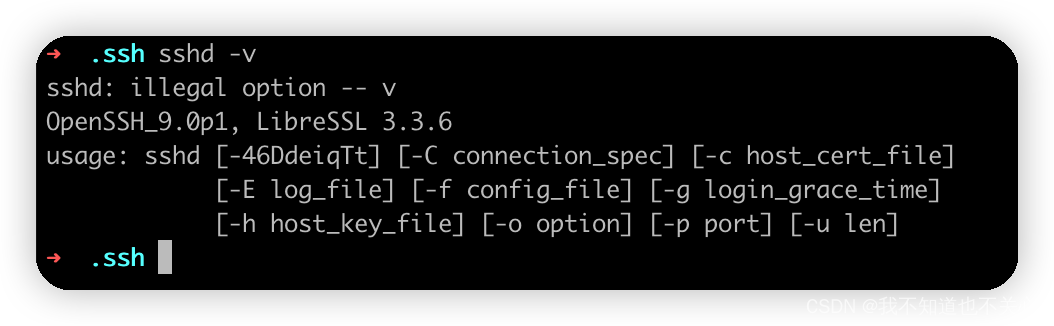

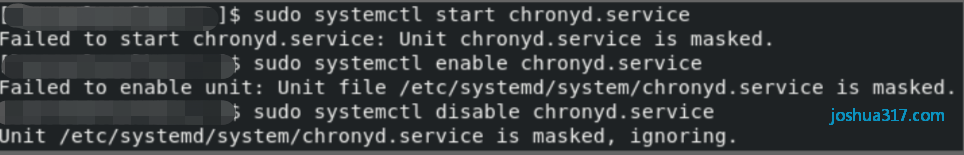

关闭防火墙+启动docker后台服务

systemctl stop firefalld systemctl start docker- 新建6个docker容器实例

docker run -d --name redis-node-1 --net host --privileged=true -v /root/data/redis/share/redis-node-1:/data redis:latest --cluster-enabled yes --appendonly yes --port 6381 docker run -d --name redis-node-2 --net host --privileged=true -v /root/data/redis/share/redis-node-2:/data redis:latest --cluster-enabled yes --appendonly yes --port 6382 docker run -d --name redis-node-3 --net host --privileged=true -v /root/data/redis/share/redis-node-3:/data redis:latest --cluster-enabled yes --appendonly yes --port 6383 docker run -d --name redis-node-4 --net host --privileged=true -v /root/data/redis/share/redis-node-4:/data redis:latest --cluster-enabled yes --appendonly yes --port 6384 docker run -d --name redis-node-5 --net host --privileged=true -v /root/data/redis/share/redis-node-5:/data redis:latest --cluster-enabled yes --appendonly yes --port 6385 docker run -d --name redis-node-6 --net host --privileged=true -v /root/data/redis/share/redis-node-6:/data redis:latest --cluster-enabled yes --appendonly yes --port 6386这个地方–net host可以看后面Docker网络的解释

查看一下起来的container:

-

进入docker-node-1并为6台机器构建集群关系

# 进入容器 docker exec -it redis-node-1 /bin/bash # 构建主从关系 redis-cli --cluster create 139.155.56.240:6381 139.155.56.240:6382 139.155.56.240:6383 139.155.56.240:6384 139.155.56.240:6385 139.155.56.240:6386 --cluster-replicas 1–cluster-replicas 1表示为每个master创建一个slave节点。【相当于是一种创建策略】

-

链接进入6381作为切入点,查看集群状态

cluster info cluster nodes

2.2.3 主从容错切换迁移案例

- 数据读写存储⭐️

-

对这个错误的分析,是因为key在被hash之后,其对应的卡槽数超过了这个节点的上的能够存储的范围,所以它会直接报错。这主要是因为刚才登陆方式有问题,主要有以下两种登陆方式

# 登陆方式1:非集群的方式登陆 redis-cli -p 6381 # 登陆方式2:集群的方式的登陆 redis-cli -p 6381 -c

-

检查集群的信息

redis-cli --cluster check 127.0.0.1:6381

-

容错切换迁移

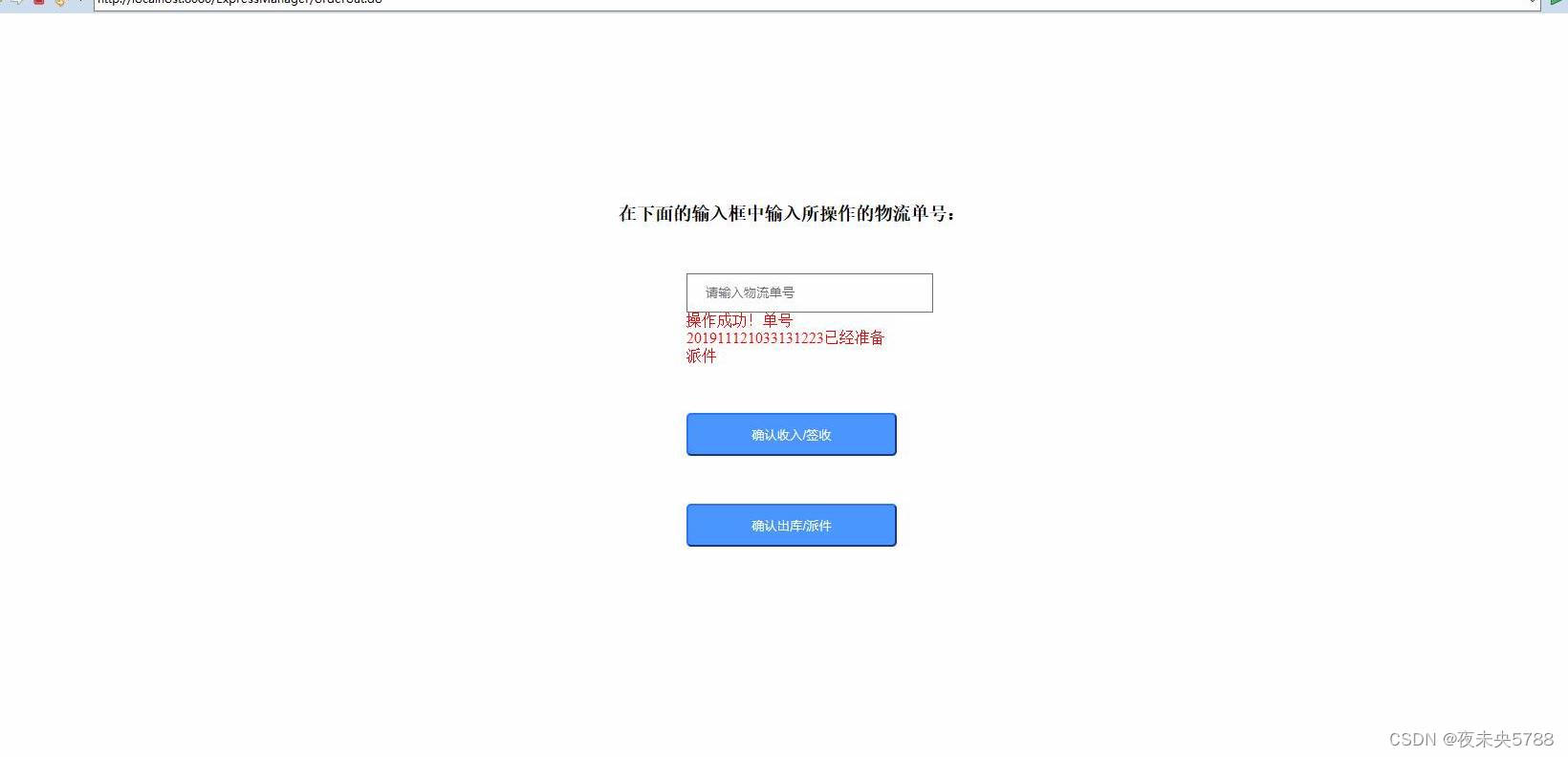

主从容错简单来说是指当master宕机之后,slave能够顺利的成为master顶替原来宕机的master的位置。# 停止6381 docker stop redis-node-1 # 进入6382查看集群状态 docker exec -it redis-node-2 /bin/bash # 进入redis客户端 redis-cli -p 6382 -c # 查看集群情况 cluster nodes

-

2.2.4 主从扩容案例

三主三从——>四组四从。扩容一个基本的思考是之前slot已经分配好了,所以现在新放进来一个怎么分配这个slot。

-

新建6387、6388两个节点+后台启动+查看是否一共是8个节点

docker run -d --name redis-node-7 --net host --privileged=true -v /root/data/redis/share/redis-node-7:/data redis:latest --cluster-enabled yes --appendonly yes --port 6387 docker run -d --name redis-node-8 --net host --privileged=true -v /root/data/redis/share/redis-node-8:/data redis:latest --cluster-enabled yes --appendonly yes --port 6388 -

进入6387容器实例内部

docker exec -it redis-node-7 -

将新增的6387节点(空槽号)作为master节点加入原集群

# 6387 就是要将作为master新增节点 # 6381 就是原来集群里面的领路人,相当于6387拜拜6381的码头从而找到组织加入集群 redis-cli --cluster add-node ip:6837 ip:6381

-

检查集群情况第1次

redis-cli --cluster check 127.0.0.1:6381

-

重新分派槽号⭐️

# 新的节点进入集群必须重新分配slot redis-cli --cluster reshard IP地址:端口号

-

检查集群情况第2次

分析上面slot分配的情况,简单来说,设置了4096,所以三个主机各自的分配出来一些节点给第四个节点,如果全部重新分配的成本太高了,所以第四个节点的slot会呈现出一段一段的情况,最终实现大家的slot的个数都是4096。 -

为主节点6387分配从节点6388

# 主节点的id需要根据你自己来判断 redis-cli --cluster add-node 127.0.0.1:6388 127.0.0.1:6387 --cluster-salve --cluster-master-id 02e58802c8acb191cc51a81c028e4e023f58c8f0

-

检查集群情况第3次

2.2.5 主从缩容案例

- 获得6388的ID

redis-cli --cluster check 127.0.0.1:6381 - 先删除6388

redis-cli --cluster del-node IP:从机端口 从机6388节点ID

- 清出来的槽号重新分配

# 本例将清出来的槽号都给6381 redis-cli --cluster reshard 127.0.0.1:6381

图中第一个红框表示谁接受slot(6381),第二个红框表示从哪里获取这些slot(6387) - 检查集群的情况第一次

redis-cli --cluster check 127.0.0.1:6381

- 再删除6387

redis-cli --cluster del-node IP:端口 6387节点ID

- 检查集群的情况第2次

恢复成了3主3从redis-cli --cluster check 127.0.0.1:6381

3.Dockerfile解析⭐️

3.1 Dockerfile简介

- 是什么?

Dockerfile是用来构建docker镜像的文本文件,是由一条条构建镜像所需的指令和参数所组成的脚本。其一般主要包含两个步骤,一是编写Dockerfile文件;二是利用Docker build命令构建镜像;三是使用docker run 依镜像运行容器实例

3.2 Dockerfile构建过程解析

- Dockerfile内容基础知识

- 每条保留字指令都必须为大写字母且后面要跟随至少一个参数

- 指令按照从上到下,顺序执行

- #表示注释

- 每条指令都会创建一个新的镜像层并对新的镜像进行提交

- Docker执行Dockerfile的大致过程

- Docker从基础镜像运行一个容器

- 执行一条指令并对容器作出修改

- 执行类似docker commit的操作提交一个新的镜像层

- docker再基于刚提交的镜像运行一个新容器

- 执行dockerfile中的下一条指令直到所有的指令都执行完成

- 小总结

从应用软件的角度来看,Dockerfile、Docker镜像与Docker容器分别代表软件的三个不同阶段:

- Dockerfile是软件原材料

- Docker镜像是软件的交付品

- Docker容器则可以认为是软件镜像的运行态,也即依照镜像运行的容器实例

Dockerfile面向开发,Docker镜像成为交付标准,Docker容器则涉及部署与运维,三者缺一不可,合力充当Docker体系的基石。

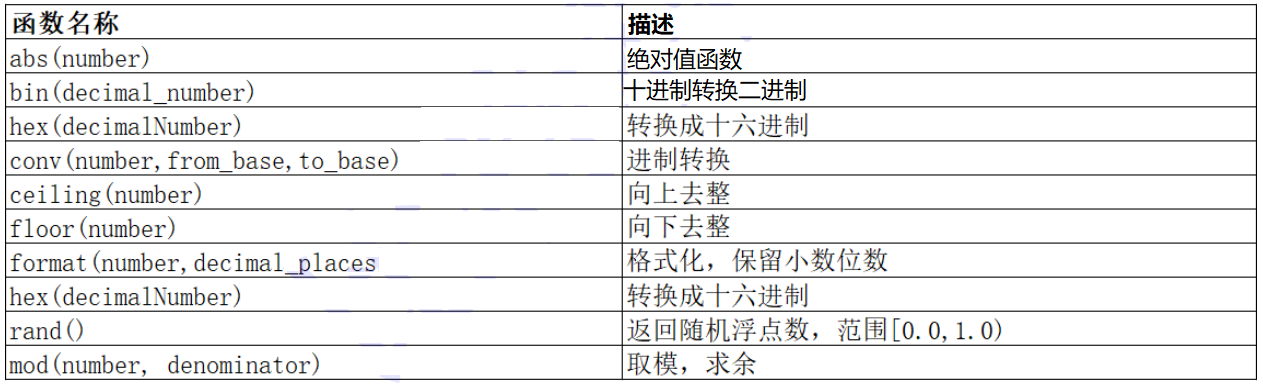

3.3 Dockerfile常用保留字指令

- 常用关键字

FROM —— 基础镜像,当前新镜像基于哪个镜像的,指定一个已经存在的镜像作为模版,第一条必须是FROM; MATINTAINER —— 镜像维护者的姓名和邮箱地址; RUN —— 容器构建时需要运行的命令,有两种格式shell格式和exec格式,Run是docker build时运行; EXPOSE —— 当前容器暴露的端口; WORKDIR —— 指定在创建容器后,终端默认登陆的进来工作目录,一个落脚点; USER —— 指定该镜像以什么样的用户去执行,如果都不指定,默认是root; ENV —— 用来构建环境变量,这个环境变量可以在后续的任何RUN指令中使用,这就如同在命令前面指定了环境变量前缀一样; ADD —— 将宿主机目录下的文件拷贝进镜像且会自动处理URL和解压tar压缩包,相当于COPY+解压; COPY —— 讲宿主机的文件拷贝进入容器中 VOLUME —— 容器卷,用于数据持久化 CMD —— 指定容器启动后的要干的事情,注意和RUN的区别,CMD是在docker run时运行而RUN是docker build时候运行。 ENTRYPOINT —— 也是用来制定一个容器启动时要运行的命令,类似于CMD指令,但是ENTRYPOINT不会被docker run 后面的命令覆盖,而这些命令行参数会被当作参数送给ENTRYPOIINT指令指定的程序

3.3 Dockerfile案例演示

3.3.1 要求

- Centos7镜像具备vim、ifconfig、jdk8

- jdk的下载镜像地址

3.3.2 编写

编写Dockerfile

FROM centos:centos7

MAINTAINER dengzhaowork@gmail.com

ENV MYPATH /usr/local

WORKDIR $MYPATH

# 安装vim编辑器

RUN yum update -y

RUN yum -y install vim

# 安装ifconfig命令查看网络IP

RUN yum -y install net-tools

# 安装java8及lib库

RUN yum -y install glibc.i686

RUN mkdir /usr/local/java

# ADD是相对路径jar,把jdk-8u171-linux-x64.tar.gz添加到容器中,安装包必须要和Dockerfile文件在同一位置

ADD jdk-8u171-linux-x64.tar.gz /usr/local/java

# 配置java环境

ENV JAVA_HOME /usr/local/java/jdk1.8.0_171

ENV JRE_HOME $JAVA_HOME/jre

ENV CLASSPATH $JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar:$JAVA_HOME/lib:$CLASSPATH

ENV PATH $JAVA_HOME/bin:$PATH

EXPOSE 80

CMD echo $MYPATH

CMD echo "success------------ok"

CMD /bin/bash

自己编写一个配置Go语言开发环境的

FROM centos:centos7

MAINTAINER dengzhaowork@gmail.com

ENV MY_WORK_PATH /usr/local

WORKDIR $MY_WORK_PATH

# 创建Go的目录

RUN mkdir $MY_WORK_PATH/go

RUN mkdir $MY_WORK_PATH/bin/myproject

ADD go1.19.3.linux-amd64.tar.gz /usr/local

ENV PATH $PATH:/usr/local/go/bin

ENV GOPATH $MY_WORK_PATH/bin/myproject

EXPOSE 80

CMD echo $MYPATH

CMD echo "success------------ok"

CMD /bin/bash

3.3.3 构建

# 注意tag之后还有个空格和.

docker build -t 新镜像的名字:tag .

3.3.4 虚悬镜像

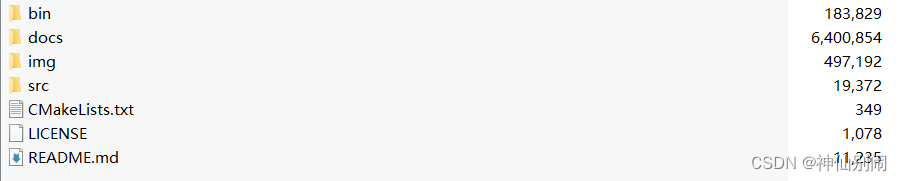

-

仓库名、标签都是<none>的镜像,俗称dangling image,例如下面Dockerfile就是一个虚悬镜像

FROM ubuntu CMD echo "dangling image test"# 运行上面这个Dockerfile docker build . -

查询所有虚悬镜像

docker image ls -f dangling=true -

删除所有虚悬镜像

docker image prune

4.Docker网络⭐️

4.1 Docker的网络是什么?

- docker启动后,使用ifconfig命令会发现多了以下模块

- docker查看网络的命令

docker network ls

4.2 网络常用的命令

- All命令

# 遇到有不懂的命令的时候建议使用该命令进行查询

docker network --help

- 查看网络

docker network ls

- 查看网络数据源

docker network inspect xx网络名字

- 删除网络

docker network rm xx网络名字

4.3 Docker网络能干嘛?

- 容器间的互联和通信以及端口映射

- 容器IP变动时候可以通过服务名直接网络通信不受到影响

4.4 Docker网络模式

4.4.1 网络模式介绍

| 网络模式 | 命令 | 简介 |

|---|---|---|

| bridge | –network bridge | 为每一个容器、设置IP,并将容器连接到一个docker0。虚拟网桥,默认为该模式 |

| host | –network host | 容器将不会虚拟出自己的网卡,配置自己的IP等,而是使用宿主机的IP和端口 |

| none | –network none | 容器有独立的network namespace,但并没有对其进行任何网络设置,乳分配veth pair和网桥连接、IP等 |

| container | –network container:NAME或者容器ID指定 | 新创建的容器不会创建自己的网卡和配置自己的IP,而是和一个指定的容器共享IP、端口范围等 |

我们90%的应用场景都是bridge。简单的理解就是“主机给每一个容器都发了一个口罩”。

4.4.2 容器实例内默认网络IP生产规则

首先进行下面的操作,对容器的IP进行查看

docker run -it --name u1 ubuntu

docker run -it --name u2 ubuntu

# 检查后20行,最终的结果如下表所示

docker inspect u1 | tail -n 20

docker inspect u2 | tail -n 20

如果这个时候容器shutdown了,那么重新起来的容器会占用原来停掉的端口。也就是说原来我们在项目中使用固定IP的方式在这种环境里面可能不太适用,最好的方式还是通过服务名获取。docker容器里面的ip是可能会发生变化的。

4.4.3 案列说明

- bridge

- Docker服务默认会创建一个docker0网桥(其中一个docker0内部接口),该桥接网络的名称为docker0,它在内核层连通了其他的物理或虚拟网卡,这就将所有的容器和本地主机都放到同一个物理网络。Docker默认指定了docker0的接口IP地址和子网掩码,让主机和容器之间可以通过网桥相互通信。

- Docker适用Linux桥接,在宿主机虚拟一个Docker容器网桥(docker0),Docker启动一个容器时会根据Docker网桥的网段分配给容器一个IP地址,称为Container-IP直接通信。

- docker run的时候,没有指定network的话默认使用的网络模式就是docker0。在宿主机ifconfig,就可以看到docker0和自己create的network eth0、eth1、eth2…代表网卡1、网卡2…,lo代表127.0.0.1,即localhost.inet.addr用来表示网卡的IP地址。

- 网桥docker0创建一对对等虚拟设备接口叫veth,另一个叫做eth0.成对匹配。整个宿主机的网桥模式都是docker0,类似一个交换机有一堆接口,每一个接口叫veth。在本地主机和容器内创建一个虚拟接口,并让他们彼此联通,这样一对接口叫做veth pair;每个容器实例内部也有一块网卡,每个接口叫eth0,两两配对,一一匹配。通过上述,讲宿主机上所有的容器都连接到这个内部网络上,两个容器在同一网络下,会从这个网关下各自拿到分配的到ip。此时两个容器的网络是互通的。

- 代码验证

docker run -d -p 8081:8080 --name tomcat81 镜像名 docker run -d -p 8082:8080 --name tomcat82 镜像名 # 使用下面命令查看当前网卡的具体情况 ip addre

进入容器内部查看的情况:容器内部是eth0

- host

- 直接使用宿主机的IP地址与外界通信,不再需要额外的进行NAT抓换。

- 容器将不会获得一个独立的Network Namespace,而是和宿主机共用一个Network NameSpace。容器将不会虚拟出自己的网卡而是使用宿主机的IP和端口。

- 命令

# 注意如果这个使用-p 8083:8080的话会给出警告,因为这里本来就不再涉及到端口映射的问题 docker run -d --network host --name tomcat83 镜像名 docker inspect 容器id

- 那么这个时候如何访问tomcat83呢?

因为是共用,所以这个时候直接访问8080端口即可,“相当于本机上装了tomcat”

- none

- 禁用网络功能,只有Io标识(就是127.0.0.1表示本地回环);

- 在none模式下,并不为Docker容器进行任何网络配置,也就是说,这个Docker容器没有网卡、IP、路由等信息,只有一个Io,需要我们自己为Docker容器添加网卡,配置IP等。

- 启动命令

docker run -d -p 8084:8080 --network none --name tomcat84 镜像ID

- container

-

新建的容器和已经存在的一个容器共享一个网络IP配置而不是和宿主机共享。新建的容器不会创建自己的网卡,配置自己的IP,而是和一个指定的容器共享IP、端口范围等。同样的,两个容器除了网络方面,和其他的如文件系统、进程列表等还是隔离的。

-

命令

# 一种典型的错误如下 docker run -d -p 8085:8080 --name tomcat85 镜像名 docker run -d -p 8086:8080 --network container:tomcat85 --name tomcat86 镜像名

#正确操作如下 docker run -it --name alpine1 alpine /bin/sh docker run -it --network container:alpine1 --name alpine2 alpine /bin/sh # 运行结果,验证共用搭桥 # 假如此时关闭alpine1,再看看alpine2

关闭alpine1,查看alpine2的IP情况【只剩一个lo了】

-

- 自定义网络

- 问题,主要就是如果按照IP连接可以连同,但是此时无法通过服务名来联通,因此,此时需要引入自定义的网络.

# ping alpine1 ping: bad address 'alpine1' # ping alpine2 ping: bad address 'alpine2' - 创建自定义网络

docker network create todolist_network # run的时候--network选择刚才创建的网络

- 问题,主要就是如果按照IP连接可以连同,但是此时无法通过服务名来联通,因此,此时需要引入自定义的网络.

5.Docker-compose容器编排

5.1 什么是Docker-Compose?

docker-compose是Docker官方的开源项目,负责实现队Docker容器集群的快速编排。只需要定义一个YAML格式的配置文件docker-compose.yaml,写好多个容器之间的调用关系。然后只需要一个命令,就能同时启动/关闭这些命令。

5.2 Docker-Compose能干嘛?

- docker建议我们每一个容器中只运行一个服务,因为docker容器本身占用资源极少,所以最好是将每个服务单独分割开来但是又面临一个问题?如果我需要部署好多个服务,难道每个服务单独写Dockerfile然后构建镜像,这样构建镜像累都得累死,所以docker官方给我们提供了docker-compose多服务部署的工具。

- 例如要实现一个Web微服务项目,除了Web服务容器本身,往往还需要加上后端的数据库mysql服务容器,redis服务容器,注册中心eureka,甚至还包括负载均衡等等…

- compose允许用户通过一个单独的docker-compose.yaml模版文件(yaml格式)来定义一组相关联的应用容器为一个项目(project),可以很容易地用一个配置文件定义一个多容器应用,然后使用一条指令安装这个应用的所有依赖,完成构建。Docker-Compose解决了容器于容器之间如何管理编排的问题。

5.3 Docker-Compose的安装与卸载?

查看官网

5.4 Docker-Compose核心概念

- 一文件:docker-compose.yml

- 两要素:

- 服务(service):一个个应用容器实例,比如订单微服务、mysql容器、nginx容器或者redis容器;

- 工程(project):由一组关联的应用容器组成的一个完整的业务单元,在docker-compose.yml文件中定义;

5.5 Docker-Compose使用的三个步骤

- 编写Dockerfile定义各个微服务应用并构建出对应的镜像文件

- 使用docker-compose.yml定义一个完整的业务单元,安排好整体应用中的各个容器服务。

- 最后,执行docker-compose up命令,来启动并运行整个应用程序,完成一件部署上线。

5.6 Docker-Compose常用命令

在这里只列举常用的几个

- 启动所有docker-compose服务并后台运行

docker-compose up -d - 停止并删除容器、网络、卷、镜像

docker-compose down - 检查配置

docker-compose config - 检查配置,有问题才有输出

docker-compose config -q

6.Docker轻量化图形工具Portainer

6.1 是什么?

Portainer是一款轻量级的应用,它提供了图形化界面,用于方便的管理Docker环境,包括单机环境和集群环境。

6.2 安装

6.2.1 官网

Portainer官网

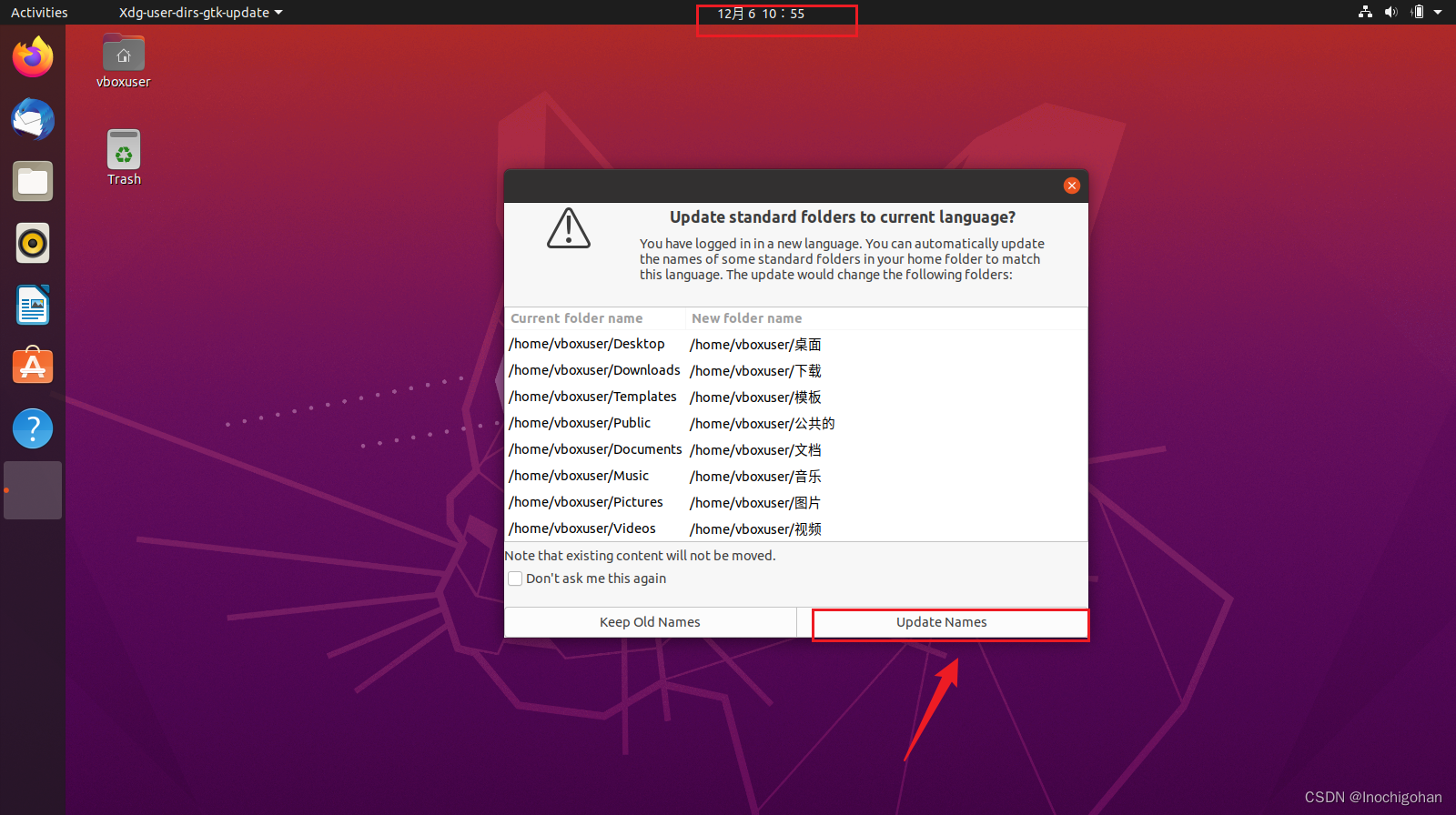

6.2.2 安装步骤

- 拖取镜像以及RUN

docker run -d -p 8000:8000 -p 9000:9000 -name portainer -v /var/run/docker.sock:/var/run/dcoker/sock -v /portainer_data:/data --restart=always portainer/portainer-ce:latest - 第一次登陆需要穿件admin,访问地址为:9000

7.Docker容器监控

7.1 现状

通过docker stats命令可以很方便的看到当前宿主机上所有容器的CPU,内存以及网络流量等数据,一般的小公司够用了。但是docker stats统计结果只能是当前宿主机的全部容器,数据资料是实时的,没有地方存储,没有健康指标过线预警等功能。

7.2 容器监控三件套

CAdvisor监控收集+InfluxDB存储数据+Granfana展示数据

- InfluxDB

- InfluxDB是用Go语言编写的一个开源式时序、事件和指标数据库,无需外部依赖;

- CAdvisor默认在本机保存最近2分钟的数据,为了持久化存储数据和统一收集展示监控数据,需要将数据存储到InfluxDB中。InfluxDB是一个时序数据库,专门用于存储数据和统一收集展示监控数据,需要将数据存储到InfluxDB中。InfluxDB是一个时序数据库,专门用于存储时序相关数据,很适合存储CAdvisor的数据。而且,CAavisor本已经提供了InfluxDB的集成方法,启动容器时指定配置即可。

- InfluxDB主要功能:1.基于时间序列,支持与时间有关的相关函数(如最大值、最小值、求和等);2.可度量性:可以实时对大量数据计算;3.他支持任一事件数据。

- Granfana

- Grafana是一个开源的数据监控分析可视化平台,支持多种数据源配置(支持influxDB,MySQL,Elasticsearch,OpenTSDB,Graphite等)和丰富的插件及模版功能,支持图表权限控制和报警。

- Grafana的主要特性:1.灵活丰富的图形化选项;2.可以混合多种风格;3.支持白天和夜间模式;4.多种数据源;

7.3 三件套的docker-compose.yml

version: '2'

services:

influxdb:

image: tutum/influxdb:0.9

environment:

- PRE_CREATE_DB=cadvisor

ports:

- "8083:8083"

- "8086:8086"

volumes:

- /root/mydocker/cig/data/influxdb:/data

cadvisor:

image: google/cadvisor

links:

- influxdb:influxsrv

command:

- storage_driver=influxdb-storage_driver_db=cadvisor-storage_driver_host=influxsrv:8086

ports:

- "8080:8080"

volumes:

- /:/rootfs:ro

- /var/run:/var/run:rw

- /sys:/sys:ro

- /var/lib/docker/:/var/lib/docker:ro

restart: always

grafana:

user: "104"

image: grafana/grafana

links:

- influxdb:influxsrv

command: ['sh', '-c', 'chown 777 /var/lib/grafana']

ports:

- "3000:3000"

volumes:

- /root/mydocker/cig/grafana/grafana_data:/var/lib/grafana

environment:

- HTTP_USER=admin

- HTTP_PASS=admin

- INFLUXDB_HOST=influxsrv

- INFLUXDB_POST=8086

restart: always

启动后

分别访问以下端口:

- 浏览cadvisor收集服务:http://ip:8080/

- 浏览influxdb存储服务:http://ip:8083/

- 浏览grafana展现服务:http://ip:3001