NeRF: Representing Scenes as Neural Radiance Fields for Novel View Synthesis

文章目录

- NeRF: Representing Scenes as Neural Radiance Fields for Novel View Synthesis

- Pipeline

- Steps

- Volume Rendering

- Optimization

- Positional Encoding

- Hierarchical Volume Sampling

- view-dependent

tradition: 用point clouds, mesh, voxel等方式显式表示scene,缺点: 离散表示,导致合成的view表面粗糙

NeRF:用MLP function隐式表示scene,优点:可微,即连续,合成的view表面细腻。

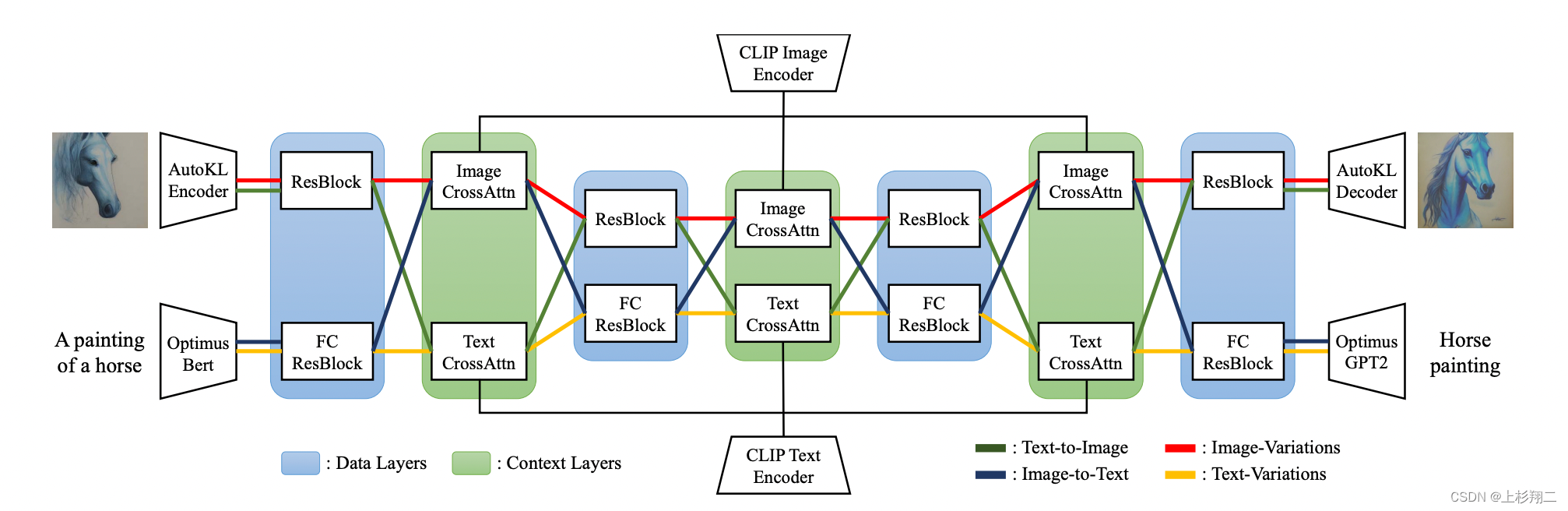

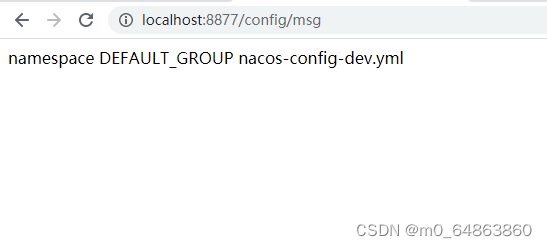

Pipeline

Steps

- 每张input view的每个像素都会生成一条

ray=o+td, t∈(tn, tf) - 会对每条ray进行N点采样,获得点的位置和方向信息,即5D input=(x, y, z, θ, φ)

- 将采样的每个点输入到MLP中得到2D output=(c, δ)

- 用volume rendering对每条ray上的N个采样点渲染,得到对应像素的颜色

- 对每张input view的每个像素的每条ray进行渲染,最终就可得到rendered view

- 用rendered view和input view计算loss,并优化

Volume Rendering

积分形式:

离散化:

动态示意图:

Optimization

Positional Encoding

MLP不能很好的学习高频函数,直接将5D信息输入到MLP,所渲染出的scene的表面比较模糊,即低频分量。

将5D信息映射到高维后,再进行训练渲染所得出的scene的表面有很清楚的纹理,即高频分量。

位置编码公式(对于位置L=10,角度L=4):

效果对比:

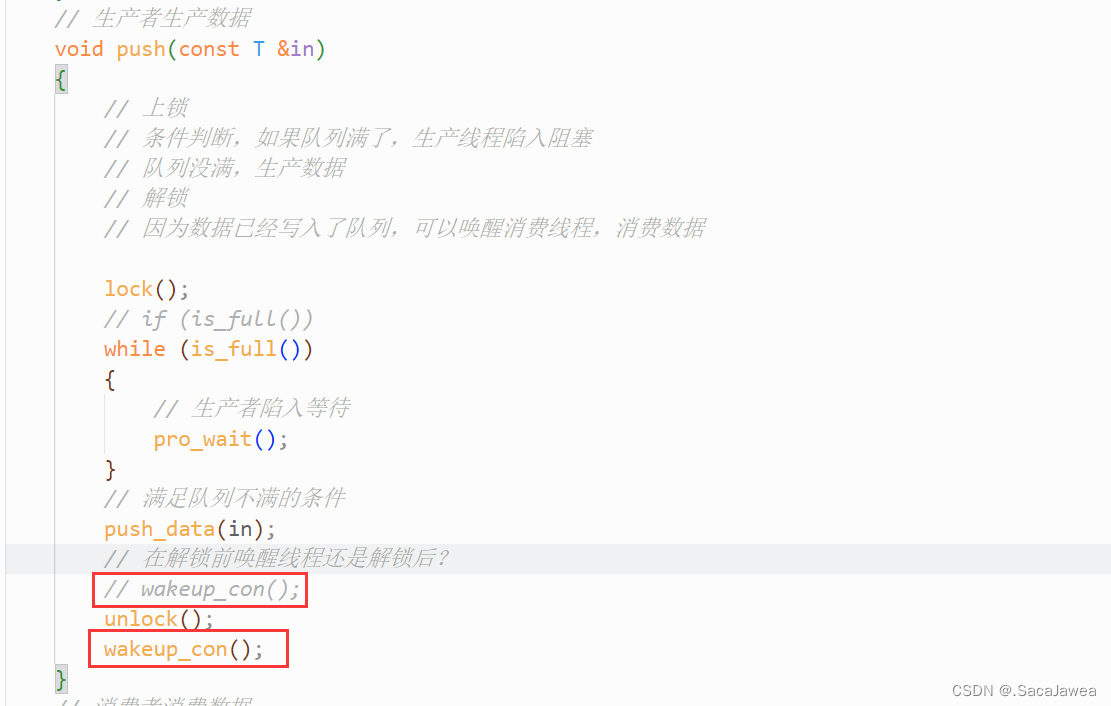

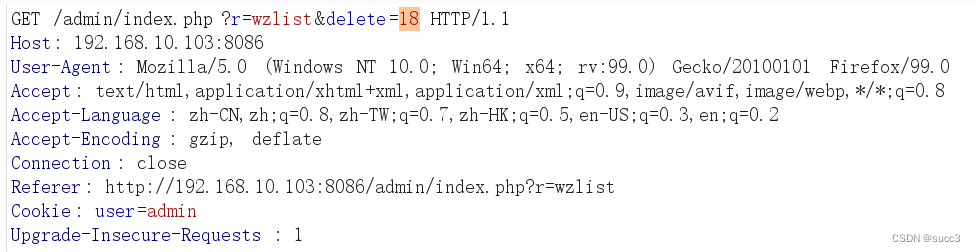

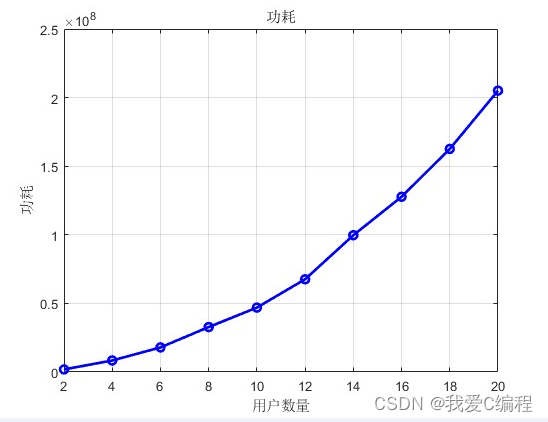

Hierarchical Volume Sampling

- N点采样时,如果均匀采样,则MLP只能学到离散位置的信息。将所需采样的区间均匀分为N段,在每一段内部采用均匀采样,这样就能够学习连续的位置信息。(对应下图中的白色采样点)

- “coarse to fine” 思想,通过上一步,将Nc个采样点输入到coarse network中去,计算透明度概率分布,然后再进行fine采样得到Nf个采样点,连同Nc输入到fine network中去。(红色曲线就是根据第一步得出的scene透明度概率分布,而红色点就是fine sampled point)

示意图:

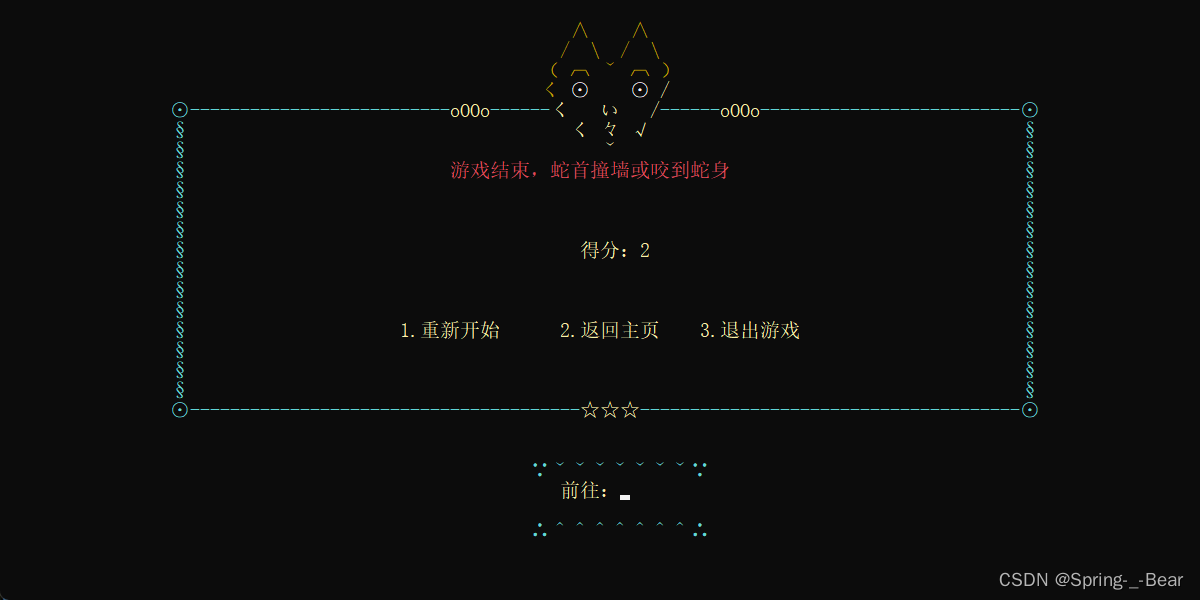

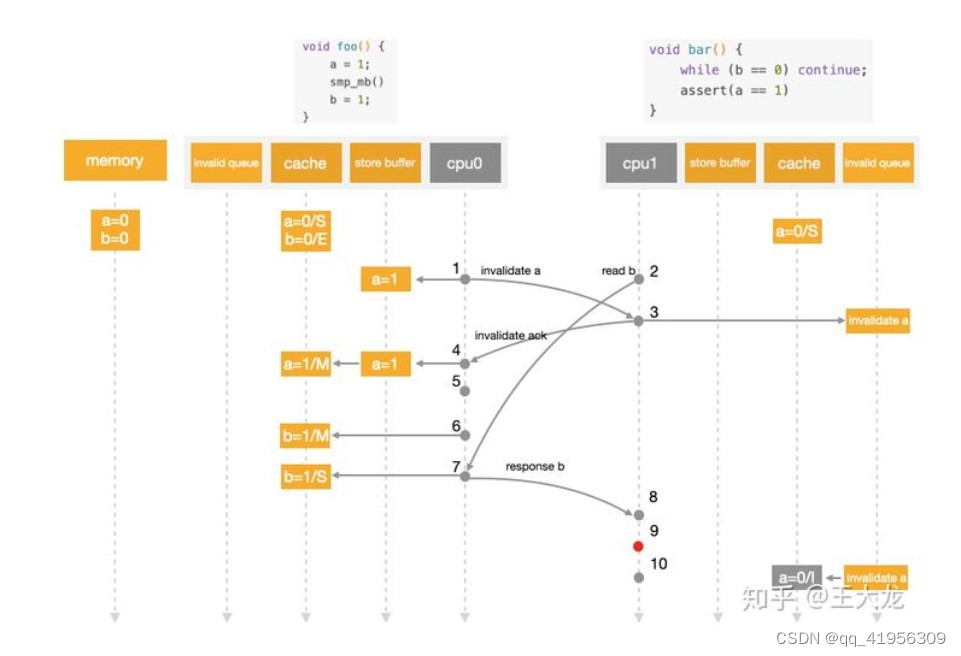

view-dependent

从不同的角度观察scene的同一个位置,透明度一样,但颜色可能不同。基于此,MLP的基本结构如下:

(上图来自网络,具体是哪忘了)

view-dependent能实现不同角度不同颜色的效果:

缺点:计算量大,虽然MLP网络不大,但每个采样点都需要送入到MLP中进行计算。