文章目录

- Prompt——1.Generated Knowledge Prompting for Commonsense Reasoning

- 核心

- 论文贡献

- 方法效果的影响因素

- 方法实现

- Contrastive learning——A Contrastive Framework for Learning Sentence Representations from Pairwise and Triple-wise Perspective in Angular Space

- 核心

- 训练目标1:对比学习

- 学习目标2:Triple-wise

- 总目标

Prompt——1.Generated Knowledge Prompting for Commonsense Reasoning

核心

是把常识知识融入到prompt,用于推理。

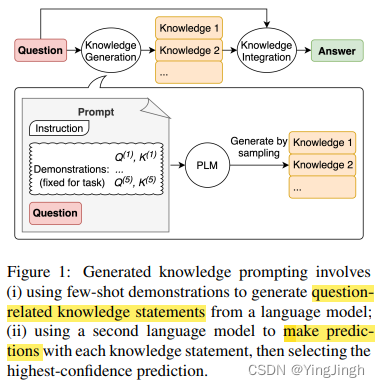

生成知识提示,包括从语言模型中生成知识,然后在回答问题时提供知识作为额外输入。

生成知识提示包括:

(i) 使用少量演示,从语言模型中生成与问题相关的知识陈述;

(ii) 使用第二个语言模型对每个知识陈述进行预测,然后选择置信度最高的预测。

论文贡献

1.调研了外部知识是否对于常识推理有帮助

2.从LLM中产生有用的知识,然后将这些知识融入到带问题的prompt中。

方法效果的影响因素

1.知识的质量

2.知识的数量

3.融入知识的策略(strategy for integrating knowledge during inference)——(1.no knowledge 2. random sentence 3. context sentences 4.template-generated knowledge 5. retrieval-based knowledge )

方法实现

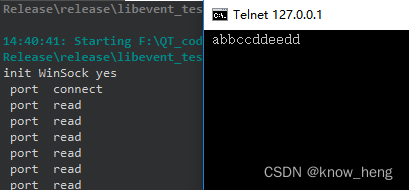

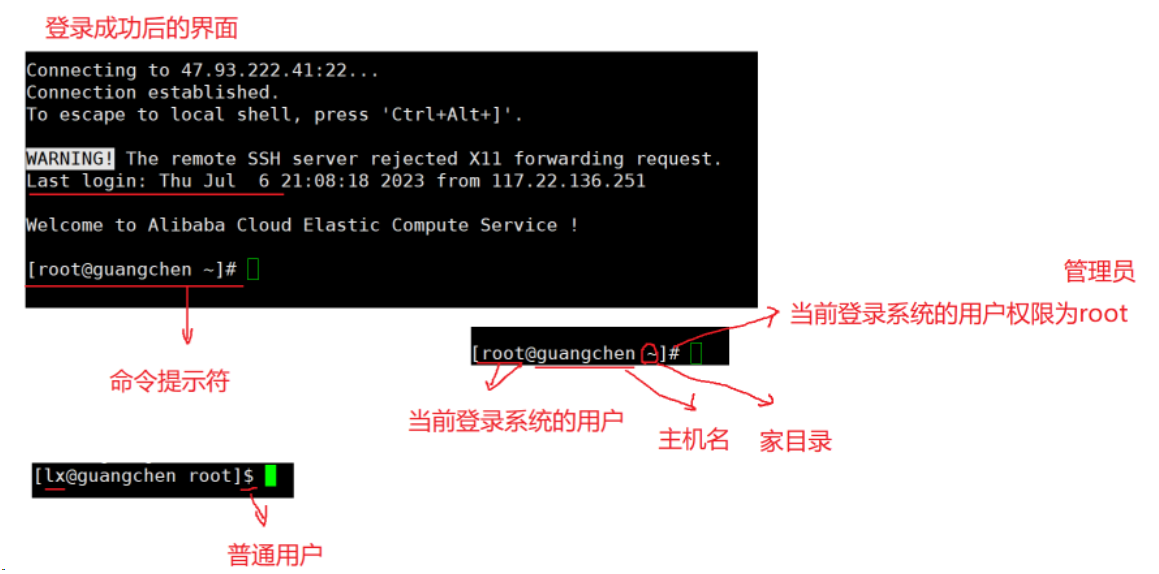

1.知识生成:利用语言模型基于question生成knowledge statements。

2. 知识融合:生成的知识融入,用于决策推断。

3.在推理时,使用每个generated knowledge statement 做预测,然后,选择highest-confidence 作为最终的prediction。

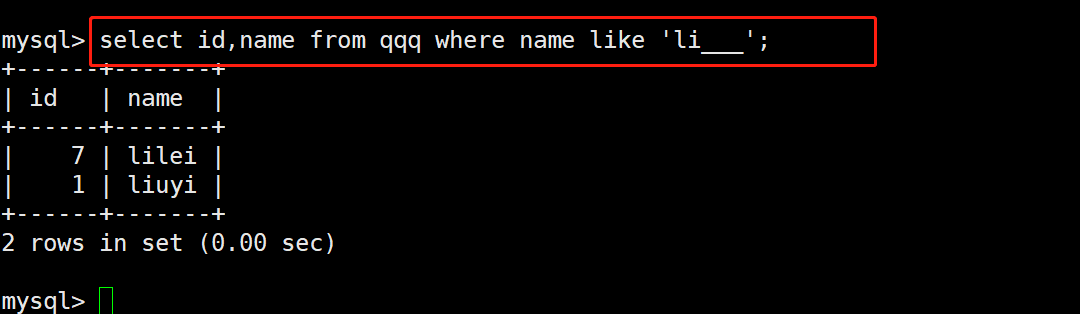

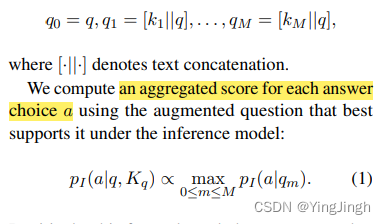

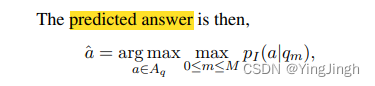

q表示question,k表示knowledge

选择置信度最大的作为最终的结果输出。

Contrastive learning——A Contrastive Framework for Learning Sentence Representations from Pairwise and Triple-wise Perspective in Angular Space

pairwise (成对)

triple-wise (三元组)

核心

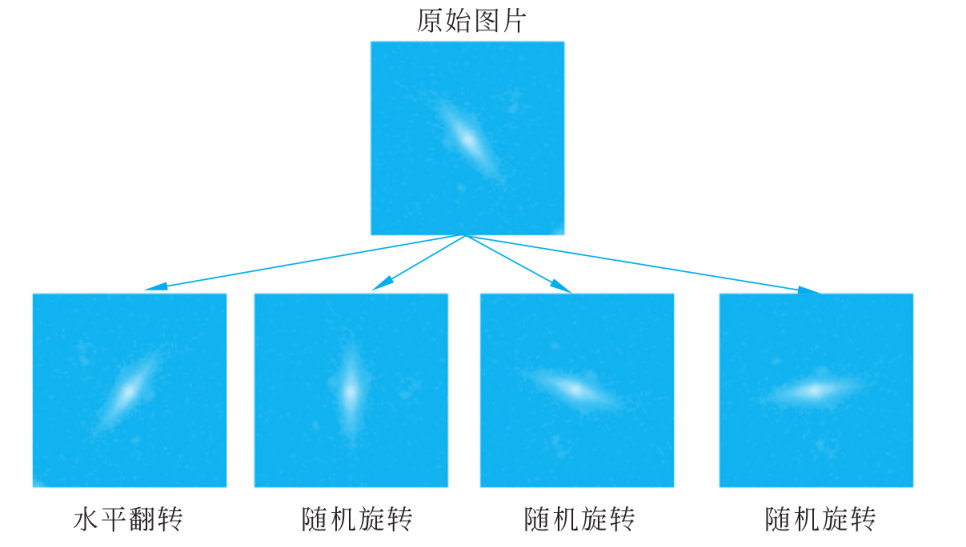

用角度代替了infoloss中的distance,要克服PLM学习到的semantic represenation是各项异性的缺点.

训练目标: Additive Angular Margin Contrastive Loss (ArcCon Loss)。它通过最大化角度空间中的判定余量来增强成对判别能力。

positive pairs: 同一个sentence做的不同rate的dropout.

negetive pairs: the representations of different sentences within the same batch.

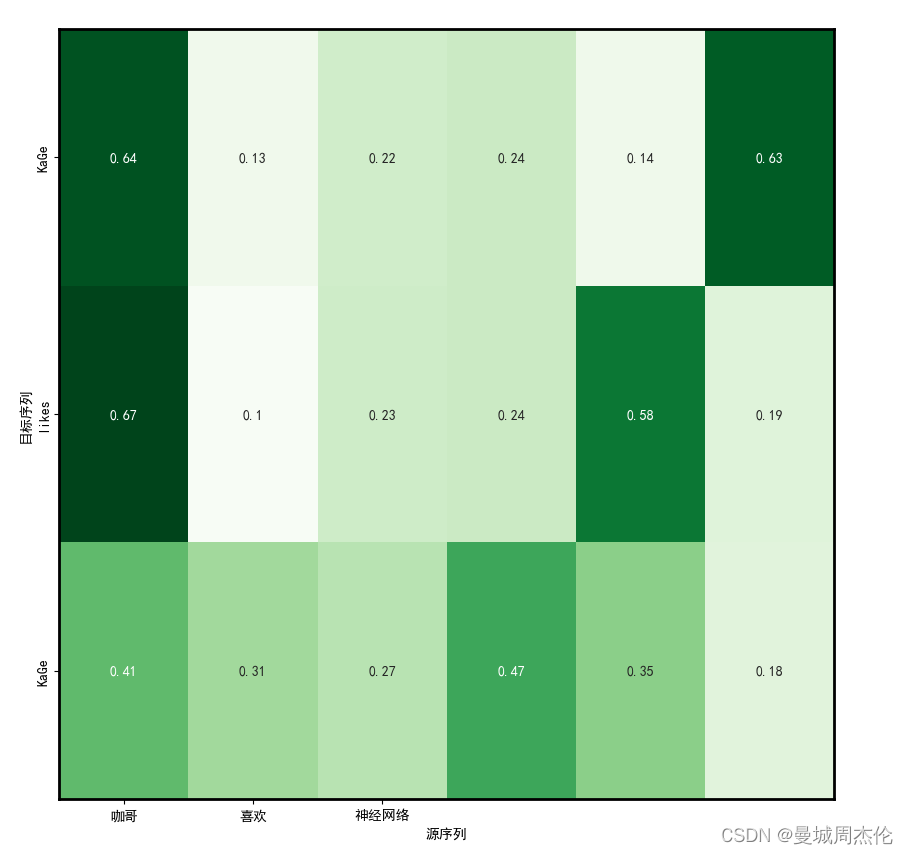

训练目标1:对比学习

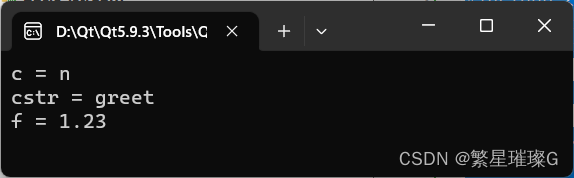

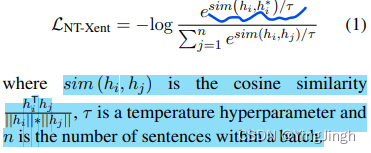

原来的contrastive learning objective:

论文中使用的additive angular margin :

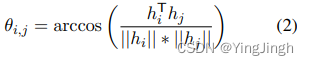

其中,θ的计算公式如下:

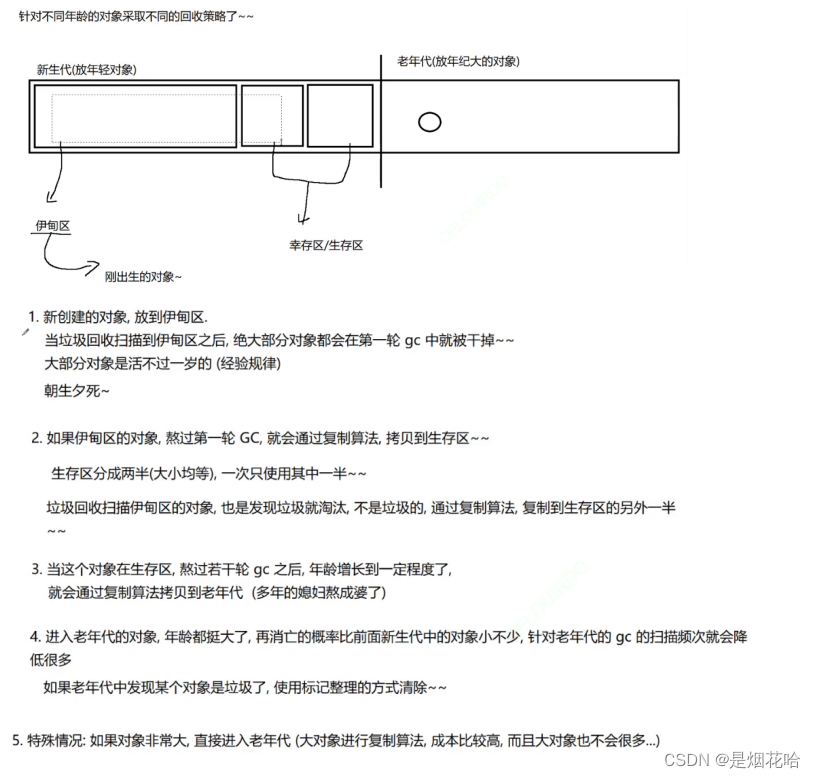

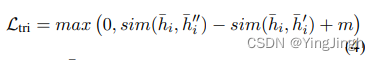

学习目标2:Triple-wise

对于文本数据集 D 中的每个句子 si,我们首先以20% 的屏蔽率屏蔽 si 的连续片段,生成外部句子 s ′ i。然后,我们扩大屏蔽区域,得到一个新句子 s ′′ i,屏蔽率为 si 的 40% .

假设条件: mask=20% 的句子比mask=40%的句子更相似。

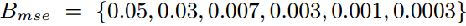

总目标

Larc是角度下的对比学习目标,Ltri是三元组相似度学习目标。