目录

一、k8s单主架构集群的部署

1.操作系统初始化配置

2.部署 etcd 集群

3.部署docker引擎

4.部署 Master 组件

5.部署 Worker Node 组件

6.部署网络组件(使用 flannel)

一、k8s单主架构集群的部署

k8s集群master01:192.168.116.10

k8s集群master02:192.168.116.20(第二部分高可用架构会加入)k8s集群node01:192.168.116.30

k8s集群node02:192.168.116.40etcd集群节点1:192.168.116.10(etcd集群原则上单独部署,此实验为方便部署在节点上)

etcd集群节点2:192.168.116.30

etcd集群节点3:192.168.116.40负载均衡nginx+keepalive01(master):192.168.116.50

负载均衡nginx+keepalive02(backup):192.168.116.60

1.操作系统初始化配置

#关闭防火墙

systemctl disable --now firewalld

iptables -F && iptables -t nat -F && iptables -t mangle -F && iptables -X

#关闭selinux

setenforce 0

sed -i 's/enforcing/disabled/' /etc/selinux/config

#关闭swap

swapoff -a

sed -ri 's/.*swap.*/#&/' /etc/fstab

#根据规划设置主机名

hostnamectl set-hostname master01

hostnamectl set-hostname node01

hostnamectl set-hostname node02

su

#添加主机名映射

vim /etc/hosts

#添加

192.168.116.10 master01

192.168.116.30 node01

192.168.116.40 node02

vim /etc/sysctl.d/k8s.conf

#开启网桥模式,可将网桥的流量传递给iptables链

net.bridge.bridge-nf-call-iptables=1

net.bridge.bridge-nf-call-ip6tables=1

#开启路由转发

net.ipv4.ip_forward=1

#关闭ipv6(可选)

#net.ipv6.conf.all.disable_ipv6=1

#加载系统配置

sysctl --system

#时间同步(可以做计划任务)

yum install ntpdate -y

ntpdate ntp.aliyun.com

crontab -e

*/10 * * * * /usr/sbin/ntpdate ntp.aliyun.com &> /dev/null

2.部署 etcd 集群

在 master01 节点上操作

先准备签发证书的环境

#准备cfssl证书生成工具

wget https://pkg.cfssl.org/R1.2/cfssl_linux-amd64 -O /usr/local/bin/cfssl

wget https://pkg.cfssl.org/R1.2/cfssljson_linux-amd64 -O /usr/local/bin/cfssljson

wget https://pkg.cfssl.org/R1.2/cfssl-certinfo_linux-amd64 -O /usr/local/bin/cfssl-certinfo

chmod +x /usr/local/bin/cfssl*

CFSSL是CloudFlare公司开源的一款PKI/TLS工具。CFSSL包含一个命令行工具和一个用于签名、验证和捆绑TLS证书的HTTPAPI服务。使用Go语言编写。

CFSSIL使用配置文件生成证书,因此自签之前,需要生成它识别的json格式的配置文件,CFSSL提供了方便的命令行生成配置文件。

CFSSL用来为etcd提供TLS证书,它支持签三种类型的证书:

cfssl:证书签发的工具命令

cfssljson:将cfssl生成的证书(json格式)变为文件承载式证书cfssl-certinfo:验证证书的信息

cfssl-certinfo -cert <证书名称> #可以使用此命令查看证书的信息

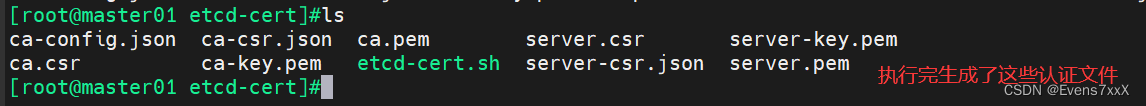

编写etcd-cert.sh用于生成CA证书、etcd 服务器证书以及私钥

mkdir -p /opt/k8s/etcd-cert

cd /opt/k8s/etcd-cert

vim /opt/k8s/etcd-cert/etcd-cert.sh

#!/bin/bash

#配置证书生成策略,让 CA 软件知道颁发有什么功能的证书,生成用来签发其他组件证书的根证书

cat > ca-config.json <<EOF

{

"signing": {

"default": {

"expiry": "87600h"

},

"profiles": {

"www": {

"expiry": "87600h",

"usages": [

"signing",

"key encipherment",

"server auth",

"client auth"

]

}

}

}

}

EOF

#ca-config.json:可以定义多个 profiles,分别指定不同的过期时间、使用场景等参数;

#后续在签名证书时会使用某个 profile;此实例只有一个 www 模板。

#expiry:指定了证书的有效期,87600h 为10年,如果用默认值一年的话,证书到期后集群会立即宕掉

#signing:表示该证书可用于签名其它证书;生成的 ca.pem 证书中 CA=TRUE;

#key encipherment:表示使用非对称密钥加密,如 RSA 加密;

#server auth:表示client可以用该 CA 对 server 提供的证书进行验证;

#client auth:表示server可以用该 CA 对 client 提供的证书进行验证;

#注意标点符号,最后一个字段一般是没有逗号的。

#-----------------------

#生成CA证书和私钥(根证书和私钥)

#特别说明: cfssl和openssl有一些区别,openssl需要先生成私钥,然后用私钥生成请求文件,最后生成签名的证书和私钥等,但是cfssl可以直接得到请求文件。

cat > ca-csr.json <<EOF

{

"CN": "etcd",

"key": {

"algo": "rsa",

"size": 2048

},

"names": [

{

"C": "CN",

"L": "Beijing",

"ST": "Beijing"

}

]

}

EOF

#CN:Common Name,浏览器使用该字段验证网站或机构是否合法,一般写的是域名

#key:指定了加密算法,一般使用rsa(size:2048)

#C:Country,国家

#ST:State,州,省

#L:Locality,地区,城市

#O: Organization Name,组织名称,公司名称

#OU: Organization Unit Name,组织单位名称,公司部门

cfssl gencert -initca ca-csr.json | cfssljson -bare ca

#生成的文件:

#ca-key.pem:根证书私钥

#ca.pem:根证书

#ca.csr:根证书签发请求文件

#cfssl gencert -initca <CSRJSON>:使用 CSRJSON 文件生成生成新的证书和私钥。如果不添加管道符号,会直接把所有证书内容输出到屏幕。

#注意:CSRJSON 文件用的是相对路径,所以 cfssl 的时候需要 csr 文件的路径下执行,也可以指定为绝对路径。

#cfssljson 将 cfssl 生成的证书(json格式)变为文件承载式证书,-bare 用于命名生成的证书文件。

#-----------------------

#生成 etcd 服务器证书和私钥

cat > server-csr.json <<EOF

{

"CN": "etcd",

"hosts": [

"192.168.116.10",

"192.168.116.30",

"192.168.116.40"

],

"key": {

"algo": "rsa",

"size": 2048

},

"names": [

{

"C": "CN",

"L": "BeiJing",

"ST": "BeiJing"

}

]

}

EOF

#hosts:将所有 etcd 集群节点添加到 host 列表,需要指定所有 etcd 集群的节点 ip 或主机名不能使用网段,新增 etcd 服务器需要重新签发证书。

cfssl gencert -ca=ca.pem -ca-key=ca-key.pem -config=ca-config.json -profile=www server-csr.json | cfssljson -bare server

#生成的文件:

#server.csr:服务器的证书请求文件

#server-key.pem:服务器的私钥

#server.pem:服务器的数字签名证书

#-config:引用证书生成策略文件 ca-config.json

#-profile:指定证书生成策略文件中的的使用场景,比如 ca-config.json 中的 www

#编写完后给上执行权限并执行

chmod +x etcd-cert.sh

./etcd-cert.sh

编写etcd服务脚本,添加集群配置

vim /opt/k8s/etcd.sh

#!/bin/bash

#example: ./etcd.sh etcd01 192.168.80.10 etcd02=https://192.168.80.11:2380,etcd03=https://192.168.80.12:2380

#创建etcd配置文件/opt/etcd/cfg/etcd

ETCD_NAME=$1

ETCD_IP=$2

ETCD_CLUSTER=$3

WORK_DIR=/opt/etcd

cat > $WORK_DIR/cfg/etcd <<EOF

#[Member]

ETCD_NAME="${ETCD_NAME}"

ETCD_DATA_DIR="/var/lib/etcd/default.etcd"

ETCD_LISTEN_PEER_URLS="https://${ETCD_IP}:2380"

ETCD_LISTEN_CLIENT_URLS="https://${ETCD_IP}:2379"

#[Clustering]

ETCD_INITIAL_ADVERTISE_PEER_URLS="https://${ETCD_IP}:2380"

ETCD_ADVERTISE_CLIENT_URLS="https://${ETCD_IP}:2379"

ETCD_INITIAL_CLUSTER="etcd01=https://${ETCD_IP}:2380,${ETCD_CLUSTER}"

ETCD_INITIAL_CLUSTER_TOKEN="etcd-cluster"

ETCD_INITIAL_CLUSTER_STATE="new"

EOF

#Member:成员配置

#ETCD_NAME:节点名称,集群中唯一。成员名字,集群中必须具备唯一性,如etcd01

#ETCD_DATA_DIR:数据目录。指定节点的数据存储目录,这些数据包括节点ID,集群ID,集群初始化配置,Snapshot文件,若未指定-wal-dir,还会存储WAL文件;如果不指定会用缺省目录

#ETCD_LISTEN_PEER_URLS:集群通信监听地址。用于监听其他member发送信息的地址。ip为全0代表监听本机所有接口

#ETCD_LISTEN_CLIENT_URLS:客户端访问监听地址。用于监听etcd客户发送信息的地址。ip为全0代表监听本机所有接口

#Clustering:集群配置

#ETCD_INITIAL_ADVERTISE_PEER_URLS:集群通告地址。其他member使用,其他member通过该地址与本member交互信息。一定要保证从其他member能可访问该地址。静态配置方式下,该参数的value一定要同时在--initial-cluster参数中存在

#ETCD_ADVERTISE_CLIENT_URLS:客户端通告地址。etcd客户端使用,客户端通过该地址与本member交互信息。一定要保证从客户侧能可访问该地址

#ETCD_INITIAL_CLUSTER:集群节点地址。本member使用。描述集群中所有节点的信息,本member根据此信息去联系其他member

#ETCD_INITIAL_CLUSTER_TOKEN:集群Token。用于区分不同集群。本地如有多个集群要设为不同

#ETCD_INITIAL_CLUSTER_STATE:加入集群的当前状态,new是新集群,existing表示加入已有集群。

#创建etcd.service服务管理文件

cat > /usr/lib/systemd/system/etcd.service <<EOF

[Unit]

Description=Etcd Server

After=network.target

After=network-online.target

Wants=network-online.target

[Service]

Type=notify

EnvironmentFile=${WORK_DIR}/cfg/etcd

ExecStart=${WORK_DIR}/bin/etcd \

--cert-file=${WORK_DIR}/ssl/server.pem \

--key-file=${WORK_DIR}/ssl/server-key.pem \

--trusted-ca-file=${WORK_DIR}/ssl/ca.pem \

--peer-cert-file=${WORK_DIR}/ssl/server.pem \

--peer-key-file=${WORK_DIR}/ssl/server-key.pem \

--peer-trusted-ca-file=${WORK_DIR}/ssl/ca.pem \

--logger=zap \

--enable-v2

Restart=on-failure

LimitNOFILE=65536

[Install]

WantedBy=multi-user.target

EOF

#--enable-v2:开启 etcd v2 API 接口。当前 flannel 版本不支持 etcd v3 通信

#--logger=zap:使用 zap 日志框架。zap.Logger 是go语言中相对日志库中性能最高的

#--peer开头的配置项用于指定集群内部TLS相关证书(peer 证书),这里全部都使用同一套证书认证

#不带--peer开头的的参数是指定 etcd 服务器TLS相关证书(server 证书),这里全部都使用同一套证书认证

systemctl daemon-reload

systemctl enable etcd

systemctl restart etcd

#编写完后给上执行权限,在下一步需要执行

chmod +x /opt/k8s/etcd.sh安装etcd服务,并启动集群

#上传 etcd-v3.4.9-linux-amd64.tar.gz 到 /opt/k8s 目录中,并尝试启动服务

cd /opt/k8s/

tar zxvf etcd-v3.4.9-linux-amd64.tar.gz

mkdir -p /opt/etcd/{cfg,bin,ssl}

#etcdctl管理文件,etcd服务文件

cd /opt/k8s/etcd-v3.4.9-linux-amd64/

mv etcd etcdctl /opt/etcd/bin/

cp /opt/k8s/etcd-cert/*.pem /opt/etcd/ssl/

#此脚本可以启动本地etcd服务,添加集群配置(第一次启动会卡住,是因为需要其他节点etcd服务加入)

cd /opt/k8s/

./etcd.sh etcd01 192.168.116.10 etcd02=https://192.168.116.30:2380,etcd03=https://192.168.116.40:2380

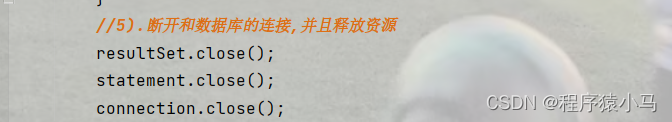

#复制服务脚本到其他etcd节点,并修改配置(见下图)

scp -r /opt/etcd/ root@192.168.116.30:/opt/

scp -r /opt/etcd/ root@192.168.116.40:/opt/

scp /usr/lib/systemd/system/etcd.service root@192.168.116.30:/usr/lib/systemd/system/

scp /usr/lib/systemd/system/etcd.service root@192.168.116.40:/usr/lib/systemd/system/

#修改完后分别启动服务

systemctl start etcd

#然后在主etcd节点再次执行

cd /opt/k8s/

./etcd.sh etcd01 192.168.116.10 etcd02=https://192.168.116.30:2380,etcd03=https://192.168.116.40:2380

执行完后可以使用以下命令查看etcd集群状态(全为true则集群无误)

#使用 health 是查看健康状态;使用 status 是查看所有状态信息

ETCDCTL_API=3 /opt/etcd/bin/etcdctl --cacert=/opt/etcd/ssl/ca.pem --cert=/opt/etcd/ssl/server.pem --key=/opt/etcd/ssl/server-key.pem --endpoints="https://192.168.116.10:2379,https://192.168.116.30:2379,https://192.168.116.40:2379" --write-out=table endpoint health

--cert:识别HTTPS端使用SSL证书文件

--cacert:使用此CA证书验证启用https的服务器的证书

--key:使用此SSL密钥文件标识HTTPS客户端

--endpoints:集群中以逗号分隔的机器地址列表cluster-health: 检查etcd集群的运行状况

--write-out=table 或 -wtable:以表格形式输出

查看etcd集群成员信息

ETCDCTL_API=3 /opt/etcd/bin/etcdctl --cacert=/opt/etcd/ssl/ca.pem --cert=/opt/etcd/ssl/server.pem --key=/opt/etcd/ssl/server-key.pem --endpoints="https://192.168.116.10:2379,https://192.168.116.30:2379,https://192.168.116.40:2379" --write-out=table member list

补充 etcd 备份和还原方式

注:备份时 endpoint 只需要指定etcd中的一个节点

备份

ETCDCTL_API=3 /opt/etcd/bin/etcdctl --cacert=/opt/etcd/ssl/ca.pem --cert=/opt/etcd/ssl/server.pem --key=/opt/etcd/ssl/server-key.pem --endpoints="https://192.168.116.10:2379" snapshot save 备份文件路径

查看

ETCDCTL_API=3 /opt/etcd/bin/etcdctl --cacert=/opt/etcd/ssl/ca.pem --cert=/opt/etcd/ssl/server.pem --key=/opt/etcd/ssl/server-key.pem --endpoints="https://192.168.116.10:2379" snapshot status 备份文件路径 -wtable

恢复

ETCDCTL_API=3 /opt/etcd/bin/etcdctl --cacert=/opt/etcd/ssl/ca.pem --cert=/opt/etcd/ssl/server.pem --key=/opt/etcd/ssl/server-key.pem --endpoints="https://192.168.116.10:2379" snapshot restore 备份文件路径

3.部署docker引擎

所有 node 节点部署docker引擎

yum install -y yum-utils device-mapper-persistent-data lvm2

yum-config-manager --add-repo https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

yum install -y docker-ce docker-ce-cli containerd.io

systemctl start docker.service

systemctl enable docker.service 4.部署 Master 组件

编写master各组件认证的脚本

mkdir /opt/k8s/k8s-cert

vim k8s-cert.sh

#!/bin/bash

#配置证书生成策略,让 CA 软件知道颁发有什么功能的证书,生成用来签发其他组件证书的根证书

cat > ca-config.json <<EOF

{

"signing": {

"default": {

"expiry": "87600h"

},

"profiles": {

"kubernetes": {

"expiry": "87600h",

"usages": [

"signing",

"key encipherment",

"server auth",

"client auth"

]

}

}

}

}

EOF

#生成CA证书和私钥(根证书和私钥)

cat > ca-csr.json <<EOF

{

"CN": "kubernetes",

"key": {

"algo": "rsa",

"size": 2048

},

"names": [

{

"C": "CN",

"L": "Beijing",

"ST": "Beijing",

"O": "k8s",

"OU": "System"

}

]

}

EOF

cfssl gencert -initca ca-csr.json | cfssljson -bare ca -

#-----------------------

#生成 apiserver 的证书和私钥(apiserver和其它k8s组件通信使用)

#hosts中将所有可能作为 apiserver 的 ip 添加进去,后面 keepalived 使用的 VIP 也要加入

cat > apiserver-csr.json <<EOF

{

"CN": "kubernetes",

"hosts": [

"10.0.0.1",

"127.0.0.1",

"192.168.116.10",

"192.168.116.20",

"192.168.116.100",

"192.168.116.50",

"192.168.116.60",

"kubernetes",

"kubernetes.default",

"kubernetes.default.svc",

"kubernetes.default.svc.cluster",

"kubernetes.default.svc.cluster.local"

],

"key": {

"algo": "rsa",

"size": 2048

},

"names": [

{

"C": "CN",

"L": "BeiJing",

"ST": "BeiJing",

"O": "k8s",

"OU": "System"

}

]

}

EOF

cfssl gencert -ca=ca.pem -ca-key=ca-key.pem -config=ca-config.json -profile=kubernetes apiserver-csr.json | cfssljson -bare apiserver

#-----------------------

#生成 kubectl 连接集群的证书和私钥,具有admin权限

cat > admin-csr.json <<EOF

{

"CN": "admin",

"hosts": [],

"key": {

"algo": "rsa",

"size": 2048

},

"names": [

{

"C": "CN",

"L": "BeiJing",

"ST": "BeiJing",

"O": "system:masters",

"OU": "System"

}

]

}

EOF

cfssl gencert -ca=ca.pem -ca-key=ca-key.pem -config=ca-config.json -profile=kubernetes admin-csr.json | cfssljson -bare admin

#-----------------------

#生成 kube-proxy 的证书和私钥

cat > kube-proxy-csr.json <<EOF

{

"CN": "system:kube-proxy",

"hosts": [],

"key": {

"algo": "rsa",

"size": 2048

},

"names": [

{

"C": "CN",

"L": "BeiJing",

"ST": "BeiJing",

"O": "k8s",

"OU": "System"

}

]

}

EOF

cfssl gencert -ca=ca.pem -ca-key=ca-key.pem -config=ca-config.json -profile=kubernetes kube-proxy-csr.json | cfssljson -bare kube-proxy

#给上执行权限并执行

chmod +x k8s-cert.sh

./k8s-cert.sh

#再将所需证书存放到/opt/kubernetes/ssl/

cp ca*pem apiserver*pem /opt/kubernetes/ssl/

安装k8s服务,准备master需要的工具

#上传 kubernetes-server-linux-amd64.tar.gz 到 /opt/k8s/ 目录中,解压 kubernetes 压缩包

cd /opt/k8s/

tar zxvf kubernetes-server-linux-amd64.tar.gz

#将master的组件和命令工具存放到/opt/kubernetes/bin/,做软连接能被系统识别

cd /opt/k8s/kubernetes/server/bin

cp kube-apiserver kubectl kube-controller-manager kube-scheduler /opt/kubernetes/bin/

ln -s /opt/kubernetes/bin/* /usr/local/bin/

#上传master.zip到/opt/k8s目录并解压

cd /opt/k8s/

unzip master.zip -d master/

cd master/

chmod +x *.sh

创建 bootstrap token 认证文件,apiserver 启动时会调用,然后就相当于在集群内创建了一个这个用户,接下来就可以用 RBAC 给他授权

#创建 bootstrap token 认证文件,apiserver 启动时会调用,然后就相当于在集群内创建了一个这个用户,接下来就可以用 RBAC 给他授权

cd /opt/kubernetes

vim token.sh

#!/bin/bash

#获取随机数前16个字节内容,以十六进制格式输出,并删除其中空格

BOOTSTRAP_TOKEN=$(head -c 16 /dev/urandom | od -An -t x | tr -d ' ')

#生成 token.csv 文件,按照 Token序列号,用户名,UID,用户组 的格式生成

cat > /opt/kubernetes/cfg/token.csv <<EOF

${BOOTSTRAP_TOKEN},kubelet-bootstrap,10001,"system:kubelet-bootstrap"

EOF

#执行

chmod +x token.sh

./token.sh

#执行apiserver脚本 后面跟master的ip 和 etcd集群的ip

./apiserver.sh 192.168.116.10 https://192.168.116.10:2379,https://192.168.116.30:2379,https://192.168.116.40:2379

#再执行另外三个脚本

./controller-manager.sh

./scheduler.sh

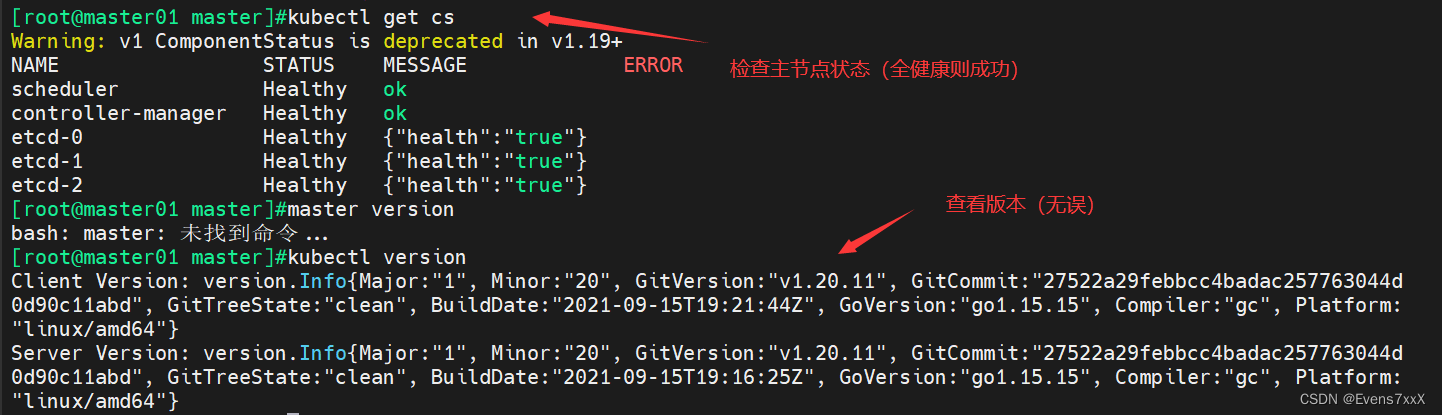

./admin检查master组件和etcd集群状态

5.部署 Worker Node 组件

在所有 node 节点上操作

#创建kubernetes工作目录

mkdir -p /opt/kubernetes/{bin,cfg,ssl,logs}

#上传 node.zip 到 /opt 目录中,解压 node.zip 压缩包,获得kubelet.sh、proxy.sh

cd /opt/

unzip node.zip

chmod +x kubelet.sh proxy.sh

在 master01 节点上操作

#把 kubelet、kube-proxy 拷贝到 node 节点

cd /opt/k8s/kubernetes/server/bin

scp kubelet kube-proxy root@192.168.116.30:/opt/kubernetes/bin/

scp kubelet kube-proxy root@192.168.116.40:/opt/kubernetes/bin/

#上传 kubeconfig.sh 文件到 /opt/k8s/kubeconfig 目录中,生成 kubeconfig 的配置文件

mkdir /opt/k8s/kubeconfig

cd /opt/k8s/kubeconfig

chmod +x kubeconfig.sh

./kubeconfig.sh 192.168.116.10 /opt/k8s/k8s-cert/

scp bootstrap.kubeconfig kube-proxy.kubeconfig root@192.168.116.30:/opt/kubernetes/cfg/

scp bootstrap.kubeconfig kube-proxy.kubeconfig root@192.168.116.40:/opt/kubernetes/cfg/

#RBAC授权,使用户 kubelet-bootstrap 能够有权限发起 CSR 请求

kubectl create clusterrolebinding kubelet-bootstrap --clusterrole=system:node-bootstrapper --user=kubelet-bootstrap

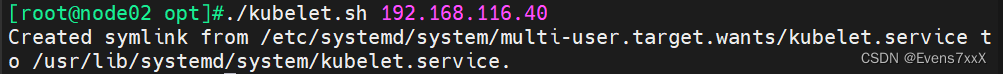

在两个 node 节点上操作

#启动 kubelet 服务

cd /opt/

./kubelet.sh 192.168.116.30

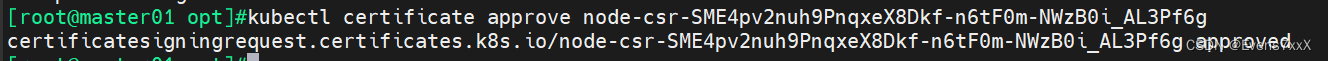

在 master01 节点上操作,通过 CSR 请求

#检查到 node01 节点的 kubelet 发起的 CSR 请求,Pending表示等待集群给该节点签发证书

kubectl get csr

kubectl certificate approve 请求名 #通过 CSR 请求

#查看节点,由于网络插件还没有部署,节点会没有准备就绪 NotReady

kubectl get node

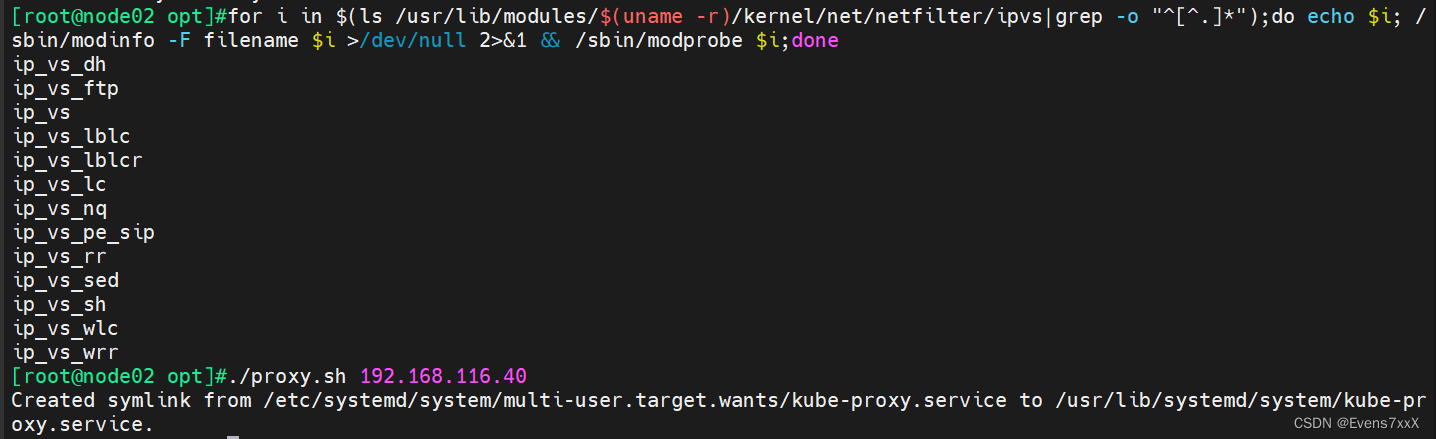

在两个 node 节点上操作

#加载 ip_vs 模块

for i in $(ls /usr/lib/modules/$(uname -r)/kernel/net/netfilter/ipvs|grep -o "^[^.]*");do echo $i; /sbin/modinfo -F filename $i >/dev/null 2>&1 && /sbin/modprobe $i;done

#启动proxy服务

cd /opt/

./proxy.sh 192.168.116.30

6.部署网络组件(使用 flannel)

在 node01 节点上操作

#上传 cni-plugins-linux-amd64-v0.8.6.tgz 和 flannel.tar 到 /opt 目录中

cd /opt/

docker load -i flannel.tar

mkdir /opt/cni/bin

tar zxvf cni-plugins-linux-amd64-v0.8.6.tgz -C /opt/cni/bin

在 master01 节点上操作

#上传 kube-flannel.yml 文件到 /opt/k8s 目录中,部署 CNI 网络

cd /opt/k8s

kubectl apply -f kube-flannel.yml kubectl get pods -n kube-system #查看pods指定命名空间

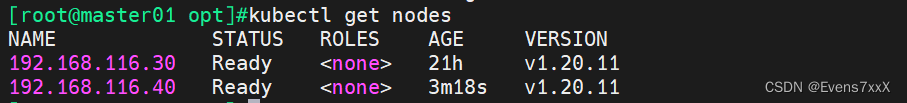

kubectl get nodes #查看节点状态(Ready即成功)

![[附源码]计算机毕业设计健身生活系统论文Springboot程序](https://img-blog.csdnimg.cn/cfdc84b9b4bd416a8c0bd20f1cf05e70.png)