-

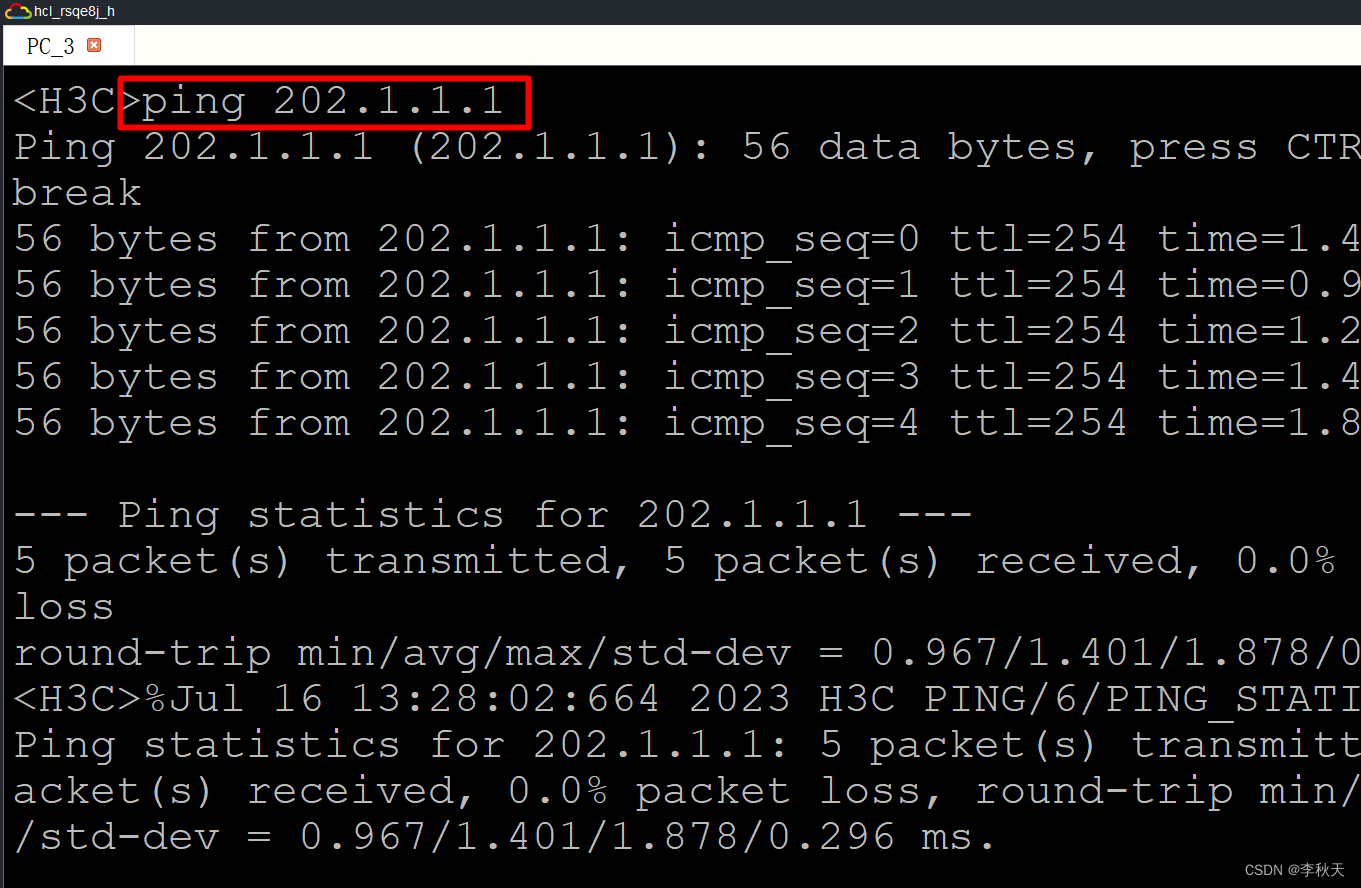

这是2022年TIP期刊的一篇有监督暗图增强的文章

-

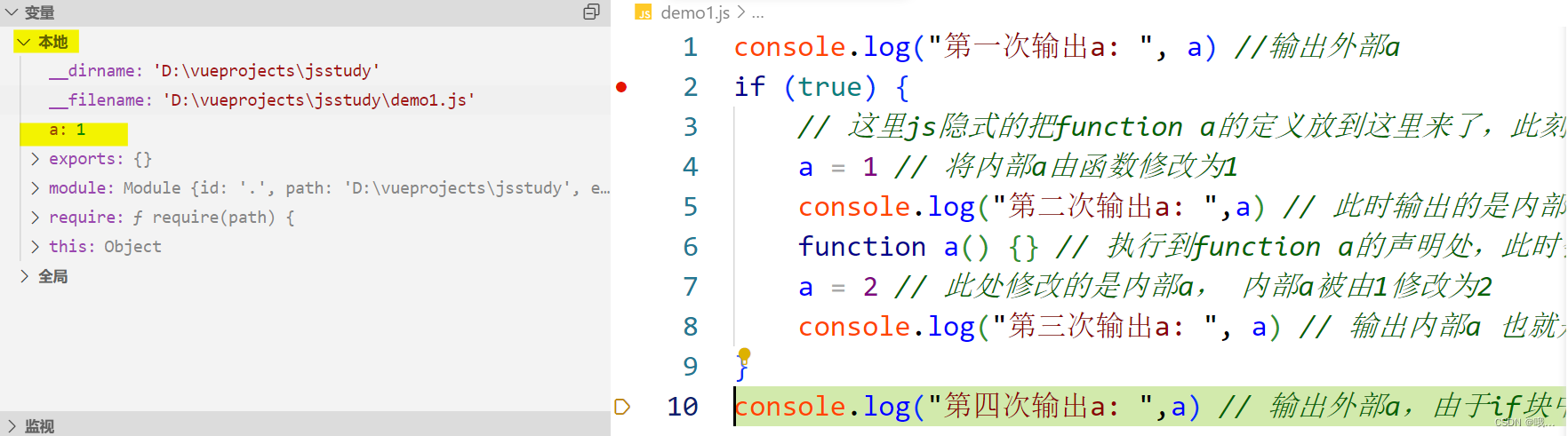

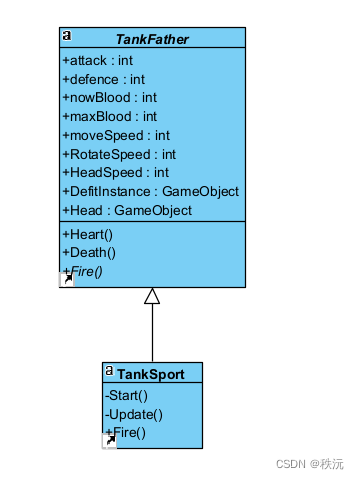

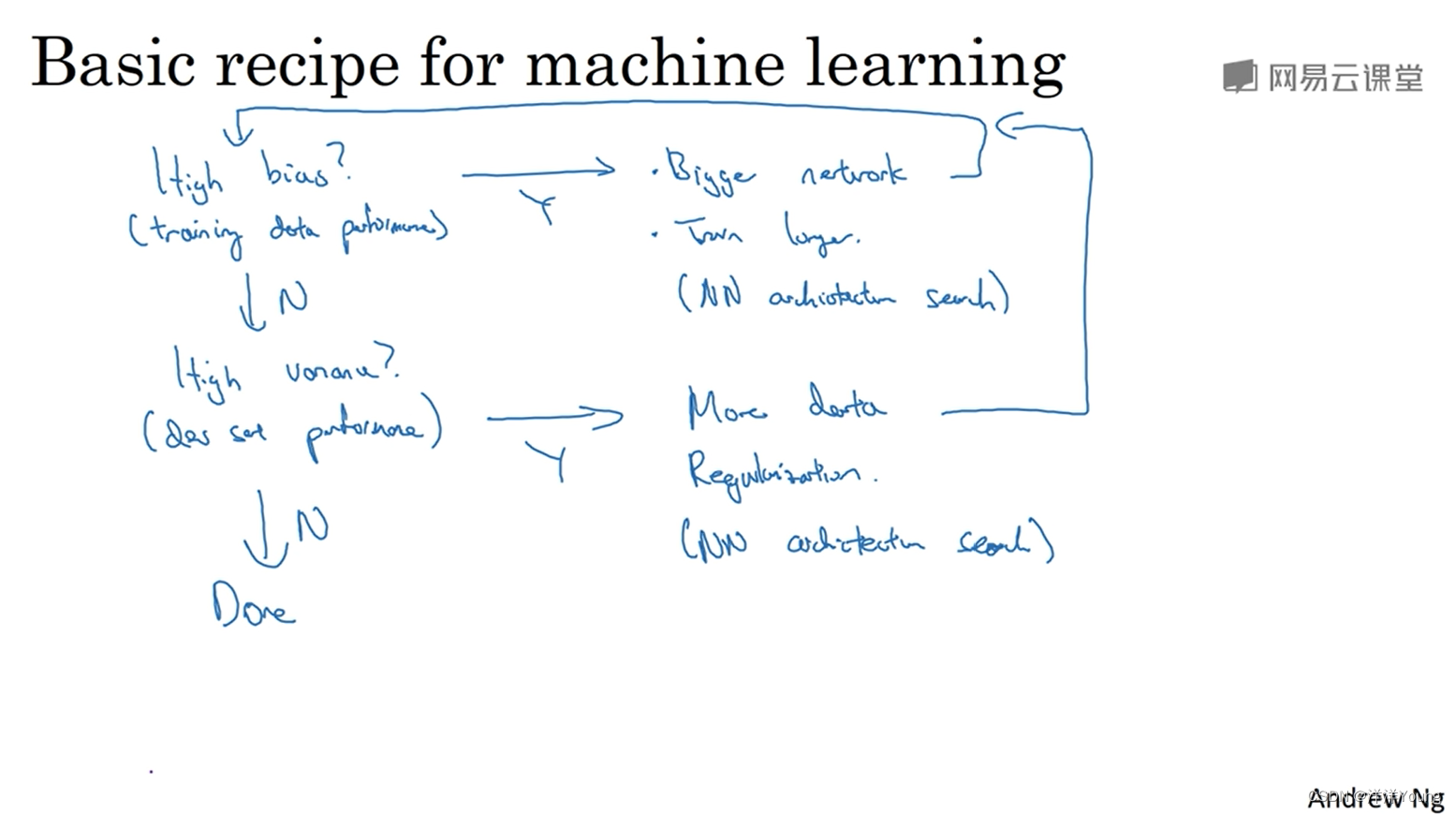

网络结构如图所示:

-

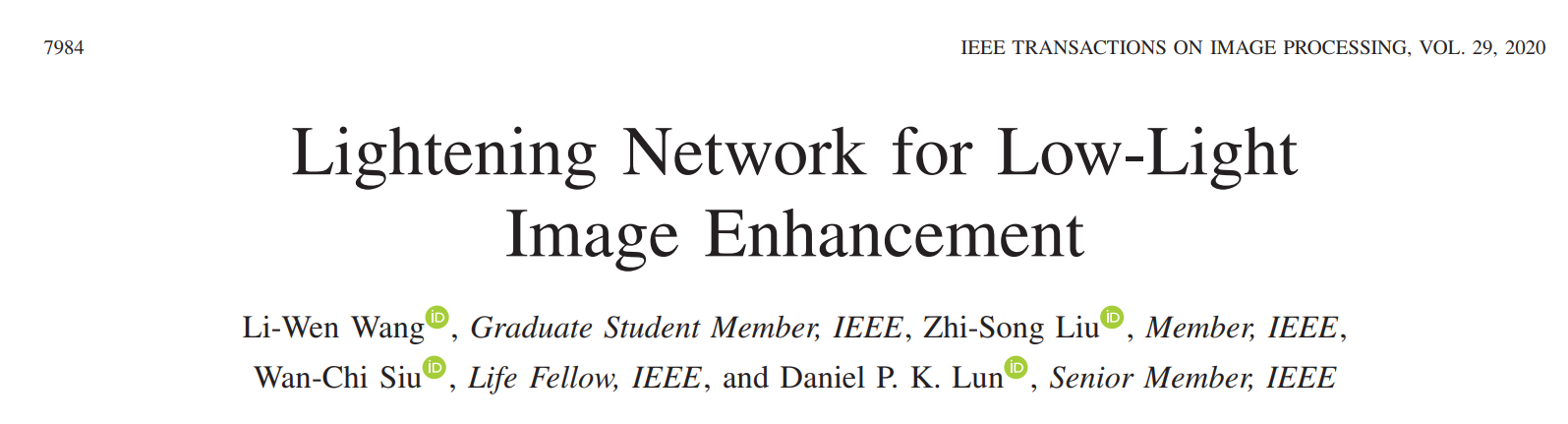

LBP的网络结构如下:

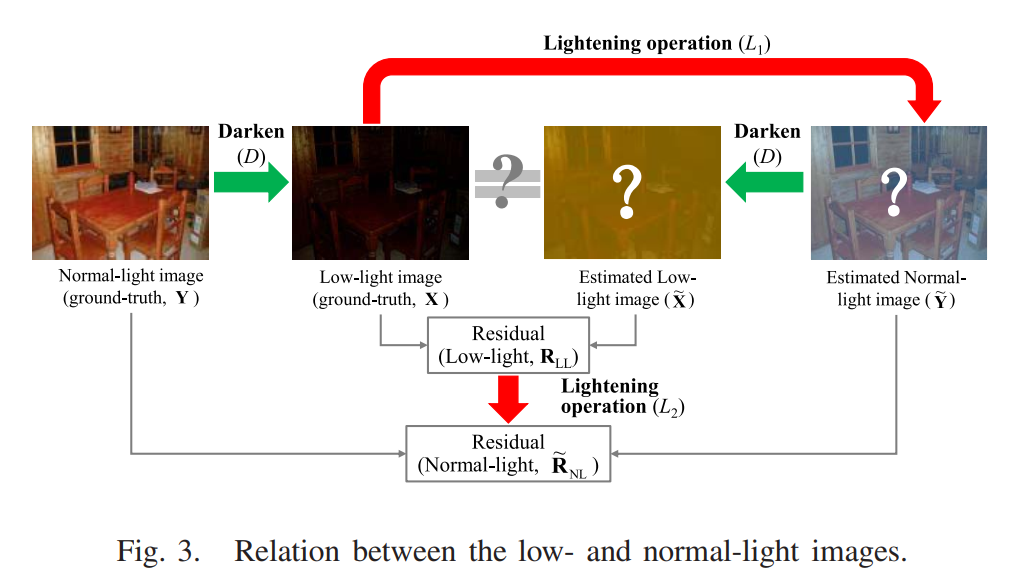

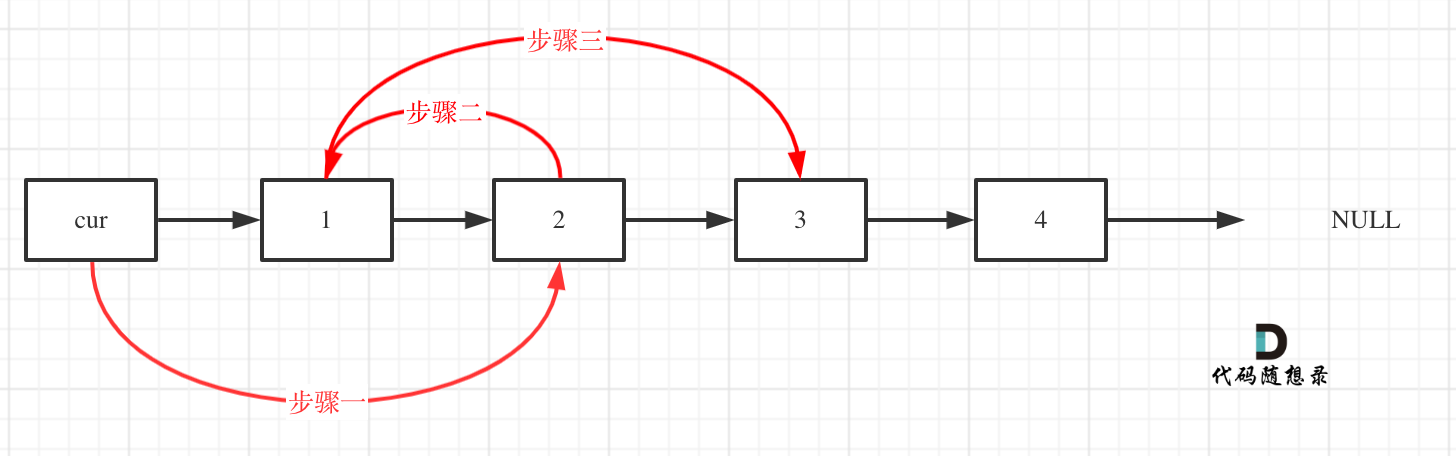

有点绕,其基于的理论如下。就是说,普通的暗图增强就只是走下图的L1红箭头,从暗图估计一个亮图。但是其实这个亮图和真实的亮图还是有一些差距,怎么弥补呢,可以再进一步学习一个 R L L R_{LL} RLL到 R N L R_{NL} RNL的映射,从而把预测出来的这部分残差加到一开始预测的亮图上,可以使得最终的增强结果更加接近亮图。

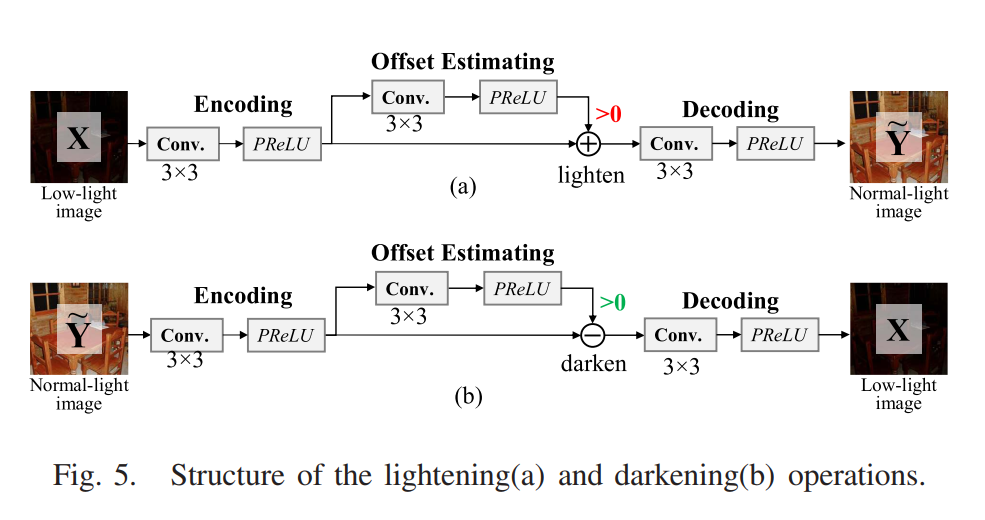

这里的 L 1 L_1 L1, L 2 L_2 L2,和 D D D如下图所示

-

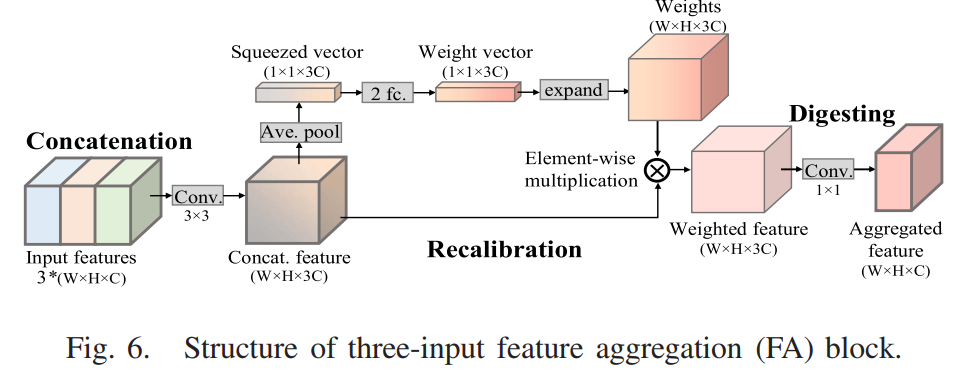

FA 模块则如下图所示,就是一个通道注意力模块:

-

损失函数是增强结果的TV loss和SSIM loss的和

-

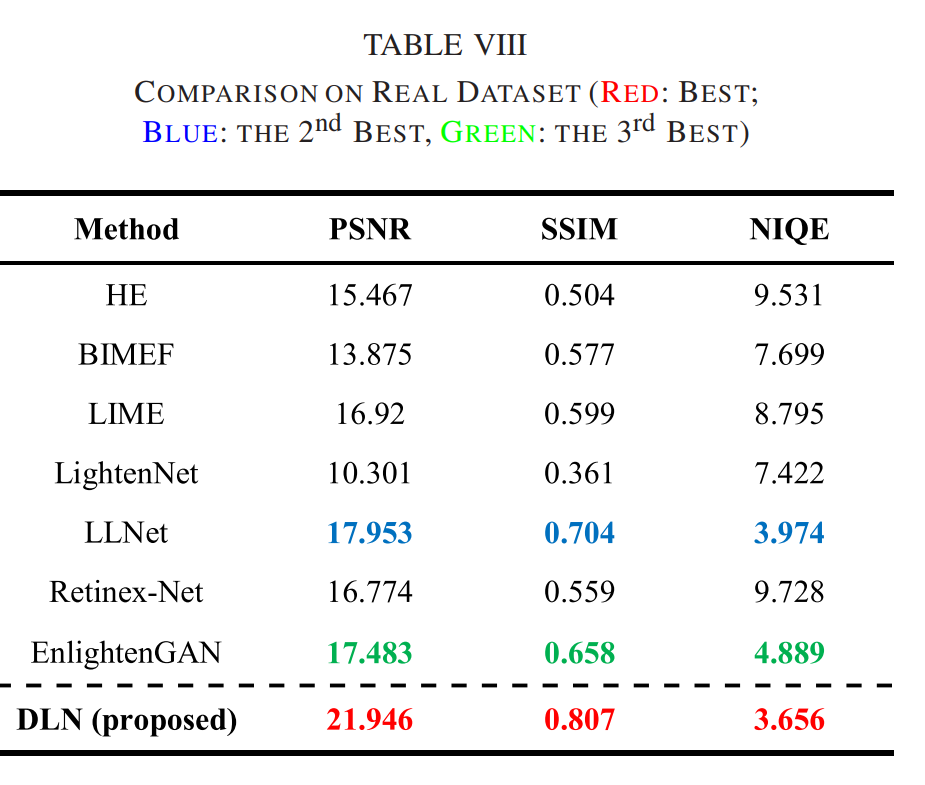

LOL数据集上的实验结果,看起来还不错:

-

启发是,back porjection和残差学习的作用还是挺大的,同时,网络是iteratively地增强的,也就是说中间出现了很多3通道的增强结果,这一点相比其他网络中间只是特征来说,更有可解释性。

![[Linux笔记]常见命令(持续施工)](https://img-blog.csdnimg.cn/880deb62f4704ccba141f5827eef335e.png)