深度学习训练营之调用Gensim来训练Word2Vec模型

- 原文链接

- 环境介绍

- 前置工作

- 下载Gensim库

- 对于原始语料进行分词

- 添加停用词

- 模型训练

- 模型介绍

- 模型正式训练

- 计算词频

原文链接

- 🍨 本文为🔗365天深度学习训练营 中的学习记录博客

- 🍦 参考文章:365天深度学习训练营-第N3周:调用Gensim来训练Word2Vec模型

- 🍖 原作者:K同学啊|接辅导、项目定制

环境介绍

- 语言环境:Python3.9.12

- 编译器:jupyter notebook

- 深度学习环境:TensorFlow2

前置工作

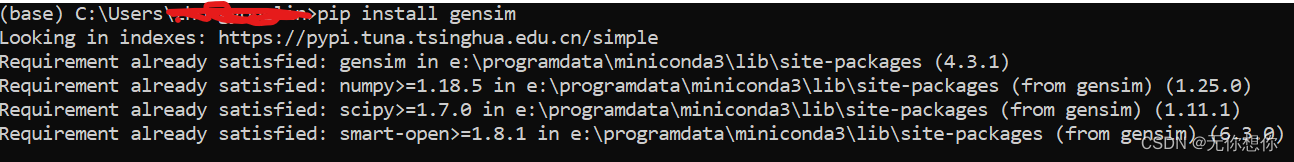

下载Gensim库

pip install gensim

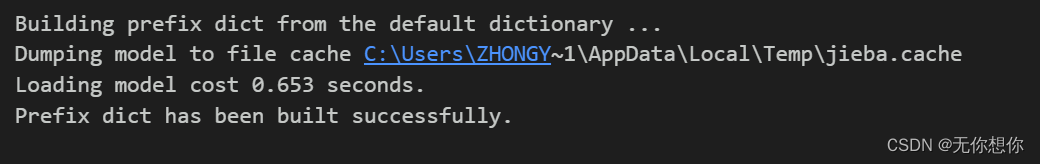

对于原始语料进行分词

import jieba

import jieba.analyse

# 加入一些词(人名),使得jieba分词准确率更高

jieba.suggest_freq('沙瑞金', True)

jieba.suggest_freq('田国富', True)

jieba.suggest_freq('高育良', True)

jieba.suggest_freq('侯亮平', True)

jieba.suggest_freq('钟小艾', True)

jieba.suggest_freq('陈岩石', True)

jieba.suggest_freq('欧阳菁', True)

jieba.suggest_freq('易学习', True)

jieba.suggest_freq('王大路', True)

jieba.suggest_freq('蔡成功', True)

jieba.suggest_freq('孙连城', True)

jieba.suggest_freq('季昌明', True)

jieba.suggest_freq('丁义珍', True)

jieba.suggest_freq('郑西坡', True)

jieba.suggest_freq('赵东来', True)

jieba.suggest_freq('高小琴', True)

jieba.suggest_freq('赵瑞龙', True)

jieba.suggest_freq('林华华', True)

jieba.suggest_freq('陆亦可', True)

jieba.suggest_freq('刘新建', True)

jieba.suggest_freq('刘庆祝', True)

jieba.suggest_freq('赵德汉', True)

with open('in_the_name_of_people.txt') as f:

result_cut=[]

lines=f.readlines()

for line in lines:

result_cut.append(list(jieba.cut(line)))

f.close()

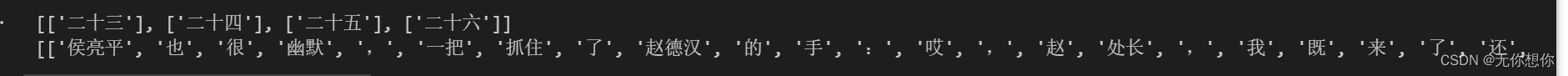

添加停用词

避免标点符号等内容作为训练样本当中的内容,从而降低模型出错的概率

#添加自定义的停用词

stopwords_list=[",","。","\n","\u3000"," ",":","!","?","..."]

#这里的停用词比如像!和?不是很理解,是否会影响语义分析的结果出现错误,因为像这样的问题应该会忽略语义的情感分析

#对于word2vec选择上下文,所以要尽可能省去标点符号

def remove_stopwords(ls):

return [word for word in ls if word not in stopwords_list]

#在实际应用当中可以通过调参提高词的embedding效果

#embedding:离散数据转向连续型数据的过程

result_stop=[remove_stopwords(x)for x in result_cut if remove_stopwords(x)]

print(result_stop[50:54])

print(result_stop[100:103])

模型训练

模型介绍

Word2Vec其所表达的意思就是 Word to Vector ,也就是相当于通过一个句子当中的单词去构建向量,在选择一个关键词之后,在该关键词所在的句子的前后选择Window(设置的选取的单词的个数)个单词作为训练样本,通过Word2Vec捕获单词之间的相似性和类比关系

模型正式训练

进行Word2vec模型的训练

from gensim.models import Word2Vec

model=Word2Vec(result_stop,

vector_size=100,#特征向量的维度

window=5,#一个句子中当前单词与被预测单词之间的距离

min_count=1,

compute_loss=True)

#计算余弦相似度

print(model.wv.similarity('沙瑞金','季昌明'))

print(model.wv.similarity('易学习','季昌明'))

0.99825275

0.99925613

for e in model.wv.most_similar(positive=['沙瑞金'],topn=5):

print(e[0],e[1])

print(type(e))

赵立春 0.9996154308319092

<class ‘tuple’>

欧阳菁 0.9995353817939758

<class ‘tuple’>

这位 0.9995108246803284

<class ‘tuple’>

情况 0.9994970560073853

<class ‘tuple’>

觉得 0.9994819760322571

<class ‘tuple’>

odd_word=model.wv.doesnt_match(["苹果","香蕉","橘子","梨","猫"])

print(f"在这组词汇当中不匹配的词汇:{odd_word}")

在这组词汇当中不匹配的词汇:猫

计算词频

word_frequency=model.wv.get_vecattr("沙瑞金","count")

print(f"沙瑞金:{word_frequency}")

print(type(model))

沙瑞金:353

<class ‘gensim.models.word2vec.Word2Vec’>