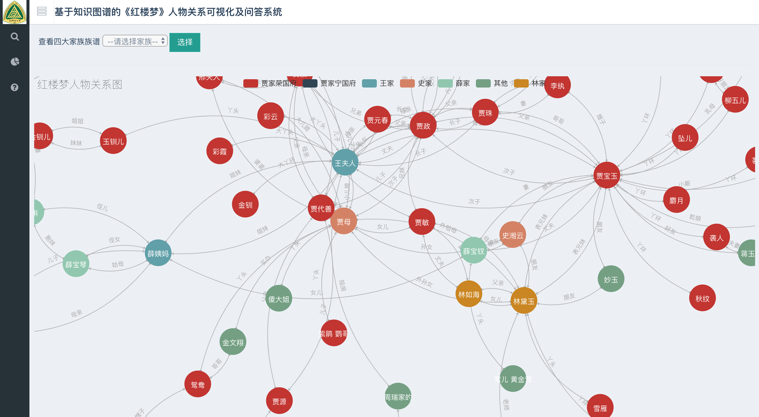

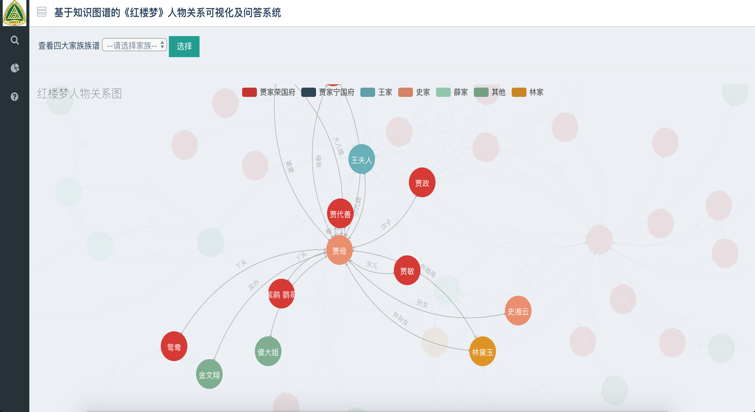

基于知识图谱的《红楼梦》人物关系可视化及问答系统(含码源):命名实体识别、关系识别、LTP简单教学

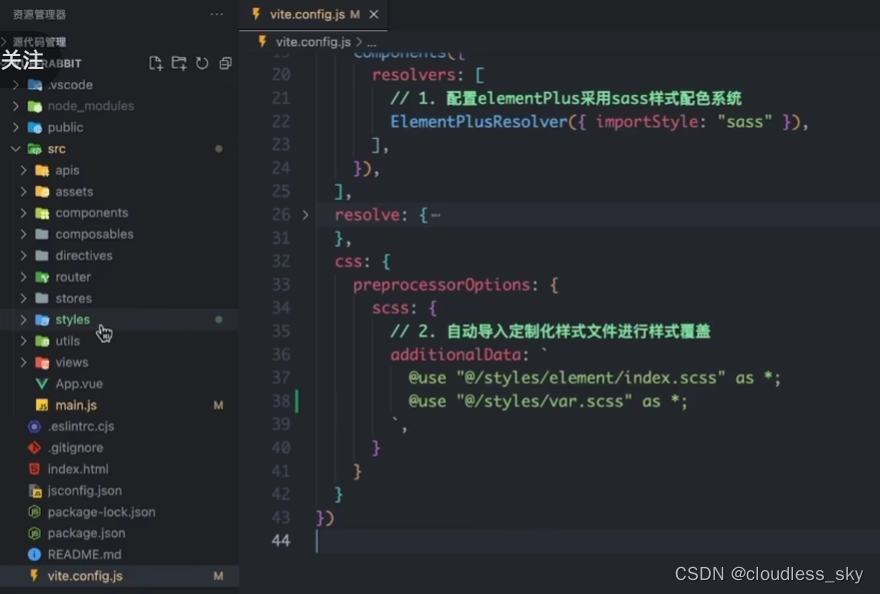

文件树:

- app.py是整个系统的主入口

- templates文件夹是HTML的页面

|-index.html 欢迎界面

|-search.html 搜索人物关系页面

|-all_relation.html 所有人物关系页面

|-KGQA.html 人物关系问答页面 - static文件夹存放css和js,是页面的样式和效果的文件

- raw_data文件夹是存在数据处理后的三元组文件

- neo_db文件夹是知识图谱构建模块

|-config.py 配置参数

|-create_graph.py 创建知识图谱,图数据库的建立

|-query_graph.py 知识图谱的查询 - KGQA文件夹是问答系统模块

|-ltp.py 分词、词性标注、命名实体识别 - spider文件夹是爬虫模块

|- get_*.py 是之前爬取人物资料的代码,已经产生好images和json 可以不用再执行

|-show_profile.py 是调用人物资料和图谱展示在前端的代码

部署步骤:

- 0.安装所需的库 执行pip install -r requirement.txt

- 1.先下载好neo4j图数据库,并配好环境(注意neo4j需要jdk8)。修改neo_db目录下的配置文件config.py,设置图数据库的账号和密码。

- 2.切换到neo_db目录下,执行python create_graph.py 建立知识图谱

- 3.去 这里 下载好ltp模型。ltp简介

- 4.在KGQA目录下,修改ltp.py里的ltp模型文件的存放目录

- 5.运行python app.py,浏览器打开localhost:5000即可查看

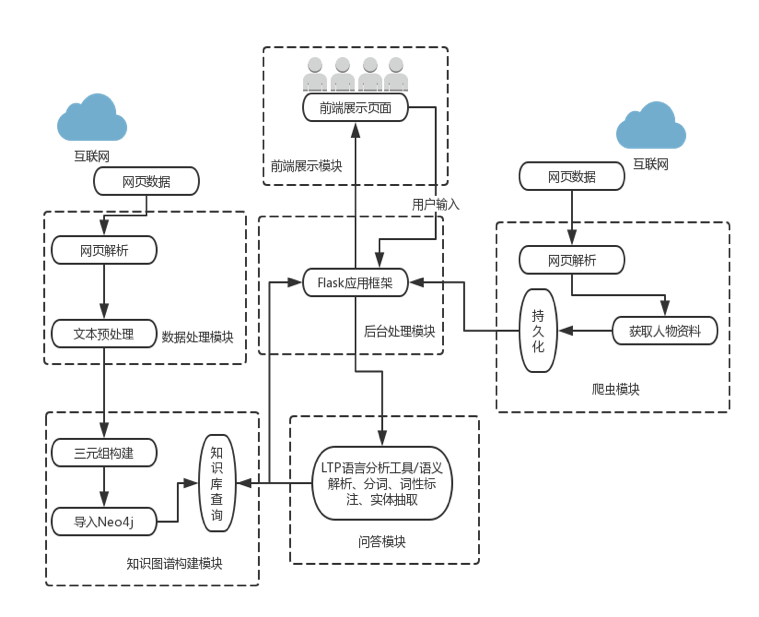

1.系统整体流程图:

项目码源见文章顶部或文末

https://download.csdn.net/download/sinat_39620217/87982770

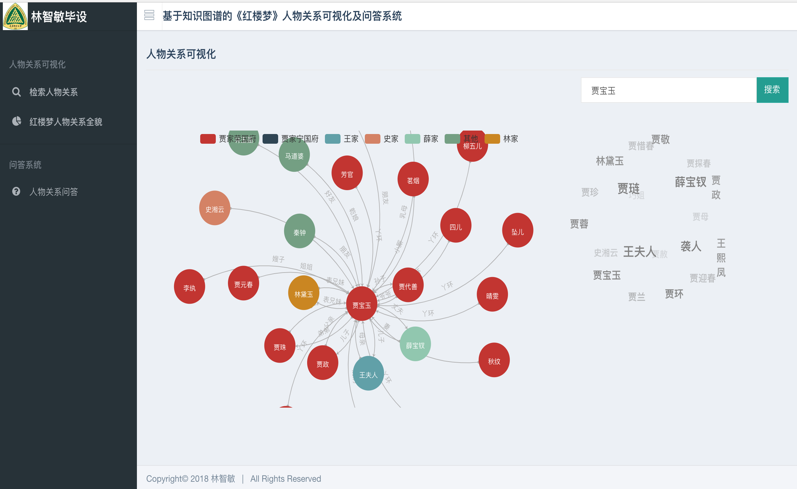

2.主界面-基于知识图谱的《红楼梦》人物关系可视化及问答系统

网站示例:

欢迎界面

3.KGQA部分码源展示

#-*- coding: utf-8 -*-

import pyltp

import os

LTP_DATA_DIR = '/Users/chizhu/data/ltp_data_v3.4.0' # ltp模型目录的路径

def cut_words(words):

segmentor = pyltp.Segmentor()

seg_model_path = os.path.join(LTP_DATA_DIR, 'cws.model')

segmentor.load(seg_model_path)

words = segmentor.segment(words)

array_str="|".join(words)

array=array_str.split("|")

segmentor.release()

return array

def words_mark(array):

# 词性标注模型路径,模型名称为`pos.model`

pos_model_path = os.path.join(LTP_DATA_DIR, 'pos.model')

postagger = pyltp.Postagger() # 初始化实例

postagger.load(pos_model_path) # 加载模型

postags = postagger.postag(array) # 词性标注

pos_str=' '.join(postags)

pos_array=pos_str.split(" ")

postagger.release() # 释放模型

return pos_array

def get_target_array(words):

target_pos=['nh','n']

target_array=[]

seg_array=cut_words(words)

pos_array = words_mark(seg_array)

for i in range(len(pos_array)):

if pos_array[i] in target_pos:

target_array.append(seg_array[i])

target_array.append(seg_array[1])

return target_array

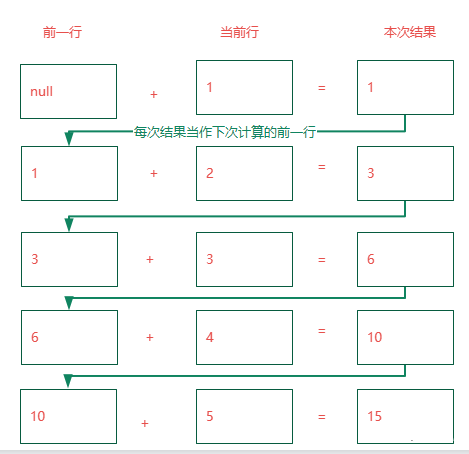

4.LTP简单教学

pyltp 是 LTP 的 Python 封装,提供了分词,词性标注,命名实体识别,依存句法分析,语义角色标注的功能。

关于各个模块任务的介绍、标注体系、性能指标,可以查阅 这里 的介绍。

pyltp 的所有输入的分析文本和输出的结果的编码均为 UTF-8。

如果您以非 UTF-8 编码的文本输入进行分析,结果可能为空。请注意源代码文件的默认编码。

由于 Windows 终端采用 GBK 编码显示,直接输出 pyltp 的分析结果会在终端显示为乱码。您可以将标准输出重定向到文件,以 UTF8 方式查看文件,就可以解决显示乱码的问题。

4.1分句

使用 pyltp 进行分句示例如下

#-*- coding: utf-8 -*-

from pyltp import SentenceSplitter

sents = SentenceSplitter.split('元芳你怎么看?我就趴窗口上看呗!') # 分句

print '\n'.join(sents)

结果如下

4.2分词

#-*- coding: utf-8 -*-

import os

LTP_DATA_DIR = '/path/to/your/ltp_data' # ltp模型目录的路径

cws_model_path = os.path.join(LTP_DATA_DIR, 'cws.model') # 分词模型路径,模型名称为`cws.model`

from pyltp import Segmentor

segmentor = Segmentor() # 初始化实例

segmentor.load(cws_model_path) # 加载模型

words = segmentor.segment('元芳你怎么看') # 分词

print '\t'.join(words)

segmentor.release() # 释放模型

结果如下

words = segmentor.segment('元芳你怎么看') 的返回值类型是 native 的 VectorOfString 类型,可以使用 list 转换成 Python 的列表类型,例如

...

>>> words = segmentor.segment('元芳你怎么看')

>>> type(words)

<class 'pyltp.VectorOfString'>

>>> words_list = list(words)

>>> type(words_list)

<type 'list'>

>>> print words_list

['\xe5\xae\xa2\xe6\x9c\x8d', '\xe5\xa4\xaa', '\xe7\xb3\x9f\xe7\xb3\x95', '\xe4\xba\x86']

4.2.1使用分词外部词典

pyltp 分词支持用户使用自定义词典。分词外部词典本身是一个文本文件(plain text),每行指定一个词,编码同样须为 UTF-8,样例如下所示

示例如下

#-*- coding: utf-8 -*-

import os

LTP_DATA_DIR = '/path/to/your/ltp_data' # ltp模型目录的路径

cws_model_path = os.path.join(LTP_DATA_DIR, 'cws.model') # 分词模型路径,模型名称为`cws.model`

from pyltp import Segmentor

segmentor = Segmentor() # 初始化实例

segmentor.load_with_lexicon(cws_model_path, '/path/to/your/lexicon') # 加载模型,第二个参数是您的外部词典文件路径

words = segmentor.segment('亚硝酸盐是一种化学物质')

print '\t'.join(words)

segmentor.release()

4.2.2使用个性化分词模型

个性化分词是 LTP 的特色功能。个性化分词为了解决测试数据切换到如小说、财经等不同于新闻领域的领域。 在切换到新领域时,用户只需要标注少量数据。 个性化分词会在原有新闻数据基础之上进行增量训练。 从而达到即利用新闻领域的丰富数据,又兼顾目标领域特殊性的目的。

pyltp 支持使用用户训练好的个性化模型。关于个性化模型的训练需使用 LTP,详细介绍和训练方法请参考 个性化分词 。

在 pyltp 中使用个性化分词模型的示例如下

#*- coding: utf-8 -*-

import os

LTP_DATA_DIR = '/path/to/your/ltp_data' # ltp模型目录的路径

cws_model_path = os.path.join(LTP_DATA_DIR, 'cws.model') # 分词模型路径,模型名称为`cws.model`

from pyltp import CustomizedSegmentor

customized_segmentor = CustomizedSegmentor() # 初始化实例

customized_segmentor.load(cws_model_path, '/path/to/your/customized_model') # 加载模型,第二个参数是您的增量模型路径

words = customized_segmentor.segment('亚硝酸盐是一种化学物质')

print '\t'.join(words)

customized_segmentor.release()

同样,使用个性化分词模型的同时也可以使用外部词典

#-*- coding: utf-8 -*-

import os

LTP_DATA_DIR = '/path/to/your/ltp_data' # ltp模型目录的路径

cws_model_path = os.path.join(LTP_DATA_DIR, 'cws.model') # 分词模型路径,模型名称为`cws.model`

from pyltp import CustomizedSegmentor

customized_segmentor = CustomizedSegmentor() # 初始化实例

customized_segmentor.load_with_lexicon(cws_model_path, '/path/to/your/customized_model', '/path/to/your/lexicon') # 加载模型

words = customized_segmentor.segment('亚硝酸盐是一种化学物质')

print '\t'.join(words)

customized_segmentor.release()

4.3词性标注

使用 pyltp 进行词性标注示例如下

#-*- coding: utf-8 -*-

import os

LTP_DATA_DIR = '/path/to/your/ltp_data' # ltp模型目录的路径

pos_model_path = os.path.join(LTP_DATA_DIR, 'pos.model') # 词性标注模型路径,模型名称为`pos.model`

from pyltp import Postagger

postagger = Postagger() # 初始化实例

postagger.load(pos_model_path) # 加载模型

words = ['元芳', '你', '怎么', '看'] # 分词结果

postags = postagger.postag(words) # 词性标注

print '\t'.join(postags)

postagger.release() # 释放模型

结果如下

参数 words 是分词模块的返回值,也支持 Python 原生的 list 类型,例如

words = ['元芳', '你', '怎么', '看']

postags = postagger.postag(words)

LTP 使用 863 词性标注集,详细请参考 词性标注集 。

- 使用词性标注外部词典

pyltp 词性标注同样支持用户的外部词典。词性标注外部词典同样为一个文本文件,每行指定一个词,第一列指定单词,第二列之后指定该词的候选词性(可以有多项,每一项占一列),列与列之间用空格区分。示例如下

##命名实体识别

使用 pyltp 进行命名实体识别示例如下

#-*- coding: utf-8 -*-

import os

LTP_DATA_DIR = '/path/to/your/ltp_data' # ltp模型目录的路径

ner_model_path = os.path.join(LTP_DATA_DIR, 'ner.model') # 命名实体识别模型路径,模型名称为`pos.model`

from pyltp import NamedEntityRecognizer

recognizer = NamedEntityRecognizer() # 初始化实例

recognizer.load(ner_model_path) # 加载模型

words = ['元芳', '你', '怎么', '看']

postags = ['nh', 'r', 'r', 'v']

netags = recognizer.recognize(words, postags) # 命名实体识别

print '\t'.join(netags)

recognizer.release() # 释放模型

其中,words 和 postags 分别为分词和词性标注的结果。同样支持 Python 原生的 list 类型。

结果如下

LTP 采用 BIESO 标注体系。B 表示实体开始词,I 表示实体中间词,E 表示实体结束词,S 表示单独成实体,O 表示不构成命名实体。

LTP 提供的命名实体类型为: 人名(Nh)、地名(Ns)、机构名(Ni)。

B、I、E、S 位置标签和实体类型标签之间用一个横线 - 相连;O 标签后没有类型标签。

详细标注请参考 命名实体识别标注集 。

4.4依存句法分析

使用 pyltp 进行依存句法分析示例如下

#-*- coding: utf-8 -*-

import os

LTP_DATA_DIR = '/path/to/your/ltp_data' # ltp模型目录的路径

par_model_path = os.path.join(LTP_DATA_DIR, 'parser.model') # 依存句法分析模型路径,模型名称为`parser.model`

from pyltp import Parser

parser = Parser() # 初始化实例

parser.load(par_model_path) # 加载模型

words = ['元芳', '你', '怎么', '看']

postags = ['nh', 'r', 'r', 'v']

arcs = parser.parse(words, postags) # 句法分析

print "\t".join("%d:%s" % (arc.head, arc.relation) for arc in arcs)

parser.release() # 释放模型

其中,words 和 postags 分别为分词和词性标注的结果。同样支持 Python 原生的 list 类型。

结果如下

arc.head 表示依存弧的父节点词的索引。ROOT 节点的索引是 0,第一个词开始的索引依次为 1、2、3…

arc.relation 表示依存弧的关系。

arc.head 表示依存弧的父节点词的索引,arc.relation 表示依存弧的关系。

标注集请参考 依存句法关系 。

4.5语义角色标注

使用 pyltp 进行语义角色标注示例如下

#-*- coding: utf-8 -*-

import os

LTP_DATA_DIR = '/path/to/your/ltp_data' # ltp模型目录的路径

srl_model_path = os.path.join(LTP_DATA_DIR, 'srl') # 语义角色标注模型目录路径,模型目录为`srl`。注意该模型路径是一个目录,而不是一个文件。

from pyltp import SementicRoleLabeller

labeller = SementicRoleLabeller() # 初始化实例

labeller.load(srl_model_path) # 加载模型

words = ['元芳', '你', '怎么', '看']

postags = ['nh', 'r', 'r', 'v']

#arcs 使用依存句法分析的结果

roles = labeller.label(words, postags, arcs) # 语义角色标注

#打印结果

for role in roles:

print role.index, "".join(

["%s:(%d,%d)" % (arg.name, arg.range.start, arg.range.end) for arg in role.arguments])

labeller.release() # 释放模型

结果如下

3 A0:(0,0)A0:(1,1)ADV:(2,2)

第一个词开始的索引依次为 0、1、2…

返回结果 roles 是关于多个谓词的语义角色分析的结果。由于一句话中可能不含有语义角色,所以结果可能为空。

role.index 代表谓词的索引, role.arguments 代表关于该谓词的若干语义角色。

arg.name 表示语义角色类型,arg.range.start 表示该语义角色起始词位置的索引,arg.range.end 表示该语义角色结束词位置的索引。

例如上面的例子,由于结果输出一行,所以 “元芳你怎么看” 有一组语义角色。 其谓词索引为 3,即 “看”。这个谓词有三个语义角色,范围分别是(0,0) 即“元芳”,(1,1)即 “你”,(2,2) 即“怎么”,类型分别是 A0、A0、ADV。

arg.name 表示语义角色关系,arg.range.start 表示起始词位置,arg.range.end 表示结束位置。

项目码源见文章顶部或文末

https://download.csdn.net/download/sinat_39620217/87982770