来自B站视频,API查阅,TORCH.NN

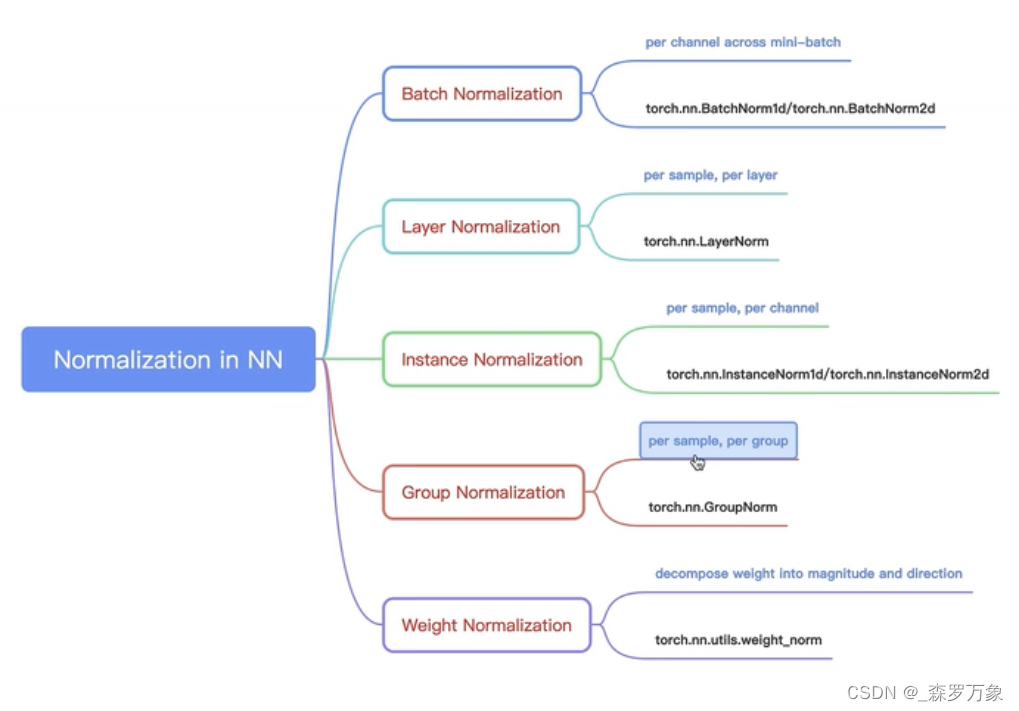

- layer normalization 是针对单个样本,训练和测试的时候行为一致

- LN 相对于 BN 更适合 RNN,可以降低训练时间

- LN 中不同样本有不同的归一化参数,以层计算

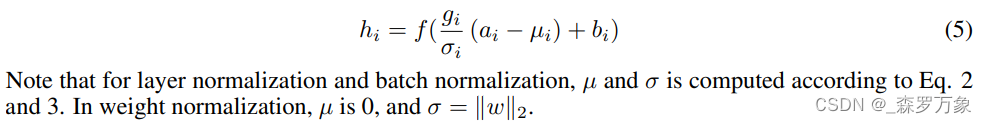

- a 是输入,f 是每层具体的操作,g 和 b 是可学习参数

- BN1d 输入是 (n,c,l),用于序列需要转置,BN2d 用于图像,标准差是 torch.var(input, unbiased=False) 有偏估计

- track_running_stats 和 momentum 是滑动平均,affine 是归一化之后还有仿射

- instancenorm 适合风格迁移,在时间步处求均值,把随着时间不变的东西消掉了,一系列画里可能是画的风格,在语音里可能是一个人人特有的音色,因此可以理解 instance(实例,情况) norm

- weight_norm 是函数,输入是一个实例层