文章目录

- MedCLIP: Contrastive Learning from Unpaired Medical Images and Text

- 目标

- 问题来源

- 模型架构

- Supervised Prototypical Contrastive Learning for Emotion Recognition in Conversation

- Prototypical Contrastive Learning

- Curriculum Strategy:

- KECP: Knowledge Enhanced Contrastive Prompting for Few-shot Extractive Question Answering

- 目标

- Fine-grained Contrastive Learning for Relation Extraction

- 目标

- 模型

- Debiased Contrastive Learning of Unsupervised Sentence Representations

MedCLIP: Contrastive Learning from Unpaired Medical Images and Text

目标

match the image and text

问题来源

For an anchor image, previous methods treat paired texts (i.e., reports from the same patient’s

study) as positives and unpaired texts (i.e., reports from other patients’ studies) as negatives. However, the negative

texts can describe the same symptoms as the anchor texts

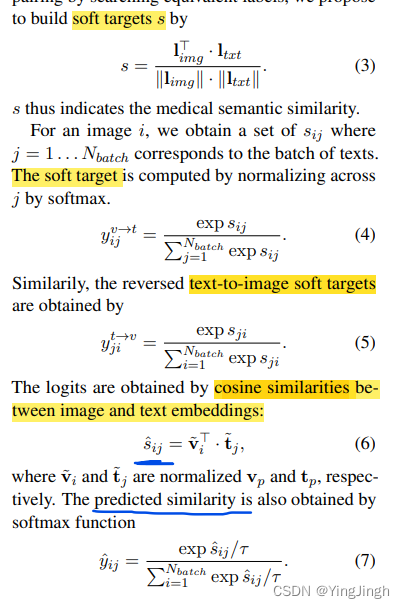

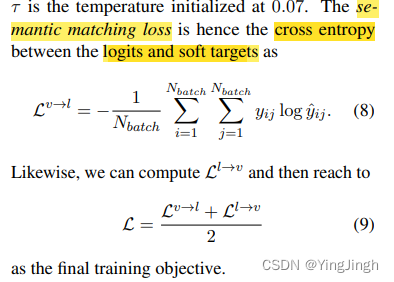

解决方式: a soft semantic matching loss that uses the medical semantic similarity between each image and report as the supervision signal

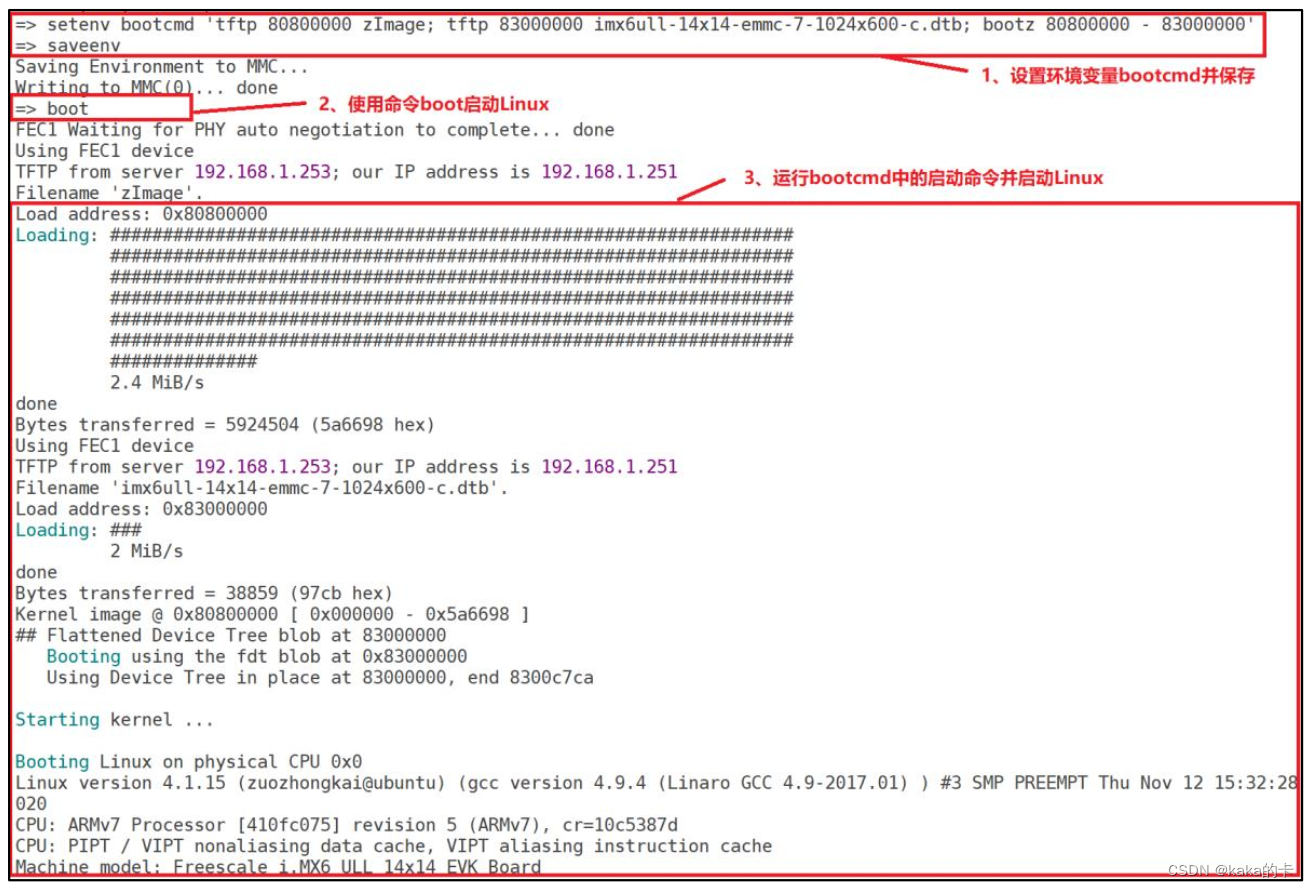

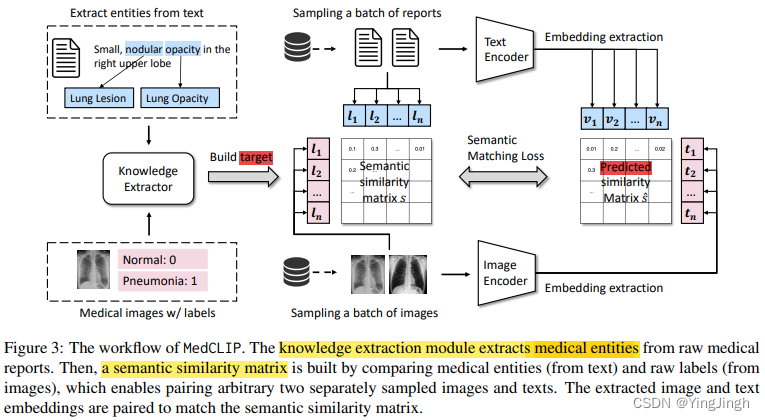

模型架构

knowledge extractor module:从文本中抽取实体

Semantic similarity matrixs:通过比较医学实体(来自文本)和原始标签(来自图像)来建立语义相似性矩阵,这使得任意两个单独采样的图像和文本能够配对。

Predicted similarity matrix: 预测相似值

损失函数:semantic matching loss

Supervised Prototypical Contrastive Learning for Emotion Recognition in Conversation

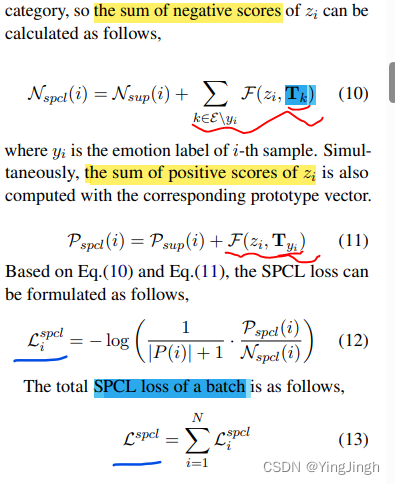

在每个训练步骤中,SPCL从这些队列中抽取一定数量的表征作为支持集,并为每个情感类别计算一个临时原型向量。这些原型向量被用作相应类别的样本来计算损失。SPCL确保每个样本至少有一个相同类别的阳性样本和一个小批量内所有其他类别的阴性样本。实验表明,SPCL可以在类别不平衡的情况下很好地工作,并且对训练批次的大小不太敏感。

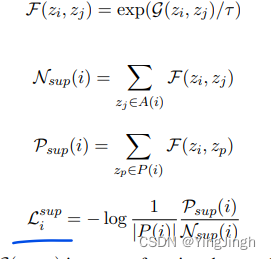

Prototypical Contrastive Learning

正常的contrastive loss:P表示positive pairs,N表示negtive pairs

G(zi, zj ) is a score function that can be dot production, cosine similarity, etc.

prototypical contrastive learning:

计算得到每个class的元表示后,作为一个example,用于计算batch中的真实example和这个类型的元表示之间的距离。(红色线标出部分)

更新之后的loss函数如下:

Curriculum Strategy:

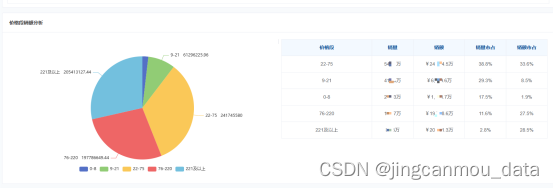

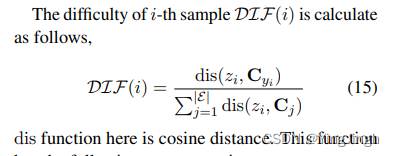

(1)数据难度衡量:主要根据数据(sample) 距离每个class中心的距离来判断数据的难度。

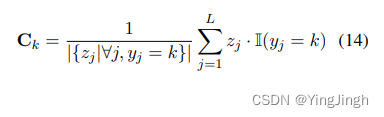

在每个epoch中,先计算class center的位置:

(2)数据选择:我们设计了一种基于抽样的方法来构建一系列从易到难的数据子集。让R作为训练历时的数量,为了在第k个历时训练模型,我们首先生成一个长度为L的等差数列,其中a1=1-k/R,aL=k/R。然后,我们用a初始化一个伯努利分布,并从中抽取一个二进制随机数组RB。我们用B从当前历时的训练集中抽取一个子集Dsub-k,其中Dsub-k≡{xi∈Dtrain|RBi = 1}。

KECP: Knowledge Enhanced Contrastive Prompting for Few-shot Extractive Question Answering

目标

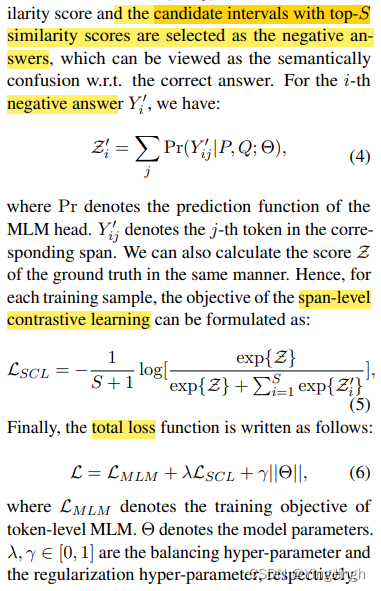

给出query,从文本得到answer所在的index。predict the start and the end positions

of the answer span

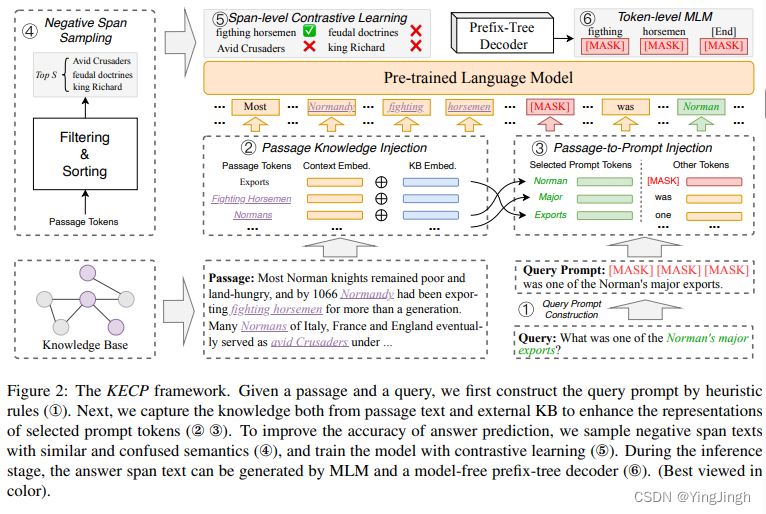

给定一个段落和一个查询,我们首先通过启发式规则(①)构建查询提示。接下来,我们从段落文本和外部知识库中获取知识,以加强对所选提示标记的表述(②③)。为了提高答案预测的准确性,我们对语义相似和混乱的负面跨度文本进行采样(④),并通过对比学习来训练模型(⑤)。在推理阶段,答案跨度文本可由MLM和无模型前缀树解码器⑥生成。(最好以彩色观看)

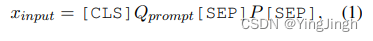

Input: We concatenate the query prompt Qprompt and the passage text P with some special tokens as input x input

span 预测: 我们首先通过滑动窗口获得一系列的跨度文本

Fine-grained Contrastive Learning for Relation Extraction

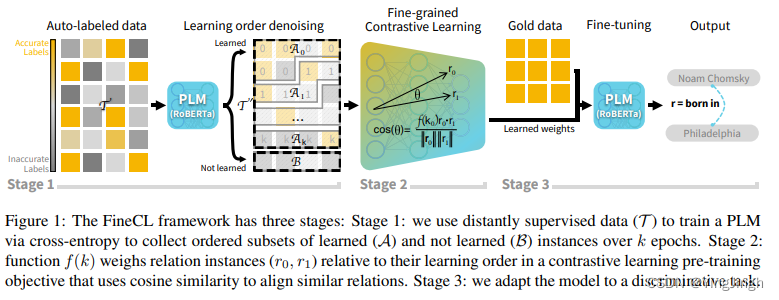

目标

在distant supervised RE中,部分label是错误的。

首先评估所有远距离监督的训练实例的噪声水平,然后将这种细粒度的信息纳入对比性预训练中。噪声较小或干净的训练实例相对于噪声训练实例的权重更高。 然后,我们在黄金标记的数据上对模型进行微调

我们利用学习顺序去噪 ( learning-order denoising)来改善预训练期间学到的关系表征,方法是将每个关系实例的权重与该实例的学习顺序进行线性投影。我们对训练中较早学到的关系实例适用较高的权重,而对训练中较晚学到的关系实例则适用较高的权重 (较早学习到的实例的真实性高于较晚学习到的实例的真实性)。我们使用这些权重来通知一个对比性学习损失函数,该函数学习将相似关系的实例分组。

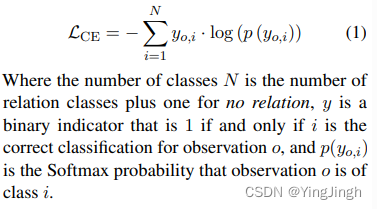

模型

(1) learning order denoising

训练一个PLM,使用多类交叉熵损失来预测关系类。

在训练过程中,我们记录了训练实例的学习顺序。在最初的正确预测中,我们认为一个实例是 "学会 "的learned。同样,如果模型在训练期间未能正确预测一个实例,则该实例为 “未学” “not learned”。

应该是通过这个过程记录了instance的order,作为了后续contrastive learning的权重值。

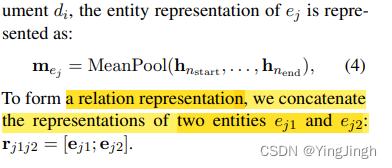

关系的representation:

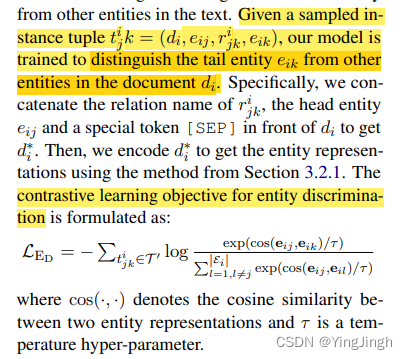

entity level的contrastive learning:

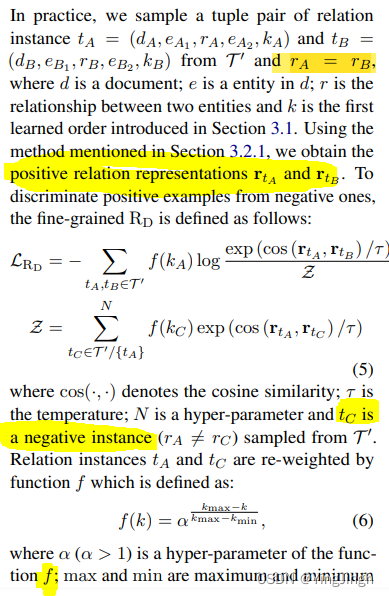

relation level的contrastive learning: distinguish whether two relations are semantically similar

assign higher weights to earlier learned instances from the learning order denoising stage

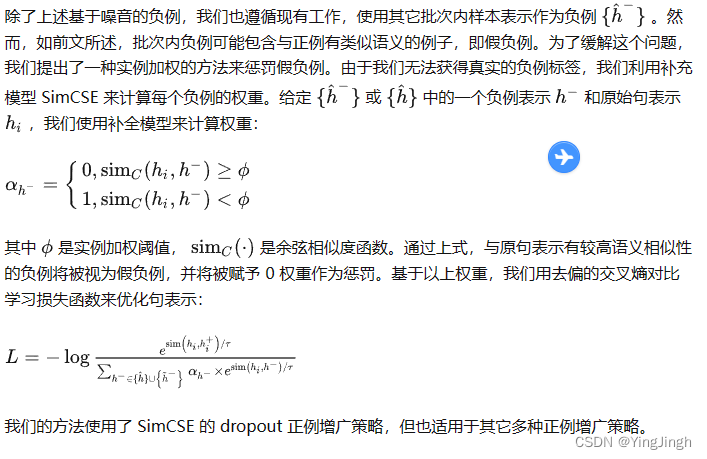

Debiased Contrastive Learning of Unsupervised Sentence Representations

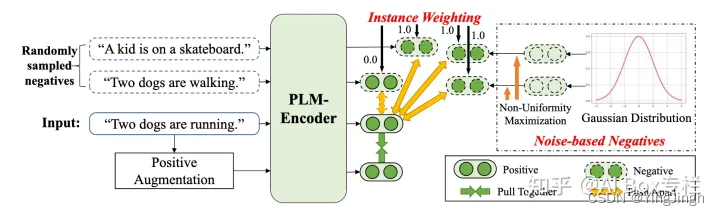

DCLR 聚焦于减少句表示对比学习中负采样偏差的影响。在这个框架中,我们设计了一种基于噪声的负例生成策略和一种惩罚假负例的实例加权方法。

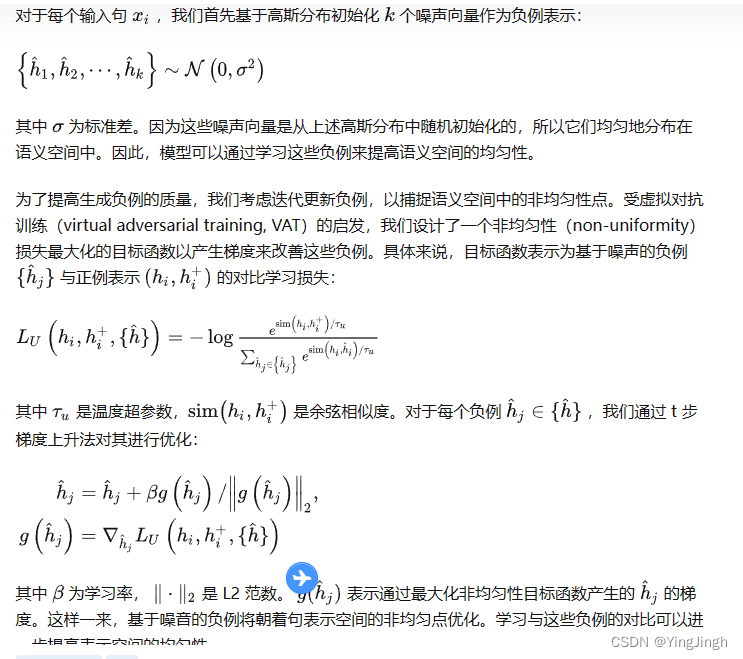

负例生成

带有实例加权的负例学习