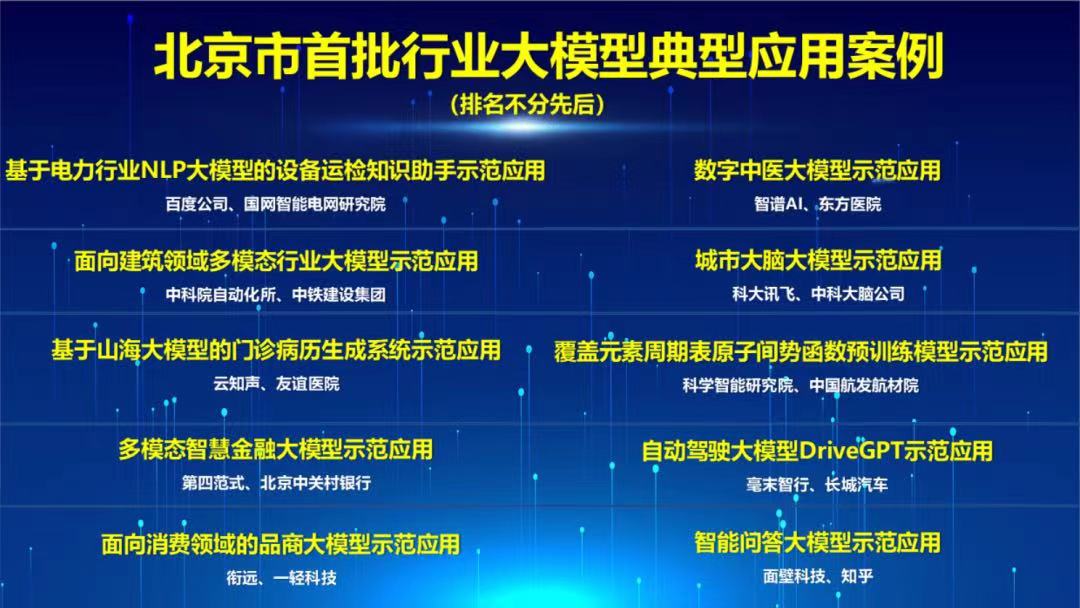

今年,大模型火的一塌糊涂。最近几个月paper with code上,前几名的论文几乎都是生成模型和LLM。参加AI相关的会议,也是千篇一律的LLM。国内的大厂争先恐后的发布自己的大模型,比如百度的文心、360的智脑、讯飞的星火等等,呈现出百花齐放百家争鸣的繁荣现象。。北京市推出了首批的大模型应用案例,从政府层面得到了对大模型的肯定。

结合最近论文和实践,我对大模型有了一些自己的看法:

大模型是有智能的。

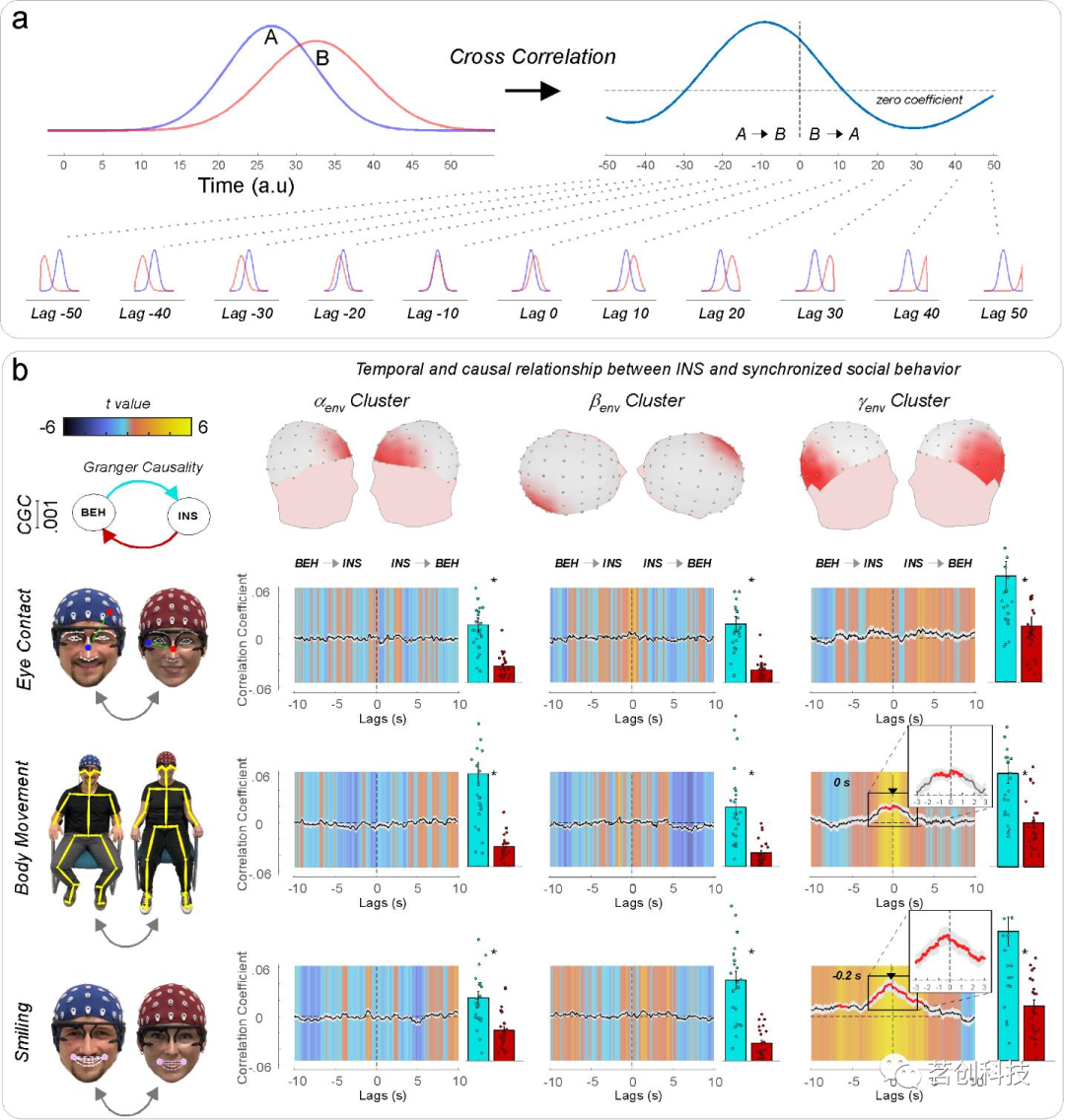

虽然不愿意承认这点,但是大模型的表现确确实实的展现出了智能。比如chat paper这样的应用,利用大模型读paper,提取paper的关键内容;医疗大模型 ——HuatuoGPT(华佗GPT)使语言模型具备像医生一样的诊断能力和提供有用信息的能力;ChatLaw作为法律大模型在2000道司法考试上得到了1733的分数等等。这些现象足以证明大模型能够理解人类的表达意图,是有智能的。甚至,有人已经发出了硅基生命将会统治碳基生命的言论,早早做起了投降派。

其实,3年前的CLIP给人留下了深刻的印象,通过对4亿的文本——图像对进行训练出来的多模态模型,零样本迁移在ImgetNet数据集上超越了ResNet50,同时在物体检测也有着不俗的表现。CLIP打破了计算机视觉的原有范式,真正做了对文本和图像的理解 论文翻译详见:https://blog.csdn.net/hhhhhhhhhhwwwwwwwwww/article/details/125452516。

CLIP的成功证明提高模型的参数规模和数据规模,可以产生意想不到的智能。

也许,大模型是一场骗局?

数据集一般分为训练集、验证集和测试集,这三个数据集是不重复的。训练ChatGPT的数据集有几个PB,几乎是人类已知数据的总和,很难保证数据集不重复。而且我们对ChatGPT的提问也几乎包含在这些数据集里。ChatGPT更像一个经过压缩的数据库,我们的提问就变成了查询和检索,只不过这样的检索效率很高,大大超越了现有的搜索引擎。

如果是这样,大语言模型的智能是非常有限的,也需没有智能。我们用小模型能不能做到呢?比如1B或者更小的模型。

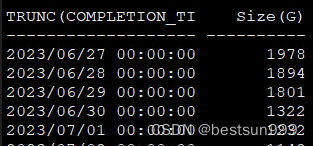

今年高考题放出来后,FlagEval 大模型评测团队从 2023年高考考卷中整理了 147 道客观题(其中语文 20道,英语 44道,历史 31道,数学 9道,物理 8道,政治 21道,生物 14道)形成 Gaokao2023 V1.0 评测集。经过测试,GPT-4 和 GPT-3.5-turbo 正确率分别为 60.4%、42.5%。750×60%=450分。陆奇博士说ChatGPT的能力达到了斯坦福大学本科生的水平。貌似高考450分很难上斯坦福吧!面对新问题,ChatGPT的表现并不理想。

当然,ChatGPT在很多其他领域的表现也不尽人意,出现了幻想!

大语言模型的能力来源于数据还是模型?这需要去验证,也需不需要1750亿这样的大模型就能达到现有ChatGPT能力。这个问题只能有OpenAI去回答。

从头训练or微调

对于有卡的人或者公司来说,这不是个问题。但是对于很多小点的公司和个人不得不考虑二者的成本和收益比。微调,特别是量化微调可以大大减少训练成本,我们在基座模型上使用消费级的显卡就可以完成。QLORA足以在单个48GB GPU上微调65B参数模型,同时保留完整的16位微调任务性能。邱锡鹏团队实现了在8×RTX 3090的机器上对65B模型进行全参数微调。这些方法大大降低了大模型的训练门槛。

组织专业的数据在已有的模型上微调,,可以提升大模型在专有领域的能力,但是带来的后果是模型其他能力的退化,比如多轮对话能力在微调之后有可能丧失了,出现了灾难性的遗忘!

上周和众多的专家交流后,我得到了答案。在组织数据的时候,可以将专有领域的数据和训练基座模型的原有数据融合去训练,有能力做全参数训练的,可以做全参数微调,如果没有的可做一些量化微调。不过训练成本会变的很大,还是不适合个人玩家。

我想象中的大模型架构

一个通用的大语言模型很难满足人们的需求,随着专有领域蓬勃发展,专有领域小模型在各自的领域吊打ChatGPT.。所以,我对大模型的架构思考了良久!我认为大模型的整体架构应该是个模型集。如下图:

通用的大模型承担中心处理的角色,它有很强的语言交互能力和多轮对话的能力。在实际生活中,人们很难一句话描述出自己的需求,往往需要多轮的沟通,等待双方的认知对齐后才能得出正确的需求。