【背景】

目前很多公司由于数据安全的问题,不能使用OpenAI的GPT,同时也没有必要非得使用如此泛用化的GPT。很多公司因此有训练自己的离线GPT的需求,这样的GPT只需要具备专业知识即可。

要使这个成为可能,首先就需要能够让GPT的Model在本地运行。

【工具】

GPT4ALL就是这样一个应运而生的工具。

官网地址:https://gpt4all.io/index.html

如果官网速度慢,可以下我存的百度:

链接:https://pan.baidu.com/s/1QodbiPxnK0RSYDcDc65sPg?pwd=dff3

提取码:dff3

–来自百度网盘超级会员V7的分享

【部署方法】

- 第一种部署方法最简单,在官网首页下载对应平台的可执行文件,直接运行即可。这种方式的优点在于方便,配有UI,UI集成了包括Model下载,训练等在内的所有功能。缺点是这种方法只能本机使用GPT功能,个人培训个人的GPT,学习和实验的成分多一些,如果要拿这个能力做局域网应用,还是需要别的部署方式。

- 第二种推荐的部署方式就是Python部署。这里有几个注意点,如果你用的Anaconda+Pycharm,注意保证GPT相应的编译器环境是3.8以上的,不然install package会报错。且Anaconda需要是64位。我一开始64位OS装了32bitAnaconda也会报错。这两个坑避免了,install会顺利。

注意还需要在首页下载model的bin文件,推荐默认的3.5版本,免费可商用。其它还有很多别的模型,自行研究即可。

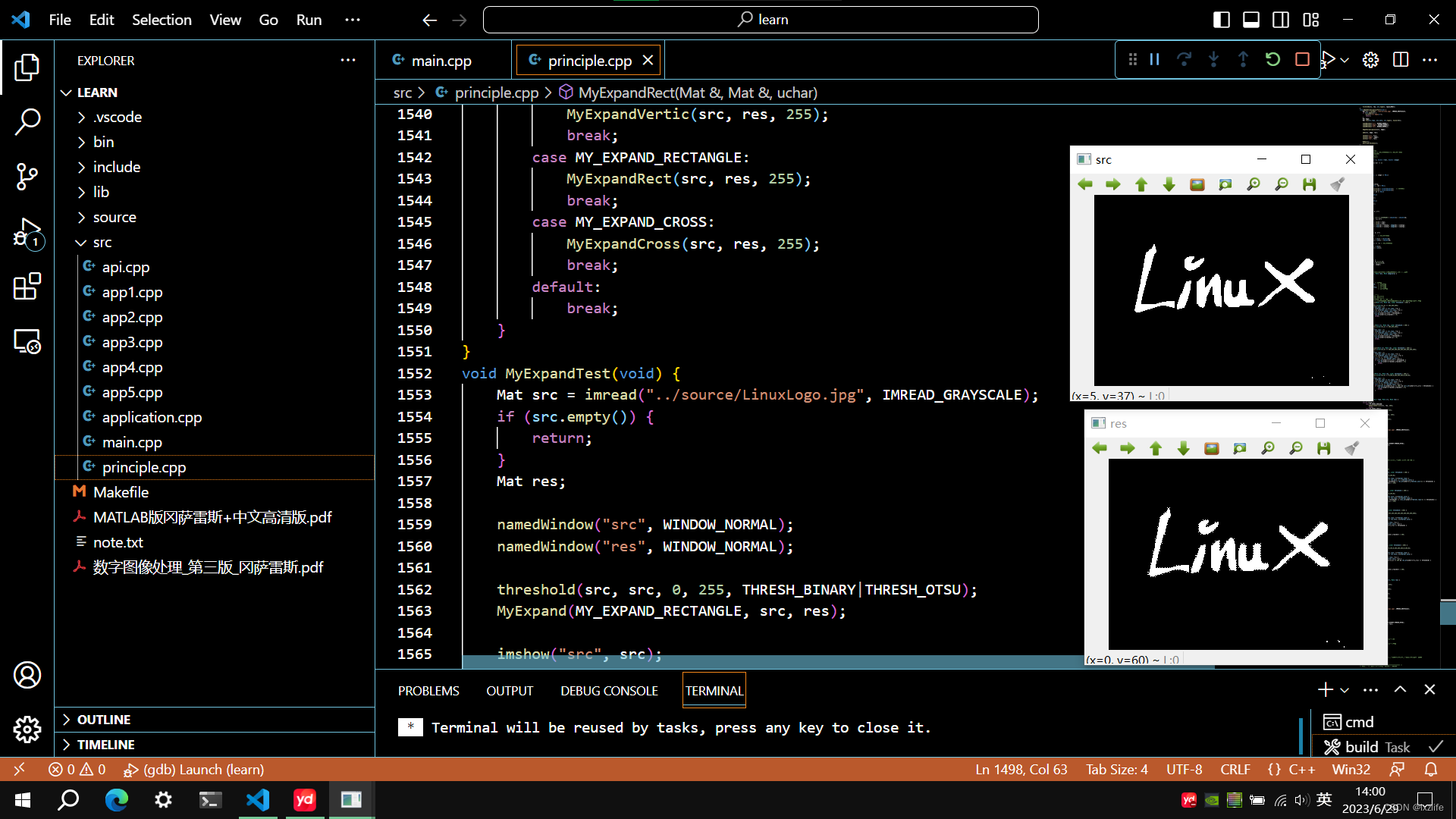

【python部署命令】

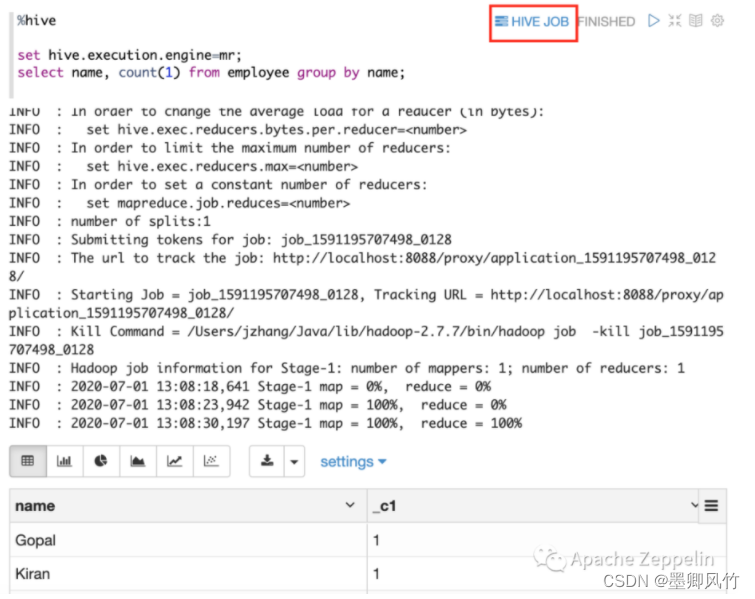

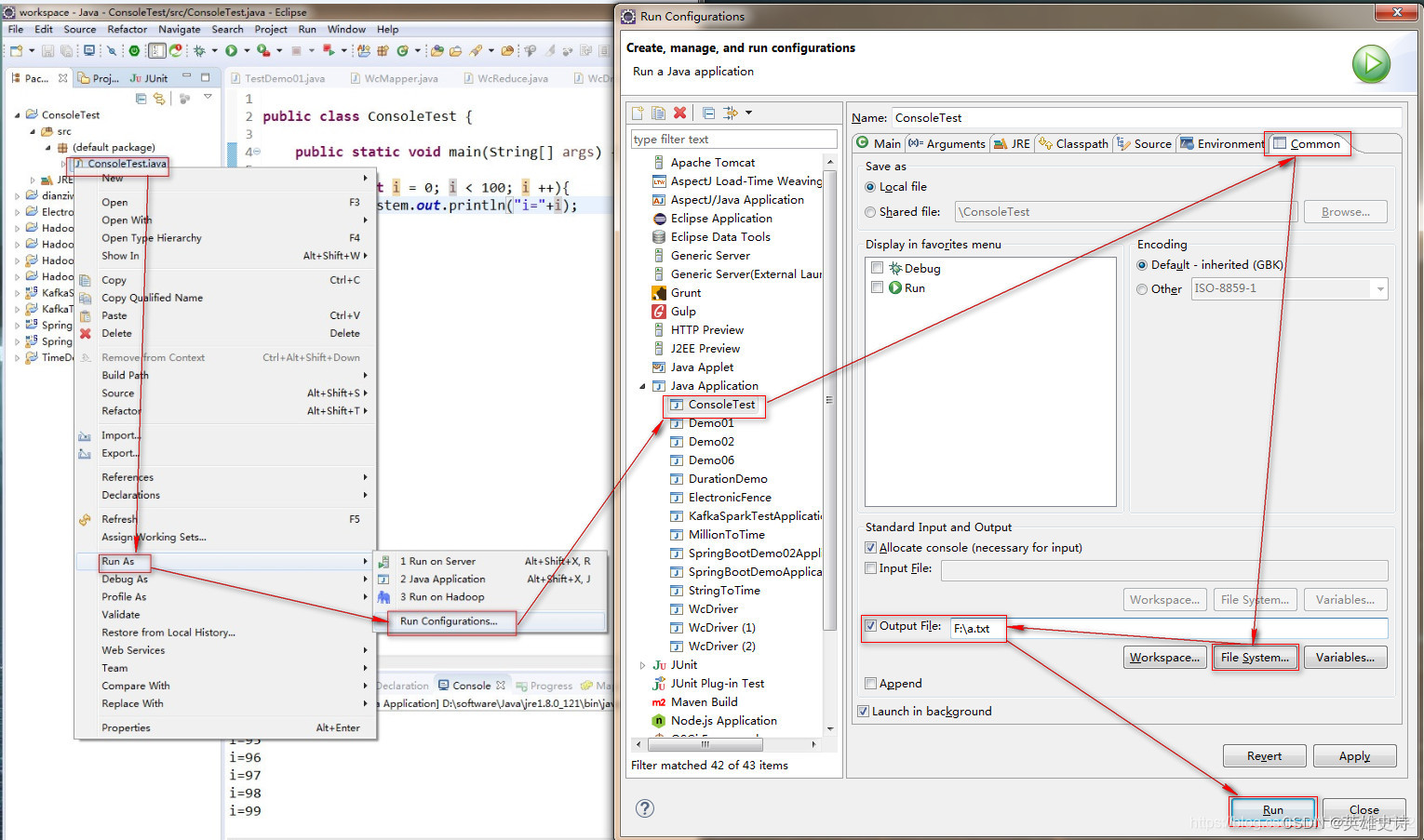

python部署的具体命令(可以命令行一步一步执行):

先是Pycharm的Terminal中

pip install nomic

pip install gpt4all

接着在PythonConsole中:

import gpt4all //看看是否成功导入

dir(gpt4all)//查看相关的模块是否都安装了

from gpt4all import GPT4All//开始验证Prompt功能

gpt = GPT4All(model_name="ggml-gpt4all-j-v1.3-groovy.bin",model_path="D:/gpt/")//先把相应的bin模型引入并初始化

gpt.chat_completion([{"role":"assistant","content":"what are machine learning models"}])//这条就是Prompt功能命令,送出后机器反应一会儿会给出问题的回答。

【其它信息】

GPT4ALL是靠CPU而非GPU运行的,所以性能好坏跟CPU性能相关。