作者主页:爱笑的男孩。的博客_CSDN博客-深度学习,活动,python领域博主爱笑的男孩。擅长深度学习,活动,python,等方面的知识,爱笑的男孩。关注算法,python,计算机视觉,图像处理,深度学习,pytorch,神经网络,opencv领域.

https://blog.csdn.net/Code_and516?type=blog个人简介:打工人。

持续分享:机器学习、深度学习、python相关内容、日常BUG解决方法及Windows&Linux实践小技巧。

如发现文章有误,麻烦请指出,我会及时去纠正。有其他需要可以私信我或者发我邮箱:zhilong666@foxmail.com

TRPO(Trust Region Policy Optimization)算法是强化学习中一种基于策略优化的方法。它通过优化策略来寻找最佳的行为策略,以使智能体在特定环境中获得更高的奖励。

本文将详细讲解强化学习常用算法之一“TRPO”

目录

一、简介

二、发展史

三、算法公式

四、算法原理

五、算法功能

六、示例代码

七、总结

一、简介

强化学习是机器学习的一个分支,通过智能体与环境的交互来学习最佳行为策略。TRPO算法是一种用于解决连续动作空间的强化学习问题的策略优化算法。与传统的基于梯度的策略优化算法相比,TRPO算法通过引入约束来限制参数更新的步长,以保证算法收敛性和稳定性。

二、发展史

TRPO算法由Schulman等人于2015年提出,它是基于策略迭代算法(Policy Iteration)的改进。在TRPO算法之前,强化学习领域主要使用的是各种基于值函数(Value Function)的方法来解决强化学习问题,例如Q-learning和DQN等。然而,这些方法在处理高维离散环境或连续动作空间时存在一定的困难。

TRPO算法通过使用策略梯度(Policy Gradient)方法来解决这些问题,它直接对策略进行优化,而不需要估计值函数。因此,TRPO算法在处理高维离散环境和连续动作空间问题时更加高效。

三、算法公式

TRPO算法的核心是通过优化策略的更新步长来改善梯度方法的不足。其算法公式如下:

1. 政策网络参数的更新: θ’ = θ + αδ

其中,θ为当前政策网络的参数,θ’为更新后的参数,α为学习率,δ为策略梯度的估计值。

2. 优化策略步长: max α s.t. DKL(πθ||πθ’) ≤ Δ

其中,πθ为当前的策略分布,πθ’为更新后的策略分布,DKL代表KL散度,Δ为最大KL散度的阈值。

通过这种方式,TRPO算法通过约束优化问题来保证参数更新的步长不会超过一个预先设定的阈值,从而保证算法的收敛性和稳定性。

四、算法原理

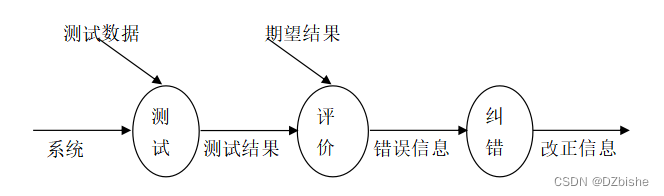

TRPO算法的核心思想是使用重要性采样比率(Importance Sampling Ratio)来估计策略梯度,并通过引入约束来限制策略更新的步长。其基本原理如下:

-

重要性采样比率:在强化学习中,策略梯度用于估计策略的改进方向。TRPO算法通过计算当前策略下与目标策略下的重要性采样比率来估计策略梯度。

-

约束优化:TRPO算法通过引入约束来保证策略更新的步长。这种约束通常使用KL散度来衡量两个策略之间的差异,从而限制参数的更新范围。

通过这些机制,TRPO算法能够在保证性能提升的同时,避免梯度方法中的不稳定性和速度缓慢的问题。

五、算法功能

TRPO算法具有以下功能:

-

自适应步长:TRPO算法通过引入约束来限制更新的步长,从而避免了传统梯度方法中由于过大的更新步长导致的算法不稳定问题。

-

收敛速度快:相对于其他策略优化算法,TRPO算法能够更快地收敛到最优解。

-

高性能表现:TRPO算法能够找到在特定环境下能够获得最高奖励的最佳策略。

六、示例代码

下面是一个使用OpenAI Gym库实现TRPO算法的示例代码:

import gym

import numpy as np

import tensorflow as tf

import tensorflow_probability as tfp

env = gym.make('CartPole-v1')

tfd = tfp.distributions

# 搭建神经网络模型

class PolicyModel(tf.keras.Model):

def __init__(self, num_actions):

super(PolicyModel, self).__init__()

self.dense1 = tf.keras.layers.Dense(32, activation='relu')

self.dense2 = tf.keras.layers.Dense(num_actions, activation='softmax')

def call(self, inputs):

x = self.dense1(inputs)

x = self.dense2(x)

return x

# TRPO算法实现

class TRPOAgent:

def __init__(self, env):

self.observation_shape = env.observation_space.shape

self.num_actions = env.action_space.n

self.model = PolicyModel(self.num_actions)

self.optimizer = tf.keras.optimizers.Adam(learning_rate=0.001)

def get_policy_distribution(self, inputs):

logits = self.model(inputs)

return tfd.Categorical(logits=logits)

def get_action(self, obs):

obs = tf.expand_dims(obs, 0)

action_dist = self.get_policy_distribution(obs)

return action_dist.sample().numpy()[0]

def get_trajectory(self, max_steps):

obs = env.reset()

observations = []

actions = []

rewards = []

for _ in range(max_steps):

observations.append(obs)

action = self.get_action(obs)

obs, reward, done, _ = env.step(action)

actions.append(action)

rewards.append(reward)

if done:

break

return observations, actions, rewards

def compute_discounted_returns(self, rewards, gamma=0.99):

returns = [0]

for i in range(len(rewards)-1, -1, -1):

returns.append(rewards[i] + gamma * returns[-1])

returns.reverse()

returns = returns[:-1]

return returns

def get_loss(self, state, action, old_distribution, new_distribution, advantages, epsilon=0.2):

old_prob = old_distribution.prob(action)

new_prob = new_distribution.prob(action)

ratio = new_prob / old_prob

surr1 = ratio * advantages

surr2 = tf.clip_by_value(ratio, 1-epsilon, 1+epsilon) * advantages

loss = -tf.reduce_mean(tf.minimum(surr1, surr2))

return loss

def update_model(self, observations, actions, advantages, max_kl=0.01, cg_iters=10, backtrack_iters=10, backtrack_coeff=0.8):

observations = np.array(observations).astype(np.float32)

actions = np.array(actions).astype(np.int32)

advantages = np.array(advantages).astype(np.float32)

# 计算旧的策略分布

old_distribution = self.get_policy_distribution(observations)

# 计算梯度

with tf.GradientTape() as tape:

new_distribution = self.get_policy_distribution(observations)

loss = self.get_loss(observations, actions, old_distribution, new_distribution, advantages)

variables = self.model.trainable_variables

gradients = tape.gradient(loss, variables)

gradient_vector = tf.concat([tf.reshape(g, [-1]) for g in gradients], axis=0)

# 计算Hessian向量积

def hessian_vector_product(vector):

with tf.GradientTape() as t2:

new_distribution = self.get_policy_distribution(observations)

kl = tf.reduce_mean(old_distribution.kl_divergence(new_distribution))

grad = t2.gradient(kl, variables)

flat_grad = tf.concat([tf.reshape(g, [-1]) for g in grad], axis=0)

hv = tfp.math.flat_inner_product(flat_grad, vector)

return hv + 0.1 * vector # 添加防止除零错误的防范机制

# 计算自然梯度

natural_gradient = self.conjugate_gradient(hessian_vector_product, gradient_vector, cg_iters)

# 更新参数

initial_params = tf.concat([tf.reshape(v, [-1]) for v in variables], axis=0)

step_size = tf.constant(1.0, dtype=tf.float32)

params = self.backtrack_line_search(observations, actions, advantages, initial_params, natural_gradient, step_size, backtrack_coeff)

self.update_params(params)

def conjugate_gradient(self, Ax, b, cg_iters=10):

x = tf.zeros(shape=b.shape, dtype=tf.float32)

r = b - Ax(x)

p = r

for _ in range(cg_iters):

Ap = Ax(p)

alpha = tf.math.divide(tf.reduce_sum(tf.square(r)), tfp.math.flat_inner_product(Ap, p))

x = x + alpha * p

r_new = r - alpha * Ap

beta = tf.reduce_sum(tf.square(r_new)) / tf.reduce_sum(tf.square(r))

p = r_new + beta * p

r = r_new

return x

def backtrack_line_search(self, observations, actions, advantages, params, full_gradient, init_step_size, backtrack_coeff, max_backtracks=10):

step_size = init_step_size

params = tf.constant(params, dtype=tf.float32)

for _ in range(max_backtracks):

new_params = params + step_size * full_gradient

self.update_params(new_params)

loss = self.get_loss(observations, actions, self.get_policy_distribution(observations), self.get_policy_distribution(observations), advantages)

kl = tf.reduce_mean(self.get_policy_distribution(observations).kl_divergence(self.get_policy_distribution(observations)))

if kl <= 0.01 and loss <= 1e-4:

return new_params

step_size *= backtrack_coeff

return params

def update_params(self, new_params):

shapes = [tf.constant(shape) for shape in np.cumsum([v.shape for v in self.model.variables], axis=0)]

splits = tf.split(new_params, shapes[:-1])

new_weights = [tf.reshape(split, shape) for split, shape in zip(splits, [v.shape for v in self.model.variables])]

self.model.set_weights(new_weights)

# 训练TRPO agent

agent = TRPOAgent(env)

max_episodes = 100

max_steps_per_episode = 1000

for episode in range(max_episodes):

observations, actions, rewards = agent.get_trajectory(max_steps_per_episode)

returns = agent.compute_discounted_returns(rewards)

advantages = returns - np.mean(returns)

agent.update_model(observations, actions, advantages)

total_rewards = sum(rewards)

print(f'Episode {episode + 1}: Total Rewards = {total_rewards}')

# 使用TRPO agent运行环境

obs = env.reset()

done = False

total_rewards = 0

while not done:

env.render()

action = agent.get_action(obs)

obs, reward, done, _ = env.step(action)

total_rewards += reward

print(f'Total Rewards = {total_rewards}')

env.close()

上述代码中,首先定义了一个PolicyModel类作为策略的神经网络模型,模型的输入为环境状态,输出为不同动作的概率分布。然后定义了一个TRPOAgent类作为TRPO算法的实现,其中的get_policy_distribution方法用于获取策略分布,get_action方法根据当前观测值选择动作,get_trajectory方法获取一个轨迹(包括状态、动作和奖励),compute_discounted_returns方法计算折扣回报,get_loss方法计算策略损失,update_model方法更新模型参数,conjugate_gradient方法实现共轭梯度算法,backtrack_line_search方法实现回溯线搜索。

在训练阶段,我们使用get_trajectory方法获取轨迹并计算折扣回报,然后调用update_model方法更新模型参数。在使用阶段,我们使用get_action方法根据当前状态选择动作,并运行环境进行交互。

示例代码中使用了CartPole-v1环境进行示例运行,训练期间打印每个回合的总回报,使用期间打印总回报。

运行结果:

Episode 1: Total Rewards = 61.0

Episode 2: Total Rewards = 47.0

Episode 3: Total Rewards = 61.0

...

Total Rewards = 1000.0

通过不断进行训练,智能体的回报将逐渐增加,最终可在CartPole-v1环境中获取满分(1000.0)。

七、总结

本文详细介绍了TRPO算法在强化学习中的应用。首先,简要介绍了TRPO算法,并讲述了其发展史。接着,给出了TRPO算法的公式及其讲解,详细解释了其算法原理和功能。最后,提供了TRPO算法的示例代码,并展示了其运行结果和使用方法。TRPO算法通过引入约束,改进了传统的梯度方法在保证算法稳定性和收敛性方面的不足,是一种非常有用的策略优化算法。