多智能体强化学习理论与算法总结

先搞明白on-policy和off-policy

【强化学习】一文读懂,on-policy和off-policy

我的理解:on-policy就是使用最新的策略来执行动作收集数据,off-policy的训练数据不是最新策略收集的。on-policy也是使用同个策略网络去采样动作并执行,更新Q值也需要用到该策略网络。

1.基础概念理解,多智体的状态,观测,奖励等需要重新定义:

强化学习——多智能体强化学习

强化学习笔记:Policy-based Approach

2.最新多智能体强化学习方法总结:

最新多智能体强化学习方法【总结】

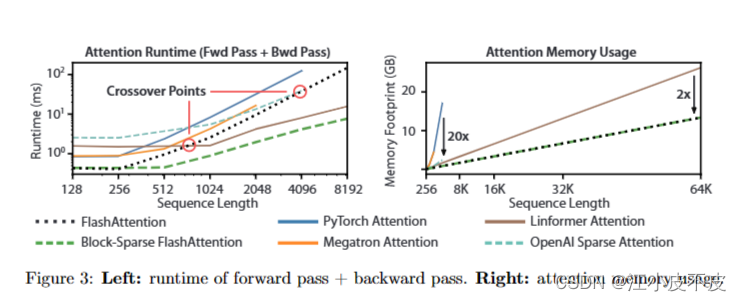

这里不错Transformer讲解:

Transformer讲解

3.一些基础算法(PPO,DQN等)步骤

DQN——PPO流程总结

强化学习笔记:PPO 【近端策略优化(Proximal Policy Optimization)】

进阶篇—PPO代码逐行分析

4.TD,GAE优势函数等定义:

GAE 广义优势估计

5.一些经典的多智能算法的局限性总结:

【一】最新多智能体强化学习方法【总结】

6.需要掌握的协作类(合作)的多智体算法:

一、基于价值函数值分解的方法:

(1)COMA算法:

【COMA】一种将团队回报拆分为独立回报的多智能体算法

COMA算法解析: Counterfactual Multi-Agent Policy Gradients

(2)VDN/QMIX/QTRAN/Qatten算法的介绍和局限性:

多智能体深度强化学习值分解方法总结(1)—VDN/QMIX/QTRAN/Qatten

(3)QMIX算法:

多智能体强化学习入门Qmix

代码:https://blog.csdn.net/tianjuewudi/article/details/121005721

(4)QTRAN算法:

QTRAN 算法详解(VDN和QMIX的升级版本)

(5)Qatten算法:

Qatten

(6)MAVEN算法:

(7)Weighted QMIX算法:

从 QMIX 到 WQMIX —— Weighted QMIX 算法详解

(8)QPLEX算法:

多智能体强化学习2021论文(五)QPLEX

最后,有个大佬调研:

多智能体强化学习值函数分解论文调研

多智能体强化学习之值函数分解:VDN、QMIX、QTRAN系列优缺点分析

二、基于PPO的方法:

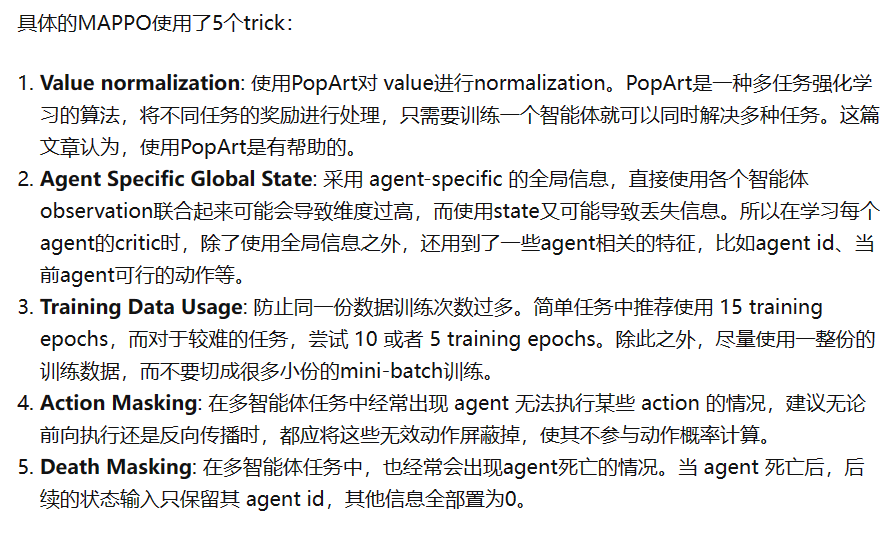

(1)MAPPO

多智能体强化学习之MAPPO理论解读

(2)HAPPO

(3) MAT

三、好代码:

https://github.com/marlbenchmark/on-policy

https://github.com/hijkzzz/pymarl2

四、一些论文总结

https://www.zhihu.com/people/sanmuyansan-mu-yang/columns