背景

最近朋友圈一直可以看到一个论调,视觉没有一个chatgpt一样强大的模型。似乎确实如此,视觉确实是缺一个通用能力的大模型;有些小伙伴可能就会讲了数据怎么能讲没有大模型:diffusion、della、muse、sam、controlnet一堆的大模型你要什么样功能的都有。然后这是这一对的不同功能的模型,而不是一个模型覆盖全视觉能力就说明了视觉确实缺一个和chatgpt一样的语言航母级别模型。

那么如果真要造这么个视觉大模型,他应该具备什么样的能力点呢。参照LLM模型个人觉得应该这个视觉模型也是要把历史上存在的各种专用模型能力全部具备,并且有在往上的两到三层的综合能力才算。也就是这个视觉模型必须具备:

1.物体识别能力:object detector、segment

2.画面描述能力:image caption

3.画面理解能力:VQA、

4.生成能力:生成能力、图片改写能力、图片多样化能力

5.有状态生成能力:图片续生成

如果说要具备上面所有这些能力的视觉大模型,市面上确实是不存在的。但是上面的技术点的专用模型和数据集其实是有不少积累的。那么有没可能像gpt系列模型一样用一个模型把所有的能力收到一个模型里面来呢。

个人觉得是有可能的,gpt之所以能把所有能力收到一个模型,原因有四:

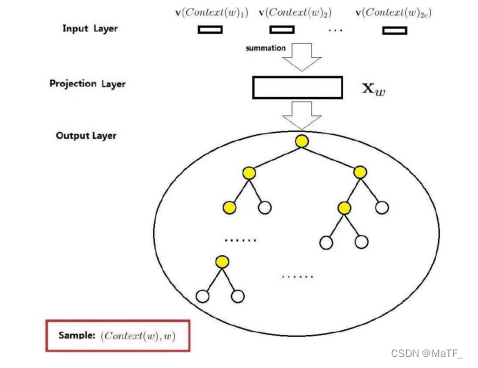

1.把能力做了抽象分层,每层能力通过不同训练方式激活

2.通过prompt方式把所有问题统一到一个上下文的前向生成任务

3.找到一种自监督方式让模型可以提高整体能力

4.在下游任务端,可以通过prompt方式把各种任务,统一在:条件、上下文、生成要求下生成这样统一框架

那么对比gpt,视觉大模型是否也具备把各种能力收口到统一的模型条件,个人觉得是具备的:

1.一样可以做分层:感知理解能力层,根据任务自动适配能力搭配层、适配人类需求的精细调整层

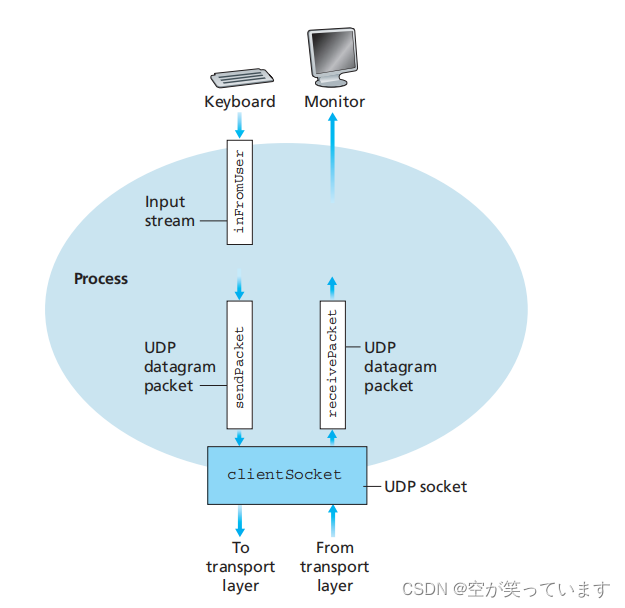

2.把图片当成和图一样的信息输入(无非就是多一些结构信息),通过prompt方式把各种能力收口,输出就是图片的信息组,装成带prompt的生成方式

3.一样可以通过图文、图图、文图抽象成信息,通过自监督方式提高各种能力

4.下游任务也是通过prompt方式把各种任务,来适配到应用

技术点

这部分会给大家介绍下现在模型需要具备的能力,一些论文的做法:

增删改:通过text的方式,来对图里面需要改增删改的地方做修改,这其实是有序列的,需要对输入的图和修改指令做增量预测。

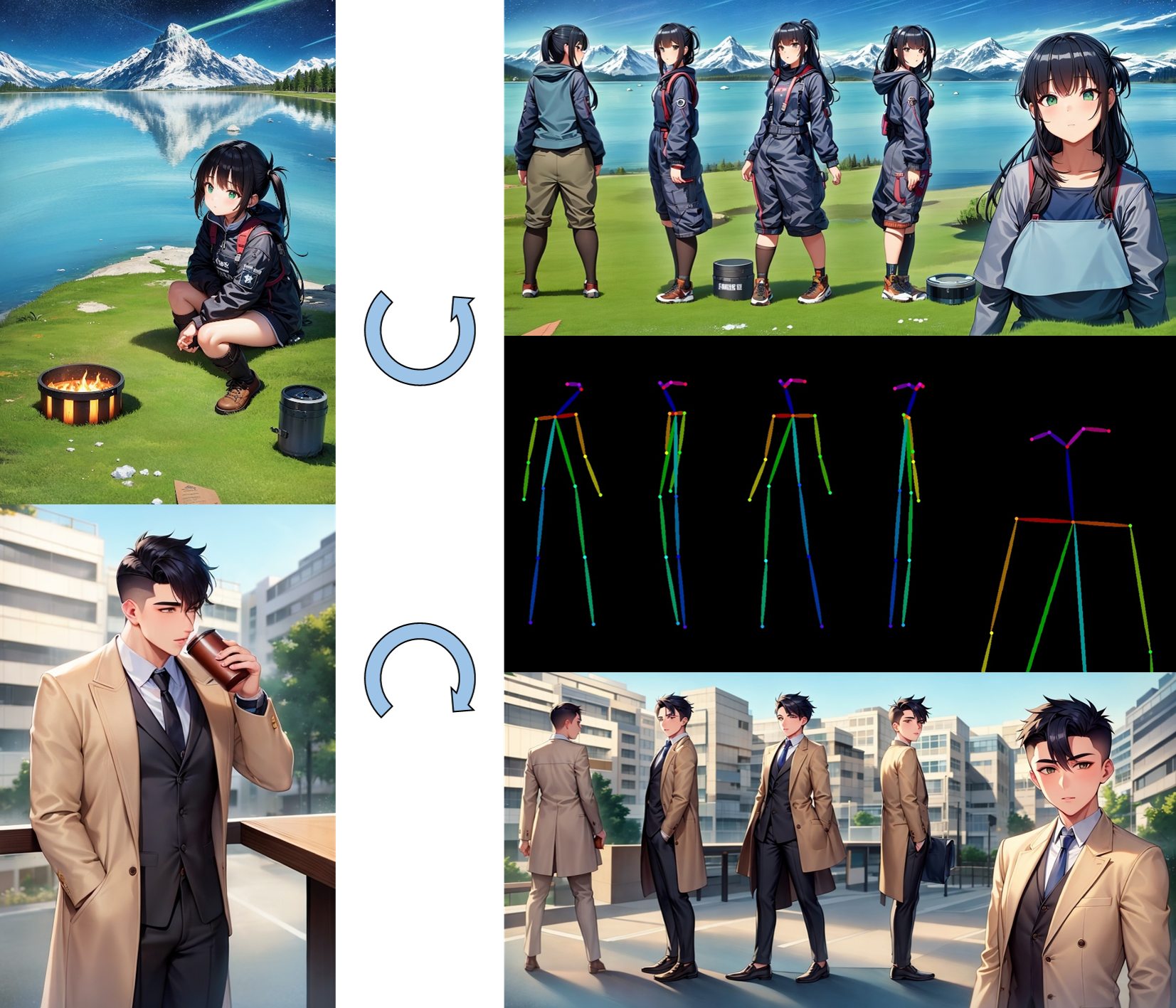

根据输入的图片和控制条件,生成同一角色不同姿势。

通过文字方式控制下一帧动画的增量变化。

模型结构可以如下,只要增加一个上一帧图片作为输入,文本可以通过session方式来写动作变化。训练数据可以来源于:二维动画的作画、每一帧增量变化的动作画面、动作描述语言。

小结

1.从现在视觉模型,结合chatgopt的能力发现现在视模型,缺少一个和chatgpt类似的通用大模型

2.现在的视觉生成模型框架有望把各种视觉能力汇总到一个框架,发展出类似chatgpt的通用大模型

3.展望了通用视觉通用大模型需要具备什么能力

4.展望如何通过生成视觉模型框架来统一各种能力,数据和任务搞如何设置

5.对现在通用大模型能力,特别是有状态的增删改能力做了些论文小结

个人预测真正有通用能力的视觉大模型应该离我们不远了,最快明年年初应该就会出来一个类似模型。试想一下如果模型具备通过文本方式生成图、可以同一个模型用文本方式来做内容增上改,可以通过文本方式来实现内容续生成(也就是可以生成下一帧画面),可以感知画面结构通过文本方式来改变布局。如此可见现在的视觉生成大模型还只是一个专用模型,并非通用大模型。真正视觉大模型出来应该是需要具备有状态的,那么对内容的创作会有质和量的飞跃。