1. 使用chatgpt前提条件

需要特殊的网络环境。如果是小白,不会搭建网络环境,可以关注我私信我,在线帮你搭建网络环境。

2.BAIChat链接

https://chatbot.theb.ai/#/chat/1686535596065

GPT3

研究背景

最近的研究表明,在 pretrain+finetune 模型中,当模型适应了下游任务的训练集后,往往会失去对下游任务的 OOD(out-of-distribution)泛化能力,这种能力也被称为Zero-shot能力。由于训练集不可能涵盖整个真实分布,而且预测数据的分布也随时间变化而变化,因此模型需要具备 OOD 的能力。通过构建 OOD 测试集,并与 IID(Independent Identically Distribution 指训练集和测试集是同分布但是互相独立)上的表现进行比较,进行了一些实验研究:

1. 传统 NN 衰减很大,甚至只有 30%,而 PTM 衰减很小;

2. 更大 size 的 PTM,并不一定表现更好;

3. PTM 使用的训练数据的规模越大、多样性越强,表现越好,这点在ChatGPT的训练集构建中也体现出来了。

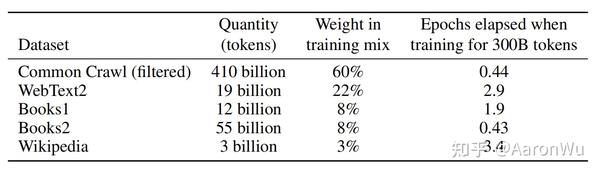

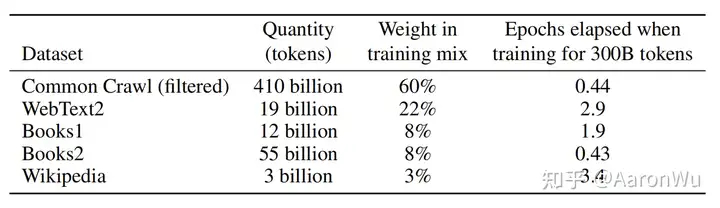

训练数据

GPT-3的训练数据包括低质量的Common Crawl,高质量的WebText2,Books1,Books2和Wikipedia。GPT-3根据数据集的不同的质量赋予了不同的权值,权值越高的在训练的时候越容易抽样到。相比之下,GPT-2的训练数据包括了WebText、BooksCorpus、Stories、Wikipedia和Project Gutenberg等。为了清理脏数据,OpenAI做了以下的数据处理部分:

1. 使用高质量数据作为正例,训练LR分类算法,对 CommonCrawl 的所有文档做初步过滤;

2. 利用公开的算法做文档去重,减少冗余数据;

3. 加入已知的高质量数据集;

其中“高质量数据”主要是指 BERT、GPT、GPT-2 使用过的数据,最终处理完成后使用的数据规模约 570G。

如上图所示,在实际实验过程中,对不同数据集按照一定的比例进行采样,这个比例不是按照原始数据量多少来划分的,不然这里基本采样到的就都是 common crawl 的数据了,可以看到这里 common crawl 的数据量比其他几个多很多。进行采样的原因主要考虑到,就算做了一些数据清洗还是觉得 common crawl 的数据质量不如其他几个。最终采样的时候,虽然 common crawl 的数据量是其他几个数据集的上百倍,但是实际占比是 60%,有 40% 的数据是能够保证质量的。

训练方法

Step1-预训练:

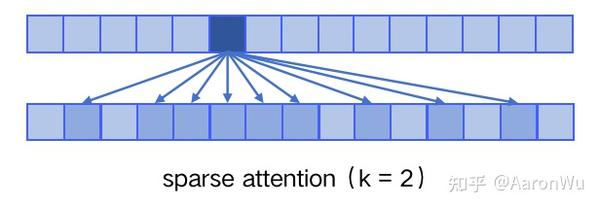

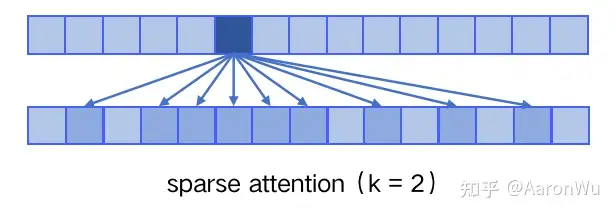

在模型结构上,GPT-3 延续使用 GPT 模型结构,但是引入了 Sparse Transformer 中的 sparse attention 模块(稀疏注意力)。

sparse attention 与传统 self-attention(称为 dense attention) 的区别在于:

dense attention:每个 token 之间两两计算 attention,复杂度 O(n²)。 sparse attention:每个 token 只与其他 token 的一个子集计算 attention,复杂度 O(n*logn)。

具体来说,sparse attention 除了相对距离不超过 k 以及相对距离为 k,2k,3k,... 的 token,其他所有 token 的注意力都设为 0,如下图所示:

我们来具体观察一下,实际上图中的第二行就是涉及到的attention的token内容,可以看出首先关注了附近四个token,其次是2k,3k距离的token,那么为什么这么做呢?使用 sparse attention 的好处主要有以下两点:

1. 减少注意力层的计算复杂度,节约显存和耗时,从而能够处理更长的输入序列;

2. 具有“局部紧密相关和远程稀疏相关”的特性,对于距离较近的上下文关注更多,对于距离较远的上下文关注较少;

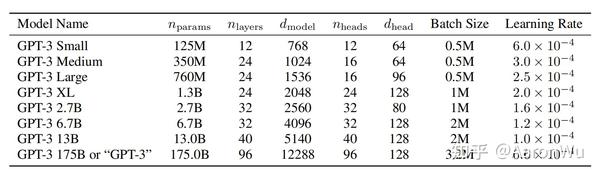

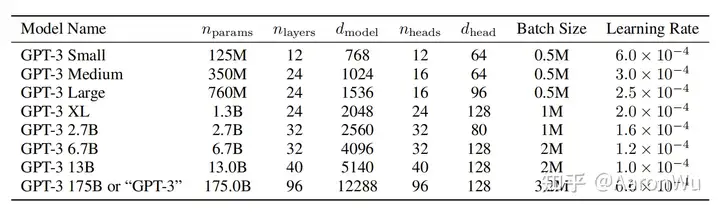

但是批判性的角度来讲,肯定是有缺点的,NLP语言中内容都是有上下文关系的,如此依赖必定会对长文本建模的效果变差。关于 sparse attention 详情可参考《Generating Long Sequences with Sparse Transformers》。最终 GPT-3 在训练过程中得到了如下不同规模的模型:

其中规模最大的模型称为 GPT-3,模型参数量为 1750 亿。

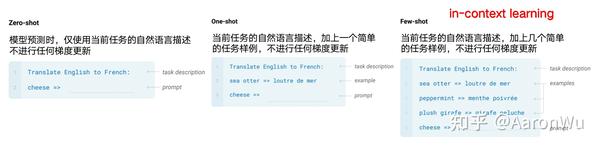

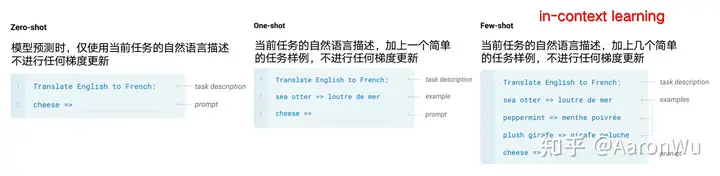

Step2-下游任务:zero-shot/few-shot

GPT-3是一种语言模型,它可以通过少量的样本进行学习,因此被称为“Few-Shot Learner”。和人类一样,GPT-3不需要完全不看任何样例就能学习,只需要看一小部分样例就能学会更多的知识。GPT-3的体量非常庞大,因此在下游任务中进行fine-tune的成本很高。为了解决这个问题,GPT-3使用了“In-Context Learning”的方式,在不进行梯度更新或fine-tune的情况下,直接在上下文中进行学习。

如上图所示,GPT-3 在下游任务的评估与预测时,提供了三种不同的方法:

Zero-shot:仅使用当前任务的自然语言描述,不进行任何梯度更新; One-shot:当前任务的自然语言描述,加上一个简单的输入输出样例,不进行任何梯度更新; Few-shot:当前任务的自然语言描述,加上几个简单的输入输出样例,不进行任何梯度更新;

其中 Few-shot 也被称为 in-context learning,虽然它与 fine-tuning 一样都需要一些有监督标注数据,但是两者的区别是:

1. fine-tuning 基于标注数据对模型参数进行更新,而 in-context learning 使用标注数据时不做任何的梯度回传,模型参数不更新;

2. in-context learning 依赖的数据量(10~100)远远小于 fine-tuning 一般的数据量;

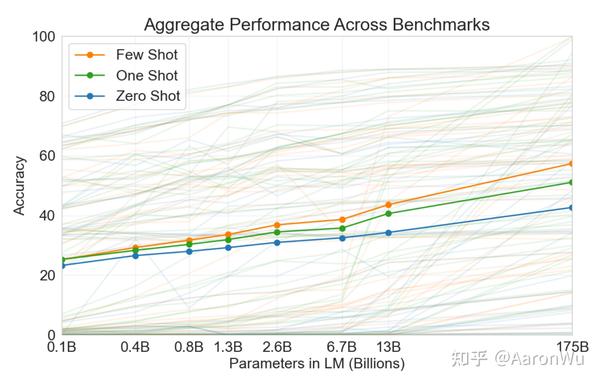

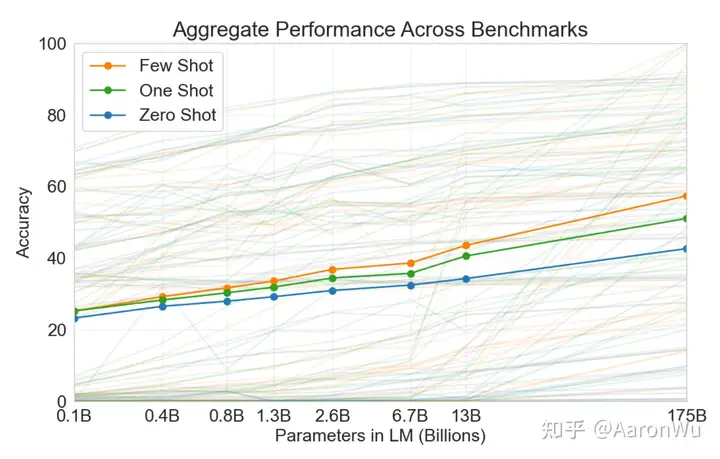

最终通过大量下游任务实验验证,Few-shot 效果最佳,One-shot 效果次之,,Zero-shot 效果最差,这是合乎情理的事情。

上图中,横坐标为模型参数量,纵坐标为任务精度,图中大量灰色线表示不同下游任务,橙色/绿色/蓝色线是下游任务效果的平均值。

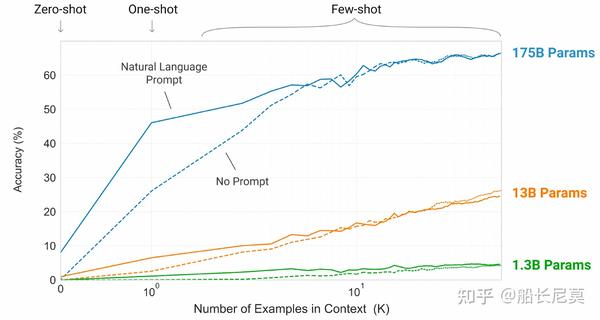

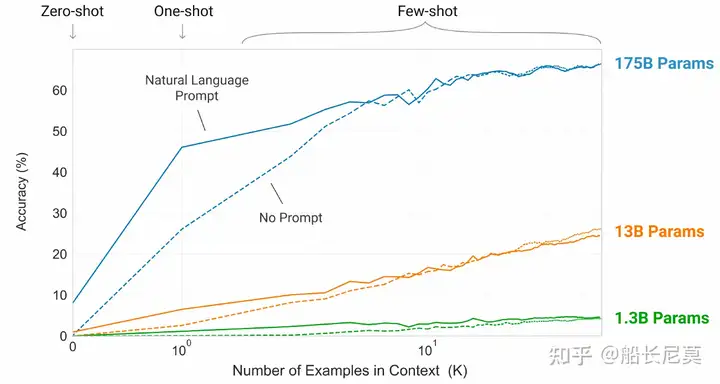

这张图显示了随着测试案例数量的增加,模型大小对最终效果的影响。虚线代表没有使用Prompt(自然语言描述)。可以看到,模型越大,测试案例数量越多,最终效果越好。当测试案例很多时,Prompt变得不那么重要,因为从案例中也可以推断出任务类型。

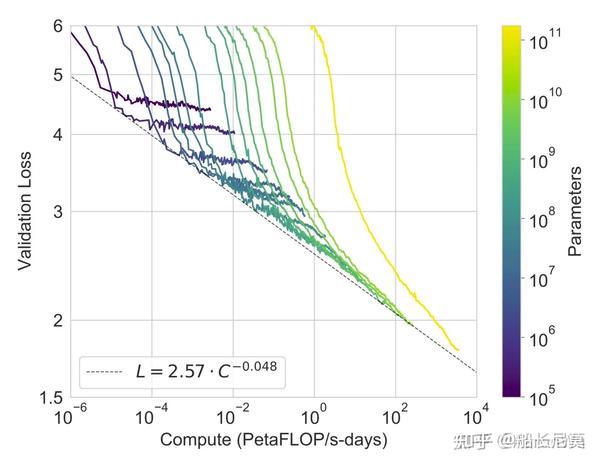

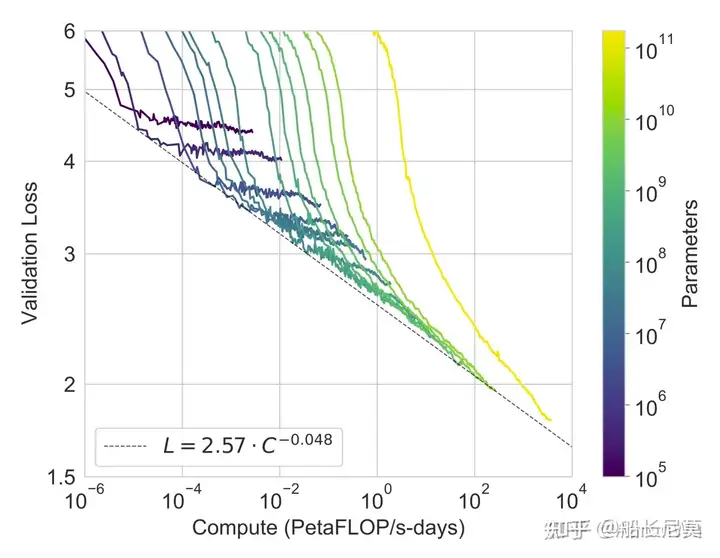

这张图显示了任务精度与计算量(模型规模或数据量)之间的关系。要实现线性提高任务效果,通常需要指数级增加模型规模和数据量。也就是说,为了获得更好的效果,我们需要投入更多的计算资源和数据量。

GPT-3虽然很强悍,但是仍旧有局限性:

1)数据量和参数量的骤增并没有带来智能的体感。从参数量上看,从GPT2 1.5B到GPT3 175B约116倍参数量的增加,从数据量上看,GPT2 40G到GPT3 570G近15倍训练数据增加,带来的“更”智能,或者简单点说“更few/zero-shot”的能力。

2)GPT-3的训练数据是从互联网上爬取的,因此可能存在一些错误或不准确的数据。

3)GPT-3在处理某些任务时可能会出现错误或不准确的结果,以及不合理或不合逻辑的结果。

GPT3.5 (Instruct GPT)

GPT-3纵然很强大,但是对于人类的指令理解的不是很好,这也就延伸出了GPT3.5诞生的思路。在做下游的任务时,我们发现GPT-3有很强大的能力,但是只要人类说的话不属于GPT-3的范式,他几乎无法理解。例如,我们说把句子A变成句子B,这种到底是机器翻译呢,还是同语言的转述,都需要让GPT-3学习到才是可以的。

ChatGPT 是基于 GPT3.5 的基础模型框架,核心变化在于通过真实的调用数据以及人类反馈的强化学习进行训练。ChatGPT3.5 主要用于自然语言处理、机器翻译等任务,而 ChatGPT3.5-Turbo 拥有更强大的强度,可用于更复杂的语言分析,比如情感分析、语法结构分析。所以,ChatGPT 和 GPT3.5 是同一系列的产品,但 ChatGPT 是在 GPT3.5 的基础上进行了改进和优化。

InstructGPT采用基于人类反馈的强化学习(RLHF)来不断微调预训练语言模型(LLM),旨在让模型能够更好地理解人类的命令和指令含义,如生成小作文、回答知识问题和进行头脑风暴等。该方法不仅让模型学会判断哪些答案是优质的,而且可以确保生成的答案富含信息、内容丰富、对用户有帮助、无害和不包含歧视信息等多种标准。因此,RLHF是一种有效的方法,可以帮助LLM不断提升性能和适应各种用户需求。

关于 InstructGPT 的技术方案,原文分为了三个步骤:有监督微调,奖励模型训练,强化学习训练;实际上可以把它拆分成两种技术方案,一个是有监督微调(SFT),一个是基于人类反馈的强化学习(RLHF),下面我们简单介绍下。

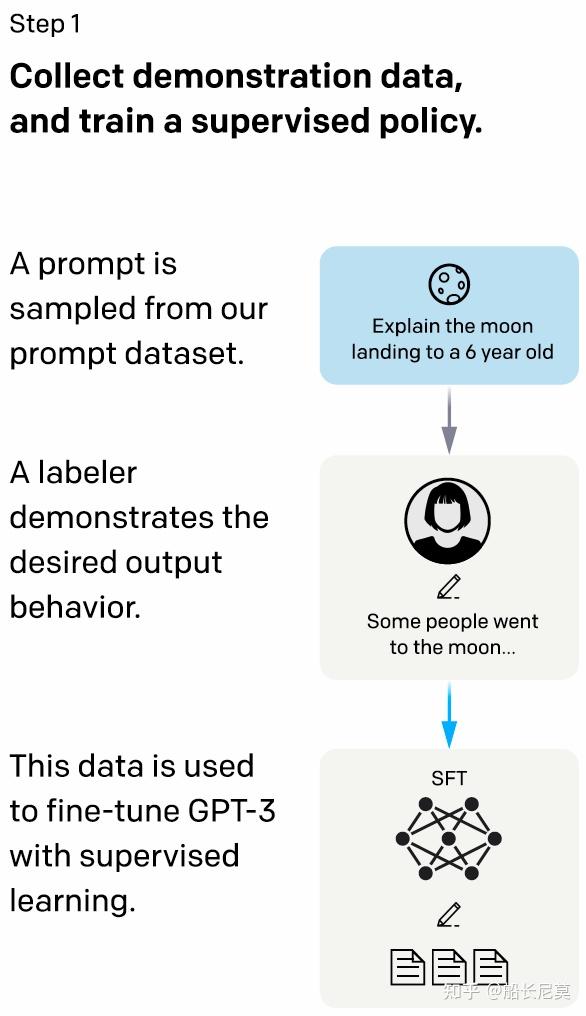

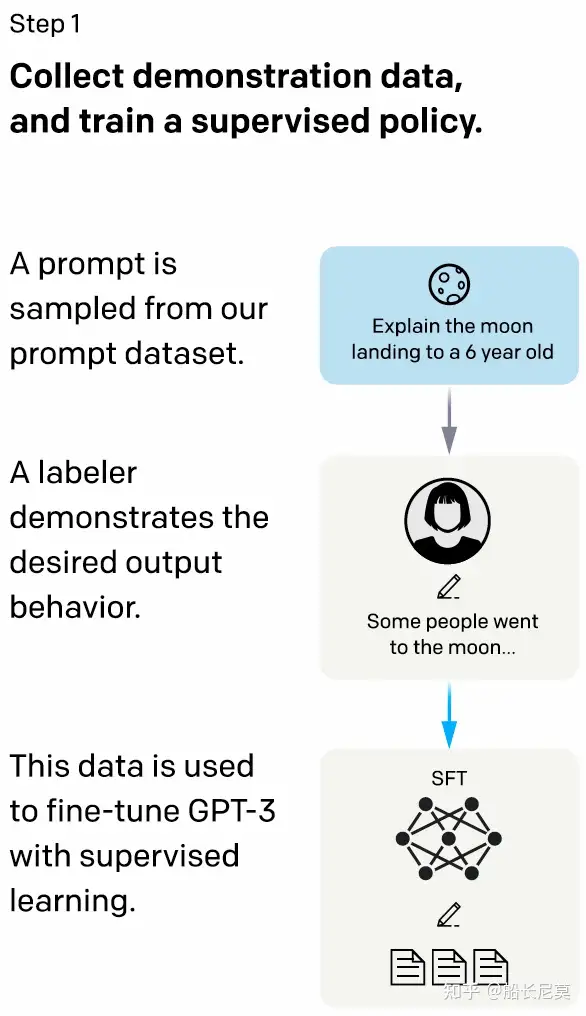

Step1 监督策略模型 (SFT supervised fine-tuning)

尽管GPT-3具有强大的语言处理能力,但它很难理解人类不同类型指令中蕴含的不同意图,并且很难判断生成内容是否是高质量的结果。为了解决这个问题,采取了以下步骤:首先,从测试用户提交的 prompt 中随机抽取一批,然后请专业的标注人员为这些 prompt 给出高质量答案。接下来,我们使用这些<prompt,answer>数据来Fine-tune GPT-3模型,以使其初步具备理解人类prompt中所包含意图,并根据这个意图给出相对高质量回答的能力。这一步骤中包含了1.2万条训练数据。虽然这个过程是有效的,但显然这还不足以解决所有问题。

在这里使用余弦学习率衰减和残差 dropout 为0.2进行了16个epoch的训练。根据验证集上的RM分数进行最终的SFT模型选择。论文发现SFT模型在第1个epoch后会出现过拟合情况,然而,后来实验发现训练更多的epoch会提高RM分数和人类偏好评分,尽管会出现这种过拟合情况。所以看来过拟合即使出现也不影响最终的学习结果。

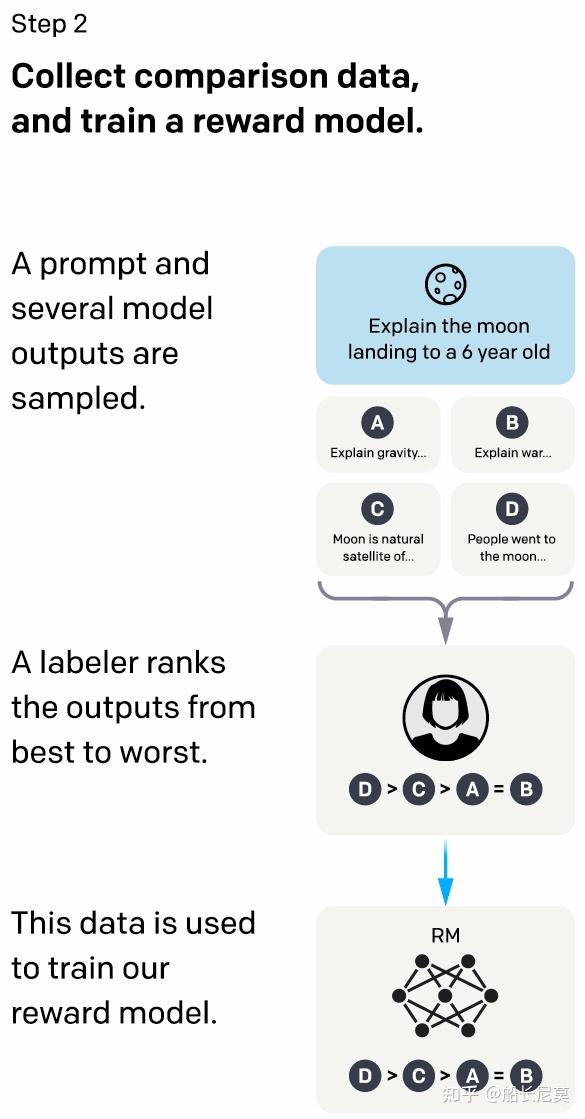

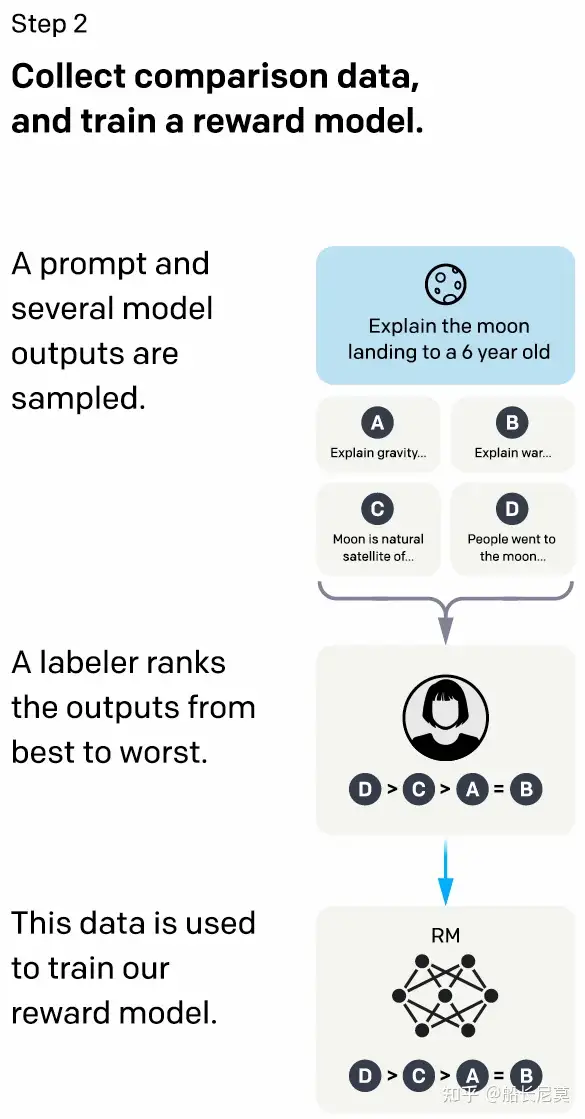

Step2 训练回报模型(Reward Model,RM)

在这个阶段,论文中的研究者的主要目的是通过人工标注训练数据来训练回报模型。对用户提交的prompt进行随机抽样,并使用第一阶段Fine-tune好的冷启动模型,生成K个不同的回答,形成<prompt,answer1>,<prompt,answer2>….<prompt,answerK>数据。然后,标注人员根据相关性、信息性和有害信息等标准,对K个结果进行排序,生成排序结果数据。接下来,研究者使用这个排序结果数据进行pair-wise learning to rank训练模式,训练回报模型。RM模型接受一个输入<prompt,answer>,给出评价回答质量高低的回报分数Score。对于一对训练数据<answer1,answer2>,假设人工排序中answer1排在answer2前面,那么Loss函数则鼓励RM模型对<prompt,answer1>的打分要比<prompt,answer2>的打分要高。

实际上船长在这里插一嘴,GPT3.5的RM标注数据,会使用到一些硬性的,主观性不是那么强的指标,例如是否回答问题,是否为低俗色情等等,但是不会完全依赖于这些指标,为什么呢?因为人类的标注都是有很强主观性的,有的人认为是好的答案,有的人就是认为不好,所以并不能通过分数来衡量。那怎么办呢?所以才提出了排名的方式,排名越靠前的越好,这就相当于默认考虑了这些潜在因素。

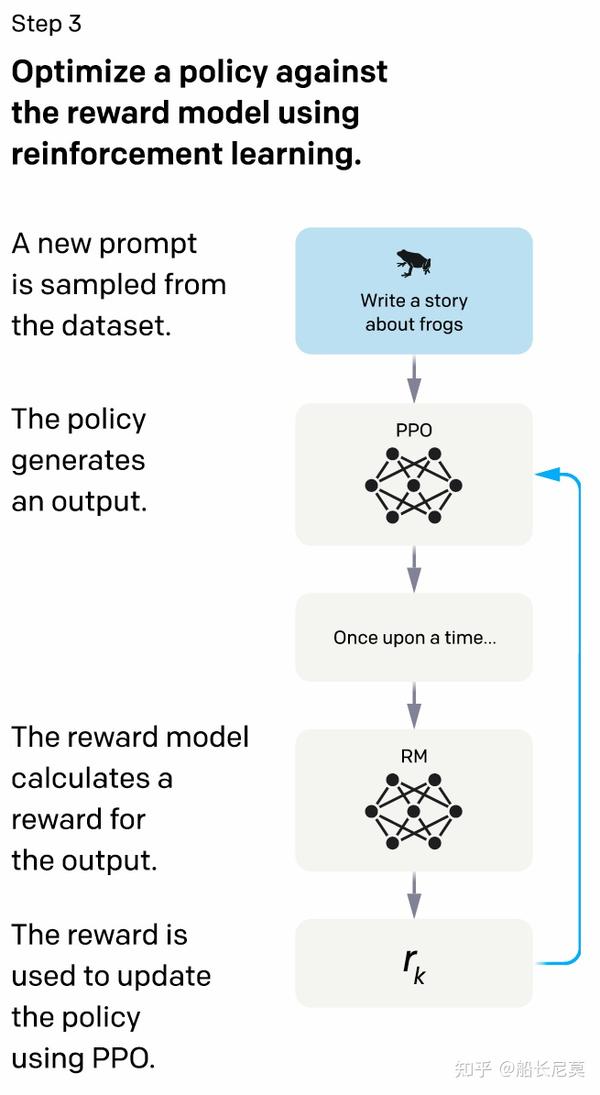

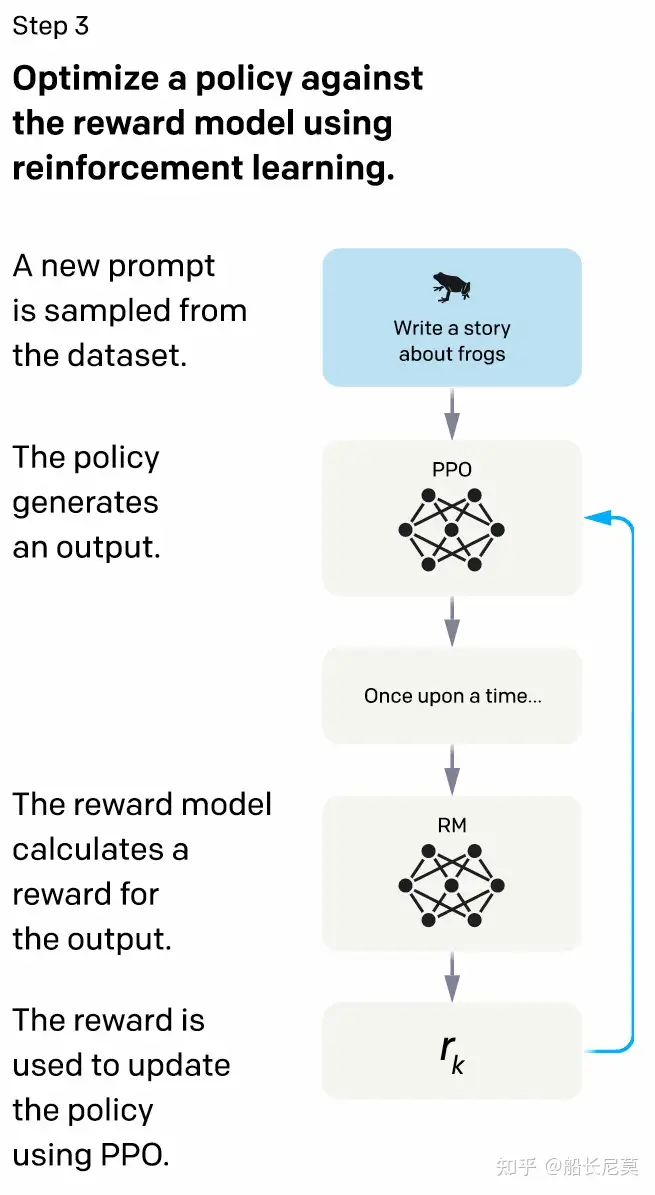

Step3-强化学习来增强预训练模型

在这个阶段,研究者不需要人工标注数据,而是利用之前学习好的RM模型,通过PPO强化学习来更新预训练模型参数。从用户提交的命令中,随机选择一些新的命令,让PPO模型来生成回答。接着,用RM模型对这些回答进行评估,并给出一个分数作为回报。研究者的目标是训练LLM模型生成的答案能够获得高分数,也就是符合RM标准的高质量回答。最后,根据得到的回报分数来更新PPO模型的参数,以便让LLM模型生成更好的回答。

其实上面说的也是比较笼统的,大致意思是需要强化学习,还有奖励函数来更新语言模型,这么做的原因纯粹是为了让模型知道用户的指令。下面我们来详细的讨论下:

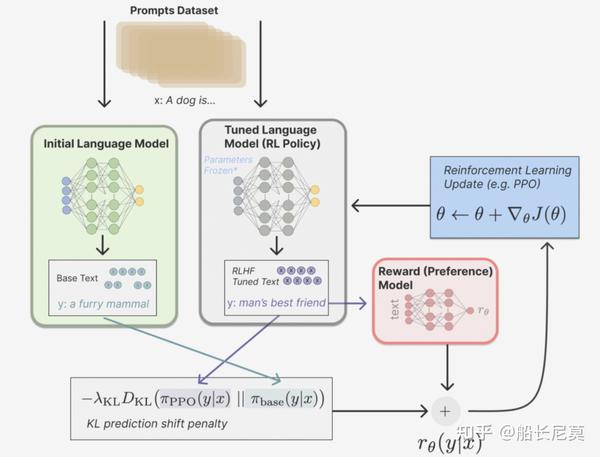

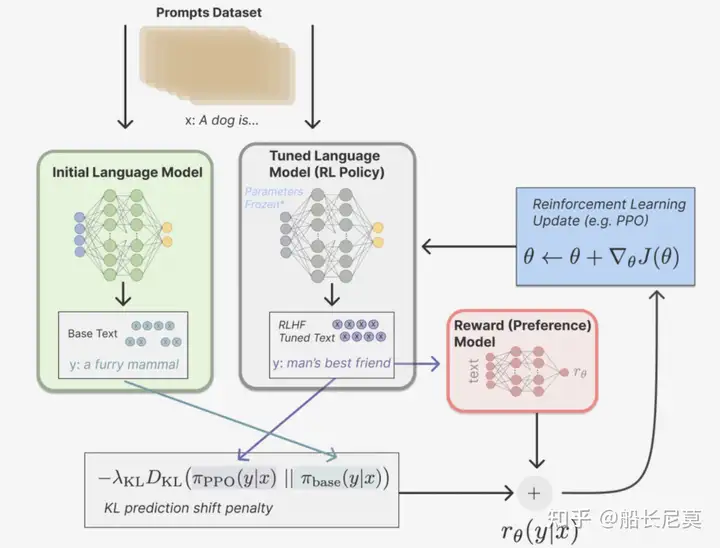

既然是强化学习,那么我们势必需要强化学习的三要素:策略(policy)、动作空间(action space)和奖励函数(reward function)等基本要素。

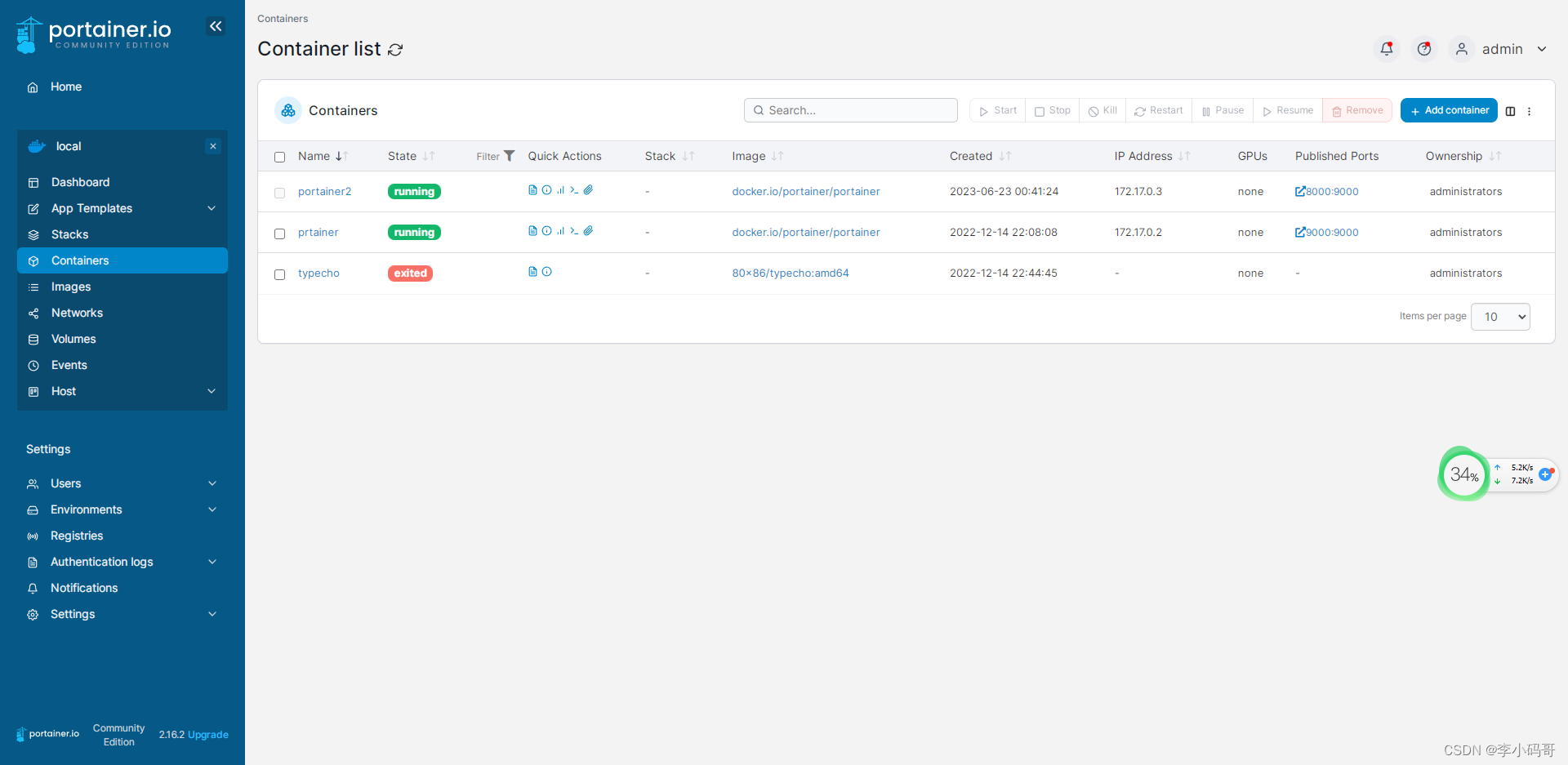

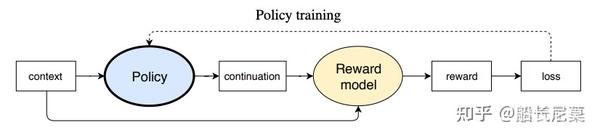

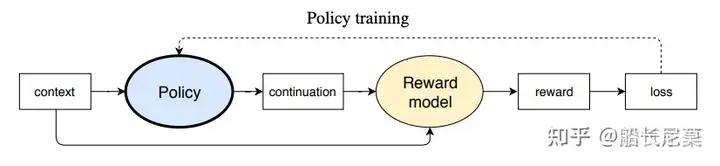

显然,策略就是基于该语言模型,接收 prompt 作为输入,然后输出一系列文本(或文本的概率分布);而动作空间就是词表所有 token 在所有输出位置的排列组合(单个位置通常有50k左右的token候选);观察空间则是可能的输入token序列(即prompt),显然也相当大,为词表所有token在所有输入位置的排列组合;而奖励函数(reward)则是基于训好的RM模型计算得到初始reward,再叠加上一个约束项来。整个过程如下图所示:

那么具体来说,是如何根据PPO来进行网络更新呢?实际上核心在于新旧两个网络,通过不断拉大新旧两个网络的距离,来让最终的新网络越好。下面是通俗易懂的操作步骤:

1. 定义“旧”的策略和“新”的策略。这两个策略都是我们用来指导智能体行动的指南。

2. 通过与环境交互,我们可以收集到从当前状态开始采取不同动作所得到的奖励,并计算每个动作的概率比例、价值函数以及优势函数等。这些都是用于评估策略表现的指标。

3. 接着,我们会计算新旧策略之间的差异,并使用一个剪切函数来约束更新幅度,以最大程度地提高未来预期回报。

4. 将该变化量应用于模型参数中,以更新模型并改进策略。

5. 重复上述步骤多次,直到模型收敛为止。

举个例子,假设我们正在训练一个自主驾驶汽车,希望它能够在城市道路上安全地行驶。我们可以使用PPO算法来训练它,让它从当前位置出发,不断采取不同的驾驶决策(如加速、刹车、转弯等),并根据所得到的奖励来调整模型参数。通过重复这个过程,我们可以逐渐改进模型,让自主驾驶汽车学会更好地行驶。

那么问题来了,为什么使用PPO方法来更新GPT3呢?实际上是因为有限的Prompt导致的,我们不能够训练无限多的Prompt,类似于强化学习中无限的环境,所以只能够通过新旧模型预测的差别来进行学习速度上的提升。那么PPO究竟如何应用在GPT-3中呢?

从上图中可以看到,base模型是绿色的,RL Policy是灰色的,他们两个都会根据同样的Prompt来输出不同的结果,而接下来就是把两个模型的Reward分数拉的尽可能的大,使得两个的差别越大越好,所以在下面的公式当中,利用了KL DIvergence来衡量两个模型之间分布的差异。而之后,这个分数会用来更新RL 模型,也即是GPT-3,所以RLHF的核心就是利用强化学习的思路来更新GPT的网络。

如果研究者一直重复第二和第三步骤,那么每一轮迭代过后,LLM模型的能力都会变得更强。这是因为第二步骤使用人工标注数据来提高RM模型的能力,第三步骤则利用增强的RM模型对新问题的答案作出更准确的评分,并使用强化学习来鼓励LLM模型学习新的高质量内容。这就像是使用伪标签来扩充高质量训练数据一样,进一步增强了LLM模型的能力。显然,第二和第三步骤相互促进,这就是为什么不断迭代会有持续增强效果的原因。

训练数据

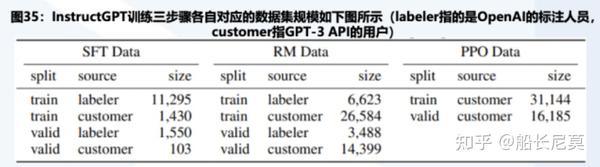

接下来的问题是,如果应用如此多的方法,那强化学习所需要的训练数据是多少呢?实际上很少,只有几万的规模,详细的数据如下图所示: