目录

1.计算概率

2.损失和正则化

2.1 逻辑回归的损失函数

2.2 逻辑回归中的正则化

3.参考文献

1.计算概率

许多问题需要概率估计作为输出。逻辑回归是一种极其有效的概率计算机制。实际上,我们可以通过以下两种方式使用返回的概率:

- 原始概率:不经转换的原始计算结果

- 二元类别:将原始计算结果转换为二元类别

那么,如何 “按原样” 使用概率?假设我们创建一个 逻辑回归(Logistic Regression)模型来预测狗在半夜吠叫的概率。我们称这个概率为:

如果逻辑回归模型预测 ,那么在一年多的时间里,狗的主人应该被惊醒大约 18 次:

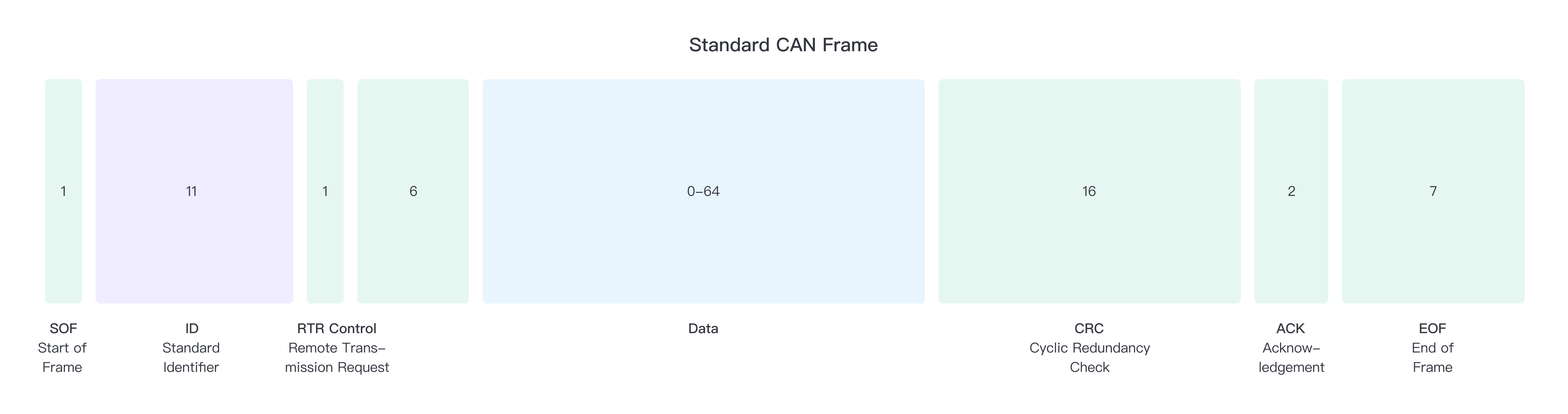

在许多情况下,我们倾向于将逻辑回归输出映射到二元分类问题的解决方案中,其中的目标是正确预测两个可能的标签之一(例如 “垃圾邮件” 或 “非垃圾邮件”)。那么,逻辑回归模型如何确保输出始终落在 0 和 1 之间呢?这就需要特殊的函数来辅助了,如下的 sigmoid 函数会产生具有相同特征的输出:

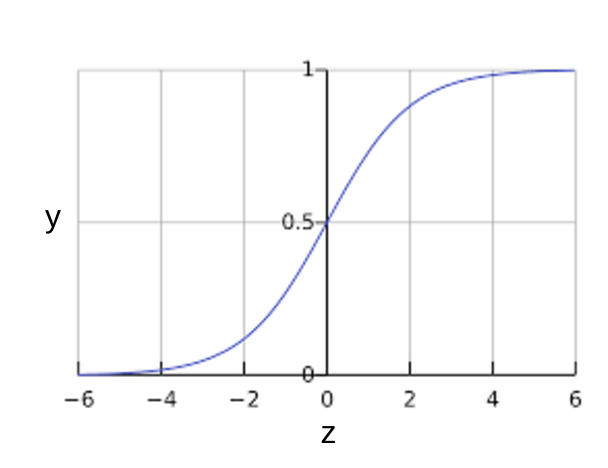

sigmoid 函数产生以下图:

图 1:S 型函数

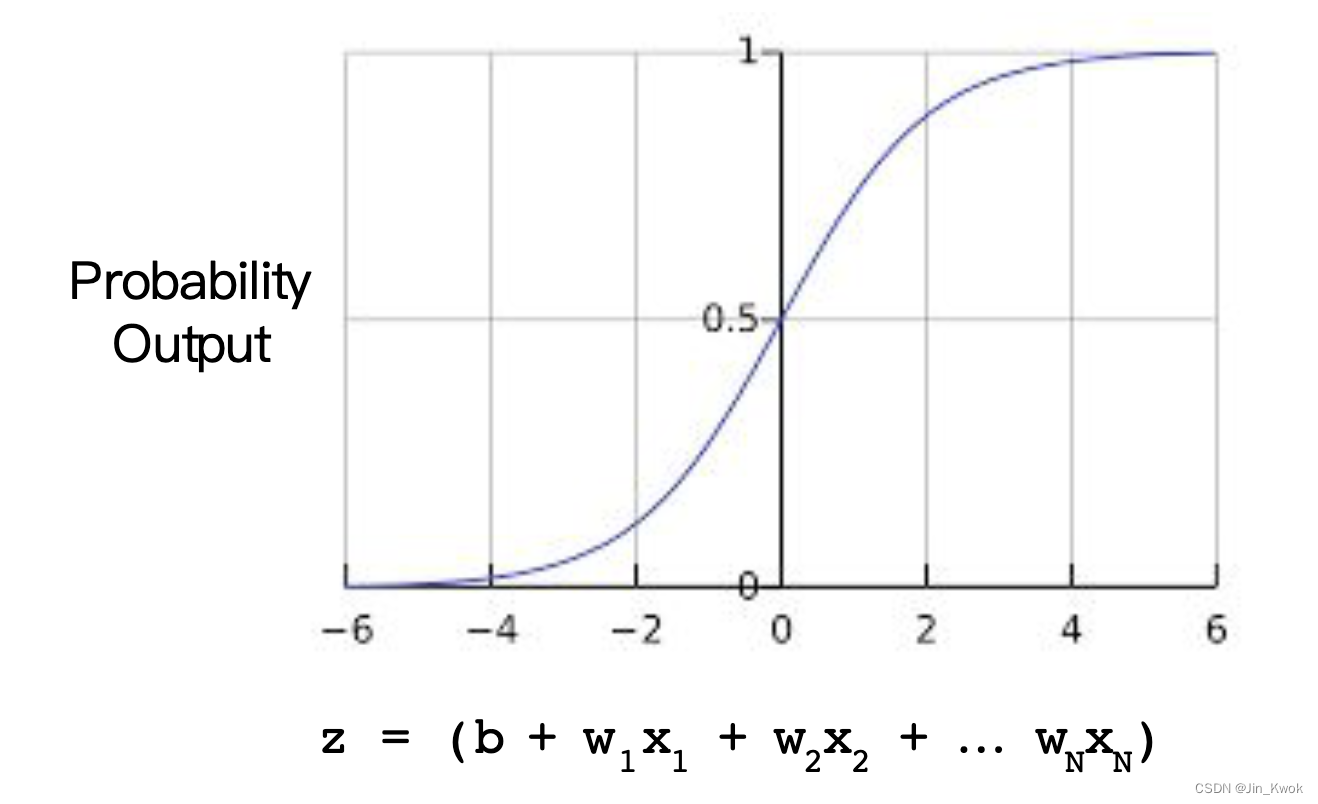

如果 表示用逻辑回归训练的模型的线性层的输出,然后

将产生一个介于 0 和 1 之间的值(概率)。用数学术语来说:

其中,

是特定示例的逻辑回归模型的输出。

-

值是模型的学习权重,并且

是偏差。

值是特定示例的特征值。

-

注意: 也称为对数概率,因为 sigmoid 的倒数表明,

可以定义为概率的对数:

这是带有 ML 标签的 sigmoid 函数:

图 2:逻辑回归输出

2.损失和正则化

2.1 逻辑回归的损失函数

线性回归的损失函数是平方损失。逻辑回归的损失函数是对数损失:Log Loss,其定义如下:

上述公式中,

是包含许多标记示例的数据集,这些示例是

对。

是带标签示例中的标签。由于这是逻辑回归,因此每个

值必须为 0 或 1。

是预测值(介于 0 和 1 之间),给定特征集

。

2.2 逻辑回归中的正则化

正则化 在逻辑回归建模中极其重要。如果没有正则化,逻辑回归的渐近性质会将高维损失推向 0。因此,大多数逻辑回归模型使用以下两种策略之一来降低模型复杂性:

正则化。

- 提前停止,即限制训练步骤数或学习率。

在后面的文章中,笔者将介绍第三种策略—— 正则化 。想象一下,为每个示例分配一个唯一的 id,并将每个 id 映射到其自己的特征。如果不指定正则化函数,模型将完全过拟合。这是因为该模型会尝试将所有示例的损失推至零,但永远无法实现这一目标,从而将每个指标特征的权重推向+无穷大或-无穷大。这种情况可能发生在具有特征交叉的高维数据中,当存在大量罕见交叉且每个交叉仅发生在一个示例上时。幸运的是,使用

或提前停止训练可以避免这个问题。

概括

- 逻辑回归模型生成概率。

- 对数损失是逻辑回归的损失函数。

- 逻辑回归被许多从业者广泛使用。

3.参考文献

链接-https://developers.google.cn/machine-learning/crash-course/logistic-regression/model-training