Lora 和 AdaLora的区别和联系?

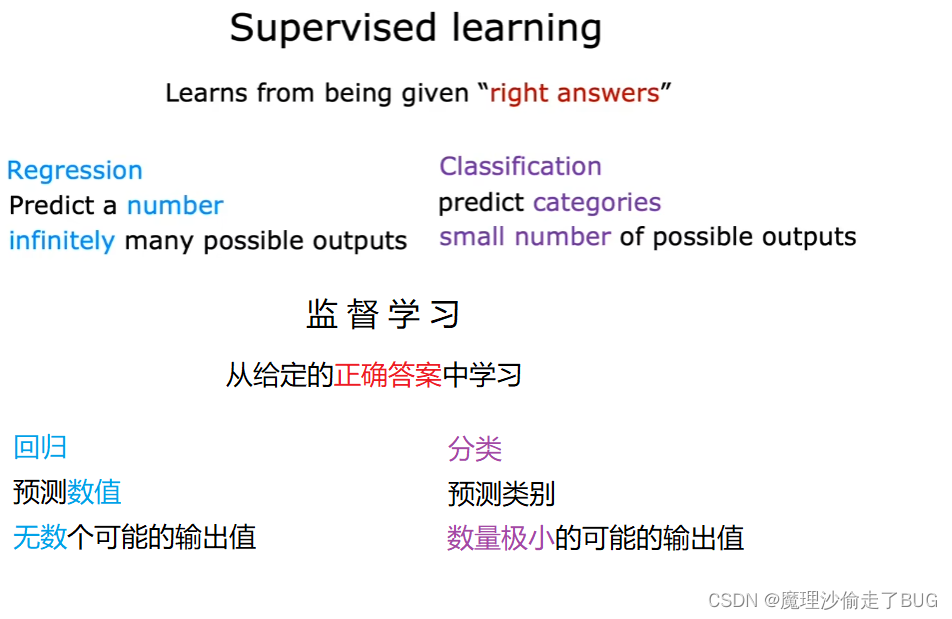

P-tuning和Prompt tuning的区别和联系?

P-Tuning,仅对大模型的Embedding加入新的参数。

P-Tuning-V2,将大模型的Embedding和每一层前都加上新的参数。

Prompt Tuning 方式可以看做是 Prefix Tuning 的简化,固定整个预训练模型参数,只允许将每个下游任务的额外 k 个可更新的 tokens (作为template的tokens)前置到输入文本中,也没有使用额外的编码层或任务特定的输出层。

原文链接:https://zhuanlan.zhihu.com/p/621700272

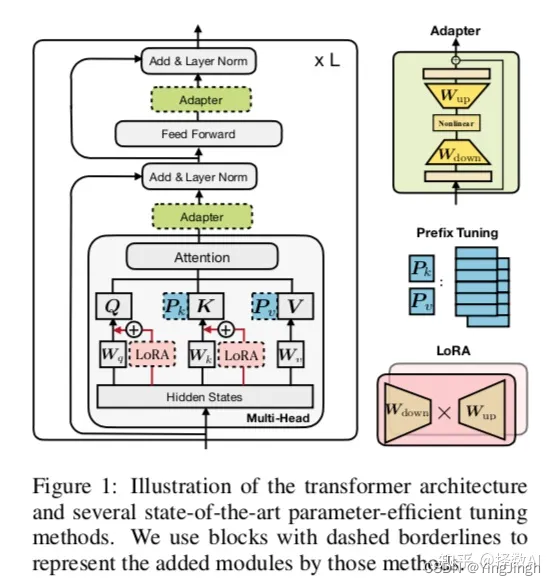

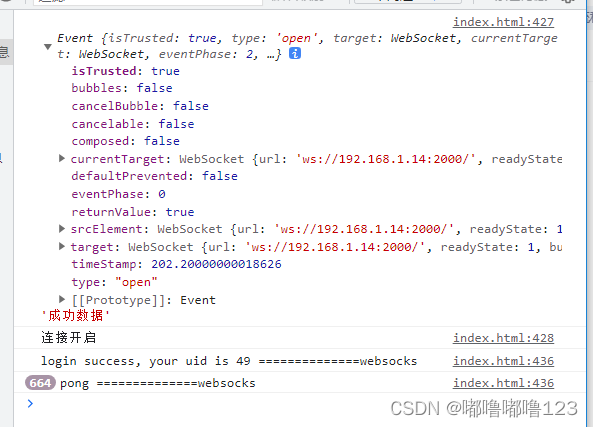

不同参数高效微调的模块在transformer中的位置: