什么是ChatGLM-6B

ChatGLM-6B 是一个开源的、支持中英双语的对话语言模型,基于 General Language Model (GLM) 架构,具有 62 亿参数。结合模型量化技术,用户可以在消费级的显卡上进行本地部署(INT4 量化级别下最低只需 6GB 显存)。 ChatGLM-6B 使用了和 ChatGPT 相似的技术,针对中文问答和对话进行了优化。经过约 1T 标识符的中英双语训练,辅以监督微调、反馈自助、人类反馈强化学习等技术的加持,62 亿参数的 ChatGLM-6B 已经能生成相当符合人类偏好的回答。

ChatGLM-6B安装

环境准备:python

如果需要在 cpu 上运行量化后的模型,还需要安装 gcc 与 openmp。多数 Linux 发行版默认已安装。对于 Windows ,可在安装 TDM-GCC 时勾选 openmp。 Windows 测试环境 gcc 版本为 TDM-GCC 10.3.0, Linux 为 gcc 11.3.0

1.Torch安装

1)torch测试执行下面代码

# cuda支持检查

import torch

print(torch.cuda.is_available())

显示 False 说明驱动还没好

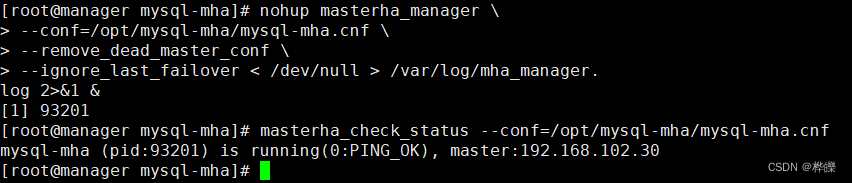

2)检查安装适合自己的cuda

在NVIDIA控制面板中点击 帮助-》系统信息 查看自己的CUDA适配版本

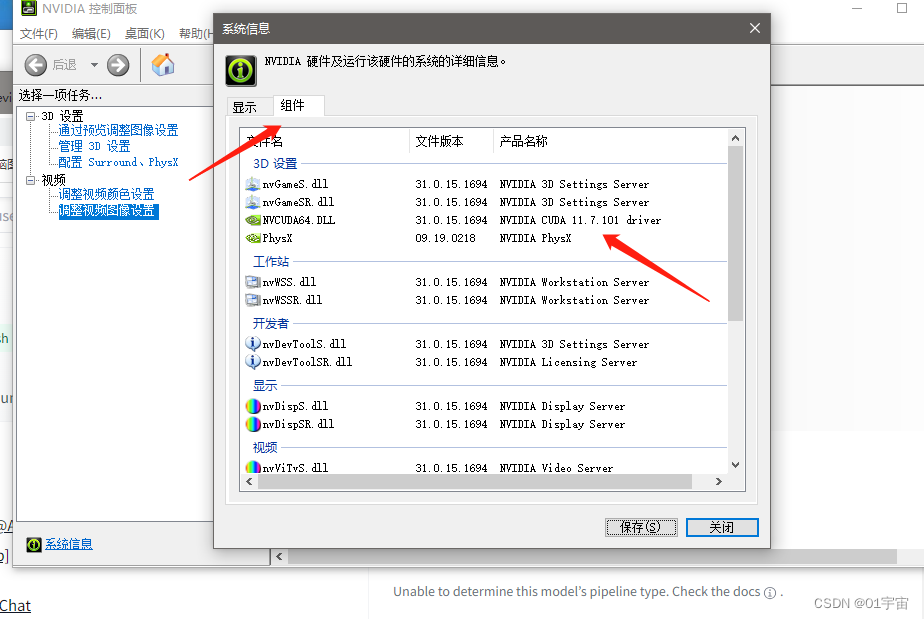

CUDA下载安装(注:CUDA版本可以向下兼容,选择大于11.7的版本) https://developer.nvidia.com/cuda-toolkit-archive

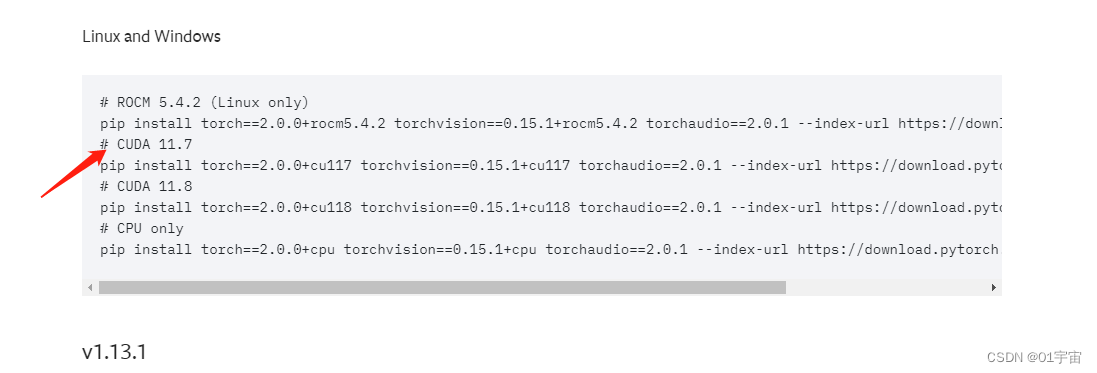

CUDA下载安装完成后 进入网站 https://pytorch.org/get-started/previous-versions/ 选择适配自己的torch安装,我这里是11.7所以我选择CUDA 11.7的命令执行

# CUDA 11.7

pip install torch==2.0.0+cu117 torchvision==0.15.1+cu117 torchaudio==2.0.1 --index-url https://download.pytorch.org/whl/cu117

注意:

pip 安装自行选择本地还是虚拟环境

#创建虚拟环境

python -m venv venv

#liunx下进入虚拟环境

source venv/bin/activate

#windows下进入虚拟环境

venv\Scripts\activate

2.ChatGLM-6B模型安装

1)将 ChatGLM-6B 项目克隆到本地 https://github.com/THUDM/ChatGLM-6B

git clone https://github.com/THUDM/ChatGLM-6B.git

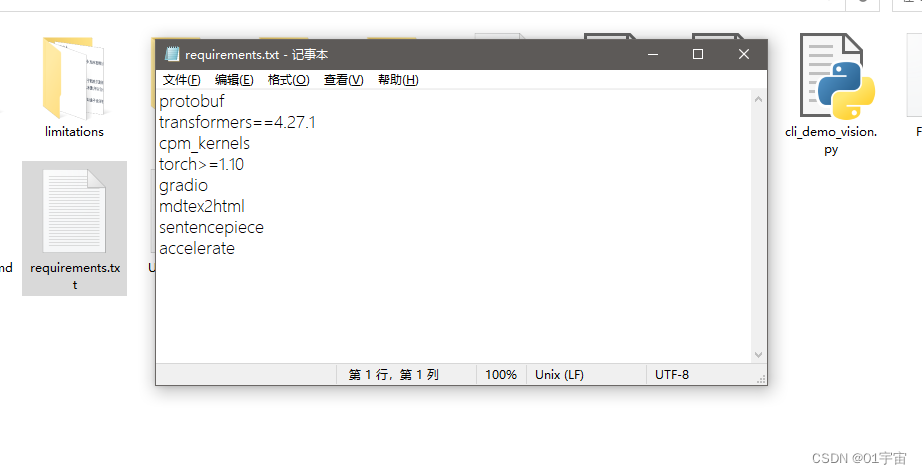

2)安装依赖

进入到项目目录执行命令:

pip install -r requirements.txt

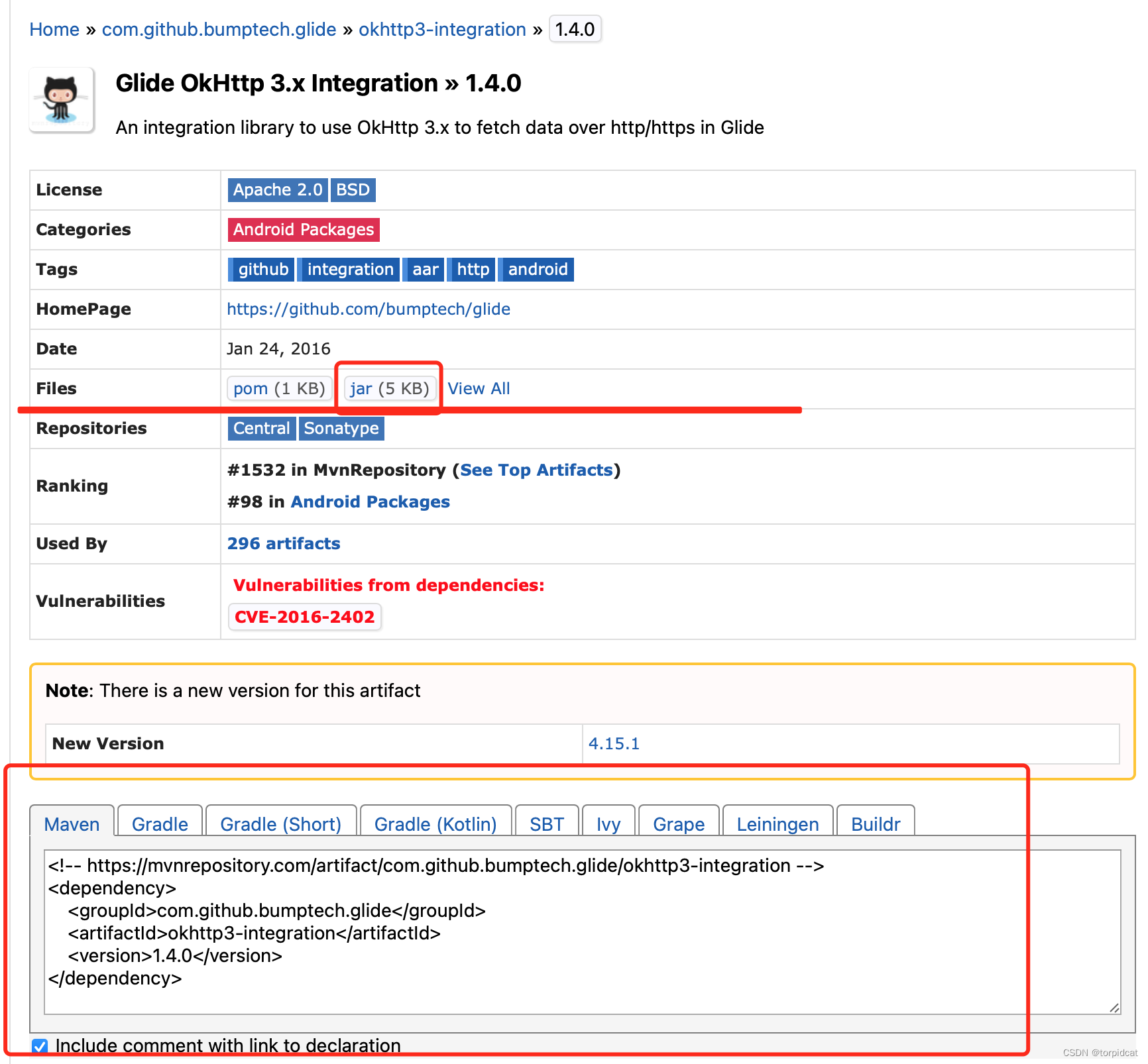

可以查看项目中的 requirements.txt 是所需要的依赖,其中 transformers 库版本推荐为 4.27.1,但理论上不低于 4.23.1 即可。

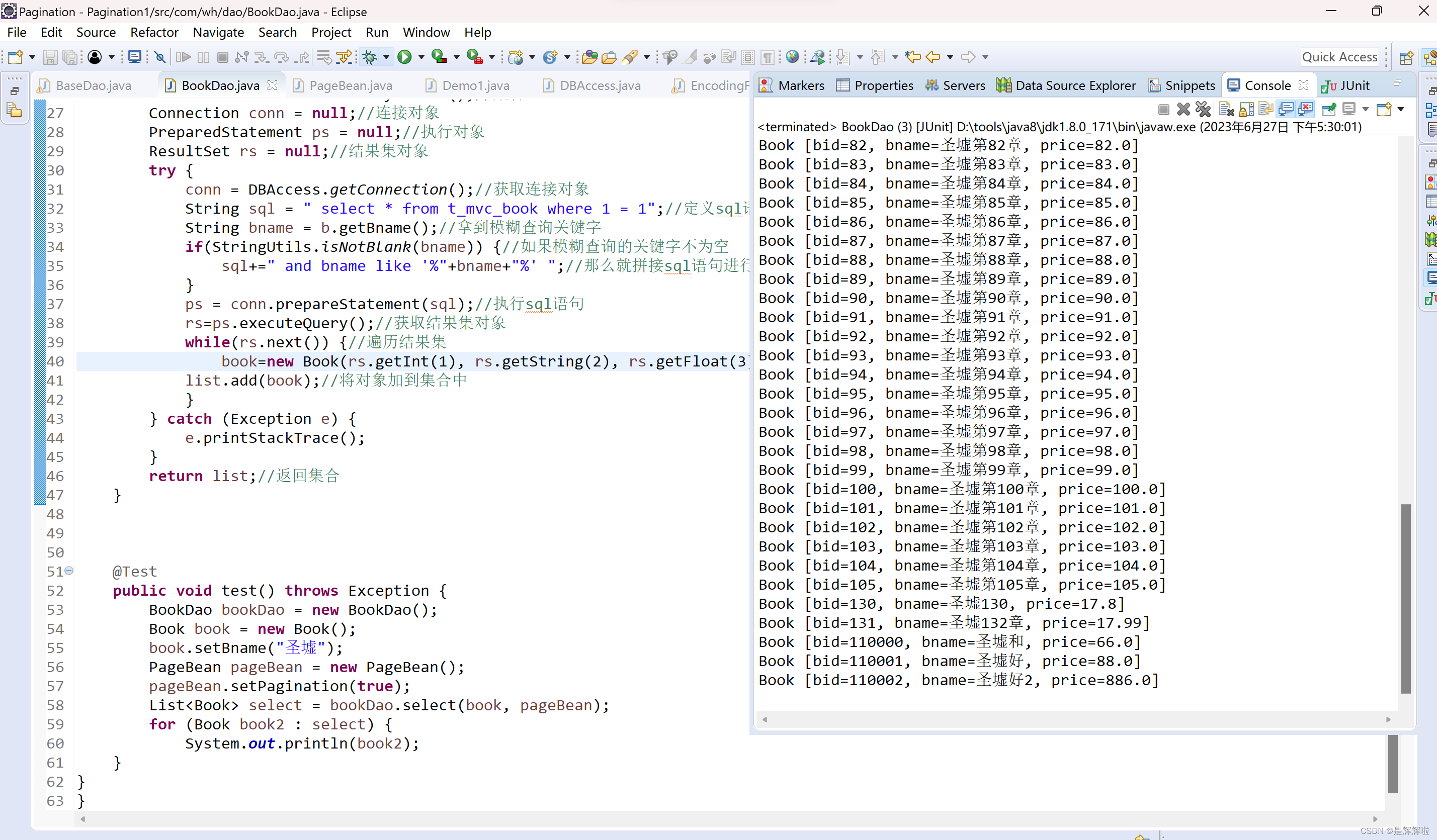

3) 从本地加载模型

从 Hugging Face Hub 下载模型需要先安装Git LFS https://docs.github.com/zh/repositories/working-with-files/managing-large-files/installing-git-large-file-storage,然后运行

git clone https://huggingface.co/THUDM/chatglm-6b

如果你从 Hugging Face Hub 上下载 checkpoint 的速度较慢,可以只下载模型实现

GIT_LFS_SKIP_SMUDGE=1 git clone https://huggingface.co/THUDM/chatglm-6b

然后从这里手动下载模型参数文件,并将下载的文件放到任意路劲下或者替换 THUDM/chatglm-6b 目录下。

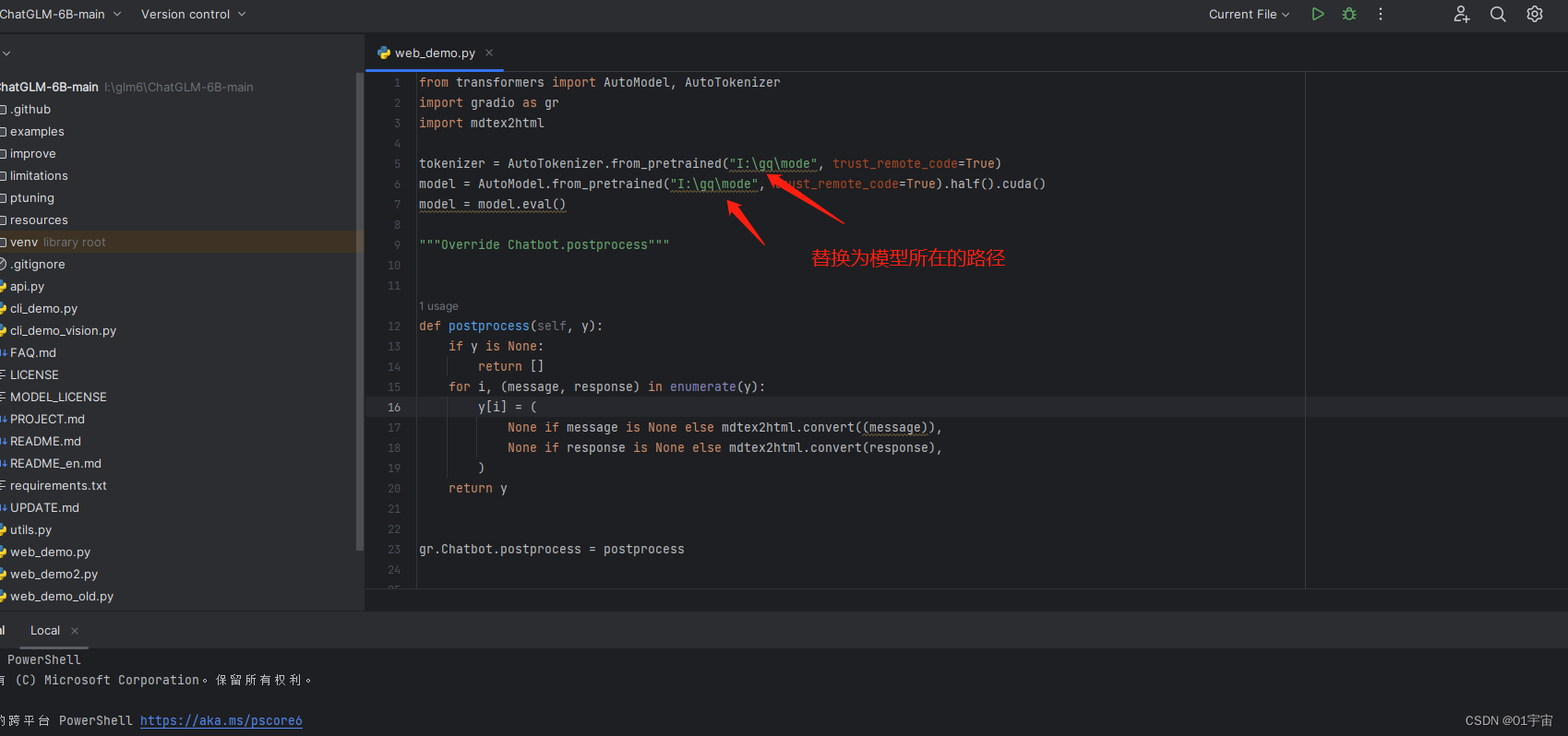

2.Demo测试

在 requirements.txt 中已经安装好 gradio,我们只需要替换模型路径

运行web_demo.py

运行成功后会出现访问地址,访问即可!