如何计算:autograd包根据tensor进行过的数学运算来自动计算梯度

注意:1:autograd实现的。2:对tensor进行计算梯度。

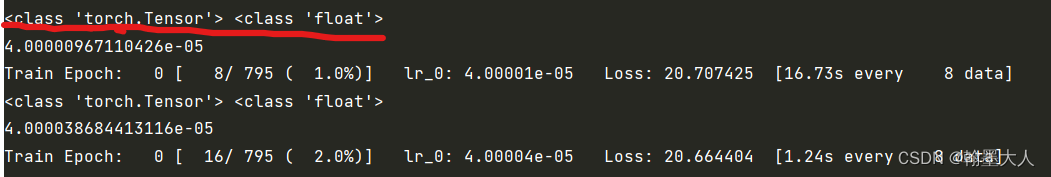

之前损失计算:分割损失和边界损失计算正常。

踩坑1:模型有两个损失,分别为分割损失和边界损失,在loss function计算损失值。然后将损失值相加进行反向传播。其中分割损失采用了深监督,需要计算五次。之前的代码采用的append将所有损失放在一个列表中,通过sum相加,搜了一下,网上说append会不断地增加内存的消耗。因此推荐使用loss += loss.item().

问题就出现在这里:然后train就开始报错:

‘‘float has no attribution of backward’’。继续搜索发现回答是loss不是tensor格式。是因为item()函数将tensor转换为了float。

所以在计算损失也就是loss.backward之前不能用loss.item()。修改为:loss += loss,这样loss就是tensor了,但是我的边界损失也是用的loss += loss.item()。那么也就是说我的边界损失也是float类型了。但是却可以正常运行:

于是继续搜索发现tensor和float相加时候,会自动将float转换为tensor格式。但是,在反向传播时候却不能对边界损失进行反向更新,因此即使可以运行,结果也是错的,所以有多个分割损失和边界损失时候,不能用loss += loss.item()。loss.backward将损失反向传播,计算梯度,optimizer使用梯度下降法优化损失。

什么时候可以用呢:搜索发现在不需要损失梯度的地方可以用loss.item(),比如需要用logger记录损失时候可以使用。

loss.backward

news2026/2/11 17:45:55

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处:http://www.coloradmin.cn/o/691677.html

如若内容造成侵权/违法违规/事实不符,请联系多彩编程网进行投诉反馈,一经查实,立即删除!相关文章

FTL没有映射管理,跟上班没有钱有什么区别

大家好,我是五月。

前言

FTL(Flash Translation Layer),即闪存转换层,是各种存储设备的核心算法,作用是将Host传下来的逻辑地址转换成物理地址,也就是映射。

可以说,地址映射是FT…

机器学习——概率与统计

参考资料:

《机器学习》周志华https://zhuanlan.zhihu.com/p/27056207

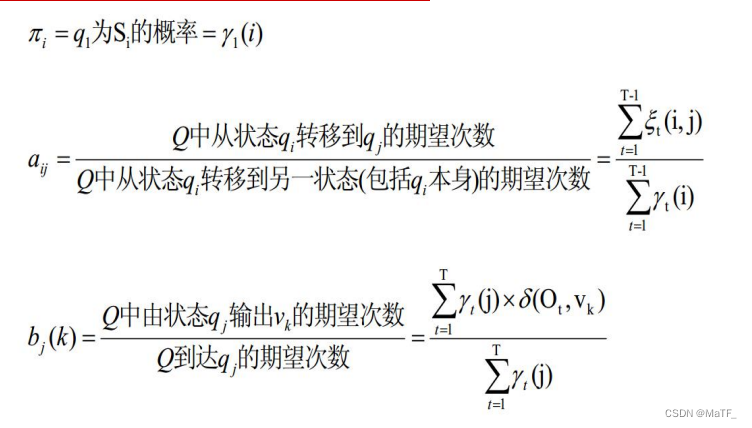

1 马尔可夫链

1.1 定义 直观含义:在已知现在的条件下,过去与未来相互独立。

1.2 马尔可夫模型 根据定义,A 必为方阵 其中, p i j ( n ) P {…

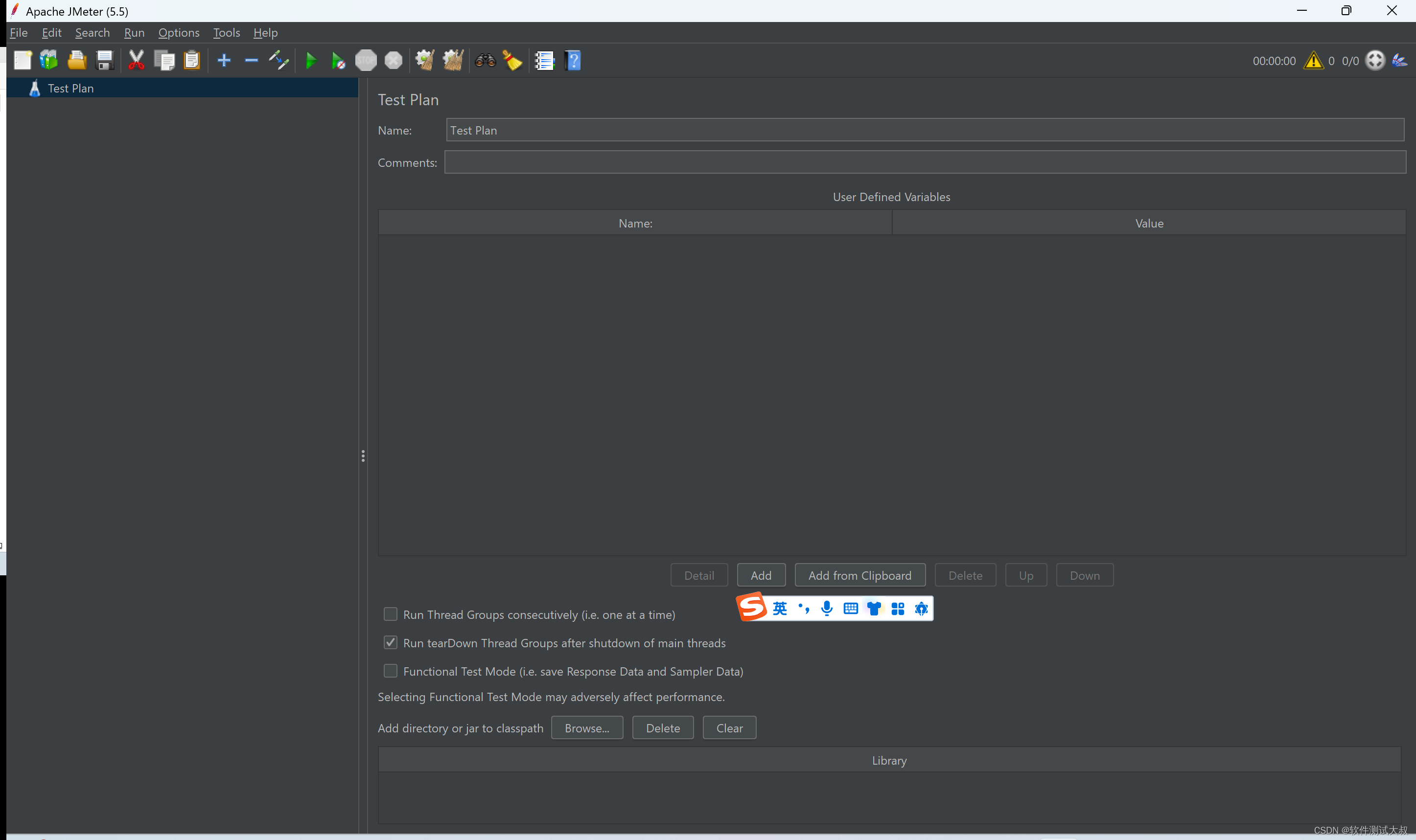

JMeter在高分辨率电脑上,页面显示字体特别小

最近使用JMeter的过程中,发现一个问题,在高分辨率的电脑上,JMeter启动后,页面显示的字体特别小,上图 我电脑的分辨率是2880*1800,缩放200%

上图里显示的字体真心看不清楚

我以为是JMeter的bug,…

[React]面向组件编程

1. 定义组件

- 函数式定义(简单组件),使用function定义

import React from react;

import ReactDOM from react-dom/client;function App() {return (<button onClick{handleClick}>click</button> // 直接把方法handleClick赋…

Pycharm+Gitlab+Jenkins持续集成自动化测试总结

一、Gitlab如何删除远程仓库的代码

1、如果本地仓库不小心删除,没关系,再新建一个空文件夹;

2、在空文件夹中右键,进入Git Bash命令行模式;

3、然后克隆远程仓库; git clone http://175.30.32.65:9000/r…

由半数年轻人存款不足10万而引发的思考!

✅作者简介:2022年博客新星 第八。热爱国学的Java后端开发者,修心和技术同步精进。 🍎个人主页:Java Fans的博客 🍊个人信条:不迁怒,不贰过。小知识,大智慧。 💞当前专栏…

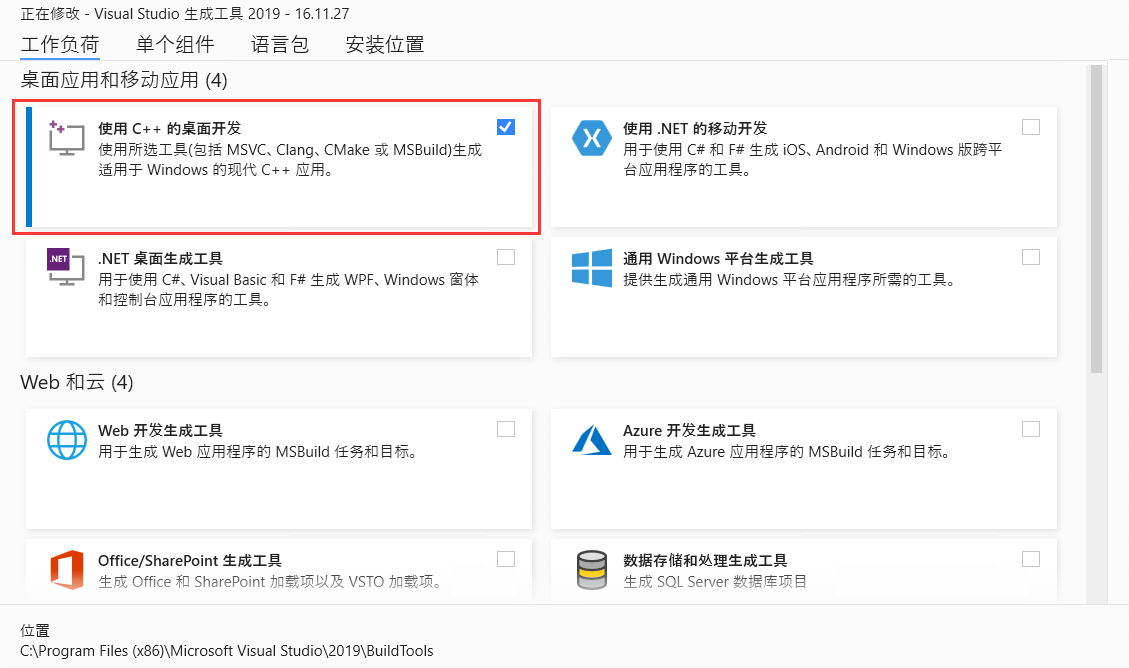

windows安装youcompleteme

通过vim-plug,安装youcompleteme安装clangd-completer。python .\install.py --clangd-completer --msvc16c系补全需提供编译参数给clangd。两种种方式

安装c开发编译环境,即visual c 相关环境。

参考

ycm-core/YouCompleteMe: A code-completion en…

PMBOK第七版有什么新变化?影响8月PMP考试吗?

PMBOK是项目管理学习过程中必不可少的重要教材,从1996年PMI发布第一版PMBOK到现在,PMBOK已经更新到第七版,那么第七版PMBOK有哪些新变化呢?会影响8月考试吗?下面老师来为您详细解答。

1

PMBOK主要变化演进情况 私免费…

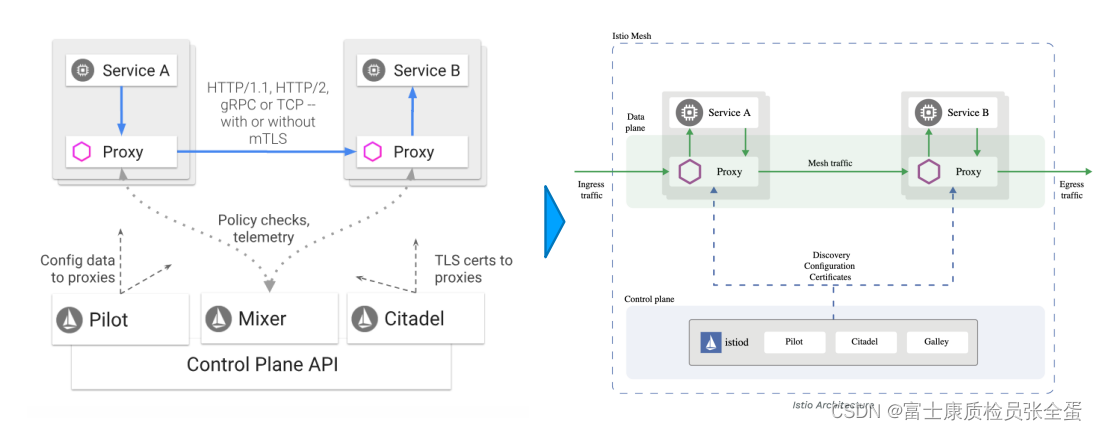

Istio 什么是服务网格

什么是服务网格 服务网格(Service Mesh)这个术语通常用于描述构成这些应用程序的微服务网络以及应用之间的交互。随着规模和复杂性的增长,服务网格越来越难以理解和管理。

它的需求包括服务发现、负载均衡、故障恢复、指标收集和监控以及通常更加复杂的运维需求&am…

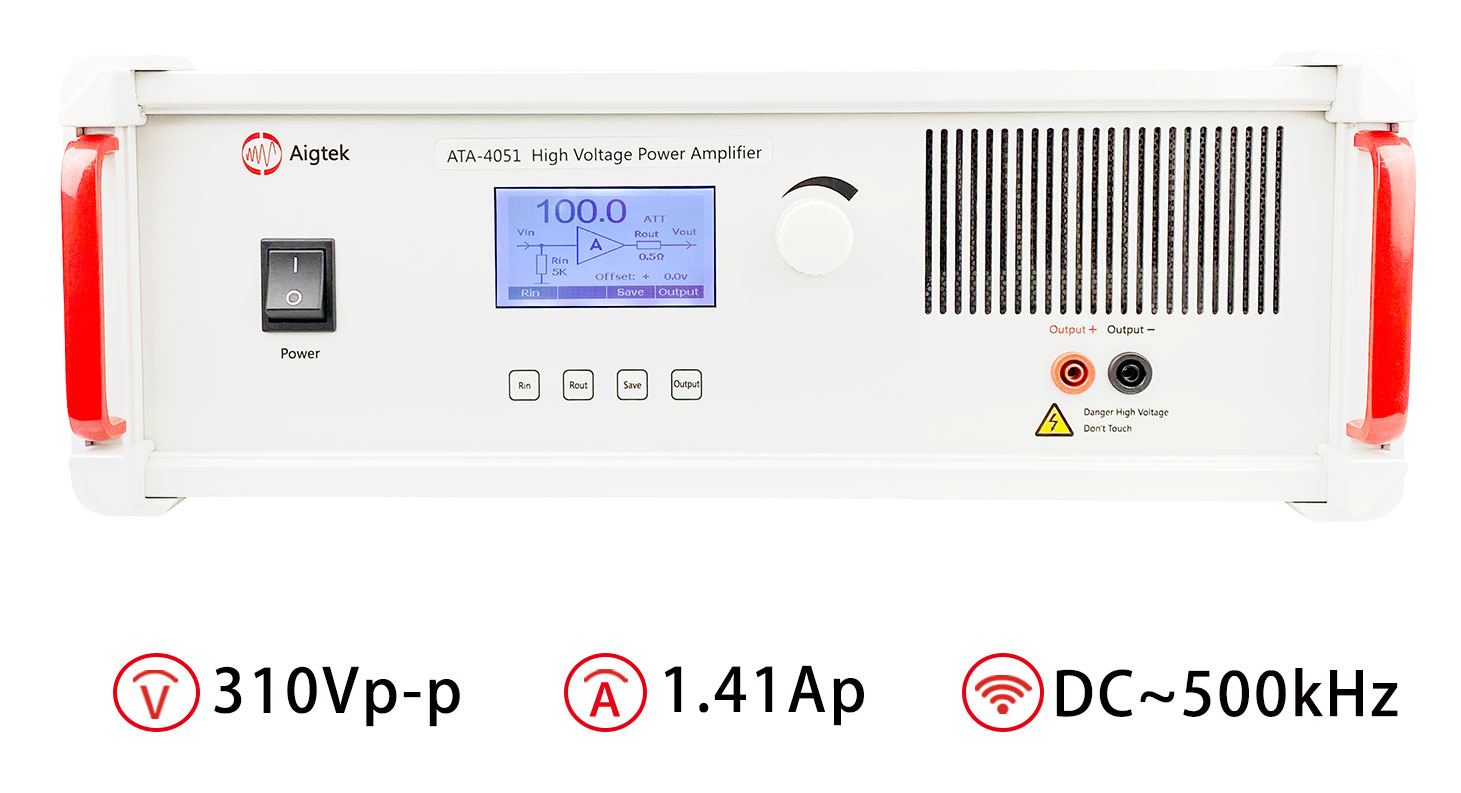

高压功率放大器在超声波探测器中的应用

超声波探测技术是一种非常重要的无损检测技术,广泛应用于医学、工业等领域。超声波探测器中的高压功率放大器是其中一个关键部件,它主要用于将微弱的超声信号放大到能够进行后续处理和分析的程度。 在超声波探测器中,超声波发射器会向被测物体…

Bug小能手系列(python)_8: 使用mne库读取gdf文件报错 Cannot cast ufunc ‘clip‘ output

Cannot cast ufunc clip output from dtype float64 to dtype uint32 with casting rule same_kind 0. 错误介绍1. 环境介绍2. 问题分析3. 解决方法4. 总结 0. 错误介绍

在加载BCI Competition IV 2a数据集时,当使用mne库的io的read_raw_gdf()函数时出错。注&#…

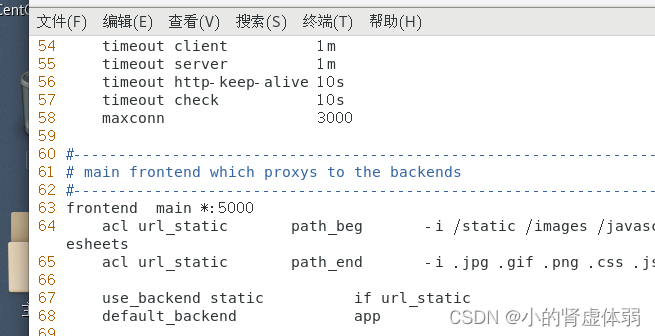

Haproxy开源负载均衡部署

第一步环境准备:

systemctl stop firewalld setenforce 0 systemctl disable firewalld.service #设置开机不启动防火墙sed -i s/SELINUX.*/SELINUXdisabled/ /etc/sysconfig/selinux #设置开机不启动防火墙iptables -F centos7服务器 haproxy 192.168…

自动化测试验证码tesseract安装以及python联调

前提

经常会遇到登录系统时候需要输入动态验证码的情况,但是自动化如何识别图片然后登陆系统? 需要用到pytesseract识别验证码图片以及PIL图像处理方法

import pytesseract

from PIL import Image, ImageEnhance1、tesseract安装

OCR,即O…

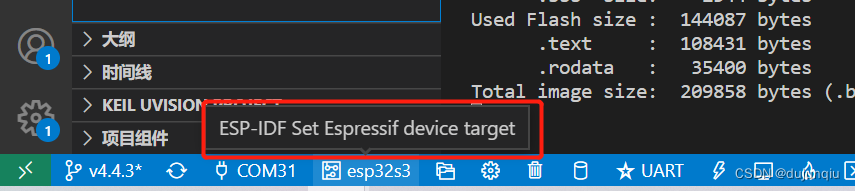

ESP32报错-Invalid chip id. Expected 9 read 0. Bootloader for wrong chip?

异常现象:

如下图所示,ESP32的 bootloader 运行时候一直报错,导致设备频繁重启,无法跳转至APP

原因及解决方式:

这个报错的原因就是程序编译时候选择的芯片型号和当前实际运行的芯片型号不一致,导致无法…

两个链表的第一个公共节点

题目描述

输入两个链表,找出它们的第一个公共节点。

如下面的两个链表:

在节点 c1 开始相交。

示例 1: 输入:intersectVal 8, listA [4,1,8,4,5], listB [5,0,1,8,4,5], skipA 2, skipB 3 输出:Reference of…

「一键智能去除文件名中的特殊符号,让文件批量改名更加简单!」

文件批量改名一直是个繁琐的任务,其中最麻烦的问题之一就是文件名中的特殊符号。手动去除这些符号是一项耗时而繁琐的工作,但现在有一个更加智能的解决方案,可以让你快速的去除文件名中的特殊符号。方法如下:

首先,我…

漏洞预警|Apache StreamPipes 权限升级漏洞

棱镜七彩安全预警

近日,棱镜七彩威胁情报团队探测到开源项目Apache StreamPipes 存在权限升级漏洞,经分析研判,向全社会发起开源漏洞预警公告,提醒相关安全团队及时响应。

项目介绍

Apache StreamPipes(incubating&…

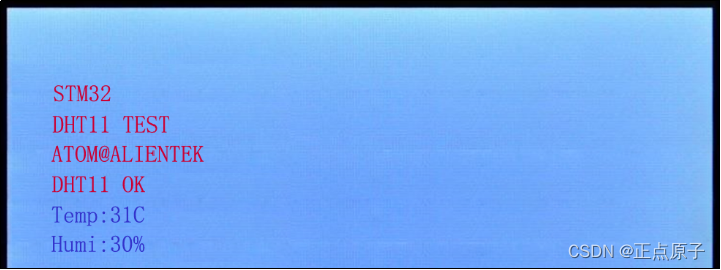

【正点原子STM32连载】 第四十三章 DHT11数字温湿度传感器 摘自【正点原子】STM32F103 战舰开发指南V1.2

1)实验平台:正点原子stm32f103战舰开发板V4 2)平台购买地址:https://detail.tmall.com/item.htm?id609294757420 3)全套实验源码手册视频下载地址: http://www.openedv.com/thread-340252-1-1.html#

第四…

![[React]面向组件编程](https://img-blog.csdnimg.cn/f5c67186beb34ca0aa5a9f97b81f0d53.png)