集成学习算法之间的主要区别在于以下3个方面: 提供给个体学习器的训练数据不同; 产生个体学习器的过程不同; 学习结果的组合方式不同,从这三个方面去学。

多样性

数据样本多样性:产生数据多样性的方法主要有3种: 输入样本扰动; 输入属性扰动; 输出表示扰动。

算法参数多样性

算法参数多样性是指通过使用不同的参数集来产生不同的个体学习器。即使每个个体学习器都使用相同的训练集,但是由于使用的参数不同,其输出也会随参数的改变而变化。

结构多样性

结构多样性主要是由个体学习器的内部结构或外部结构的不同所产生的。在一个集成学习系统中,如果个体学习器都是由同种算法训练产生的,则称之为同质集成。相反的,如果一个集成系统中包含着不同类型的个体学习器,则称之为异质集成。

基学习器训练方法

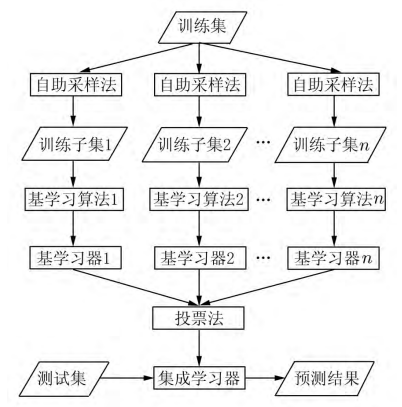

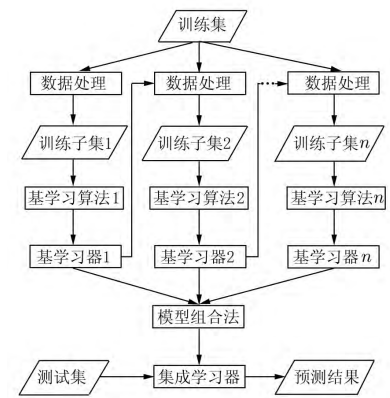

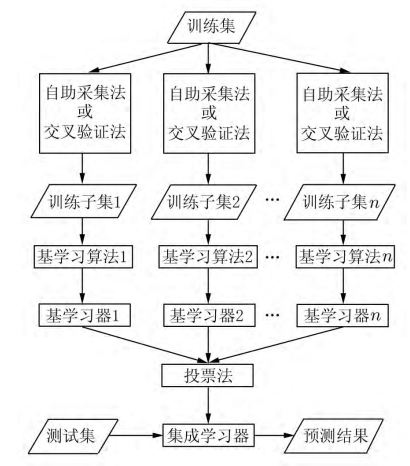

随着集成学习研究领域的不断发展,虽然不断提出新的集成学习算法,但是这些算法大都是由一些经典算法如: Bagging、Boosting、Stacking等改进得到的。

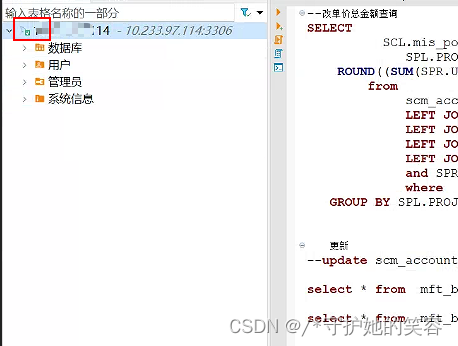

Bagging

Boosting

Stacking

基学习器的组合策略

构建集成学习系统的最后一步就是选择个体学习器的组合策略。集成学习系统可以根据个体学习器的表现来决定是否使用该学习器。

投票法,简单投票法一般分为以下2种: 绝对多数投票和相对多数投票。

平均法,平均法是一种组合连续数值型输出常用的方法,它主要分为简单平均法和加权平均法。

已有集成学习算法还存在很多不足和局限性, 例如,若想通过Bagging算法取得较好的集成效果,则需要基学习器同时具备高效的学习能力以及高度的数据敏感性。Boosting算法在训练带有噪声的数据时容易产生过拟合问题。因此集成学习在很多方面还需进一步研究,后续的研究工作可以从以 下几个方面展开: ①集成学习结构优化: 针对集成学习系统的内部结构和外部结构进行研究,使集成 学习系统的性能进一步提高。②集成学习模型选择: 对集成学习系统中的模型进行选择,将冗余和 对结果有负面影响的模型移除。③集成学习模型融合: 对于非监督算法,其输出结果较为复杂,适用于监督式集成学习算法的模型融合策略无法使用。

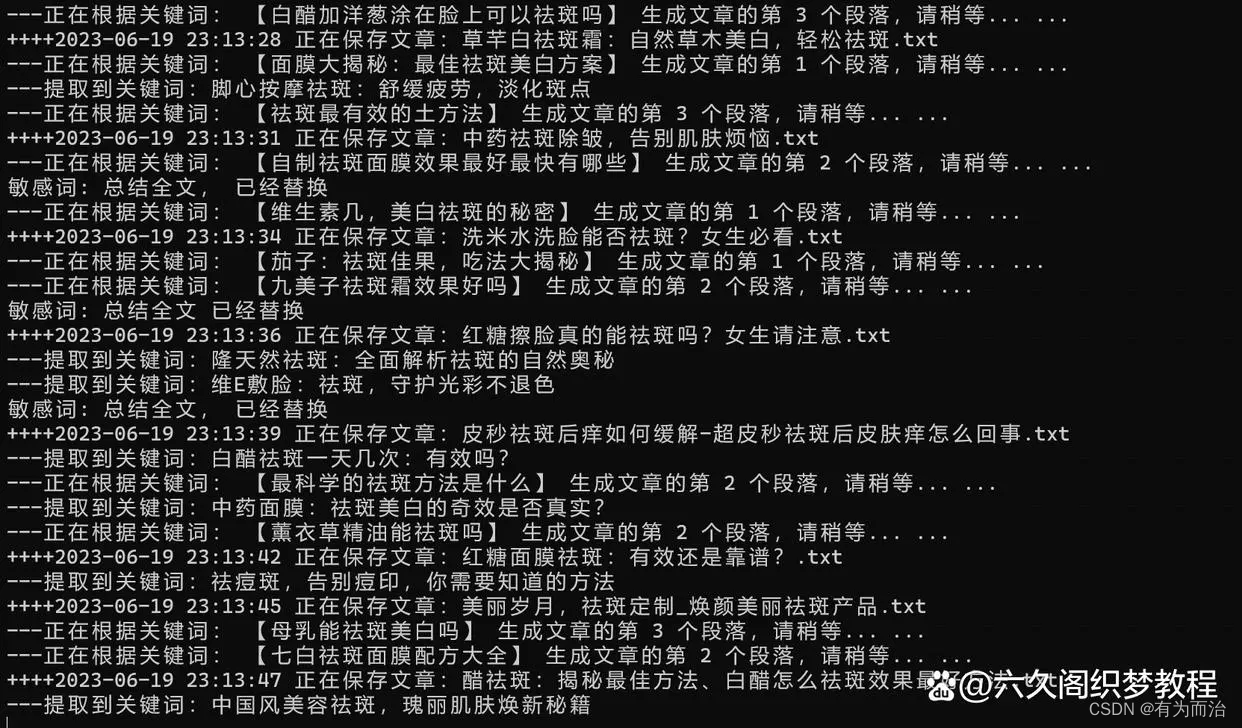

知乎咨询:哥廷根数学学派

擅长现代信号处理(改进小波分析系列,改进变分模态分解,改进经验小波变换,改进辛几何模态分解等等),改进机器学习,改进深度学习,机械故障诊断,改进时间序列分析(金融信号,心电信号,振动信号等)

算法代码地址,浏览器打开:mbd.pub/o/GeBENHAGEN