论文:https://cdn.openai.com/papers/dall-e-2.pdf

项目:https://openai.com/dall-e-2

一. 主要思想

利用CLIP提取的文本特征,级联式的生成图片。第一阶段通过prior将文本特征与图像特征进行对齐,第二阶段用扩散模型将视觉特征转化为生成图片。整体来看,DALL-E2就是CLIP与扩散模型的结合,因此作者也将其命名为unCLIP。

二. 算法框架

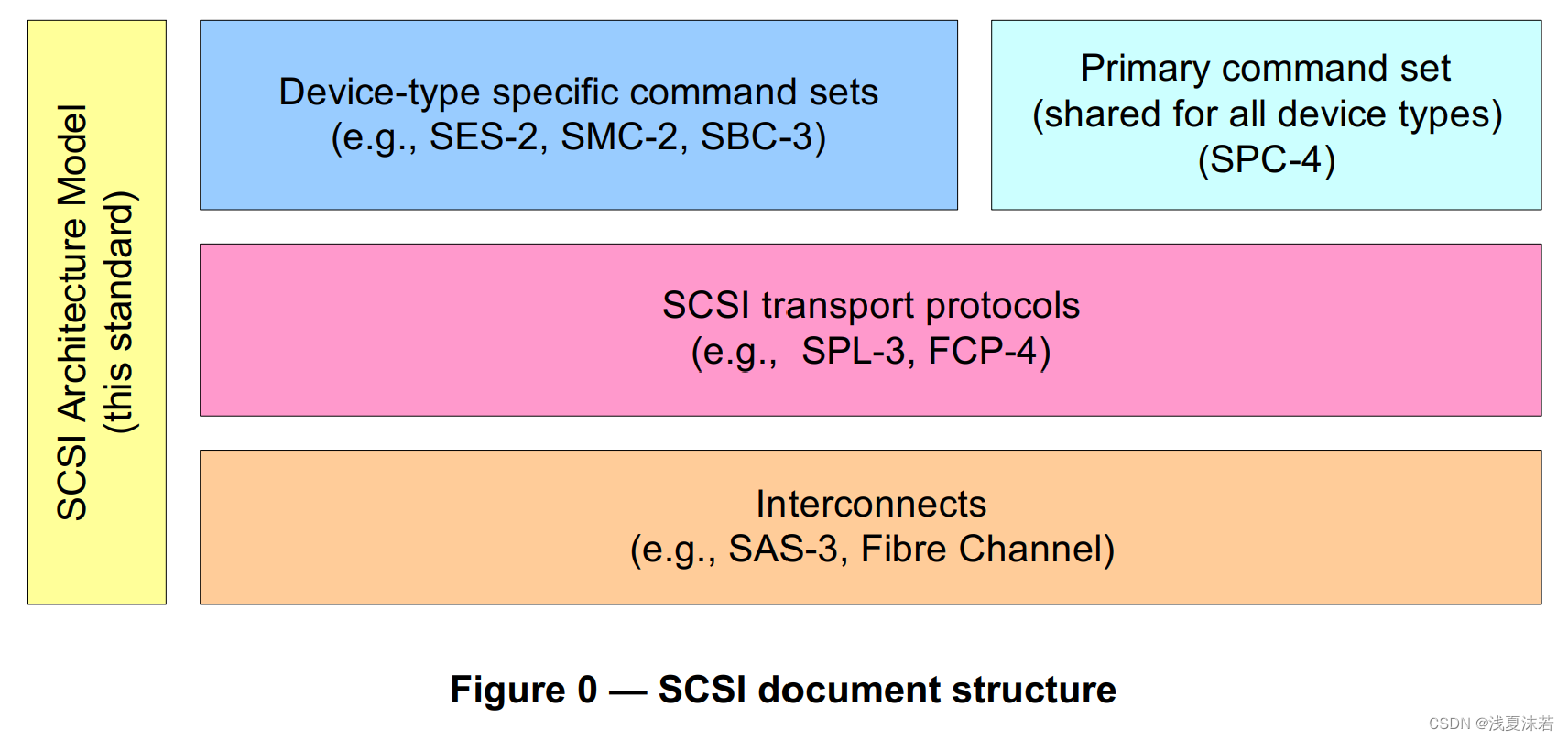

如上图所示,unCLIP是一个基于CLIP模型的文本到图像生成模型。下面是对unCLIP的高级概述:在虚线上方,我们描述了CLIP模型的训练过程,通过这个过程我们学习了一个用于文本和图像的联合表示空间。

在虚线下方,我们描述了文本到图像生成的过程:首先,将CLIP文本嵌入输入到一个自回归或扩散先验模型中,以生成一个图像嵌入;然后,使用这个嵌入来条件化一个扩散解码器,生成最终的图像。需要注意的是,在先验模型和解码器的训练过程中,CLIP模型是被冻结的,不会进行更新。

以上是对UnCLIP模型的整体概述。UnCLIP的核心思想是利用CLIP模型的文本嵌入来生成对应的图像,从而实现文本到图像的转换。这个过程通过先验模型和解码器的联合训练来实现。

三. 应用

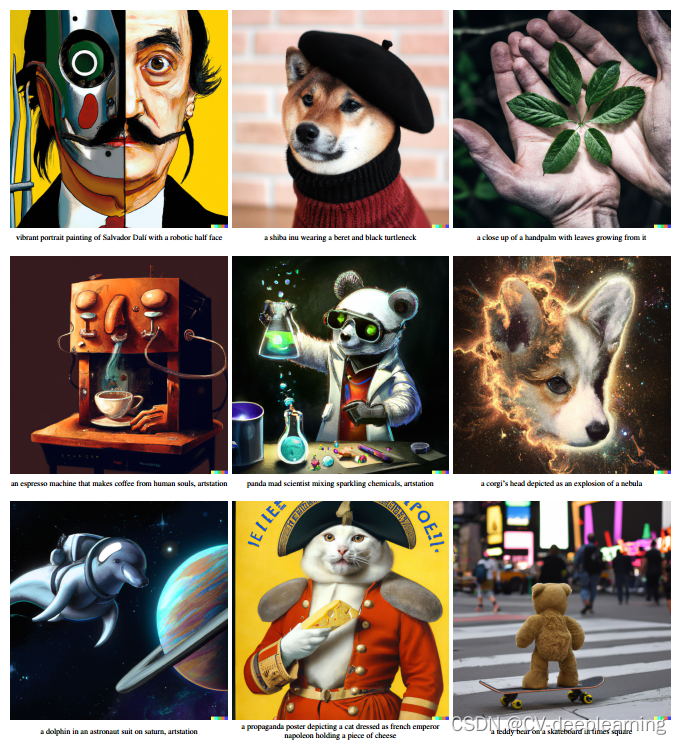

该算法可以用文本描述生成图片,由于扩散模型是Unet结构,理论上可以生成各种尺寸的图片,包括高清大图。如下图所示:

当然也可以输入图片,生成各种类似而又多样的图片。如下图所示: