1、电商业务简介

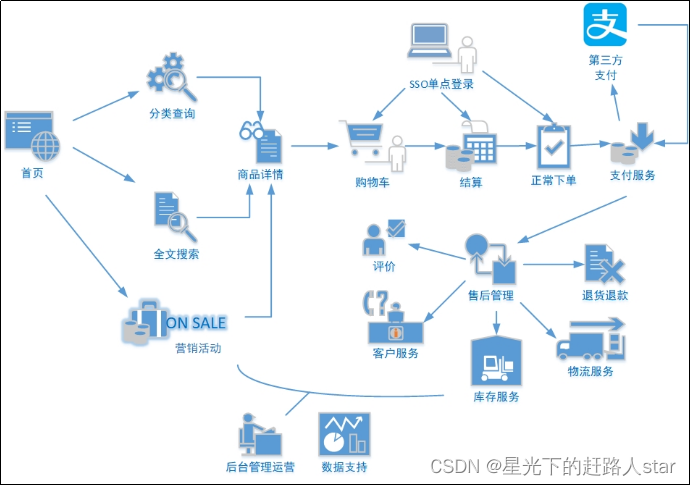

1.1 电商业务流程

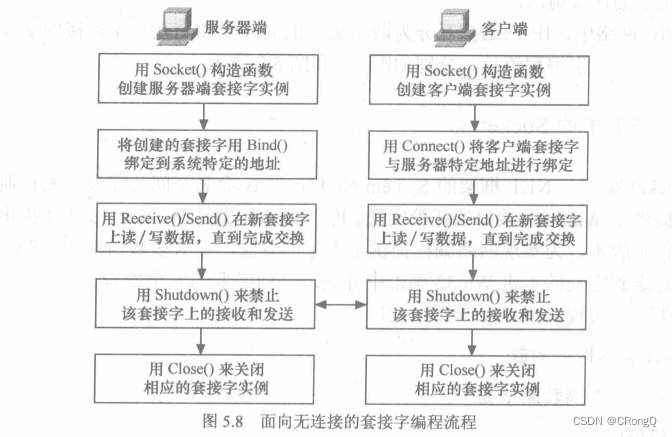

电商的业务流程可以以一个普通用户的浏览足迹为例进行说明,用户点开电商首页开始浏览,可能会通过分类查询也可能通过全文搜索寻找自己中意的商品,这些商品无疑都是存储在后台的管理系统中的。

当用户寻找到自己中意的商品,可能会想要购买,将商品添加到购物车后发现需要登录,登录后对商品进行结算,这时候购物车的管理和商品订单信息的生成都会对业务数据库产生影响,会生成相应的订单数据和支付数据。

订单正式生成之后,还会对订单进行跟踪处理,直到订单全部完成。

电商的主要业务流程包括用户前台浏览商品时的商品详情的管理,用户商品加入购物车进行支付时用户个人中心&支付服务的管理,用户支付完成后订单后台服务的管理,这些流程涉及到了十几个甚至几十个业务数据表,甚至更多。

1.2 电商常识

1.2.1 SKU和SPU

SKU = Stock Keeping Unit(库存量基本单位)。现在已经被引申为产品统一编号的简称,每种产品均对应有唯一的SKU号。

SPU(Standard Product Unit):是商品信息聚合的最小单位,是一组可复用、易检索的标准化信息集合。

SPU表示一类商品。同一SPU的商品可以共用商品图片、海报、销售属性等。

1.2.2 平台属性和销售属性

1、平台属性

2、销售属性

2、业务数据介绍

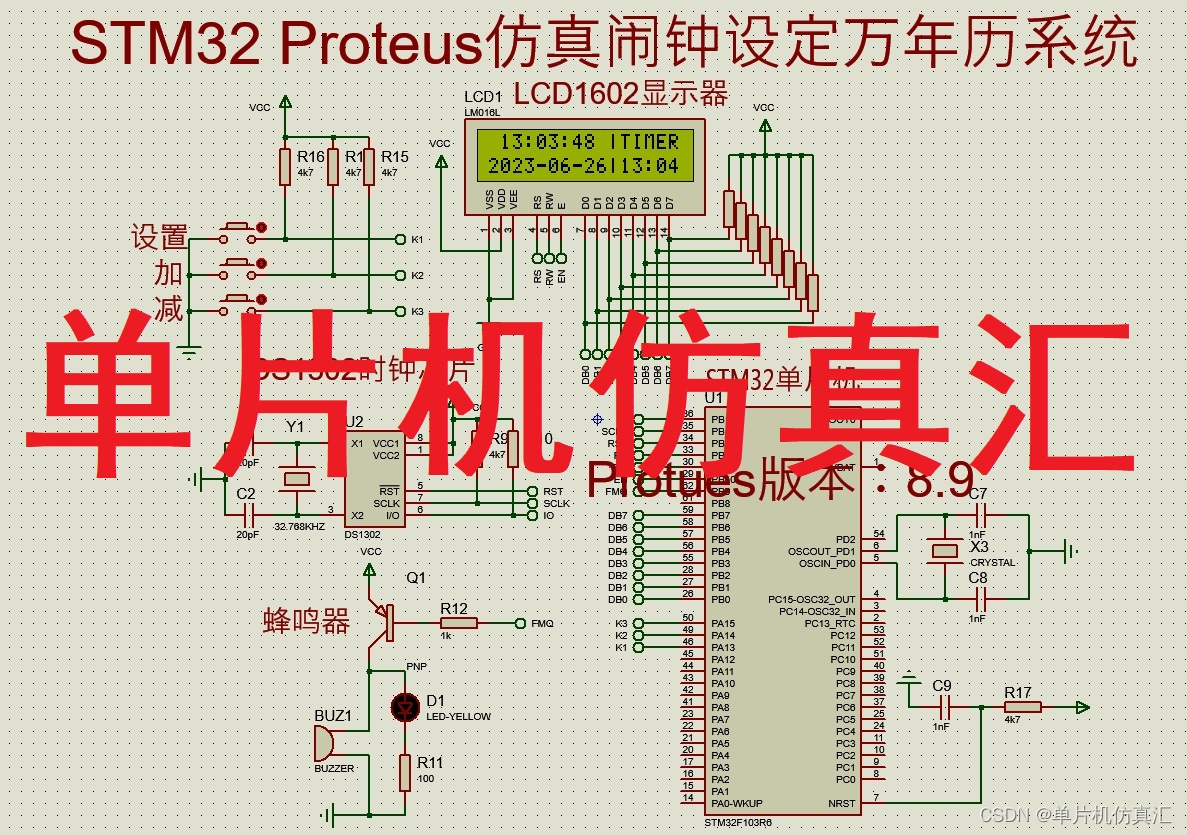

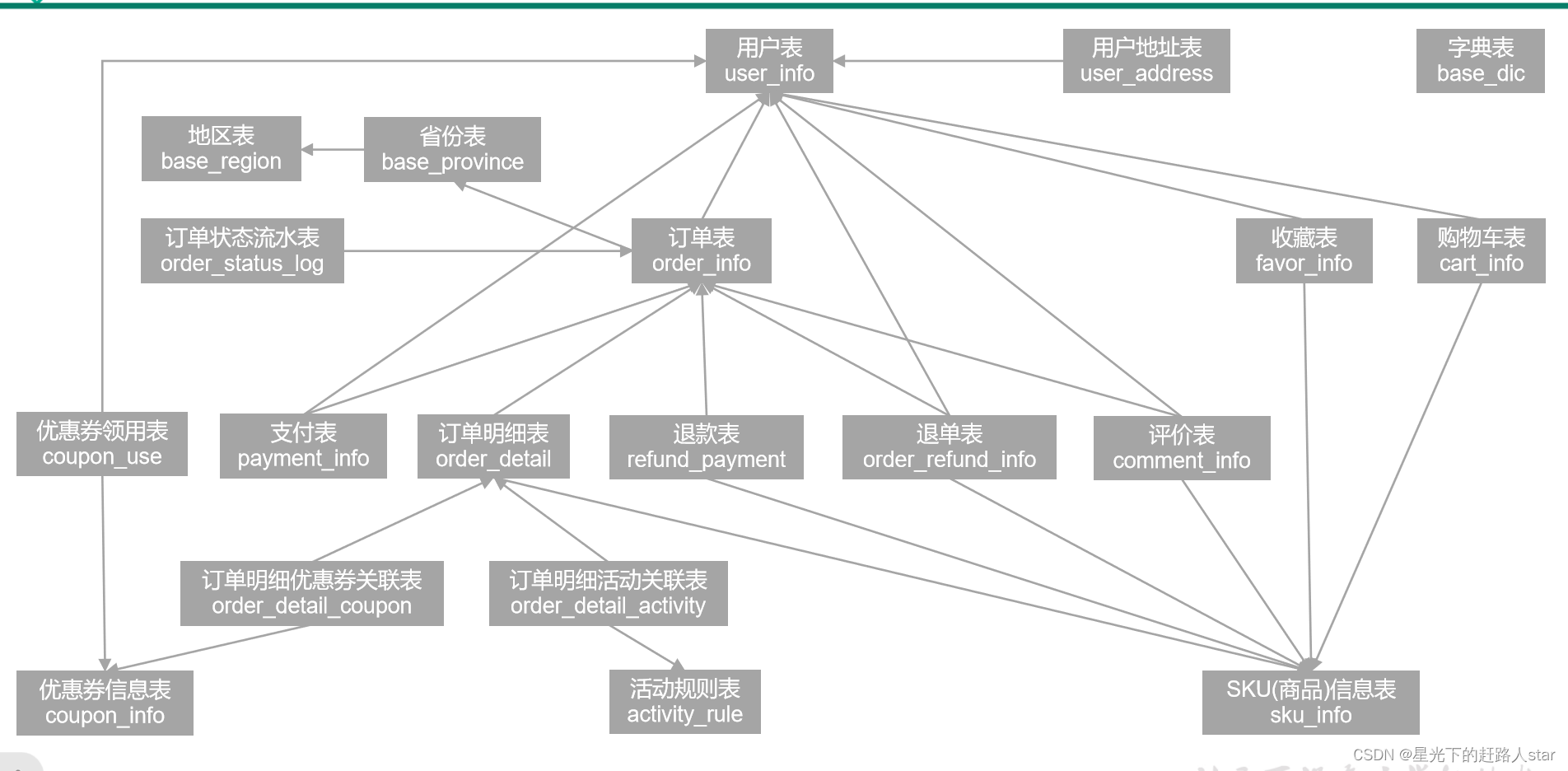

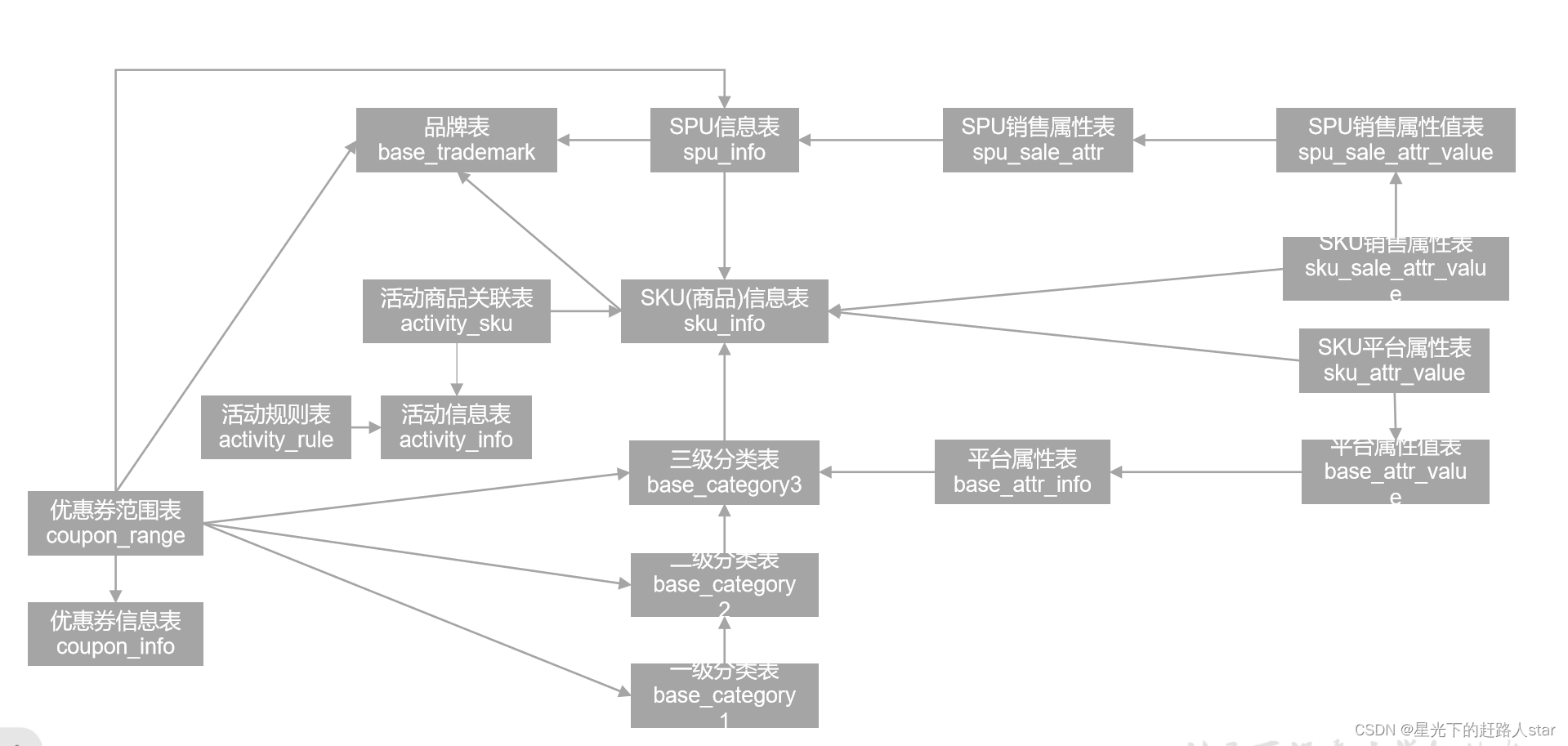

2.1 电商系统表结构

以下为本电商数仓系统涉及到的业务数据表结构关系。这34个表以订单表、用户表、SKU商品表、活动表和优惠券表为中心,延伸出了优惠券领用表、支付流水表、活动订单表、订单详情表、订单状态表、商品评论表、编码字典表退单表、SPU商品表等,用户表提供用户的详细信息,支付流水表提供该订单的支付详情,订单详情表提供订单的商品数量等情况,商品表给订单详情表提供商品的详细信息。本次讲解以此34个表为例,实际项目中,业务数据库中表格远远不止这些。

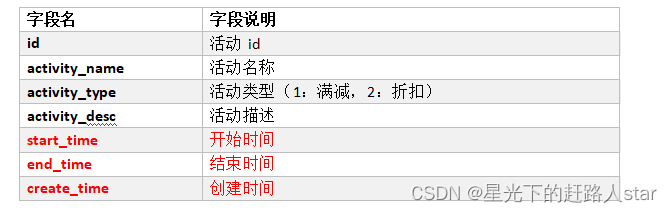

2.1.1 活动信息表(activity_info)

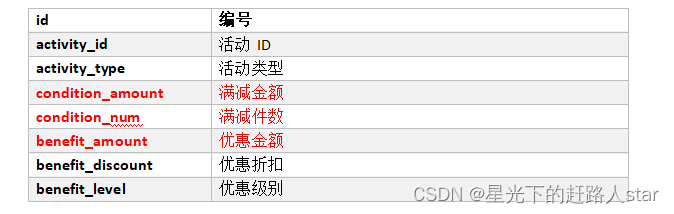

2.1.2 活动规则表(activity_rule)

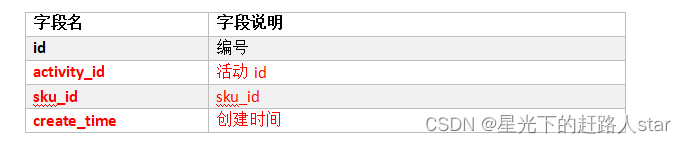

2.1.3 活动商品关联表(activity_sku)

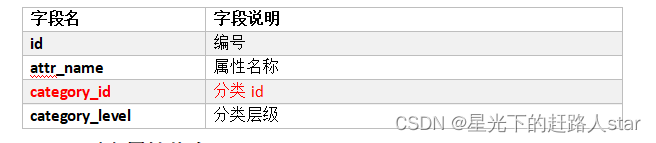

2.1.4 平台属性表(base_attr_info)

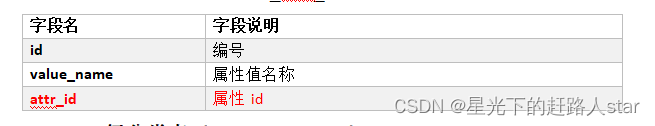

2.1.5 平台属性值表(base_attr_value)

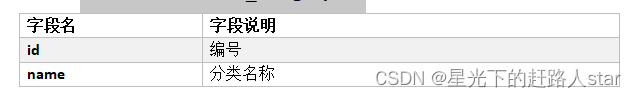

2.1.6 一级分类表(base_category1)

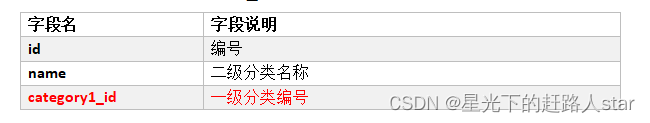

2.1.7 二级分类表(base_category2)

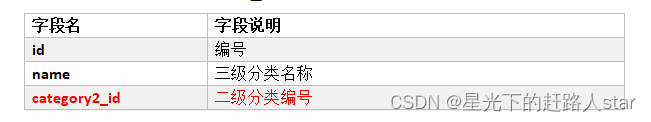

2.1.8 三级分类表(base_category3)

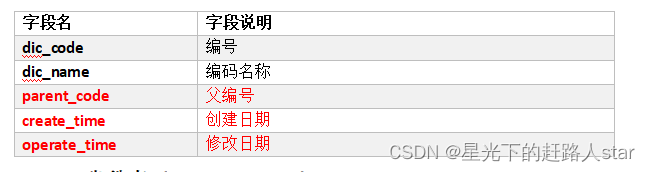

2.1.9 字典表(base_dic)

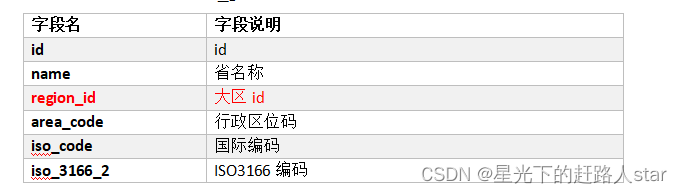

2.1.10 省份表(base_province)

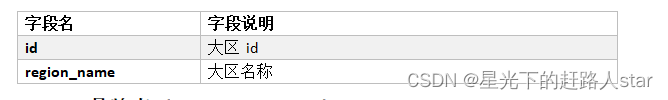

2.1.11 地区表(base_region)

2.1.12 品牌表(base_trademark)

2.1.13 购物车表(cart_info)

2.1.14 评价表(comment_info)

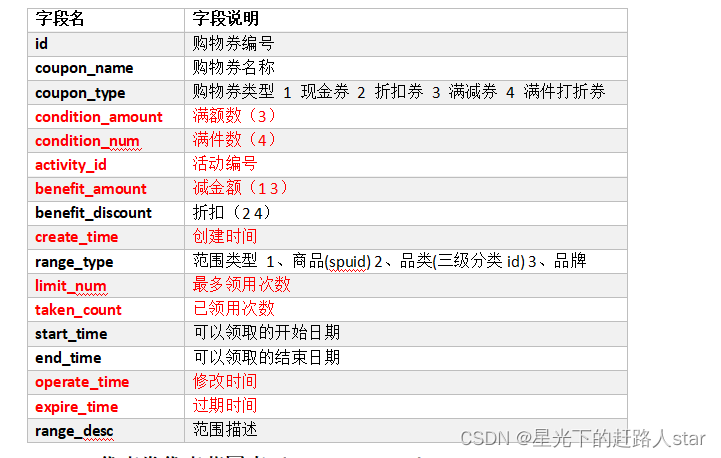

2.1.15 优惠券信息表(coupon_info)

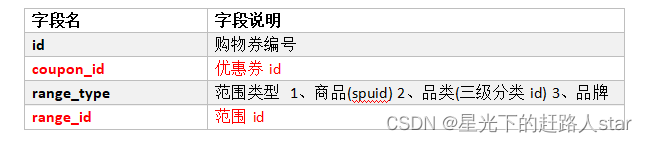

2.1.16 优惠券优惠范围表(coupon_range)

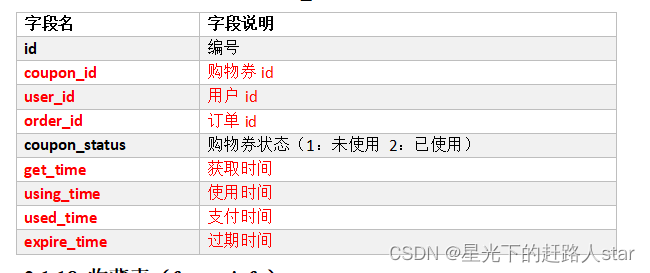

2.1.17 优惠券领用表(coupon_use)

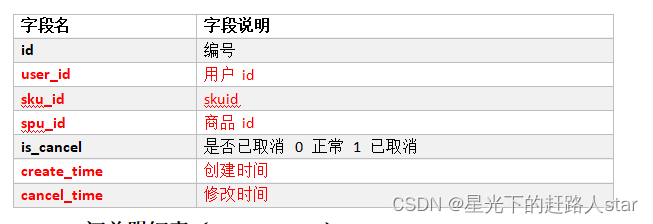

2.1.18 收藏表(favor_info)

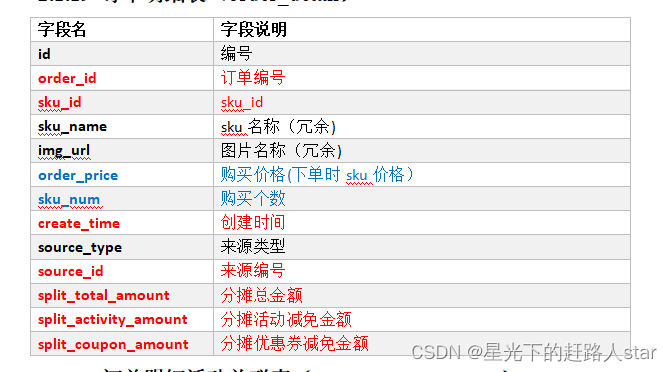

2.1.19 订单明细表(order_detail)

2.1.20 订单明细活动关联表(order_detail_activity)

2.1.21 订单明细优惠券关联表(order_detail_coupon)

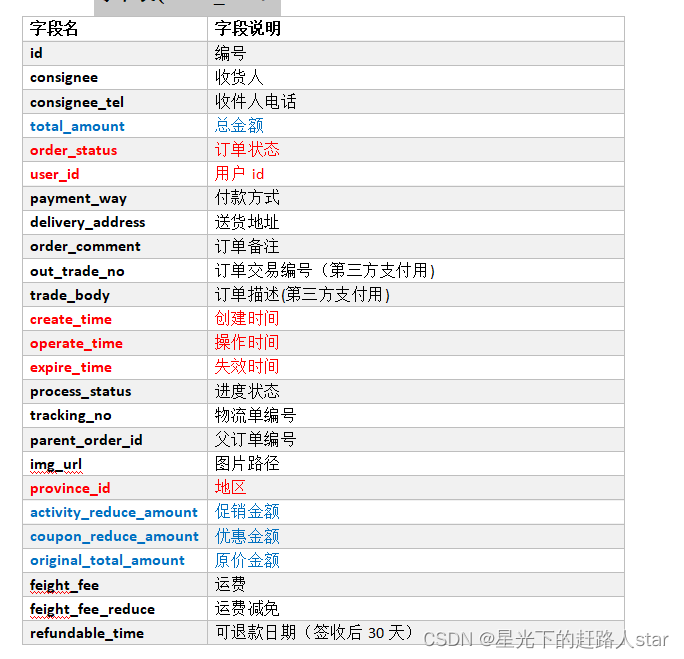

2.1.22 订单表(order_info)

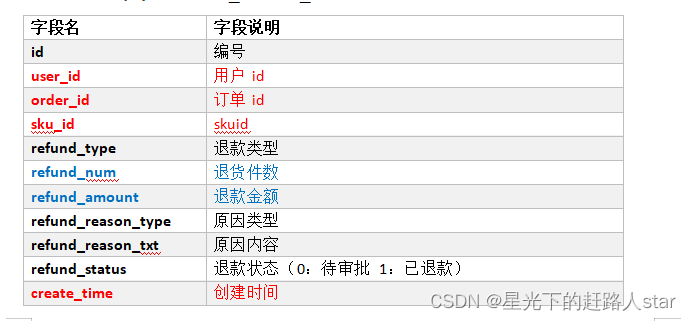

2.1.23 退单表(order_refund_info)

2.1.24 订单状态流水表(order_status_log)

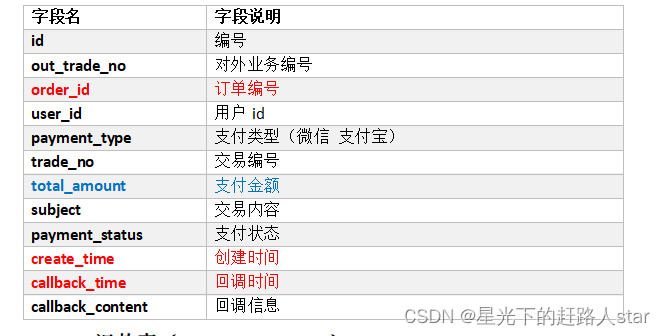

2.1.25 支付表(payment_info)

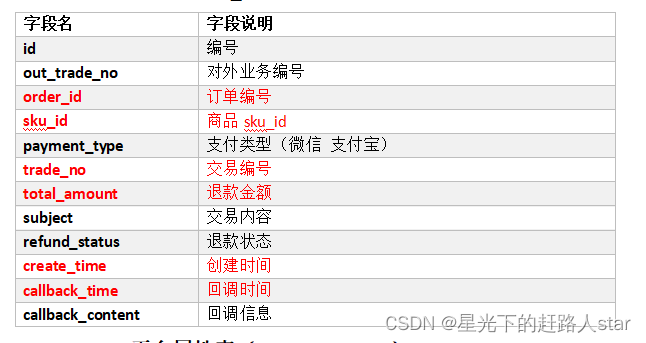

2.1.26 退款表(refund_payment)

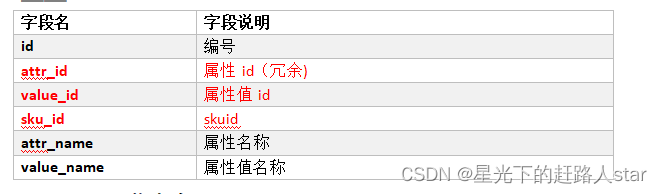

2.1.27 SKU平台属性表(sku_attr_value)

2.1.28 SKU信息表(sku_info)

2.1.29 SKU销售属性表(sku_sale_attr_value)

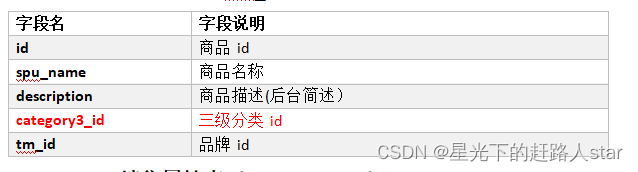

2.1.30 SPU信息表(spu_info)

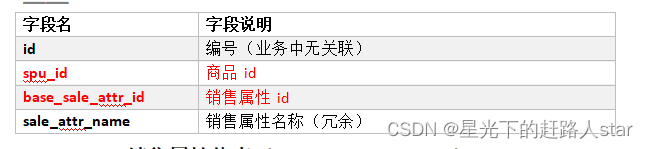

2.1.31 SPU销售属性表(spu_sale_attr)

2.1.32 SPU销售属性值表(spu_sale_attr_value)

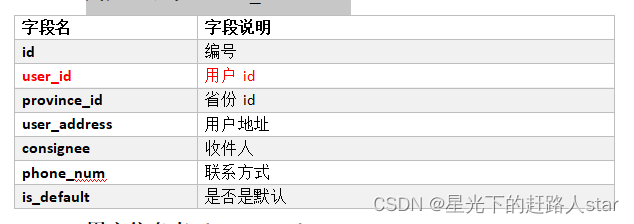

2.1.33 用户地址表(user_address)

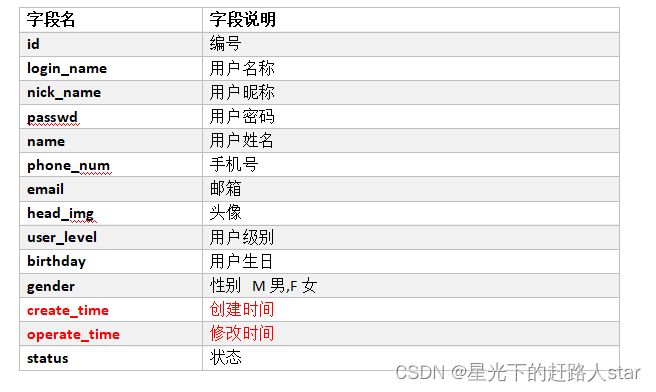

2.1.34 用户信息表(user_info)

2.1.35 电商业务表

2.1.36 后台管理系统

2.2 MySQL安装

按照这篇文章中的MySQL安装即可

2.3 业务数据模拟

2.3.1 连接MySQL

通过MySQL可视化客户端连接数据库。

2.3.2 建表语句

1、通过SQLyog创建数据库

2、设置数据库名称为gmall,编码为utf-8,排序规则为utf8_general_ci

3、导入数据库结构脚本(gmall.sql)

数据库导入数据脚本

2.3.3 生成业务数据

1、在hadoop102的/opt/module/目录下创建db_log文件夹

mkdir db_log/

2、把gmall2020-mock-db-2021-11-14.jar和application.properties上传到hadoop102的/opt/module/db_log路径上

获取jar包

3、根据需求修改application.properties相关配置

获取配置文件

logging.level.root=info

spring.datasource.driver-class-name=com.mysql.jdbc.Driver

spring.datasource.url=jdbc:mysql://hadoop102:3306/gmall?useUnicode=true&characterEncoding=utf-8&useSSL=false&serverTimezone=GMT%2B8

--下面两个要改成自己的

spring.datasource.username=root

spring.datasource.password=000000

logging.pattern.console=%m%n

mybatis-plus.global-config.db-config.field-strategy=not_null

#业务日期

mock.date=2020-06-14

#是否重置 注意:第一次执行必须设置为1,后续不需要重置不用设置为1

mock.clear=1

#是否重置用户 注意:第一次执行必须设置为1,后续不需要重置不用设置为1

mock.clear.user=1

#生成新用户数量

mock.user.count=100

#男性比例

mock.user.male-rate=20

#用户数据变化概率

mock.user.update-rate:20

#收藏取消比例

mock.favor.cancel-rate=10

#收藏数量

mock.favor.count=100

#每个用户添加购物车的概率

mock.cart.user-rate=50

#每次每个用户最多添加多少种商品进购物车

mock.cart.max-sku-count=8

#每个商品最多买几个

mock.cart.max-sku-num=3

#购物车来源 用户查询,商品推广,智能推荐, 促销活动

mock.cart.source-type-rate=60:20:10:10

#用户下单比例

mock.order.user-rate=50

#用户从购物中购买商品比例

mock.order.sku-rate=50

#是否参加活动

mock.order.join-activity=1

#是否使用购物券

mock.order.use-coupon=1

#购物券领取人数

mock.coupon.user-count=100

#支付比例

mock.payment.rate=70

#支付方式 支付宝:微信 :银联

mock.payment.payment-type=30:60:10

#评价比例 好:中:差:自动

mock.comment.appraise-rate=30:10:10:50

#退款原因比例:质量问题 商品描述与实际描述不一致 缺货 号码不合适 拍错 不想买了 其他

mock.refund.reason-rate=30:10:20:5:15:5:5

4、并在该目录下执行,如下命令,生成2020-06-14日期数据

java -jar gmall2020-mock-db-2021-11-14.jar

5、查看gmall数据库,观察是否有2020-06-14的数据出现

3、业务数据采集模块

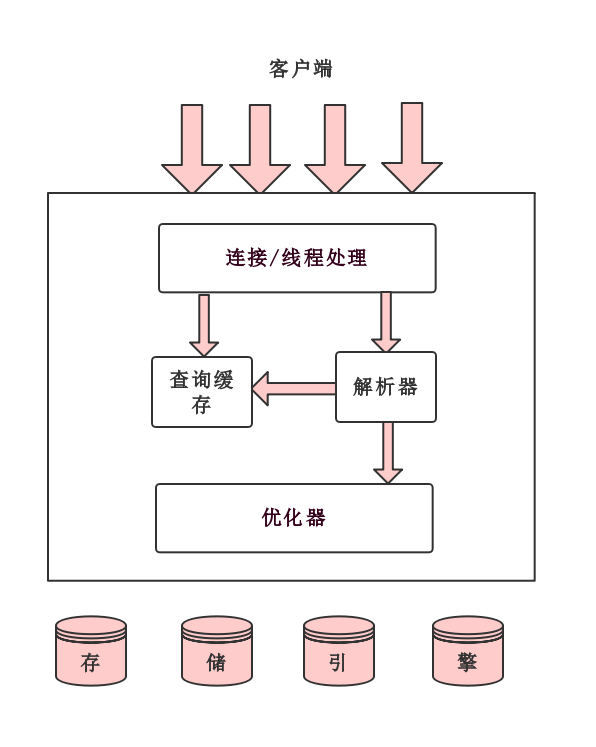

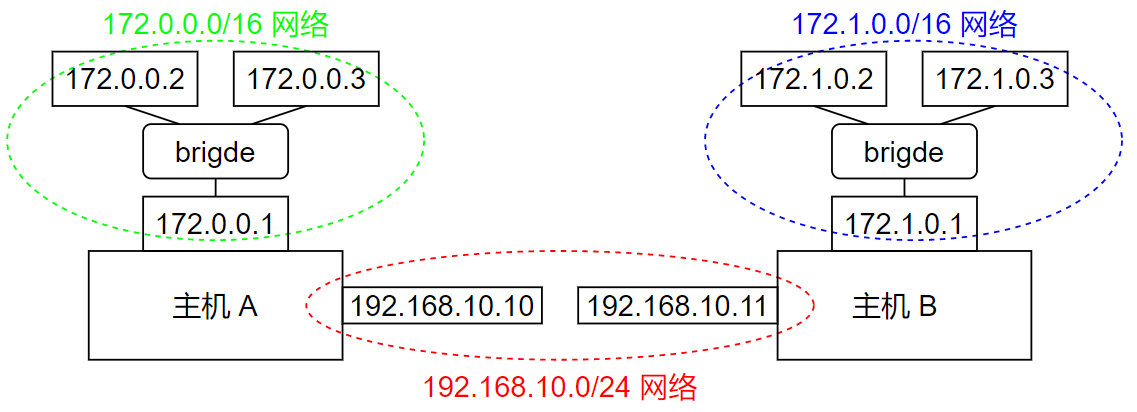

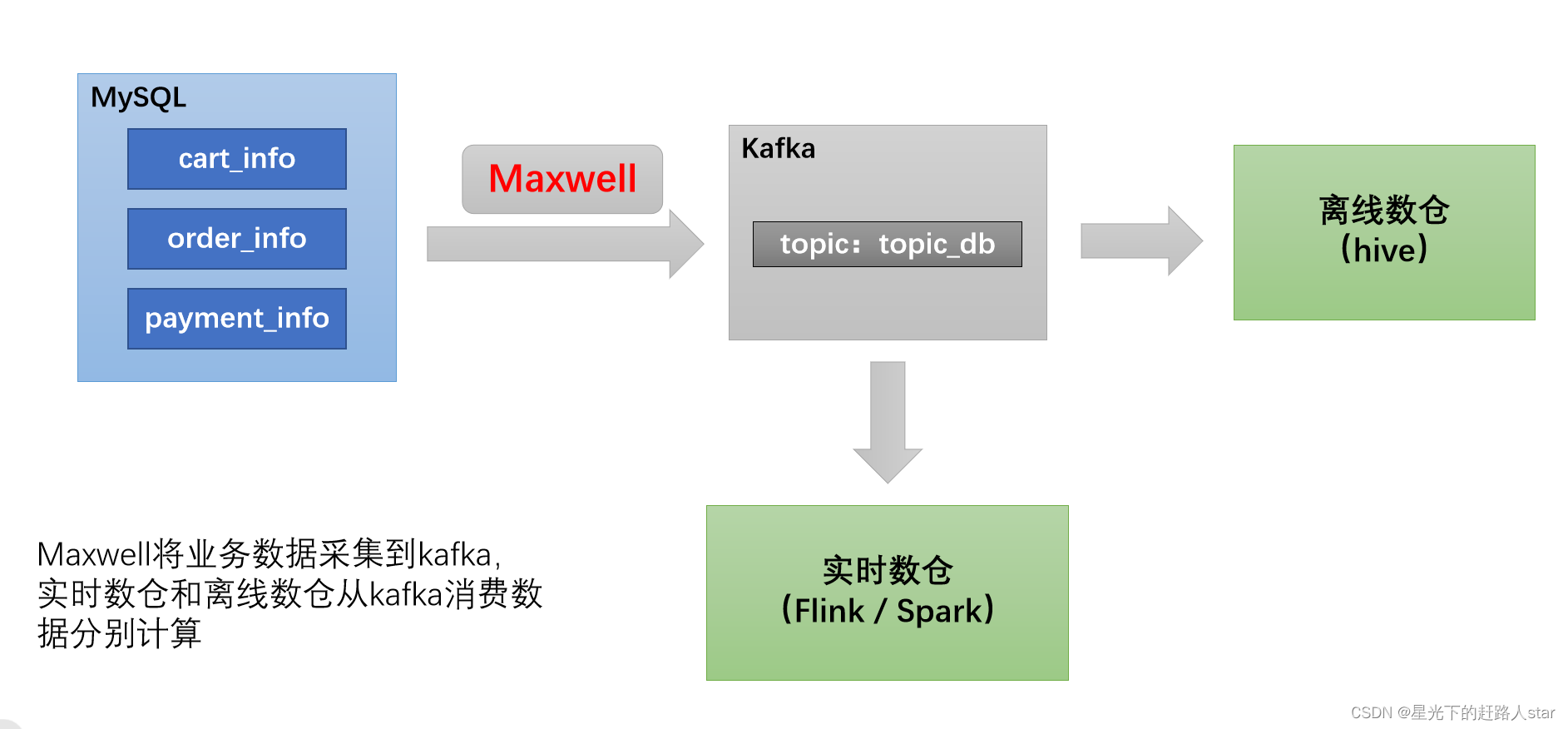

3.1 采集通道

3.2 采集工具

MaxWell详细介绍

3.3 采集通道MaxWell配置

1、修改Maxwell配置文件config.properties

vim /opt/module/maxwell/config.properties

2、配置参数如下

log_level=info

producer=kafka

kafka.bootstrap.servers=hadoop102:9092,hadoop103:9092

#kafka topic配置

kafka_topic=topic_db

# mysql login info

host=hadoop102

user=maxwell

password=maxwell

jdbc_options=useSSL=false&serverTimezone=Asia/Shanghai

3、重新启动Maxwell

mxw.sh restart

4、通道测试

(1)启动Zookeeper以及Kafka集群

(2)启动一个Kafka Console Consumer,消费topic_db数据

bin/kafka-console-consumer.sh --bootstrap-server hadoop102:9092 --topic topic_db

(3)生成模拟数据

cd /opt/module/db_log/

java -jar gmall2020-mock-db-2021-11-14.jar

(4)观察Kafka消费者是否能消费到数据