文章目录

- Pathways

- 现有AI缺憾

- Pathways Can Do

- Multiple Tasks

- Multiple Senses

- Sparse and Efficient

- Mixture of Experts(MoE)

- Neural Computation'1991, Adaptive mixtures of local experts

- ICLR'17, Outrageously Large Neural Networks: The Sparsely-Gated Mixture-of-Experts Layer

- ICLR'21, GShard: Scaling Giant Models with Conditional Computation and Automatic Sharding

- JMLR'22, Switch Transformers: Scaling to Trillion Parameter Models with Simple and Efficient Sparsity

- 2021, GLaM: Efficient Scaling of Language Models with Mixture-of-Experts

- AAAI'22, Go Wider Instead of Deeper

- NAACL'22, MoEBERT: from BERT to Mixture-of-Experts via Importance-Guided Adaptation

Pathways

google - Jaff Dean - Pathways

现今社会AI正在扮演越来越重要的角色,加之在很多领域里面AI也取得了很大的成功;

但为了与更多紧迫挑战任务的深度和复杂性相匹配,将需要新的、更强大的人工智能系统 —— 这些系统可以将人工智能的成熟方法与新兴的研究方向结合起来,从而能够解决我们今天无法解决的问题。为此,谷歌研究院的团队正在研究下一代人工智能架构的元素,called Pathways!一种通用网络的设计思路

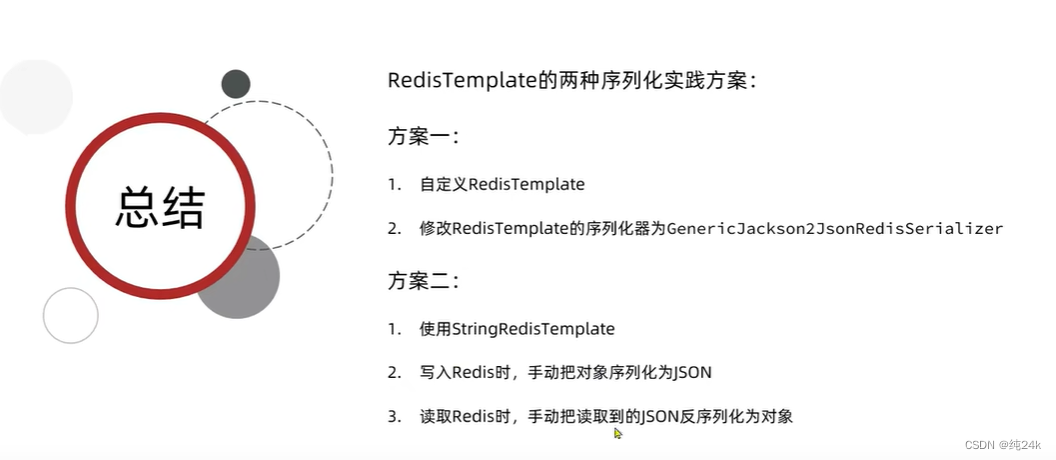

现有AI缺憾

- 目前AI模型都是为了解决某个或者某类问题而训练的

- 目前AI模型往往都聚焦到单个感观上(sense)

- 目前AI模型往往都是稠密且低效的

Pathways Can Do

Multiple Tasks

- 模型能解决多种任务

现有的AI往往都是从随机参数开始训练的,这代表着不存在任何经验的积累;并且任务是无穷尽的,代表着我们需要训练不可计数的模型,而且模型都是从0到1,每个任务都得需要大量的数据,这是无比沉重的任务

相反,我们想要训练一个模型,它不仅可以处理许多单独的任务,还可以利用并结合现有的技能来更快、更有效地学习新任务。这样,一个模型通过训练完成一项任务——比如,学习航拍图像如何预测景观的高度——可以帮助它学习另一项任务——比如,预测洪水将如何流经该地形。

我们想要一个模型有不同的功能,可以根据需要调用,并拼接在一起执行新的,更复杂的任务-更接近哺乳动物大脑在任务之间进行概括的方式。

Multiple Senses

- 模型能具有多种感知和直觉

人类对外界的感知往往都是多模态信息的整合,而目前AI模型往往都只聚集于单个模态,基本没有融合文本、语音和图像的AI

多感知的模型结果是一个更有洞察力的模型,更不容易出现错误和偏见。

当然,人工智能模型不需要局限于这些熟悉的感官,Pathways 应该需要处理更抽象的数据形式,帮助找到人类发现不同于现有感知的其他sense

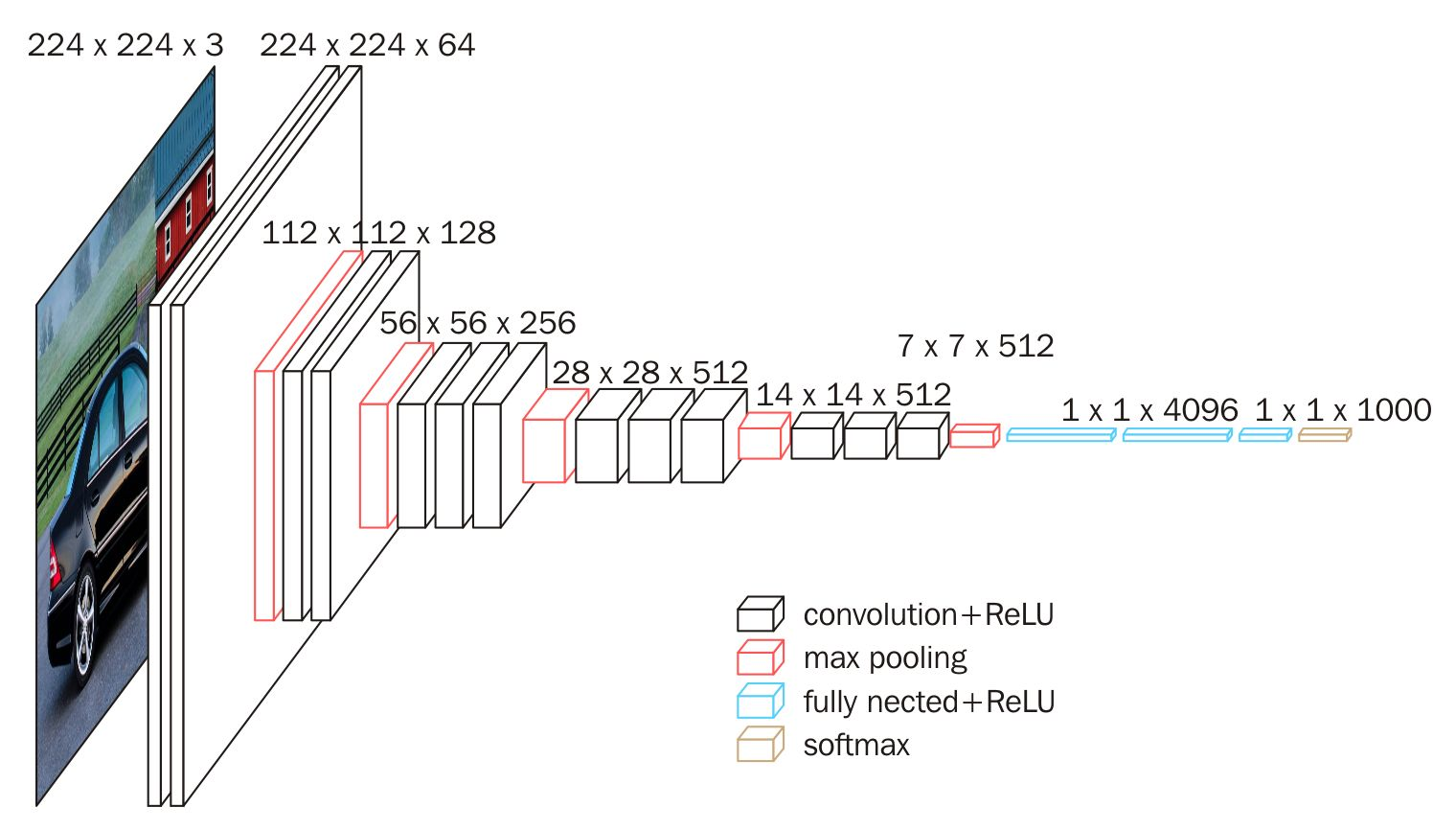

Sparse and Efficient

- 模型会变得稀疏连接且更加高效

我们的大脑有许多不同的部分专门负责不同的任务,但我们只在特定的情况下调用相关的部分。你的大脑中有近一千亿个神经元,但你依靠其中的一小部分来解释这个句子。而目前AI模型往往都是稠密的(因为是解决某个具体的任务)

人工智能也可以以同样的方式工作。我们可以建立一个“稀疏”激活的单一模型,这意味着只有通过网络的小路径在需要时被调用。事实上,模型动态地学习网络的哪个部分擅长哪些任务——它学习如何通过模型中最相关的部分路由任务。这种架构的一大好处是,它不仅具有更大的学习各种任务的能力,而且速度更快,更节能,因为我们不需要为每个任务激活整个网络。

例如,GShard和Switch Transformer是我们创建过的两个最大的机器学习模型,但由于它们都使用稀疏激活,因此它们消耗的能量不到类似大小的密集模型的1/10,同时与密集模型一样准确。

现有AI模型往往过于专注于单个任务,而它们本可以擅长许多任务。当他们可以合成几种输入时,他们依赖于一种输入形式。而且,当熟练和专业化的专业知识可以发挥作用时,他们往往会诉诸暴力(穷举)。

Pathways将使单个人工智能系统能够在数千或数百万个任务中进行泛化,以理解不同类型的数据,并以惊人的效率做到这一点——将我们从仅仅识别模式的单一用途模型时代推进到一个更通用的智能系统反映对我们世界的更深入理解并能够适应新需求的时代。

Pathways可以快速适应新的需求,解决世界各地出现的新问题,帮助人类充分利用我们面前的未来

Mixture of Experts(MoE)

Neural Computation’1991, Adaptive mixtures of local experts

- 最早的一篇混合专家模型研究论文,理论基础论文

ICLR’17, Outrageously Large Neural Networks: The Sparsely-Gated Mixture-of-Experts Layer

- 理论基础论文

ICLR’21, GShard: Scaling Giant Models with Conditional Computation and Automatic Sharding

- 经典工作论文

JMLR’22, Switch Transformers: Scaling to Trillion Parameter Models with Simple and Efficient Sparsity

- 经典工作论文

2021, GLaM: Efficient Scaling of Language Models with Mixture-of-Experts

- 经典工作论文

AAAI’22, Go Wider Instead of Deeper

- 网络设计

NAACL’22, MoEBERT: from BERT to Mixture-of-Experts via Importance-Guided Adaptation

- 网络设计