从大型语言模型走向人工通用智能AGI

返回论文和资料目录

1.导读

这篇博客主要基于《Sparks of Artificial General Intelligence: Early experiments with GPT-4》文中第9和第10节、以及我自己对当前LLM和AGI的理解。给出大型语言模型走向AGI时 改进的方向。

2.14个问题及改进方向(动态持续更新)

1.缩减模型

模型约减的目标是使用尽可能小的模型达到尽可能优的性能。当前大语言模型的模型规模是10B-500B。未来AGI必然是要普及的,所以缩减模型是一个重点研究方向。

导致的问题:

- 模型的训练成本和使用成本高,类似ChatGPT等这些优异性能的大模型每训练一次需要上千万美金,而在使用时,模型输入输出一次就需要经过整个大模型,导致使用成本巨大。

- 模型难以推广到个人。与世界上第一台电脑类似,如果后续没有个人电脑的普及,相信计算机至今都只存在大型科研或军事用途上。模型大导致现在大模型的研究主要在工业界和少数顶级科研机构上,这不仅导致研究工作开展困难,还使得模型无法推广到平民。这也间接导致了后面模型难以进行个性化的发展。

改进的具体方向:

- 从具体模型方面入手,采用更优的神经网络结构,损失函数,优化器,词向量编码。目前已经有少量的工作在这方面取得了一定的成绩,例如LLaMA。

- 与工具结合。在一些特定的场景,大模型仍然难以扩展,例如数学计算等。 一个大型语言模型再强也难以具备一个计算器的的数学运算能力。因此,与其不断努力为了保持性能而不降低模型规模,还不如研究如何将一些模型低耦合的能力分给其他工具实现,并如何将工具与大模型整合的技术。与工具结合这一方向详细展开可见第11点。

2.个性化

个性化是指模型为每个用户提供个性化服务。未来AGI必然是要普及的,所以模型如何实现个性化是一个重点研究方向。

导致的问题:

- 在许多场景,模型需要为个人或组织提供个性化服务。例如,在教育场景中,我们期望模型能够根据学生在学习方面的进步去理解并适应,给出学生不同阶段的学习帮助。同时针对不同的学生,模型需要给出不同的教学方法。再例如,在日常聊天场景中,模型面向小孩和大人的模型输出可能就不一样。针对小孩,模型不应该输出不适合未成年人的内容。同时,聊天中需要注意正确的引导孩子。

改进的具体方向:

- 元指令。这是《Sparks of Artificial General Intelligence: Early experiments with GPT-4》给出的一个方法。它的思路是每次通过指令输入的方法,让模型知道当前的用户是谁,之前和他说过什么,目前什么样的输出适合他。虽然这种方法局限性大且不够有效,但确实是最简单的一种思路,目前很火的AutoGPT就是这么干的,确实能够实现一部分个性化能力。

3.长期记忆

长期记忆指大模型需要记住长文本内容,形成新的认知,或类似人类具备情景记忆。这是大模型一个非常大的缺陷,也是实现AGI必然要解决的问题。

导致的问题:

- 模型无法应对需要长期记忆的场景。例如当使用大模型阅读一本书,模型阅读第2章内容时可能第一章内容就忘了。虽然目前GPT-4一次输入支持的最大token数已经提升到25000,但想实现阅读一本书,仍然非常困难。再例如,目前已经有工作研究将机器人与ChatGPT结合,而此时机器人有个很大问题是无法类似人类具备事件记忆,无法记住什么时候发生了什么事,遇见了什么人。

改进的具体方向:

- 结合数据库或知识图谱相关技术。目前AutoGPT就采用了这种方法,确实具备了一部分长期记忆能力。

- 构建一个长期记忆模型M并结合数据库技术。类似的想法目前清华有做类似的工作ChatDB。

4.置信校准

置信校准指的是模型需要判断事件的真假。当前LLM经常会输出假事实,例如,你让LLM写一首李白的诗,它的输出虽然是诗,但却是它自己瞎编的而不是李白的。你让他给你一篇关于XX领域的参考文献,它的输出像模像样,但真的去谷歌学术上找,发现是找不到对应的文献的。

导致的问题:

- LLM无法分别是非,它的认知主要基于训练集,不会自己去思考和判断什么是真什么是假。在实际使用的过程中,无法输出保真答案。

改进的具体方向:

无

5.持续学习

持续学习指的是模型需要根据周围的环境更新自身。模型训练好一次后,需要能够持续不断地学习。

导致的问题:

- 当前模型无法更新。具体地,存在两种情况。第一种,当一个模型训练好后,假设我们的计算资源得到了更新,我们当前需要一个更大的模型。此时,当前LLM面临的情况是在一个参数量更大的模型上完全重新训练;第二种,当模型在使用时,我们目前比较好的方式是使用RLHF的方法进行微调,使得模型能够一定程度上得到更新,但这种方式不是实时的,而且更新效率低需要对整个模型进行调节。

改进的具体方向:

无

6.计划和目标

计划和目标指模型需要具备制定计划和目标的能力。

导致的问题:

- 当模型需要处理的问题复杂时,模型无法制定计划和目标对问题进行简化,进而有效地解决问题。例如,人完成去华山旅游这件事时,需要把这个目标进行分解,再依次完成。比如,首先需要检查自己有多少钱,然后搜索去的交通工具,接着需要订酒店,购买上山物资,再接着规划行动路线,最后坐车回家。其中里面的每个环节可能又可分成多个步骤。比如,订酒店要考虑价格和位置,考虑订几人房等。这么一个复杂目标需要合适的计划,并制定一系列的目标实现。

- 另外一方面,模型无法指定提升自己的目标导致无法主动学习,进而使得模型性能无法离线提升。

改进的具体方向:

- 指令提示+短期记忆:目前AutoGPT就采取了类似的方式实现,它将一个任务不断通过prompt的方式进行提示和拆解,最终指定多个子目标,一步一步实现。这种方式能够一定程度上实现模型的规划和目标能力。

7.数据集收集和生成

数据集收集和生成指模型需要配合合适的数据集收集和生成方法。

导致的问题:

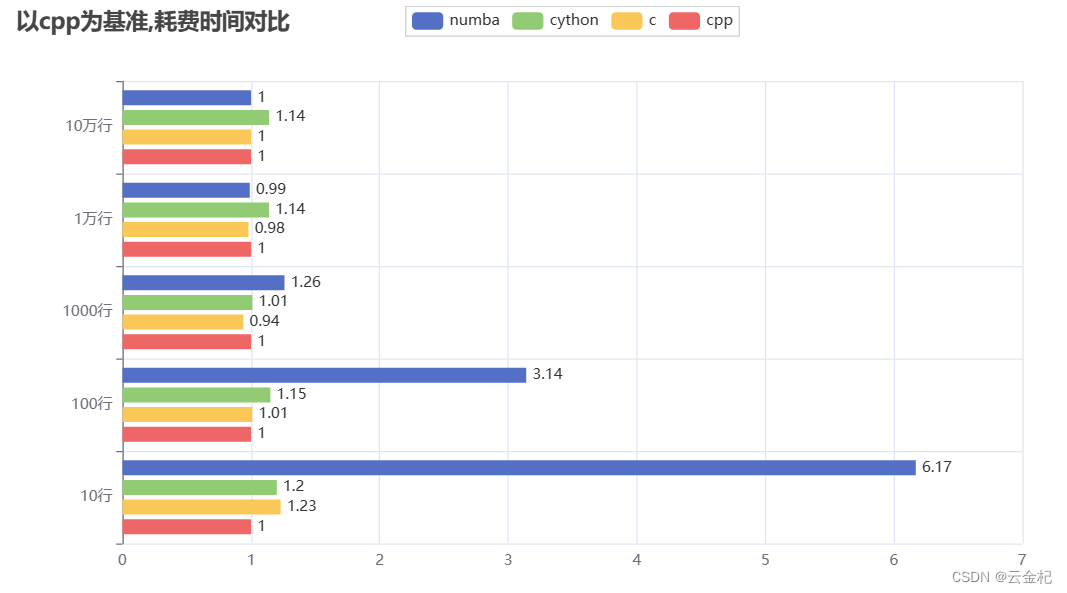

- 模型性能不高。近期,LLaMA等大模型论文中已经显示,即使是规模小的大模型,扩大数据集也能帮助进一步提升性能。反过来讲,通过合适的方式收集或生成数据,并进一步用于训练模型可以有效地提升大模型的性能。

改进的具体方向:

- 针对数据集收集,可以重点研究模型自主上网收集数据能力。最终,让模型可以在网络上自主收集数据并用于训练提升性能。

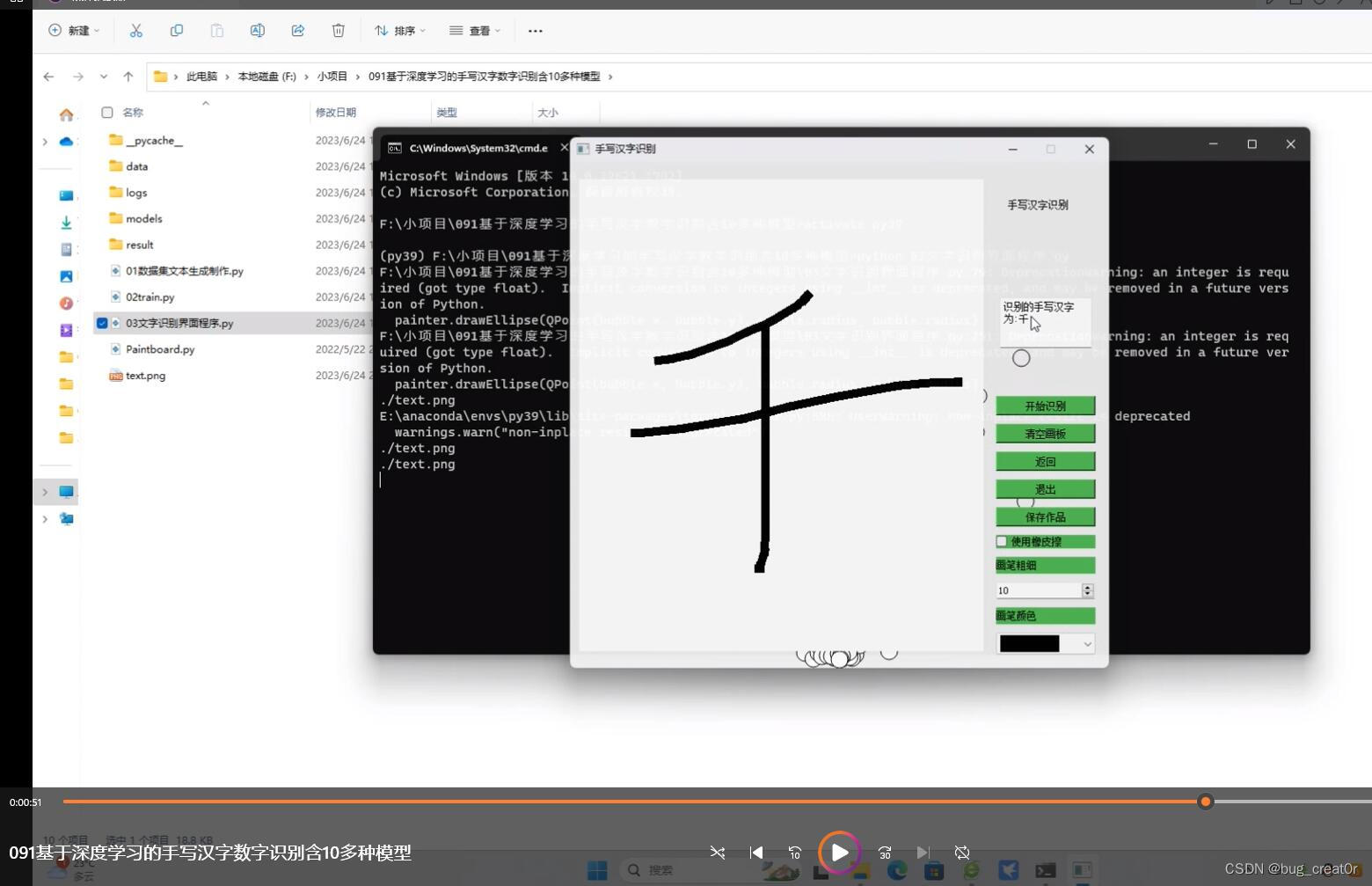

- 针对数据集生成,可以借助已有的LLM模型生成数据集,帮助提升性能,例如WizardLM模型或Wizardcode,下图给出了一个Wizardcode利用LLM生成针对Code领域的数据的例子。另外,可以研究让模型自动生成数据,再用生成数据训练模型,不断迭代增强性能。最近facebook在计算机视觉领域发表了一篇针对图像分割的论文。其中提到一个名为数据引擎的数据生成方法,使得数据生成和模型训练变成一个闭环,达到了“分割万物”的惊艳结果。

8.情感能力

情感能力指模型需要提升情感能力来帮助提升表现。

导致的问题:

- 不仅影响平时的模型表现,还导致无法应用于一些需要情感的场景。例如,在与人聊天的时候,如果对方是一个失恋的人。一个带感情的回答,必然优于平铺直叙地讲道理或安慰。未来的宠物机器人或是机器人管家的也是重点研究方向,而这些场景显然需要LLM发展情感能力。

改进的具体方向:

无

9.增强多模态

增强多模态指LLM模型同时考虑处理文本、图像、音频等。

导致的问题:

- 现有模型主要处理文本,少数可以同时处理图像(GPT-4)。因此,缺乏了音频数据的处理,例如,一个大模型无法判断一首歌好不好听。

改进的具体方向:

- 针对不同的多模态训练不同的模型再进行整合。

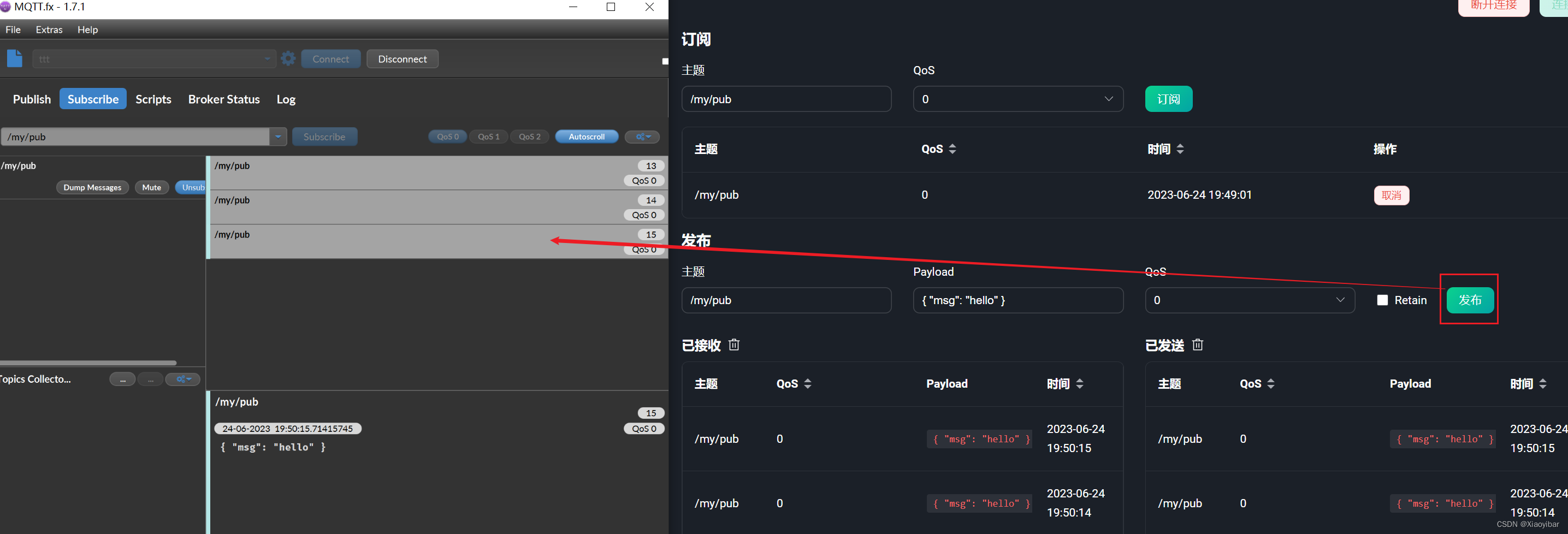

10.与现有软件工具结合

微信、淘宝、美团、QQ音乐、12306等。

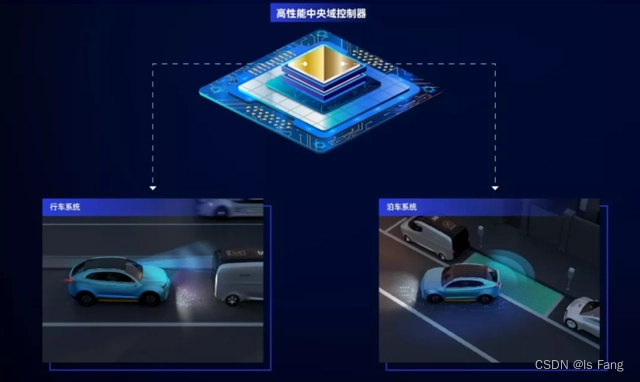

11.与现有硬件工具结合

机器人手臂,仿生人皮肤,红外线,NFC。

12.自我认知和世界认知

没有自我认知何谈置信校准。没有世界认知如何消除偏见。

导致的问题:

- 目前LLM与AGI最大的差距其实是仍然是自我认知和世界认知。

改进的具体方向:

无

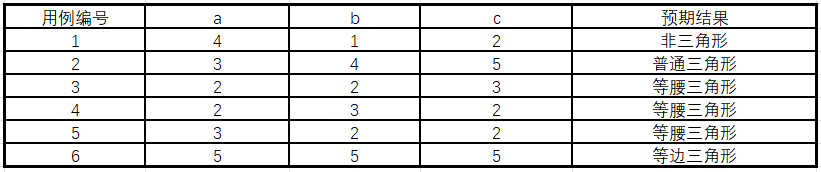

13.AGI的测试问题

目前多见于利用考试的方式,例如律师职业资格考试、GRE等。

14.AGI的安全问题和法律问题

暂时略过,读者可以看看《Planing for AGI and beyond》