文章目录

- InvPT++: Inverted Pyramid Multi-Task Transformer for Visual Scene Understanding

- 摘要

- 本文方法

- 整体结构

- InvPT++ Encoder

- Task-Specific Preliminary Decoders

- Structure of InvPT++ Decode

- UP-Transformer Block

- Cross-Scale Self-Attention: Fusion Attention and Selective Attention

- 实验结果

InvPT++: Inverted Pyramid Multi-Task Transformer for Visual Scene Understanding

摘要

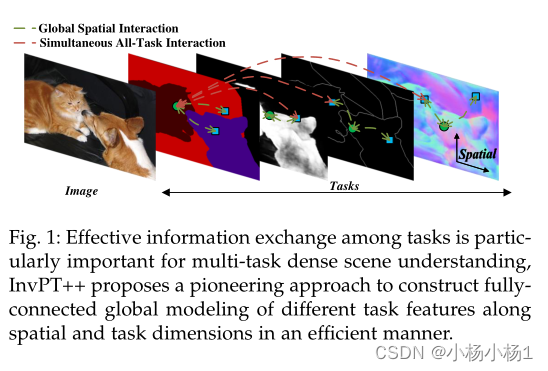

多任务场景理解旨在设计能够用一个通用模型同时预测多个场景理解任务的模型。先前的研究通常以更局部的方式处理多任务特征,因此无法有效地学习空间全局和跨任务的交互,这阻碍了模型在多任务学习中充分利用各种任务一致性的能力。

任务之间的有效信息交换对于多任务密集场景的理解尤为重要,InvPT++提出了一种开创性的方法,以高效的方式构建不同任务特征在空间和任务维度上的全连接全局建模。

本文方法

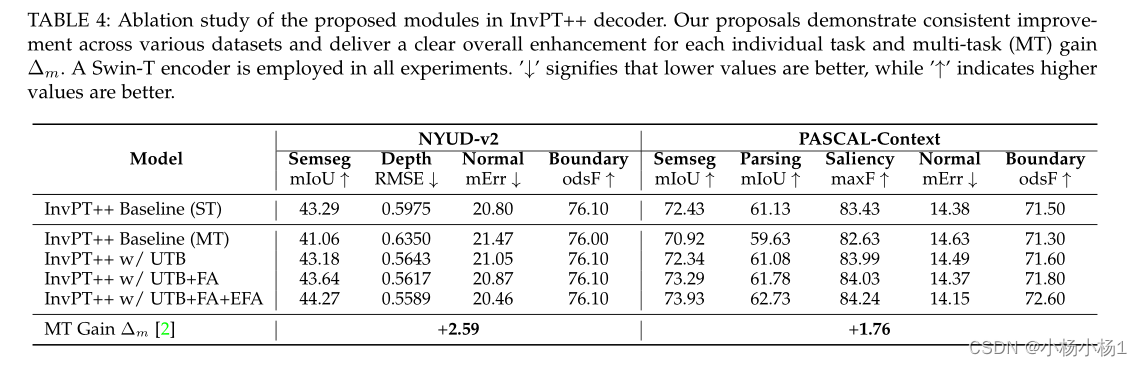

- 提出了一种倒金字塔多任务Transformer ,能够在全局背景下建模不同任务的空间特征之间的跨任务交互

- 首先使用Transformer 编码器来捕获所有任务的任务通用特征

- 然后,设计了一个Transformer 解码器来全局建立空间和跨任务交互,并设计了一种新的UPTransformer 来逐步提高多任务特征的分辨率,并在不同尺度上建立跨任务交互。

- 提出了两种类型的跨尺度自注意模块,即融合注意和选择性注意,以有效地促进不同特征尺度的跨任务交互。

- 进一步引入了编码器特征聚合策略,以更好地对解码器中的多尺度信息进行建模。

代码地址

本文方法

整体结构

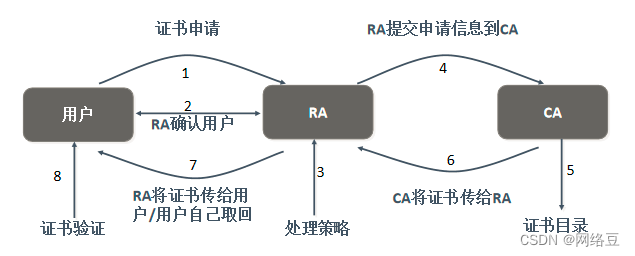

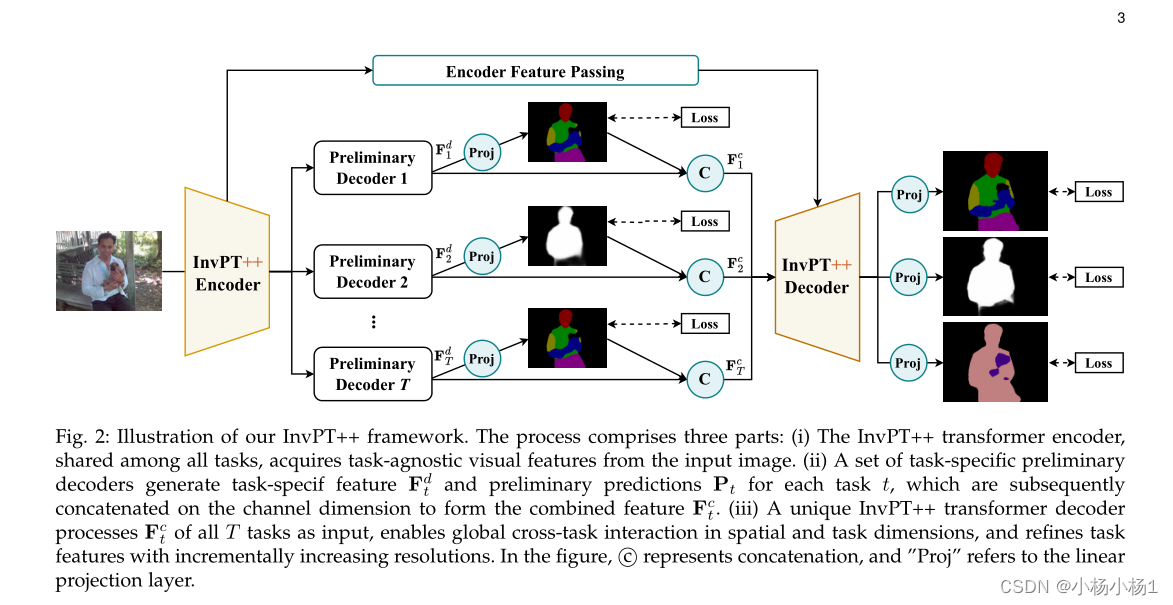

(i)在所有任务之间共享的InvPT++ transformer编码器从输入图像中获取与任务无关的视觉特征。

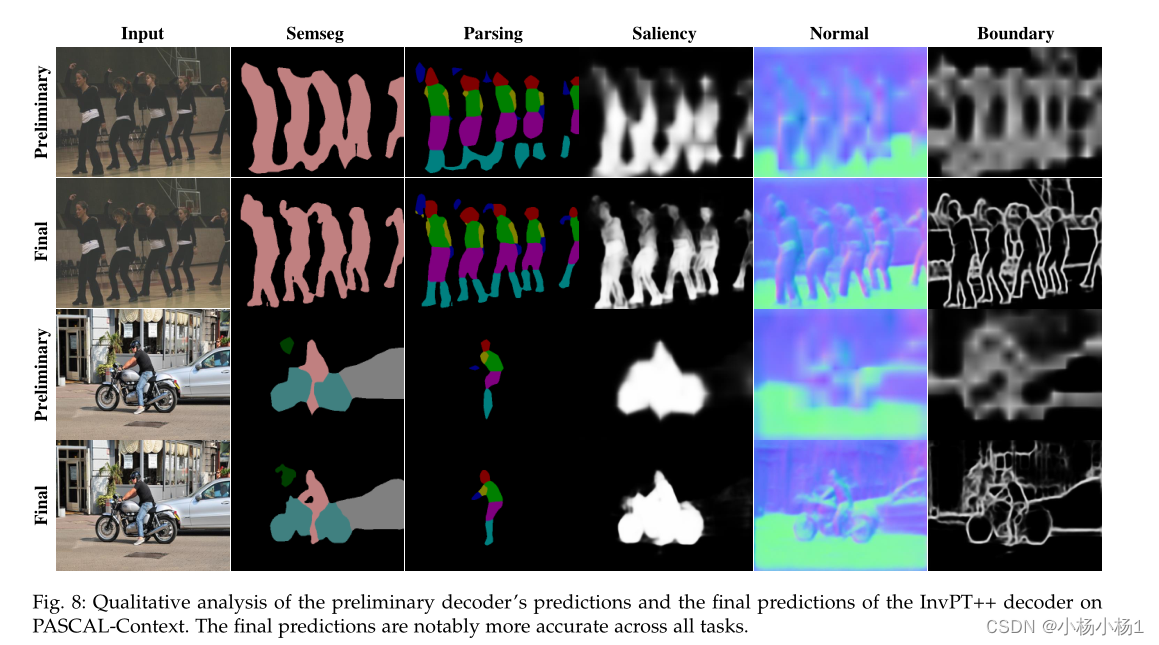

(ii)一组任务专用初步解码器生成每个任务专用特征Fdt和初步预测Pt,它们随后在通道维度上级联以形成组合特征Fct。

(iii)独特的InvPT++转换器解码器处理所有T个任务的Fct作为输入,实现空间和任务维度上的全局跨任务交互,并以递增的分辨率细化任务特征。

InvPT++ Encoder

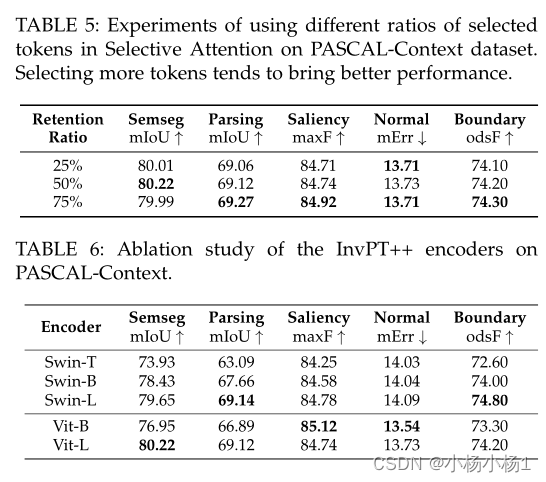

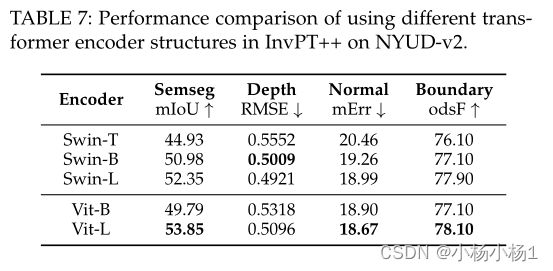

InvPT++编码器是一种transformer编码器,旨在提取给定图像的通用任务共享特征。在每个变换器层中,自注意模块通过对不同空间位置之间的长程空间依赖性建模来帮助学习全局特征表示。编码器产生一个特征序列,然后将其重塑为空间特征图。特征图的形状为H0×W0,其中H0和W0分别表示特征图的高度和宽度。假设我们学习了T个任务,然后将从编码器获得的任务通用特征传递给T个初步解码器,以生成相应的T个特征图。在实验中,我们探索了不同的编码器选择,例如,具有全局注意力的ViT和具有窗口注意力的Swin Transformer。

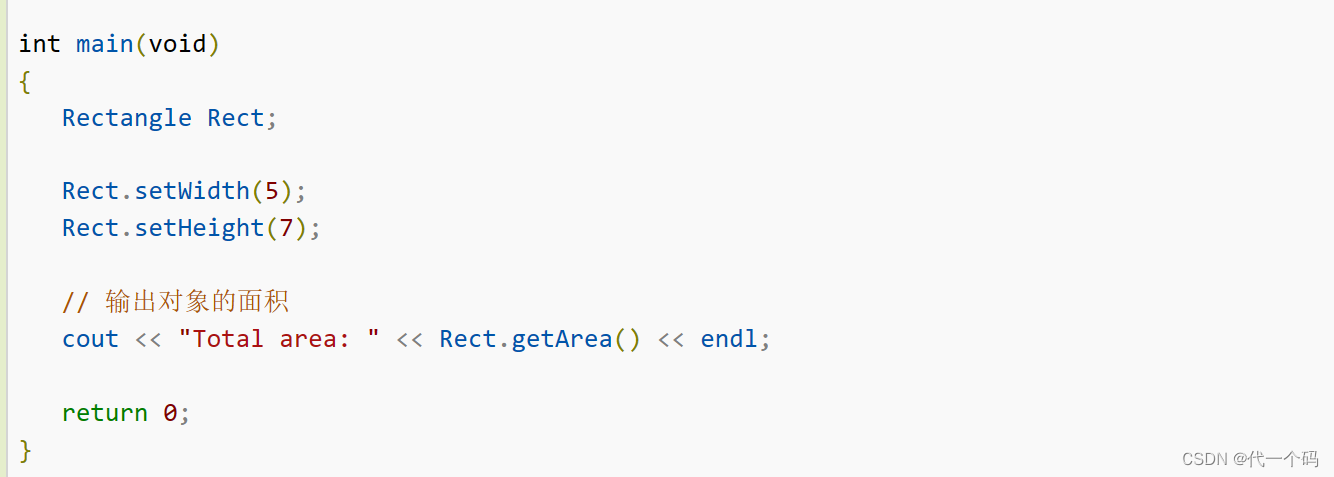

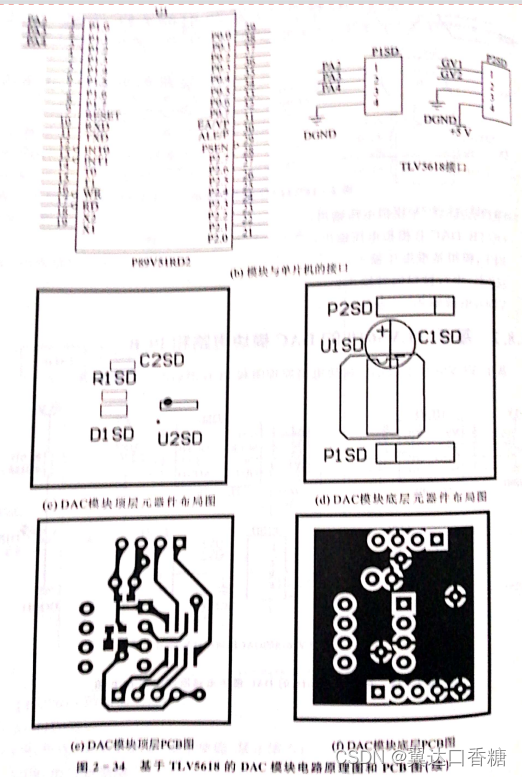

Task-Specific Preliminary Decoders

任务专用初步解码器的功能是生成不同任务的任务专用特征和粗略预测。为了实现这一点,我们构造了一个基本单元,该基本单元由具有3×3内核的卷积层、批处理归一化操作和ReLU组成,表示为“Conv BN ReLU”。每个任务的预备解码器由两个Conv BN ReLU单元组成。它接受编码器功能作为输入,并为相应的任务提供特定于任务的功能

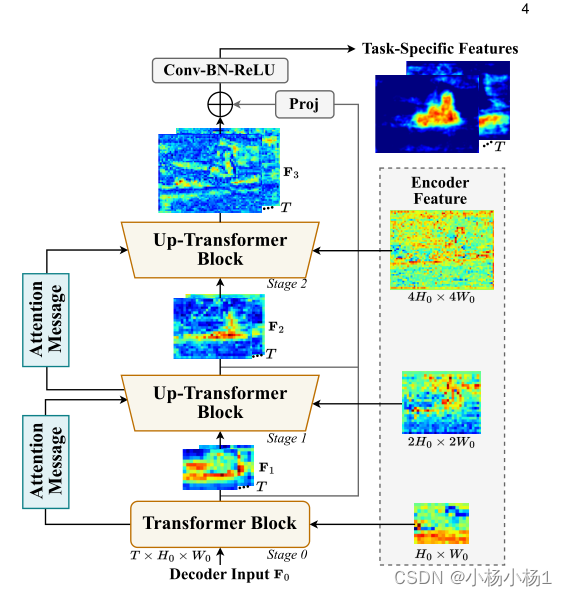

Structure of InvPT++ Decode

InvPT++解码器的设计。它由三个阶段组成,每个阶段通过专门设计的transformer块,在不同尺度上对空间全局上下文中所有任务的特征之间的跨任务交互进行全局建模。多任务令牌序列的空间分辨率在不同阶段逐渐提高,每个阶段的注意力信息传递到下一阶段,以实现跨规模的跨任务交互。多尺度编码器功能用于帮助学习InvPT++解码器中的多尺度信息。

小结:多尺度,高分辨率,任务特征之间的交互

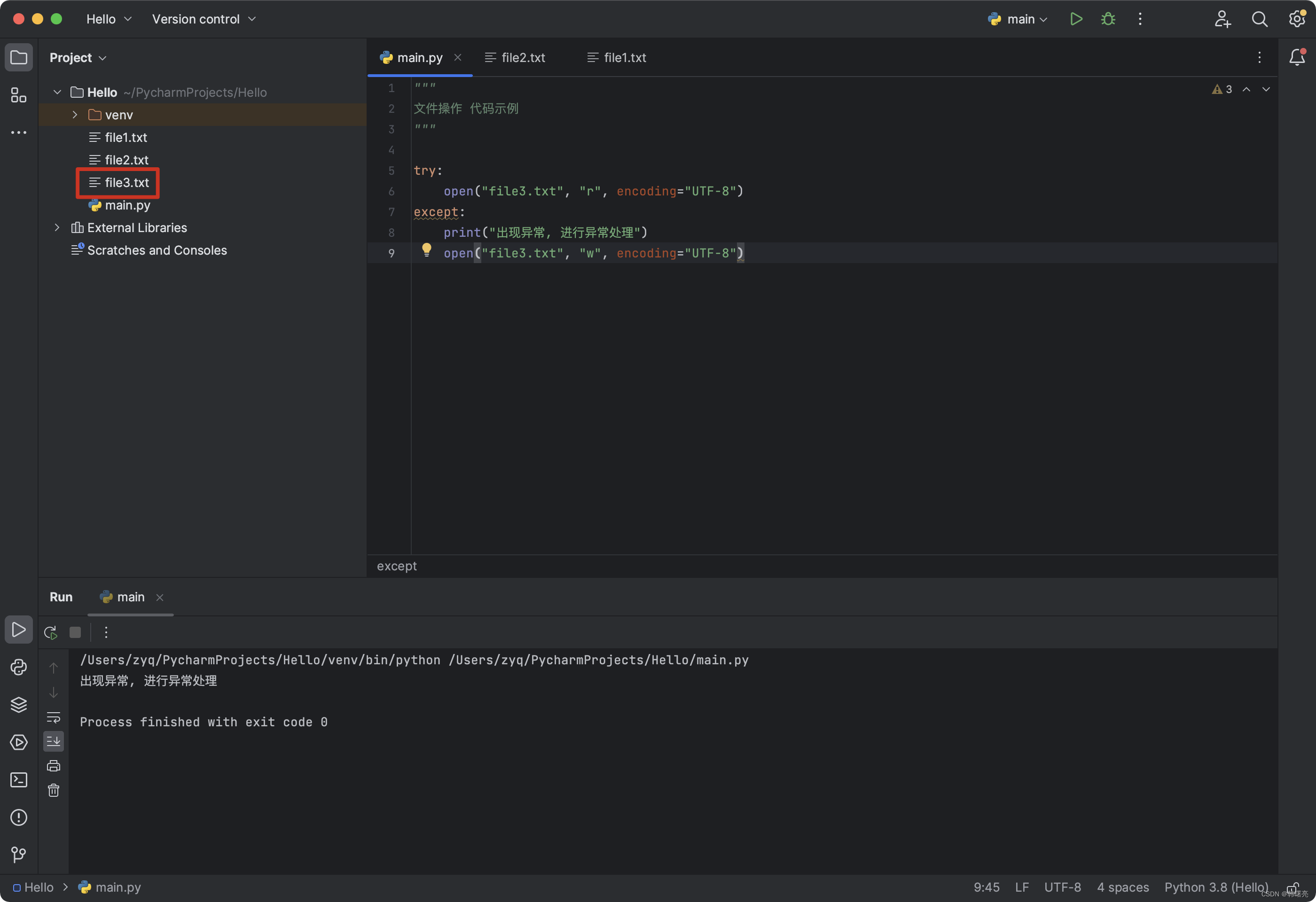

UP-Transformer Block

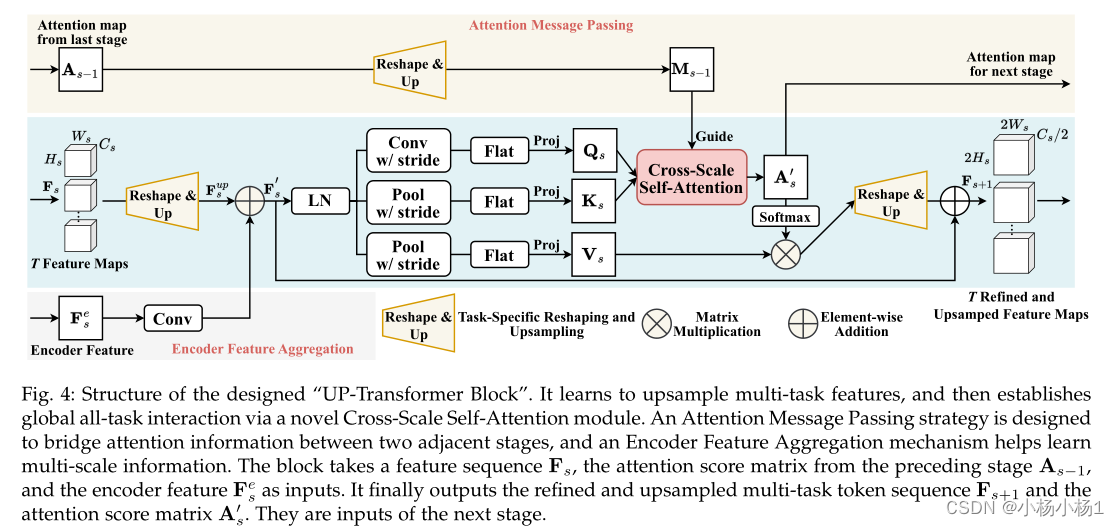

设计的“UP Transformer 块”的结构。

它学习对多任务特征进行上采样,然后通过一个新颖的跨尺度自注意模块建立全局全任务交互。

设计了一种注意力消息传递策略来桥接两个相邻阶段之间的注意力信息,编码器特征聚合机制有助于学习多尺度信息。该块采用特征序列Fs、来自前一阶段的注意力得分矩阵As−1和编码器特征Fes作为输入。它最终输出细化和上采样的多任务令牌序列Fs+1和注意力得分矩阵A′s。它们是下一阶段的投入。

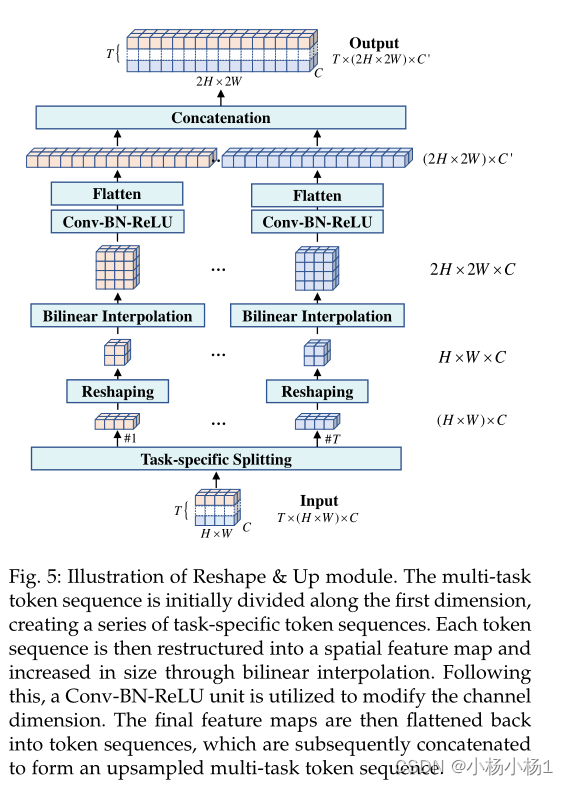

Reshape & Up模块示意图。多任务令牌序列最初沿着第一维度进行划分,从而创建一系列特定于任务的令牌序列。然后将每个令牌序列重构为空间特征图,并通过双线性插值增加大小。在此之后,使用Conv BN ReLU单元来修改信道维度。然后,将最终的特征图展平为令牌序列,随后将其连接以形成上采样的多任务令牌序列。

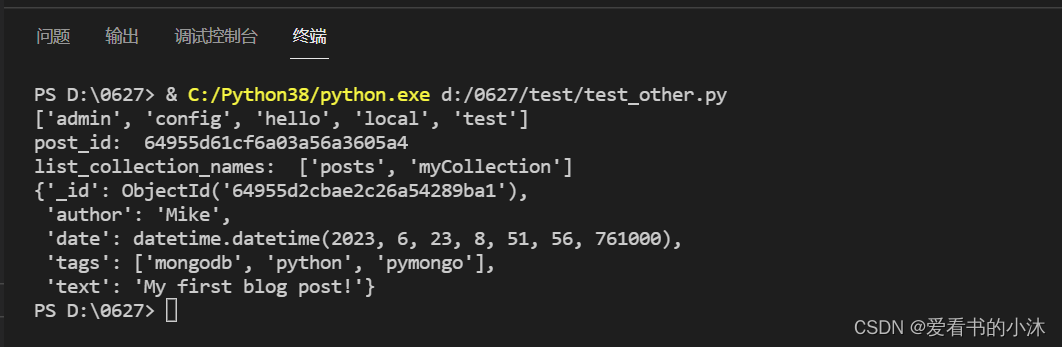

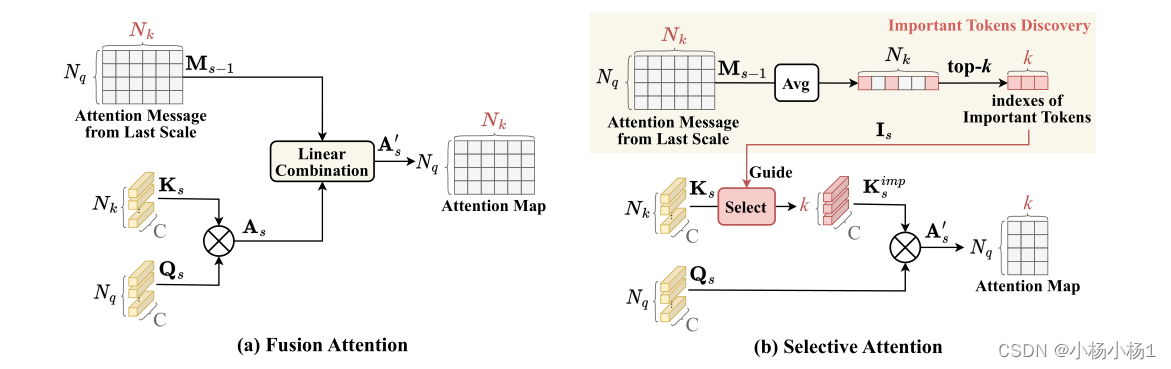

Cross-Scale Self-Attention: Fusion Attention and Selective Attention

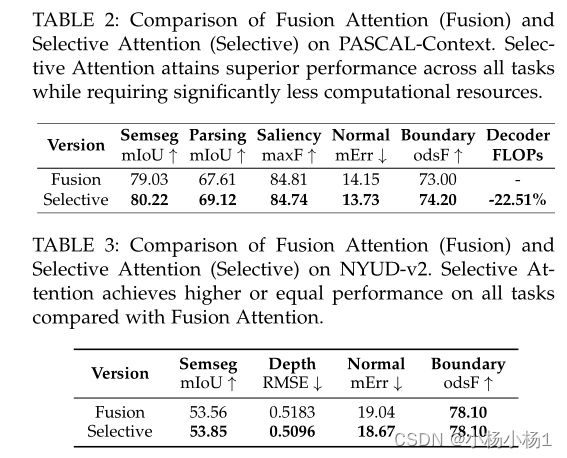

图示两种类型的跨尺度自我注意模块:融合注意和选择性注意。(a) 融合注意力将来自前一层的跨尺度注意力消息与当前阶段的注意力图合并。这促进了跨不同层次的自我注意模块的学习过程。(b) 相比之下,选择性注意建议使用早期量表中的注意信息作为指导,以确定自注意计算中的重要标记,这大大减少了计算冗余。它在关注消息中选择具有最高平均值的前k个令牌,并在当前阶段的自我关注计算中仅包含这k个令牌

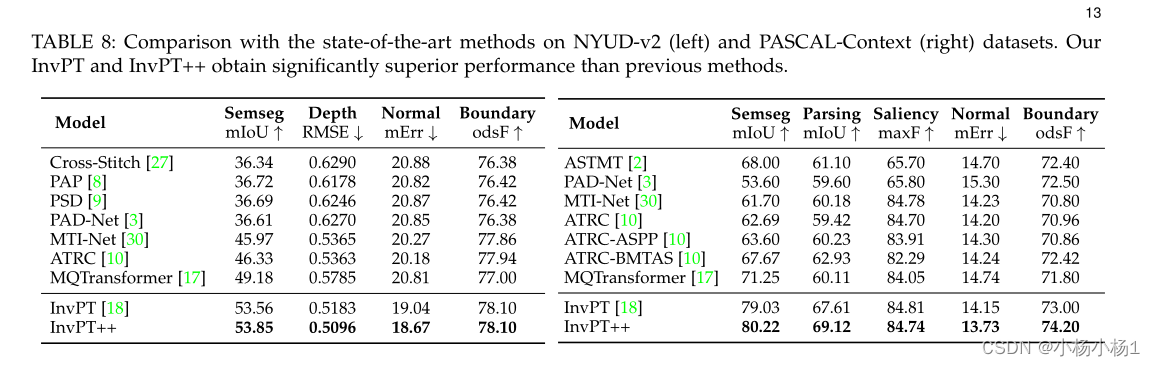

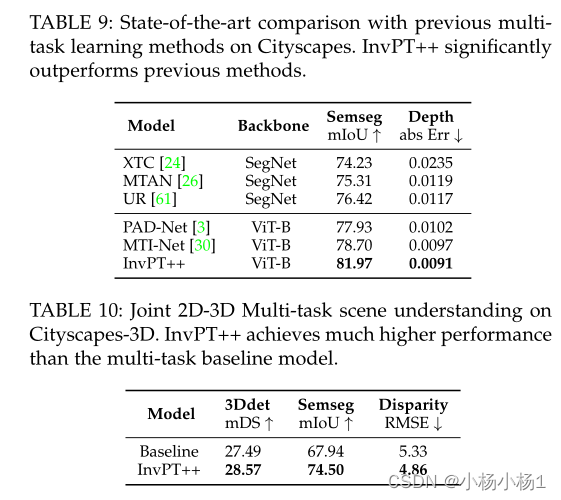

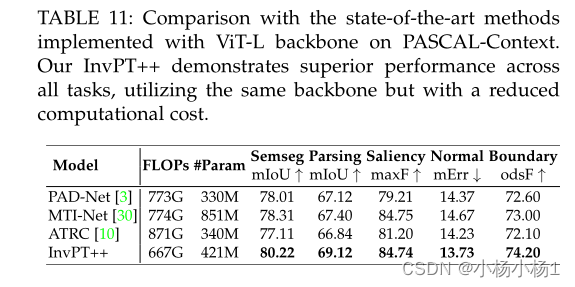

实验结果