文章目录

- 1. 创建Maven项目

- 2. 添加相关依赖

- 3. 创建日志属性文件

- 4. 启动集群HDFS服务

- 5. 在HDFS上创建文件

- 6. 写入HDFS文件

- 6.1 将数据直接写入HDFS文件

- 6.2 将本地文件写入HDFS文件

- 7. 读取HDFS文件

- 7.1 读取HDFS文件直接在控制台显示

- 7.2 读取HDFS文件,保存为本地文件

- 8. 重命名目录或文件

- 8.1 重命名目录

- 8.2 重命名文件

- 9. 显示文件列表

- 9.1 显示指定目录下文件全部信息

- 9.2 显示指定目录下文件路径和长度信息

- 10. 获取文件块信息

- 11. 创建目录

- 12. 判断目录或文件是否存在

- 13. 判断Path指向目录还是文件

- 14. 删除目录或文件

- 14.1 删除文件

- 14.2 删除目录

- 14.3 删除目录或文件

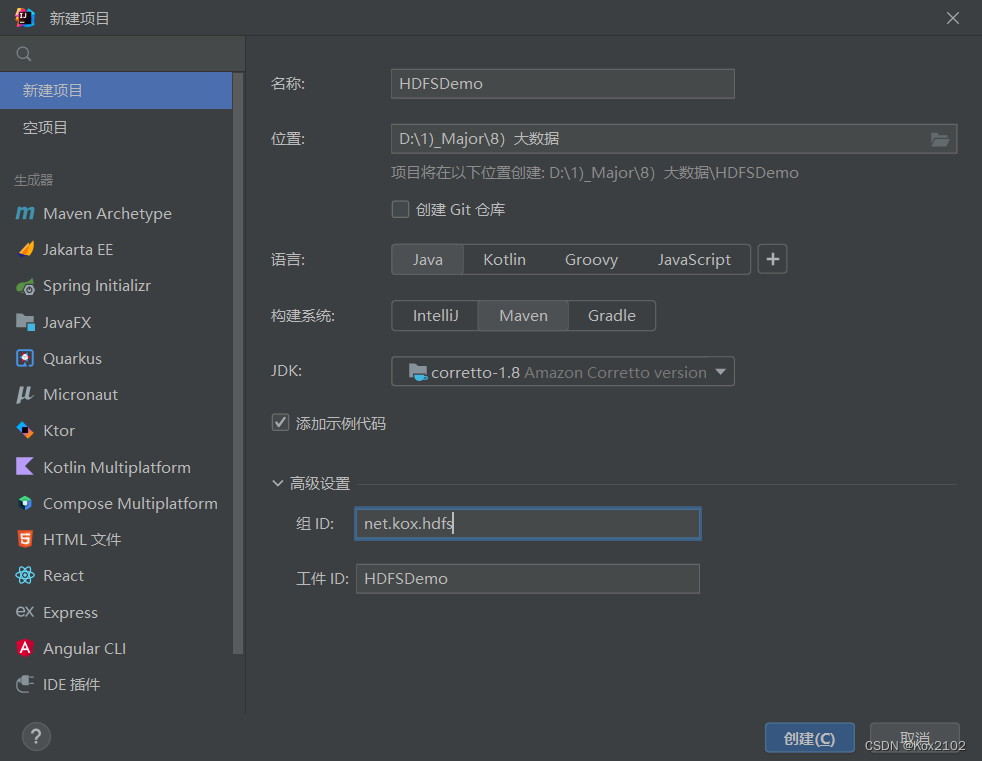

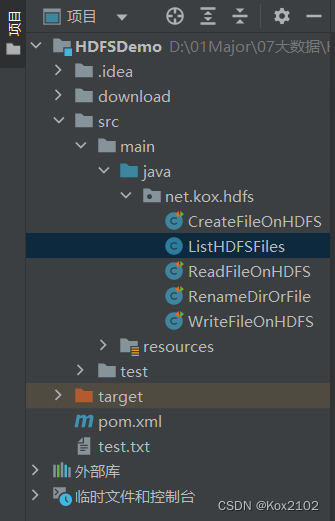

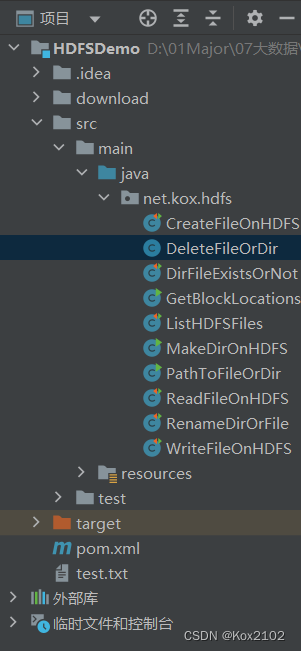

1. 创建Maven项目

- 创建Maven项目 - HDFSDemo

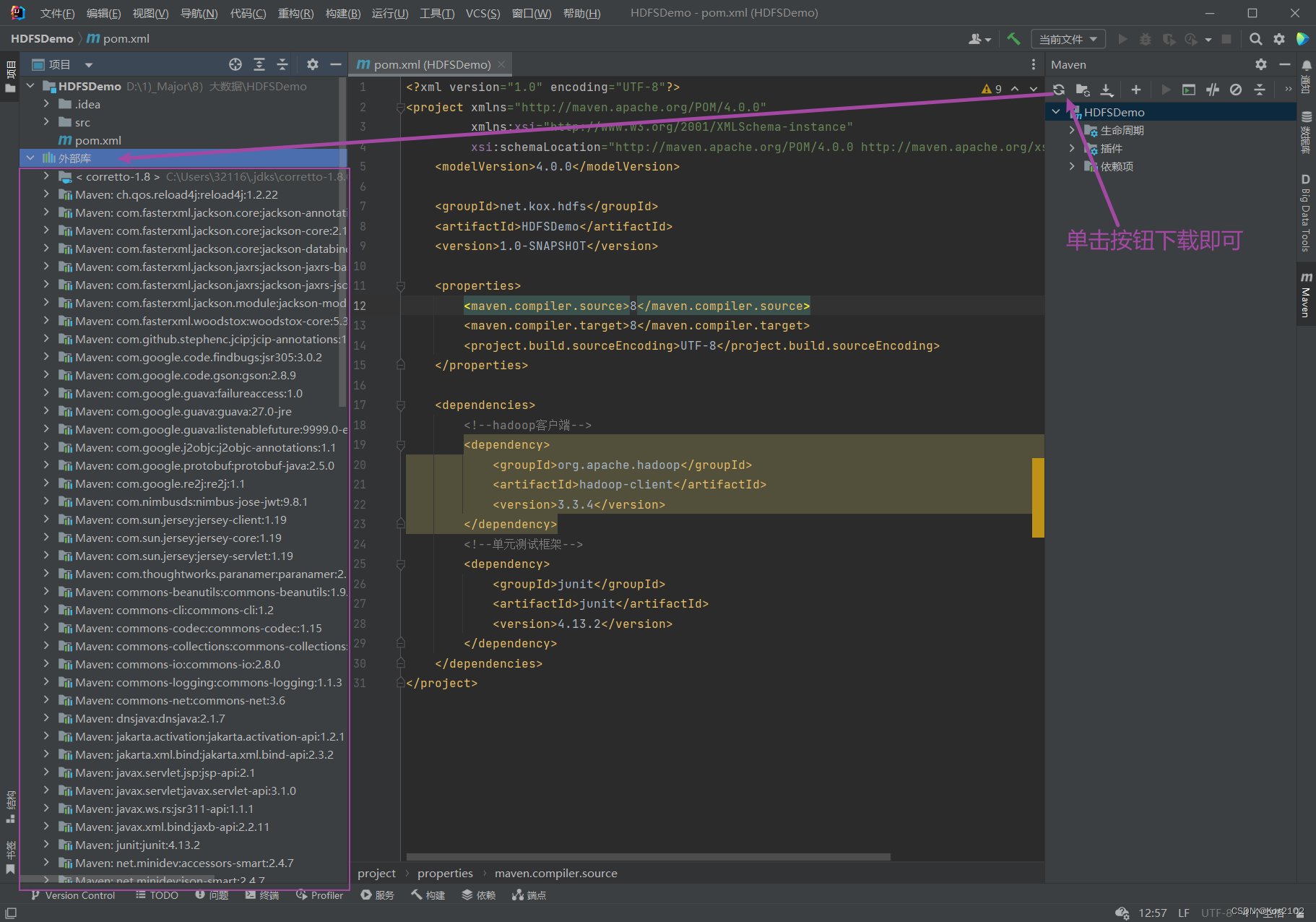

2. 添加相关依赖

- 在pom.xml文件里添加hadoop和junit依赖

<dependencies>

<!--hadoop客户端-->

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>3.3.4</version>

</dependency>

<!--单元测试框架-->

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>4.13.2</version>

</dependency>

</dependencies>

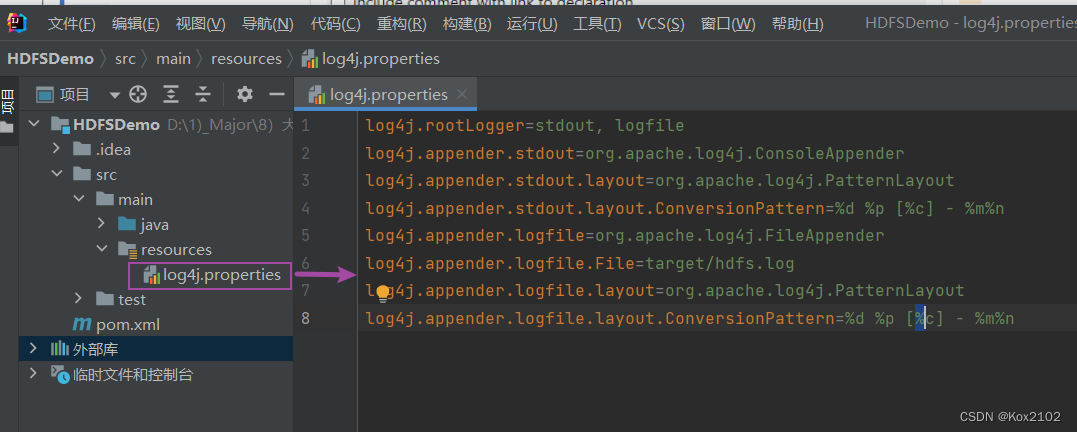

3. 创建日志属性文件

- 在resources目录里创建log4j.properties文件

log4j.rootLogger=stdout, logfile

log4j.appender.stdout=org.apache.log4j.ConsoleAppender

log4j.appender.stdout.layout=org.apache.log4j.PatternLayout

log4j.appender.stdout.layout.ConversionPattern=%d %p [%c] - %m%n

log4j.appender.logfile=org.apache.log4j.FileAppender

log4j.appender.logfile.File=target/hdfs.log

log4j.appender.logfile.layout=org.apache.log4j.PatternLayout

log4j.appender.logfile.layout.ConversionPattern=%d %p [%c] - %m%n

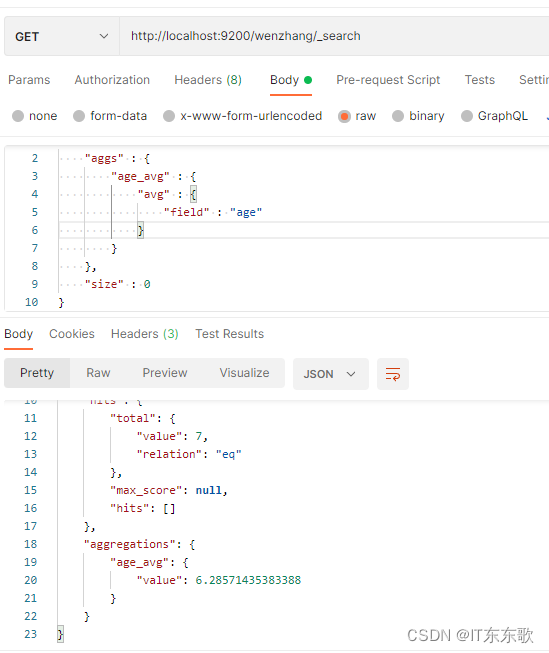

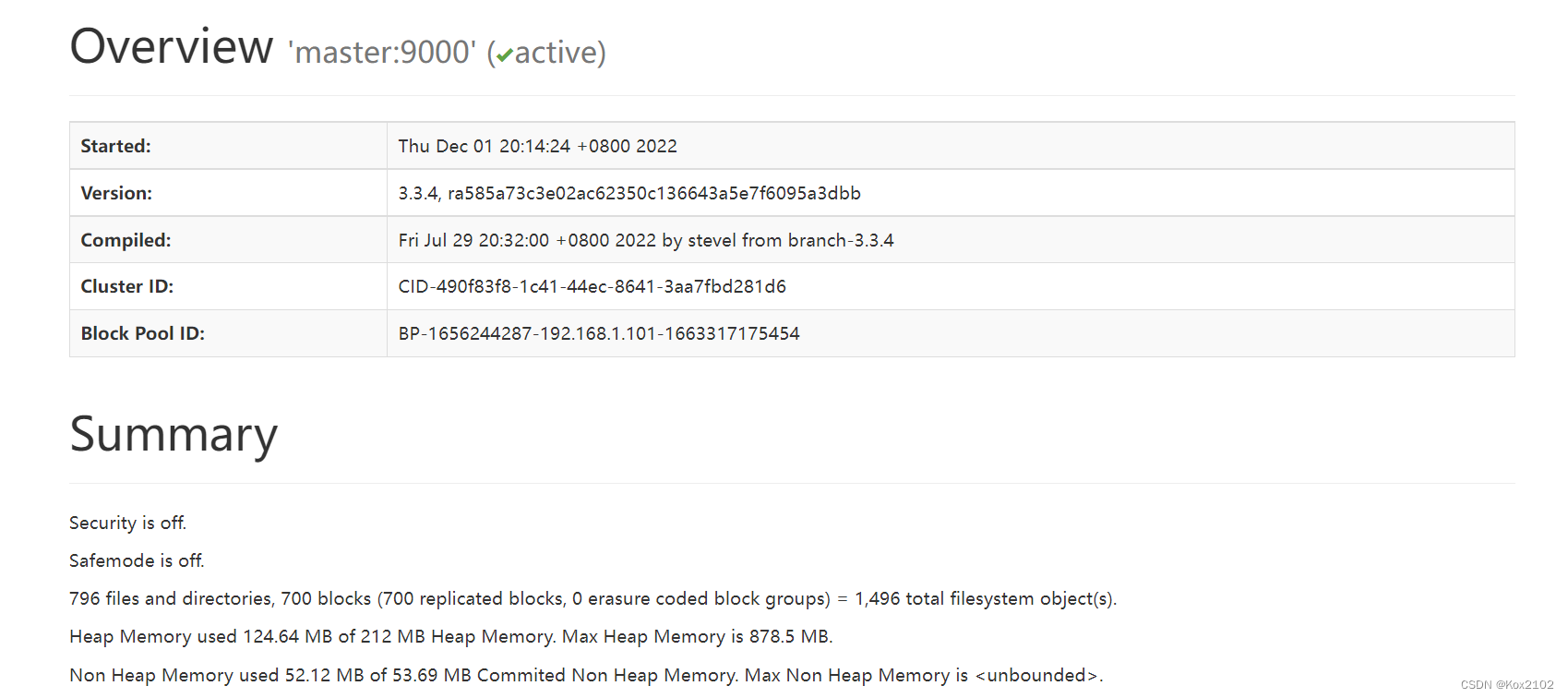

4. 启动集群HDFS服务

- 执行命令:

start-dfs.sh - 在Hadoop WebUI界面查看:

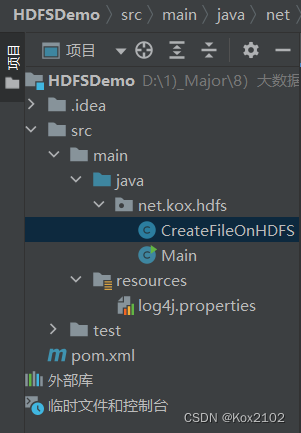

5. 在HDFS上创建文件

- 创建net.kox.hdfs包,在包里创建CreateFileOnHDFS类

- 编写create1()方法:

package net.kox.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.junit.Test;

import java.net.URI;

public class CreateFileOnHDFS {

@Test

public void create1() throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 定义统一资源标识符(uri:uniform resource identifier)

String uri = "hdfs://192.168.218.141:9000";

// 创建文件系统对象(基于HDFS的文件系统)

FileSystem fs = FileSystem.get(new URI(uri), conf);

// 创建路径对象(指向文件)

Path path = new Path(uri + "/ied01/hadoop.txt");

// 基于路径对象创建文件

boolean result = fs.createNewFile(path);

// 根据返回值判断文件是否创建成功

if (result) {

System.out.println("文件[" + path + "]创建成功!");

} else {

System.out.println("文件[" + path + "]创建失败!");

}

}

}

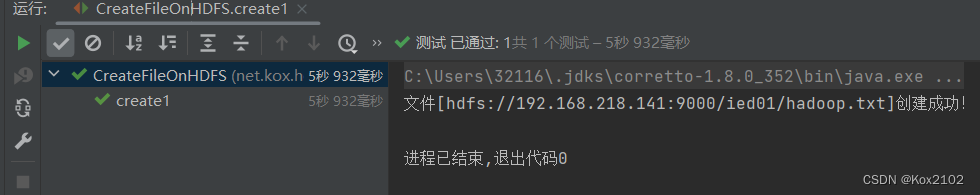

- 运行程序,查看结果:

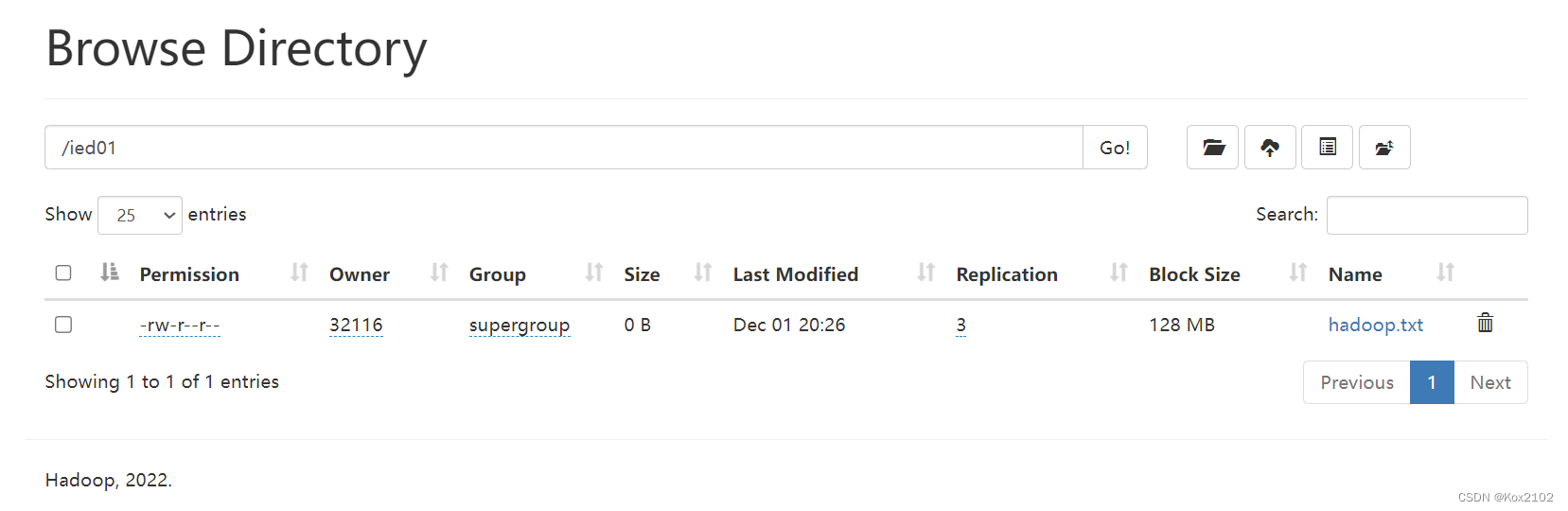

- 利用Hadoop WebUI查看:

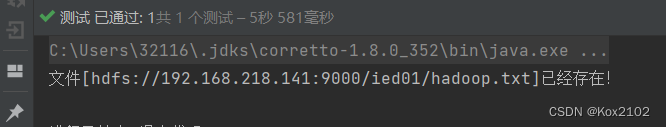

- 再次运行程序,由于hadoop.txt已经存在,此时会提示用户创建失败

- 由此编写create2()方法,事先判断文件是否存在

@Test

public void create2() throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 定义统一资源标识符(uri:uniform resource identifier)

String uri = "hdfs://192.168.218.141:9000";

// 创建文件系统对象(基于HDFS的文件系统)

FileSystem fs = FileSystem.get(new URI(uri), conf);

// 创建路径对象

Path path = new Path(uri + "/ied01/hadoop.txt");

// 判断路径对象指向的文件是否存在

if (fs.exists(path)) {

// 提示用户文件已存在

System.out.println("文件[" + path + "]已经存在!");

} else {

// 基于路径对象创建文件

boolean result = fs.createNewFile(path);

// 根据返回值判断文件是否创建成功

if (result) {

System.out.println("文件[" + path + "]创建成功!");

} else {

System.out.println("文件[" + path + "]创建失败!");

}

}

}

- 运行程序,查看结果:

6. 写入HDFS文件

- 类似于HDFS Shell里的hdfs dfs -put命令

- 在net.hw.hdfs包里创建WriteFileOnHDFS类

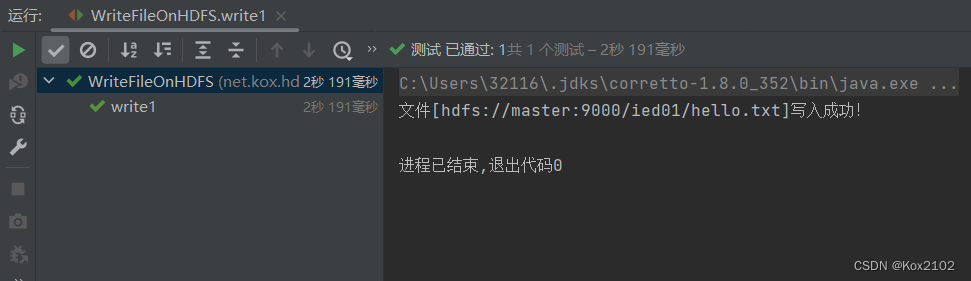

6.1 将数据直接写入HDFS文件

- 任务:在/ied01目录里创建hello.txt文件

- 创建write1()方法:

package net.kox.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataOutputStream;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.junit.Test;

import java.net.URI;

public class WriteFileOnHDFS {

@Test

public void write1() throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 定义统一资源标识符(uri: uniform resource identifier)

String uri = "hdfs://master:9000";

// 创建文件系统对象(基于HDFS的文件系统)

FileSystem fs = FileSystem.get(new URI(uri), conf);

// 创建路径对象(指向文件)

Path path = new Path(uri + "/ied01/hello.txt");

// 创建文件系统数据字节输出流(出水管:数据从程序到文件)

FSDataOutputStream out = fs.create(path);

// 通过字节输出流向文件写数据

out.write("Hello Hadoop World".getBytes());

// 关闭文件系统数据字节输出流

out.close();

// 关闭文件系统对象

fs.close();

// 提示用户写文件成功

System.out.println("文件[" + path + "]写入成功!");

}

}

-

运行程序,查看结果:

-

利用Hadoop WebUI查看hello.txt文件

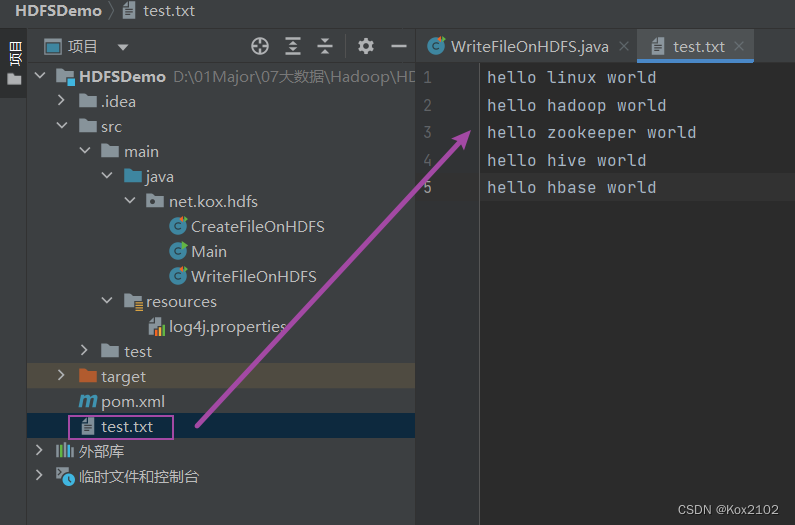

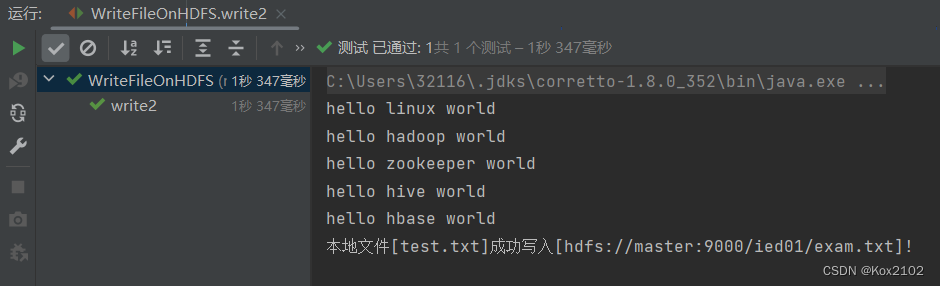

6.2 将本地文件写入HDFS文件

- 在项目根目录创建一个文本文件test.txt

- 创建write2()方法:

@Test

public void write2() throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname","true");

// 定义统一资源标识符

String uri = "hdfs://master:9000";

// 创建文件系统对象(基于HDFS的文件系统)

FileSystem fs = FileSystem.get(new URI(uri), conf, "root");

// 创建路径对象(指向文件)

Path path = new Path(uri + "/ied01/exam.txt");

// 创建文件系统数据字节输出流(出水管:数据从程序到文件)

FSDataOutputStream out = fs.create(path);

// 创建文件字符输入流对象(出水管:数据从文件到程序)

FileReader fr = new FileReader("test.txt");

// 创建缓冲字符输入流对象

BufferedReader br = new BufferedReader(fr);

// 定义行字符串变量

String nextLine = "";

// 通过循环遍历缓冲字符输入流

while ((nextLine = br.readLine()) != null) {

// 在控制输出读取的行

System.out.println(nextLine);

// 通过文件系统数据字节输出流对象写入指定文件

out.write(nextLine.getBytes());

}

// 关闭缓冲字符输入流

br.close();

// 关闭文件字符输入流

fr.close();

// 关闭文件习题数据字节输出流

out.close();

// 提示用户写入文件成功

System.out.println("本地文件[test.txt]成功写入[" + path + "]!");

}

- 运行write2()测试方法,查看结果:

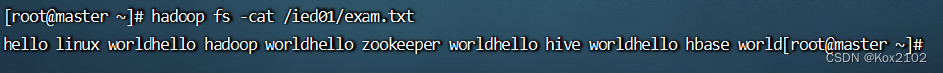

- 查看/ied01/exam.txt内容

7. 读取HDFS文件

7.1 读取HDFS文件直接在控制台显示

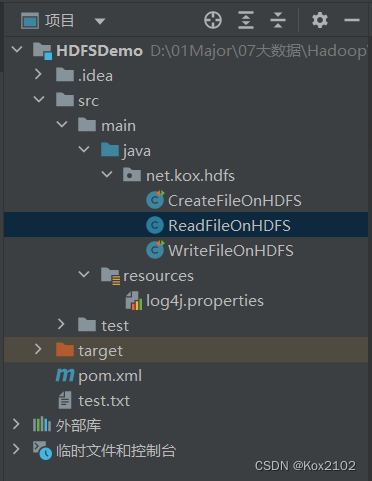

- 创建ReadFileOnHDFS类

- 编写read1()方法:

package net.kox.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataInputStream;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.junit.Test;

import java.io.BufferedReader;

import java.io.InputStreamReader;

import java.net.URI;

public class ReadFileOnHDFS {

@Test

public void read1() throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 定义统一资源标识符(uri: uniform resource identifier)

String uri = "hdfs://master:9000";

// 创建文件系统对象(基于HDFS的文件系统)

FileSystem fs = FileSystem.get(new URI(uri), conf, "root");

// 创建路径对象(指向文件)

Path path = new Path(uri + "/ied01/test.txt");

// 创建文件系统数据字节输入流(进水管:数据从文件到程序)

FSDataInputStream in = fs.open(path);

// 创建缓冲字符输入流,提高读取效率(字节流-->字符流-->缓冲流)

BufferedReader br = new BufferedReader(new InputStreamReader(in));

// 定义行字符串变量

String nextLine = "";

// 通过循环遍历缓冲字符输入流

while ((nextLine = br.readLine()) != null) {

// 在控制台输出读取的行

System.out.println(nextLine);

}

// 关闭缓冲字符输入流

br.close();

// 关闭文件系统数据字节输入流

in.close();

// 关闭文件系统

fs.close();

}

}

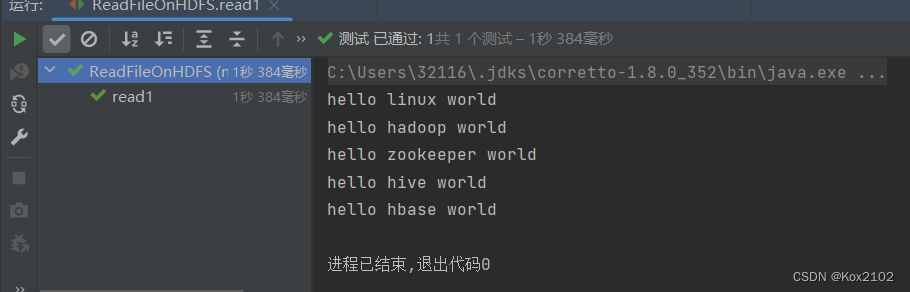

- 运行read1()测试方法,查看结果:

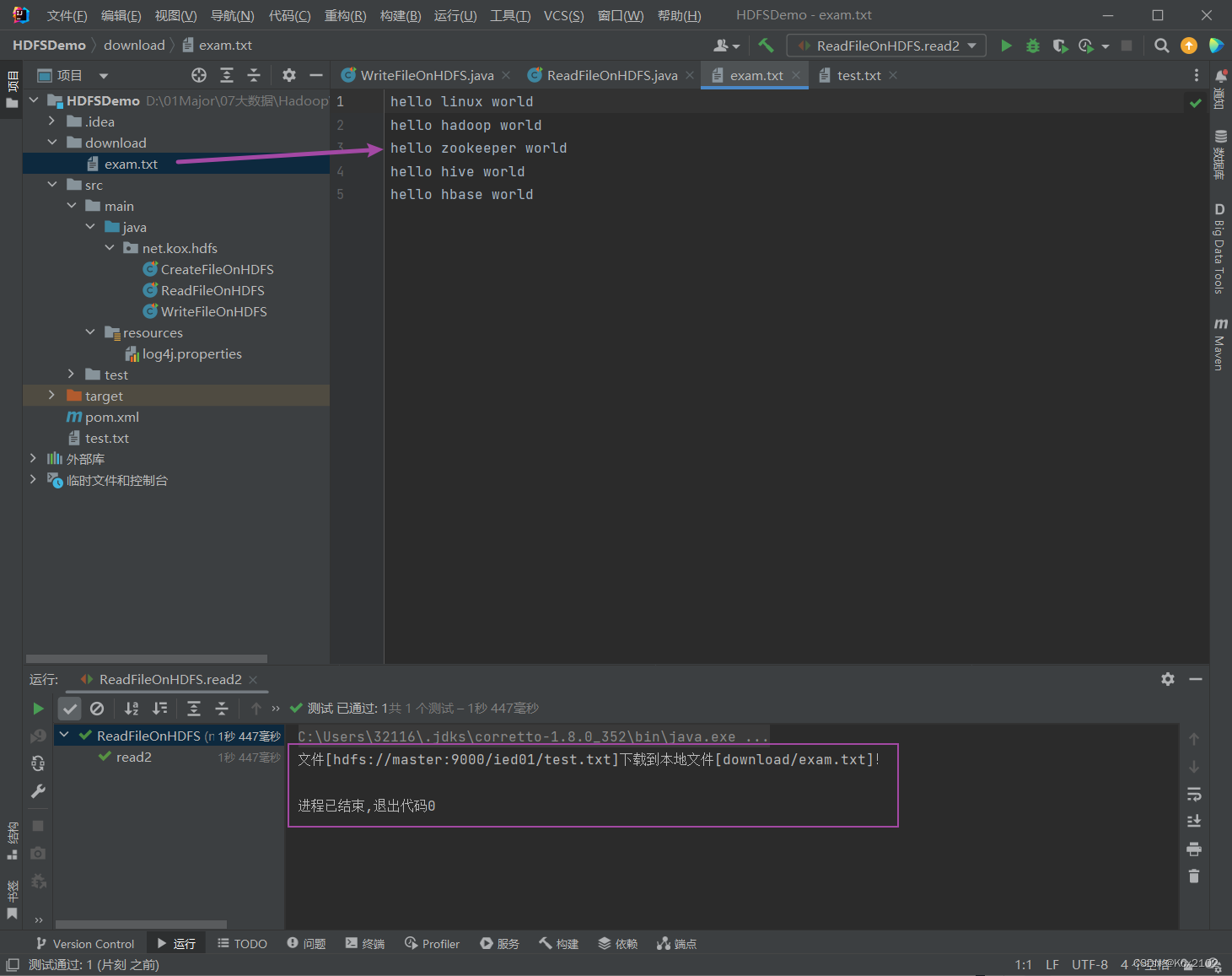

7.2 读取HDFS文件,保存为本地文件

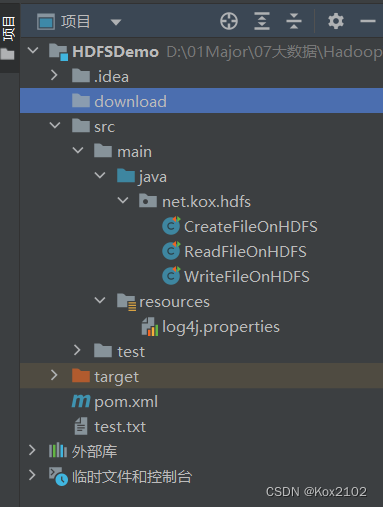

- 创建download目录:

- 创建 read2()方法:

@Test

public void read2() throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 定义统一资源标识符(uri: uniform resource identifier)

String uri = "hdfs://master:9000";

// 创建文件系统对象(基于HDFS的文件系统)

FileSystem fs = FileSystem.get(new URI(uri), conf, "root");

// 创建路径对象(指向文件)

Path path = new Path(uri + "/ied01/test.txt");

// 创建文件系统数据字节输入流(进水管:数据从文件到程序)

FSDataInputStream in = fs.open(path);

// 创建文件字节输出流(出水管:数据从程序到文件)

FileOutputStream out = new FileOutputStream("download/exam.txt");

// 利用IOUtils工具类读取HDFS文件(靠输入流),写入本地文件(靠输出流)

IOUtils.copyBytes(in, out, conf);

// 关闭文件字节输出流

out.close();

// 关闭文件系统数据字节流输入流

in.close();

// 关闭文件系统

fs.close();

// 提示用户文件下载成功

System.out.println("文件[" + path + "]下载到本地文件[download/exam.txt]!");

}

- 运行read2()测试方法,查看结果:

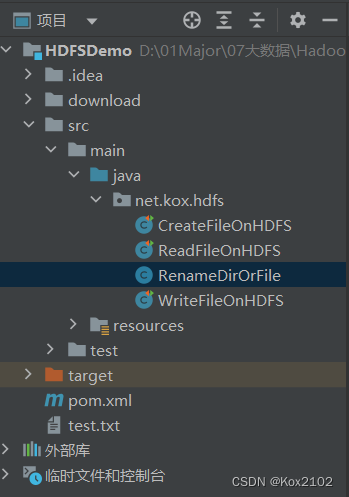

8. 重命名目录或文件

- 创建RenameDirOrFile类

8.1 重命名目录

- 将/ied01目录更名为/lzy01

- 编写renameDir()方法:

package net.kox.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.junit.Test;

import java.net.URI;

public class RenameDirOrFile {

@Test

public void renameDir() throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 定义统一资源标识符(uri: uniform resource identifier)

String uri = "hdfs://master:9000";

// 创建文件系统对象(基于HDFS的文件系统)

FileSystem fs = FileSystem.get(new URI(uri), conf, "root");

// 创建源路径对象(指向目录)

Path sourcePath = new Path(uri + "/ied01");

// 创建目标路径对象(指向目录)

Path destinationPath = new Path(uri + "/lzy01");

// 利用文件系统对象重命名目录

fs.rename(sourcePath, destinationPath);

// 关闭文件系统

fs.close();

// 提示用户目录更名成功

System.out.println("目录[" + sourcePath.getName() + "]更名为目录[" + destinationPath.getName() + "]!");

}

}

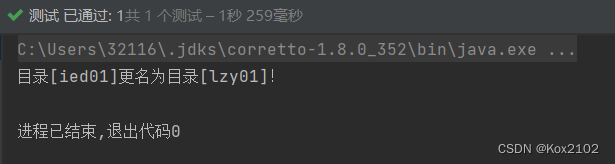

- 运行程序,查看结果:

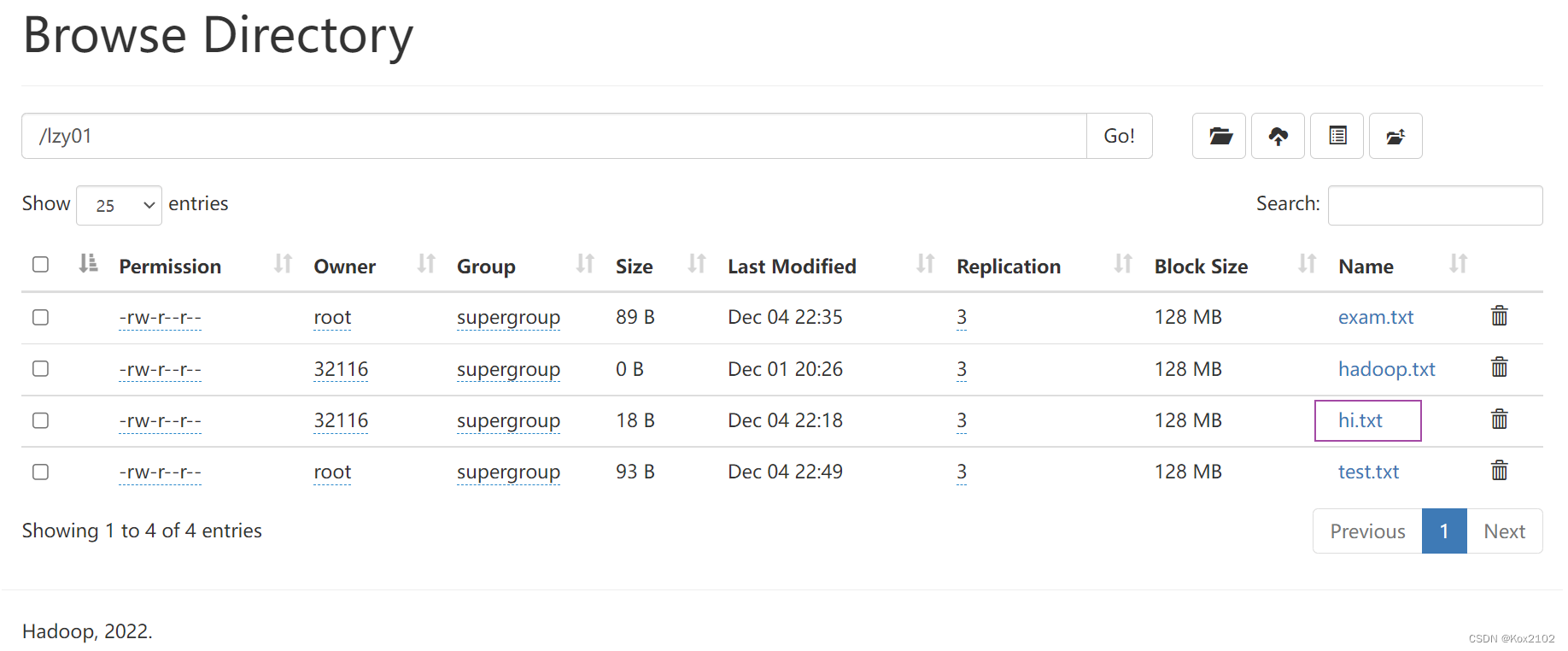

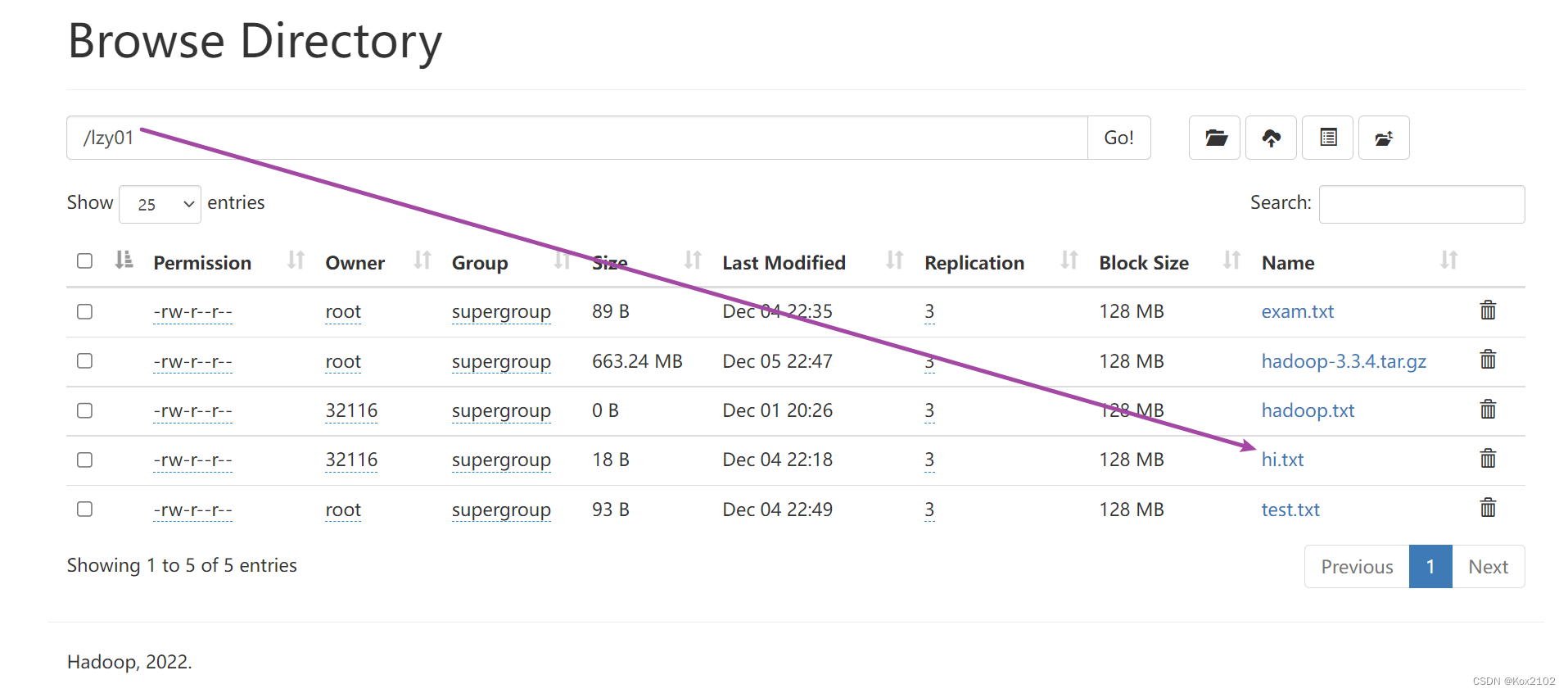

- 利用Hadoop WebUI界面查看:

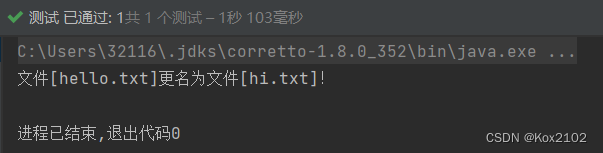

8.2 重命名文件

- 将lzy01目录下的hello.txt重命名为hi.txt

- 编写renameFile()方法:

@Test

public void renameFile() throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 定义统一资源标识符(uri: uniform resource identifier)

String uri = "hdfs://master:9000";

// 创建文件系统对象(基于HDFS的文件系统)

FileSystem fs = FileSystem.get(new URI(uri), conf, "root");

// 创建源路径对象(指向文件)

Path sourcePath = new Path(uri + "/lzy01/hello.txt");

// 创建目标路径对象(指向文件)

Path destinationPath = new Path(uri + "/lzy01/hi.txt");

// 利用文件系统对象重命名文件

fs.rename(sourcePath, destinationPath);

// 关闭文件系统

fs.close();

// 提示用户文件更名成功

System.out.println("文件[" + sourcePath.getName() + "]更名为文件[" + destinationPath.getName() + "]!");

}

- 运行程序,查看结果:

9. 显示文件列表

- 创建ListHDFSFiles类

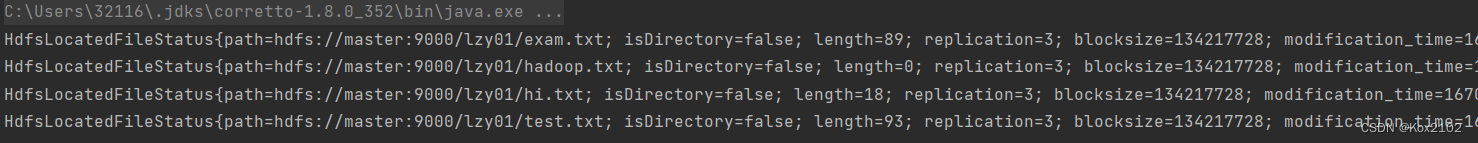

9.1 显示指定目录下文件全部信息

- 显示/lzy01目录下的文件列表

- 编写list1()方法:

package net.kox.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.LocatedFileStatus;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.fs.RemoteIterator;

import org.junit.Test;

import java.net.URI;

public class ListHDFSFiles {

@Test

public void list1() throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 定义uri字符串

String uri = "hdfs://master:9000";

// 创建文件系统对象

FileSystem fs = FileSystem.get(new URI(uri), conf, "root");

// 创建远程迭代器对象,泛型是位置文件状态类(相当于`hdfs dfs -ls -R /lzy01`)

RemoteIterator<LocatedFileStatus> ri = fs.listFiles(new Path("/lzy01"), true);

// 遍历远程迭代器

while (ri.hasNext()) {

System.out.println(ri.next());

}

}

}

- 运行程序,查看结果:

9.2 显示指定目录下文件路径和长度信息

- 编写list2()方法:

@Test

public void list2() throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 定义uri字符串

String uri = "hdfs://master:9000";

// 创建文件系统对象

FileSystem fs = FileSystem.get(new URI(uri), conf, "root");

// 创建远程迭代器对象,泛型式位置文件状态类(相当于‘hdfs dfs-ls-R /lzy01')

RemoteIterator<LocatedFileStatus> ri = fs.listFiles(new Path("/lzy01"), true);

// 遍历远程迭代器

while (ri.hasNext()) {

LocatedFileStatus lfs = ri.next();

System.out.println(lfs.getPath() + " " + lfs.getLen() + "字节");

}

}

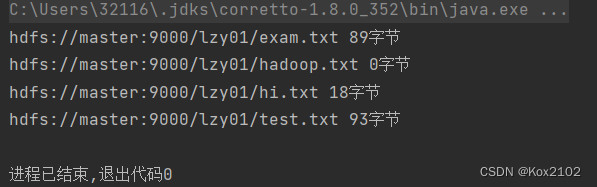

- 运行list2()测试方法,查看结果:

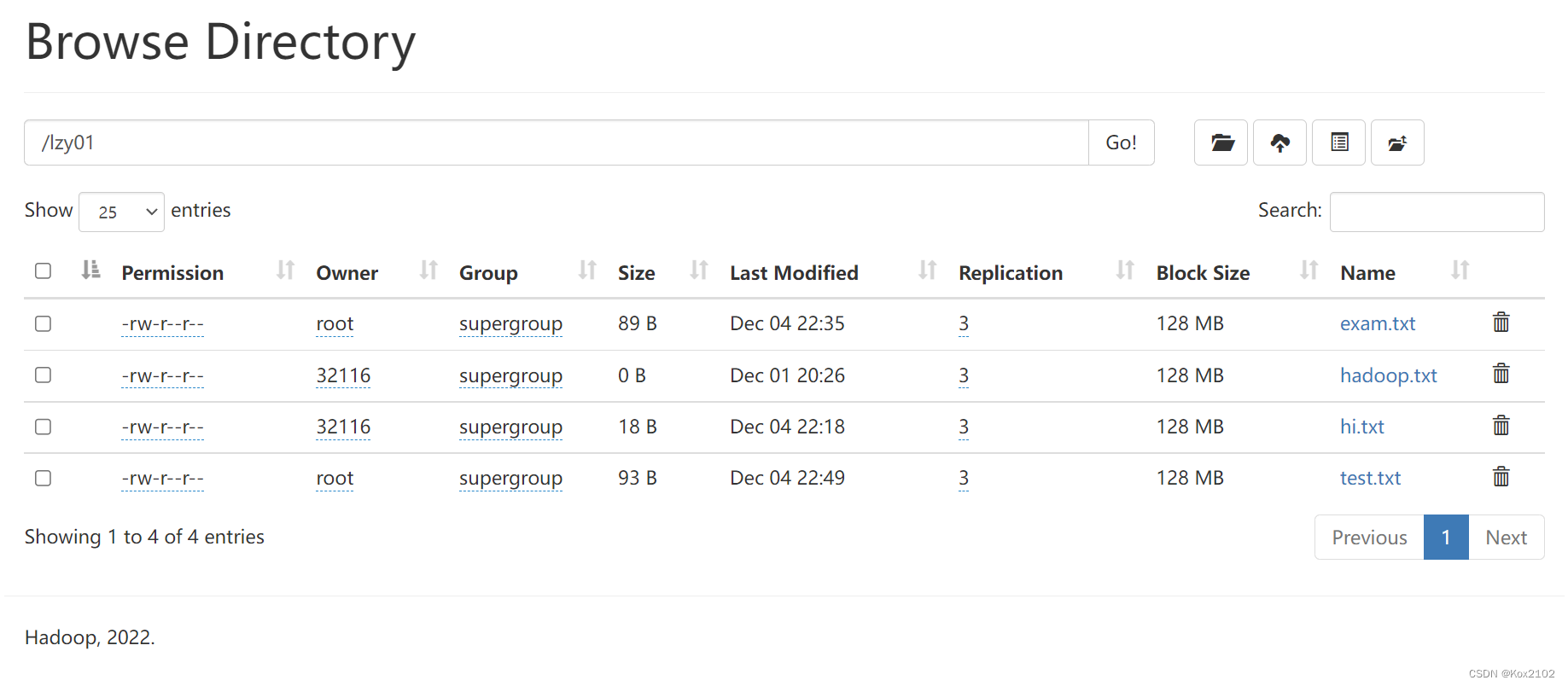

- 对照Hadoop WebUI上给出的文件长度信息

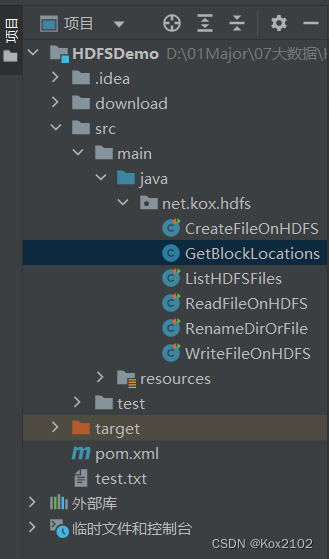

10. 获取文件块信息

- 获取/lzy01/hadoop-3.3.4.tar.gz文件块信息

- 创建GetBlockLocations类

- 编写代码,获取文件块信息:

package net.kox.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.BlockLocation;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import java.net.URI;

import java.util.Arrays;

/**

* 功能:获取文件块信息

* 作者:华卫

* 日期:2022年11月26日

*/

public class GetBlockLocations {

public static void main(String[] args) throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 定义uri字符串

String uri = "hdfs://master:9000";

// 创建文件系统对象

FileSystem fs = FileSystem.get(new URI(uri), conf, "root");

// 创建路径对象,指向文件

Path path = new Path("/lzy01/hadoop-3.3.4.tar.gz");

// 获取文件块信息

BlockLocation[] blks = fs.getFileBlockLocations(path, 0, Integer.MAX_VALUE);

// 利用Lambda表达式遍历块信息

Arrays.asList(blks).forEach(blk -> System.out.println(blk));

}

}

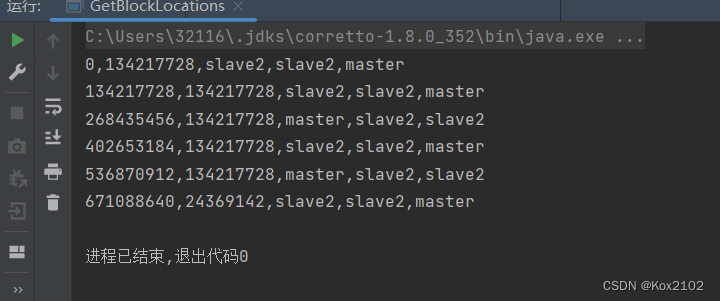

- 运行程序,查看结果(切点位置,块大小,块存在位置)

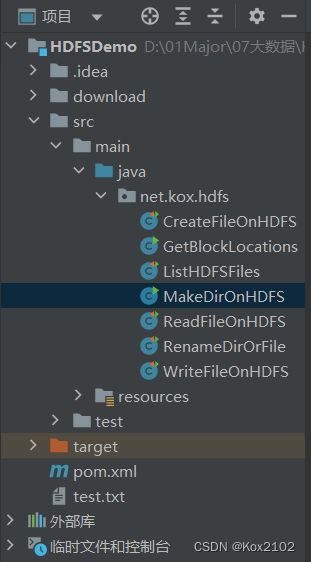

11. 创建目录

- 在HDFS上创建/ied01目录

- 创建MakeDirOnHDFS类

- 编写程序:

package net.kox.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import java.net.URI;

public class MakeDirOnHDFS {

public static void main(String[] args) throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 定义uri字符串

String uri = "hdfs://master:9000";

// 创建文件系统对象

FileSystem fs = FileSystem.get(new URI(uri), conf, "root");

// 创建路径对象,指向目录

Path path = new Path("/ied01");

// 利用文件系统创建指定目录

boolean result = fs.mkdirs(path);

// 判断目录是否创建成功

if (result) {

System.out.println("目录[" + path + "]创建成功!");

} else {

System.out.println("目录[" + path + "]创建失败!");

}

}

}

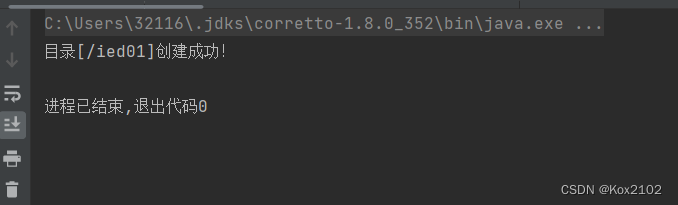

- 运行程序,查看结果:

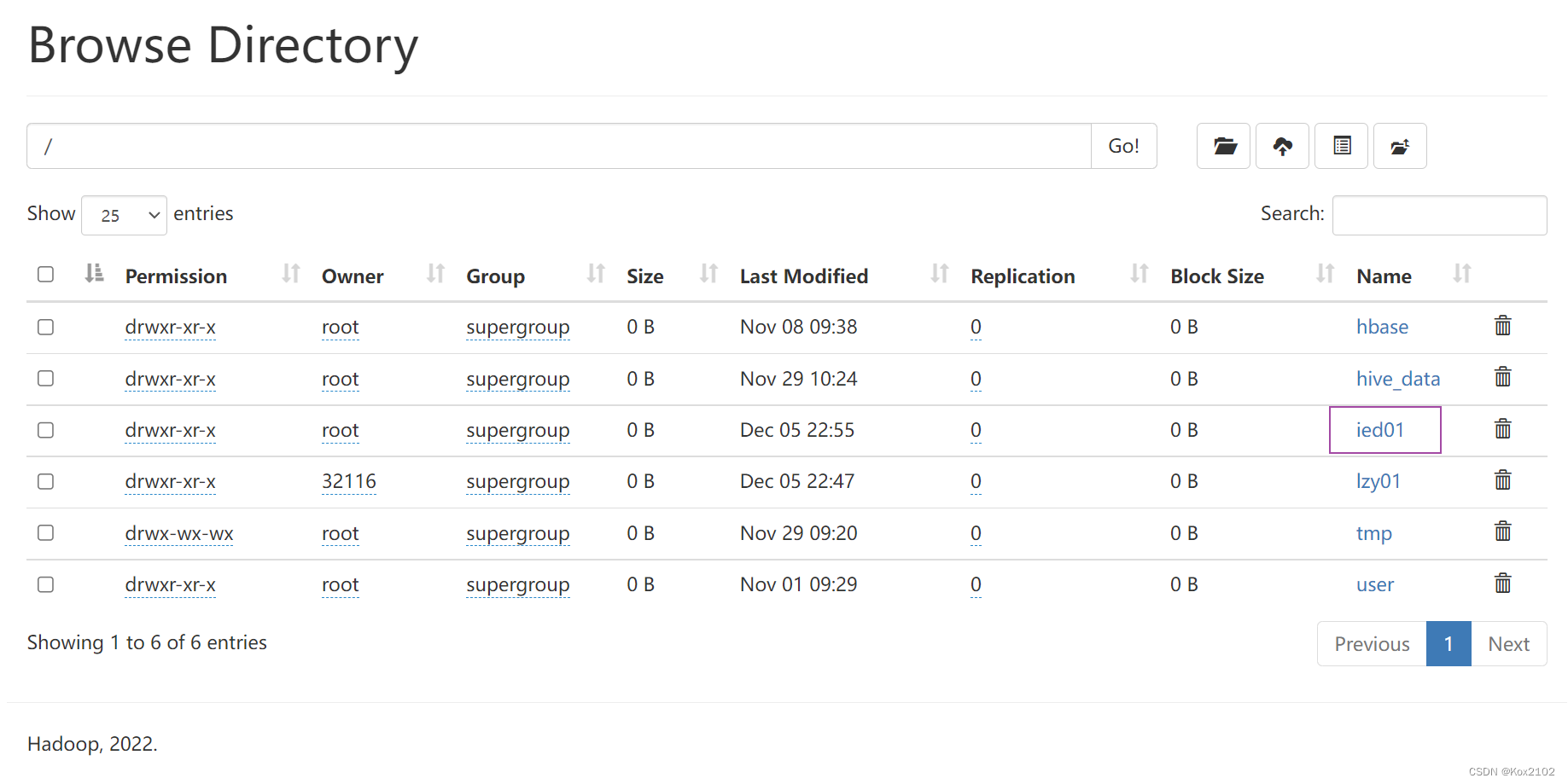

- 利用Hadoop WebUI界面查看:

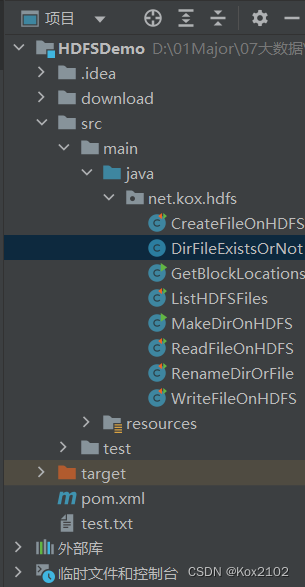

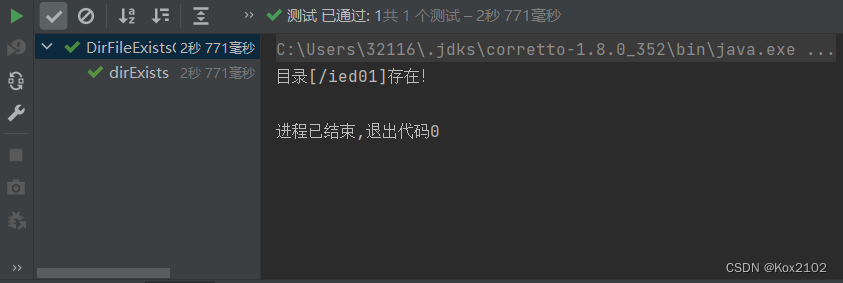

12. 判断目录或文件是否存在

- 判断HDFS上/ied01目录是否存在,判断/ied01/hadoop.txt文件是否存在

- 创建DirFileExistsOrNot类

- 编写dirExists()方法:

package net.kox.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.junit.Test;

import java.net.URI;

public class DirFileExistsOrNot {

@Test

public void dirExists() throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 定义uri字符串

String uri = "hdfs://master:9000";

// 创建文件系统对象

FileSystem fs = FileSystem.get(new URI(uri), conf, "root");

// 创建路径对象,指向目录

Path path = new Path("/ied01");

// 判断目录是否存在

if (fs.exists(path)) {

System.out.println("目录[" + path + "]存在!");

} else {

System.out.println("目录[" + path + "]不存在!");

}

}

}

- 运行程序,查看结果:

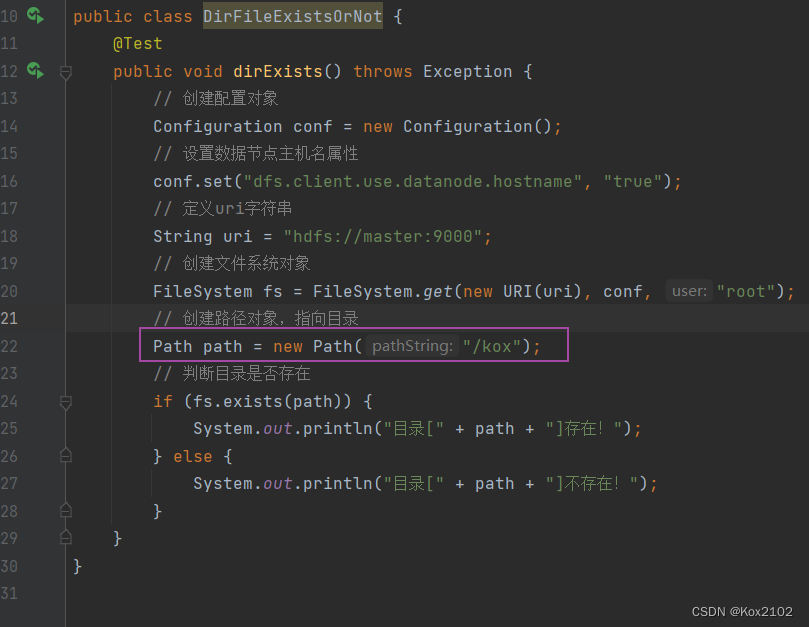

- 修改代码,在进行测试:

- 运行程序,查看结果:

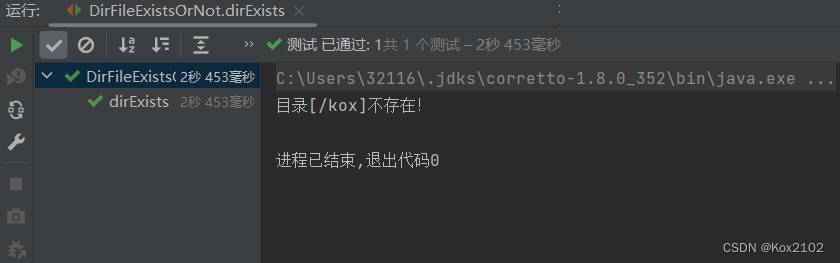

13. 判断Path指向目录还是文件

- 创建PathToFileOrDir类

- 编写代码:

package net.kox.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import java.net.URI;

public class PathToFileOrDir {

public static void main(String[] args) throws Exception{

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 定义uri字符串

String uri = "hdfs://master:9000";

// 创建文件系统对象

FileSystem fs = FileSystem.get(new URI(uri), conf, "root");

// 创建路径对象,指向目录

Path path1 = new Path("/ied01");

if (fs.isDirectory(path1)) {

System.out.println("[" + path1 + "]指向的式目录!");

} else {

System.out.println("[" + path1 + "]指向的是文件!");

}

// 创建路径对象,指向文件

Path path2 = new Path("/lzy01/test.txt");

if (fs.isFile(path2)) {

System.out.println("[" + path2 + "]指向的是文件!");

} else {

System.out.println("[" + path2 + "]指向的是目录!");

}

}

}

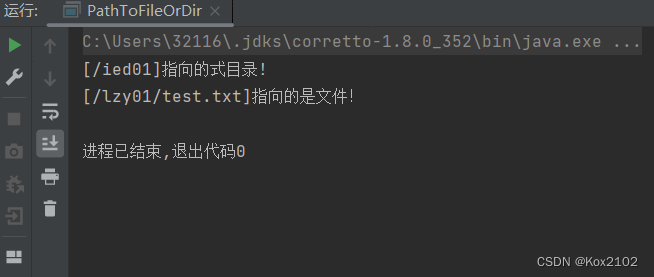

- 运行程序,查看结果:

14. 删除目录或文件

- 类似于HDFS Shell里的hdfs dfs -rmdir和hdfs dfs -rm -r命令

- 创建DeleteFileOrDir类

14.1 删除文件

- 删除/lzy01/hi.txt文件

- 编写deleteFile()方法

package net.kox.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.junit.Test;

import java.net.URI;

public class DeleteFileOrDir {

@Test

public void deleteFile() throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 定义uri字符串

String uri = "hdfs://master:9000";

// 创建文件系统对象

FileSystem fs = FileSystem.get(new URI(uri), conf, "root");

// 创建路径对象(指向文件)

Path path = new Path(uri + "/lzy01/hi.txt");

// 删除路径对象指向的文件(第二个参数表明是否递归,删除文件,不用递归)

boolean result = fs.delete(path, false);

// 根据返回结果提示用户

if (result) {

System.out.println("文件[" + path + "]删除成功!");

} else {

System.out.println("文件[" + path + "]删除失败!");

}

}

}

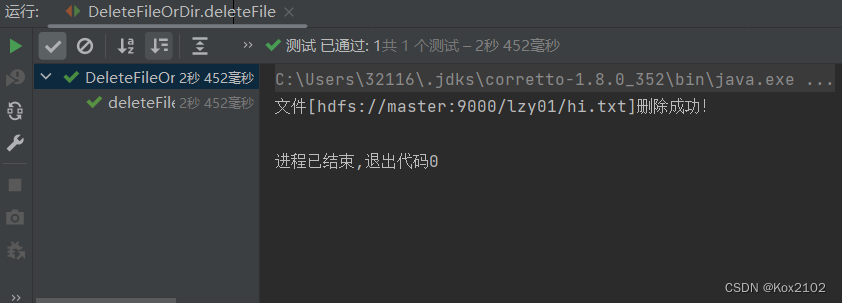

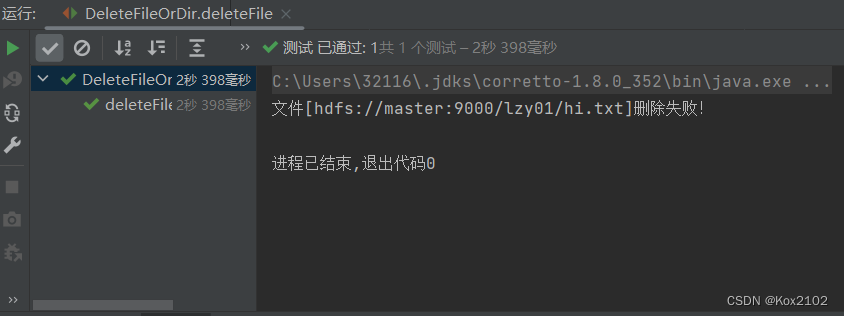

- 运行程序,查看结果:

- 利用Hadoop WebUI界面查看:

- 再运行deleteFile()测试方法,查看结果:

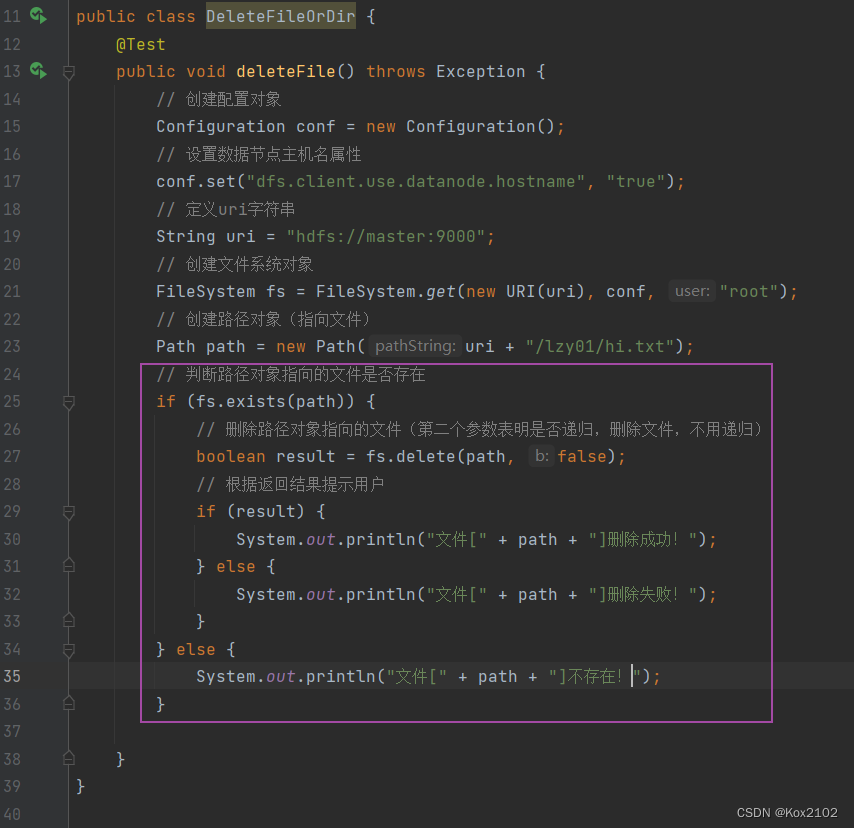

- 改进代码:

package net.kox.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.junit.Test;

import java.net.URI;

public class DeleteFileOrDir {

@Test

public void deleteFile() throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 定义uri字符串

String uri = "hdfs://master:9000";

// 创建文件系统对象

FileSystem fs = FileSystem.get(new URI(uri), conf, "root");

// 创建路径对象(指向文件)

Path path = new Path(uri + "/lzy01/hi.txt");

// 判断路径对象指向的文件是否存在

if (fs.exists(path)) {

// 删除路径对象指向的文件(第二个参数表明是否递归,删除文件,不用递归)

boolean result = fs.delete(path, false);

// 根据返回结果提示用户

if (result) {

System.out.println("文件[" + path + "]删除成功!");

} else {

System.out.println("文件[" + path + "]删除失败!");

}

} else {

System.out.println("文件[" + path + "]不存在!");

}

}

}

- 运行程序,查看结果:

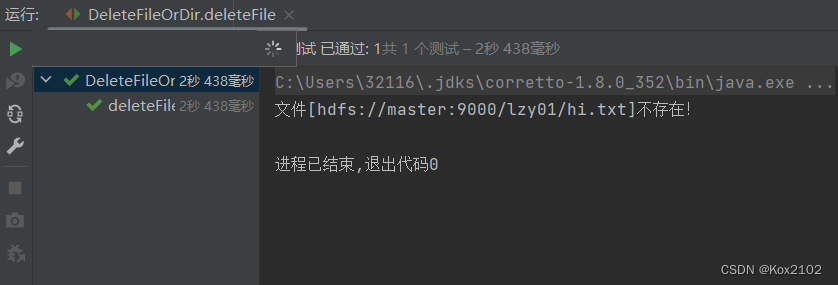

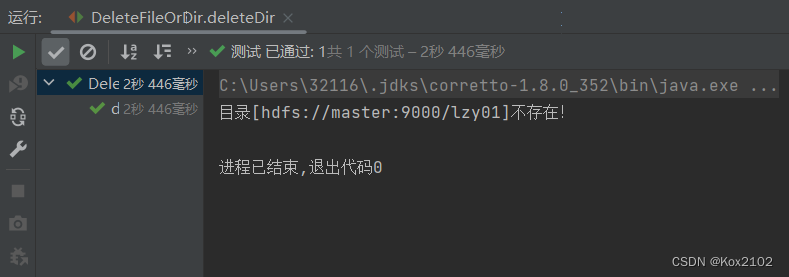

14.2 删除目录

- 删除/lzy01目录

- 编写deleteDir()方法:

@Test

public void deleteDir() throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 定义uri字符串

String uri = "hdfs://master:9000";

// 创建文件系统对象

FileSystem fs = FileSystem.get(new URI(uri), conf, "root");

// 创建路径对象(指向目录)

Path path = new Path(uri + "/lzy01");

// 判断路径对象指向的目录是否存在

if (fs.exists(path)) {

boolean result = fs.delete(path, true);

// 根据返回结果提示用户

if (result) {

System.out.println("目录[" + path + "]删除成功!");

} else {

System.out.println("目录[" + path + "]删除失败!");

}

} else {

System.out.println("目录[" + path + "]不存在!");

}

}

- 运行程序,查看结果:

- 再次运行:

14.3 删除目录或文件

- 进行三个层面的判断:判断类型(目录或文件)、判断是否存在、判断删除是否成功

- 删除/ied02/exam.txt文件和/lzy01目录

- 编写delete()方法:

@Test

public void delete() throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 定义uri字符串

String uri = "hdfs://master:9000";

// 创建文件系统对象

FileSystem fs = FileSystem.get(new URI(uri), conf, "root");

// 定义随机对象

Random random = new Random();

// 产生随机整数 - [0, 1]

int choice = random.nextInt(100) % 2;

// 定义路径字符串

String[] strPath = {"/ied02/exam.txt", "/lzy01"};

// 创建路径对象(指向目录或文件)

Path path = new Path(uri + strPath[choice]);

// 判断类型:目录或文件

String type = "";

if (fs.isDirectory(path)) {

type = "目录";

} else {

type = "文件";

}

// 判断存在性

if (fs.exists(path)) {

// 删除路径对象指向的目录或文件

boolean result = fs.delete(path, true);

// 判断删除是否成功

if (result) {

System.out.println(type + "[" + path + "]删除成功!");

} else {

System.out.println(type + "[" + path + "]删除失败!");

}

} else {

System.out.println(type + "[" + path + "]不存在!");

}

}

![[附源码]计算机毕业设计青栞系统Springboot程序](https://img-blog.csdnimg.cn/b953bb0bf76942879006a02b1075c47e.png)

![[附源码]JAVA毕业设计沙县小吃点餐系统(系统+LW)](https://img-blog.csdnimg.cn/7132c19018274e6fa104c8d6aab2f04c.png)

![[附源码]Python计算机毕业设计Django校园招聘微信小程序](https://img-blog.csdnimg.cn/34a6039709d54d868725dd8bc9c41fa1.png)