开会时间:2023.06.18 15:00 线下会议

01【调研-数据分析(质量、ETL、可视化)】

ETL,是英文Extract-Transform-Load的缩写,用来描述将数据从来源端经过抽取(extract)、转换(transform)、加载(load)至目的端的过程。ETL一词较常用在数据仓库,但其对象并不限于数据仓库。

数据分析是指通过收集、清洗、整理和解释数据,以提取有价值的信息和洞察力的过程。在数据分析中,有几个重要的方面需要考虑,包括数据质量、ETL(抽取、转换和加载)和可视化。

- 数据质量: 数据质量是确保数据准确、完整、一致和可靠的度量。在数据分析中,数据质量对于得出准确的结论和做出正确的决策至关重要。以下是一些确保数据质量的常见方法:

- 数据清洗:去除数据中的重复项、空值、异常值和错误数据。

- 数据验证:检查数据是否符合事先定义的规则和约束。

- 数据整合:将来自不同来源的数据整合在一起,确保数据的一致性和完整性。

- 数据审查:评估数据的准确性、完整性和一致性,并解决潜在的数据质量问题。

- ETL(抽取、转换和加载): ETL是指将数据从各种来源(如数据库、日志文件、API等)中抽取出来,进行必要的转换和清洗,然后加载到目标系统中进行分析的过程。以下是ETL过程的主要步骤:

- 数据抽取:从各种来源中提取数据,通常使用查询、API调用或文件导入等方法。

- 数据转换:对抽取的数据进行清洗、整合、转换和规范化,以便符合分析的需求。

- 数据加载:将转换后的数据加载到目标系统(如数据仓库、数据湖等)中,以便进行进一步的分析和可视化。

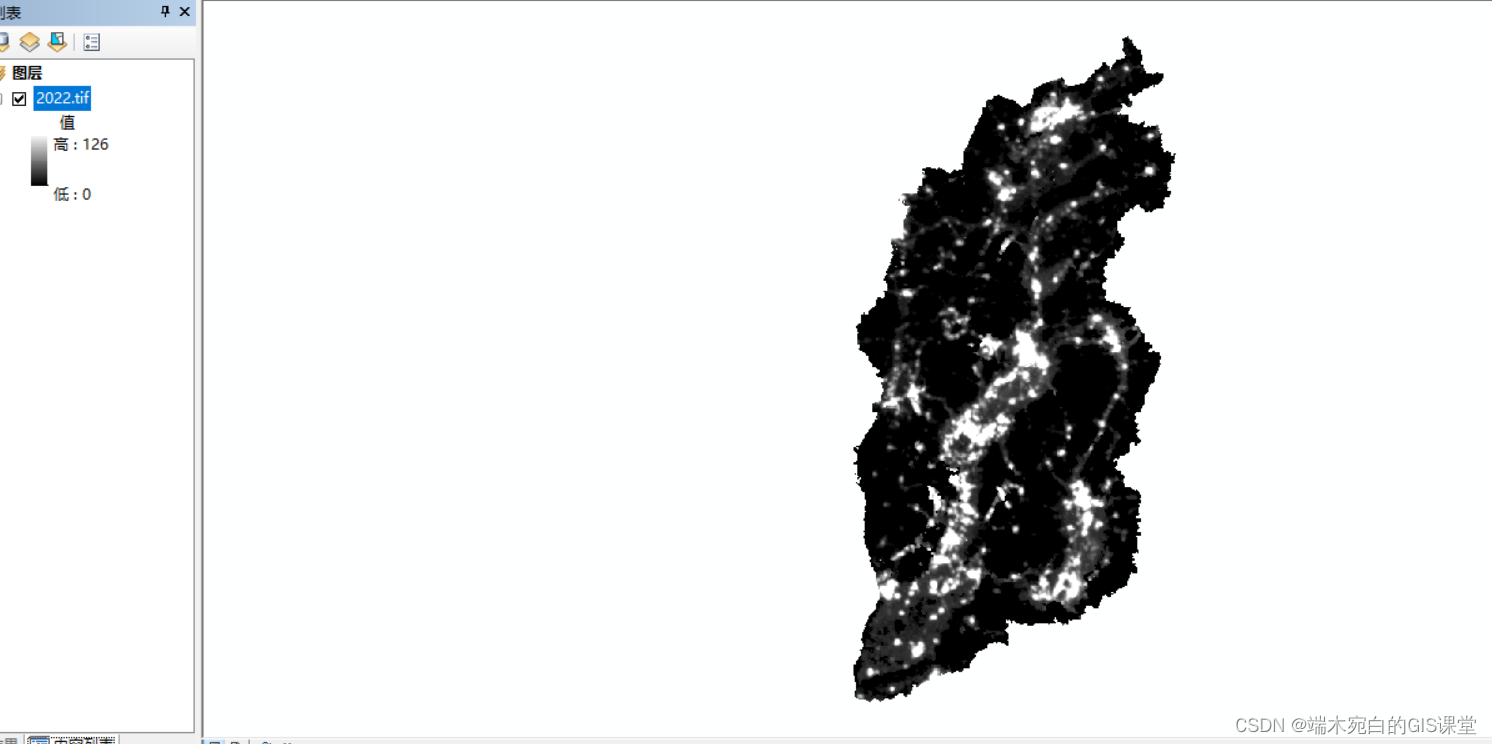

- 可视化: 可视化是将数据转换为图表、图形和其他可视元素的过程,以便更好地理解和传达数据中的模式、趋势和洞察力。以下是可视化的一些常见方法和工具:

- 图表和图形:使用柱状图、折线图、饼图、散点图等图表类型来展示数据。

- 仪表板:通过将多个图表和指标组合在一起,提供对数据的全面和实时的可视化展示。

- 数据可视化工具:例如Tableau、Power BI、Matplotlib、D3.js等工具,提供丰富的可视化功能和交互性,帮助用户更好地探索和解释数据。

综上所述,数据分析过程涉及到确保数据质量、进行ETL以及进行数据可视化,以获得准确、可靠且有意义的结果和洞察力。

ETL常用的三种工具介绍及对比Datastage,Informatica和Kettle

ETL常用的三种工具介绍及对比Datastage,Informatica和Kettle

1.1【流程图】

1.2【架构图】

1.3【使用场景】

1.4【技术架构】

02【fhzn项目】

2.1【es多维度检索接口】

多维度检索方案设计,es多条件查询接口。

接口编写、git提交代码。

2.2【AI算法库资料整理】

第一阶段任务,参考两个推荐文献,抽象出 AI 领域的一个总体结构,包括内部包含的不同类别的算法和常用算法。这里可以参考分成四个部分总结。

- 第一部分:关于 AI 领域的发展历程、由一开始的专家系统到后面的神经网络做一个全局的说明和叙述。

- 第二部分:阐述 AI 领域内一些概念或术语上的解释,如训练、损失、评估器优化器之类的概念。

- 第三部分:是理论层面的,包括回归、分类等任务常见算法。

- 第四部分:列出不同目前工业领域 AI 火热的领域,如 NLP、视觉领域,再往下细分,列出一些更细的方向和每个方向下的常见算法,先把总体的资料库骨架抽象出来后续填充内容。

神经网络与深度学习-邱锡鹏.pdf

03【专利】

fastDFS、轮循机制、

04【学习内容】

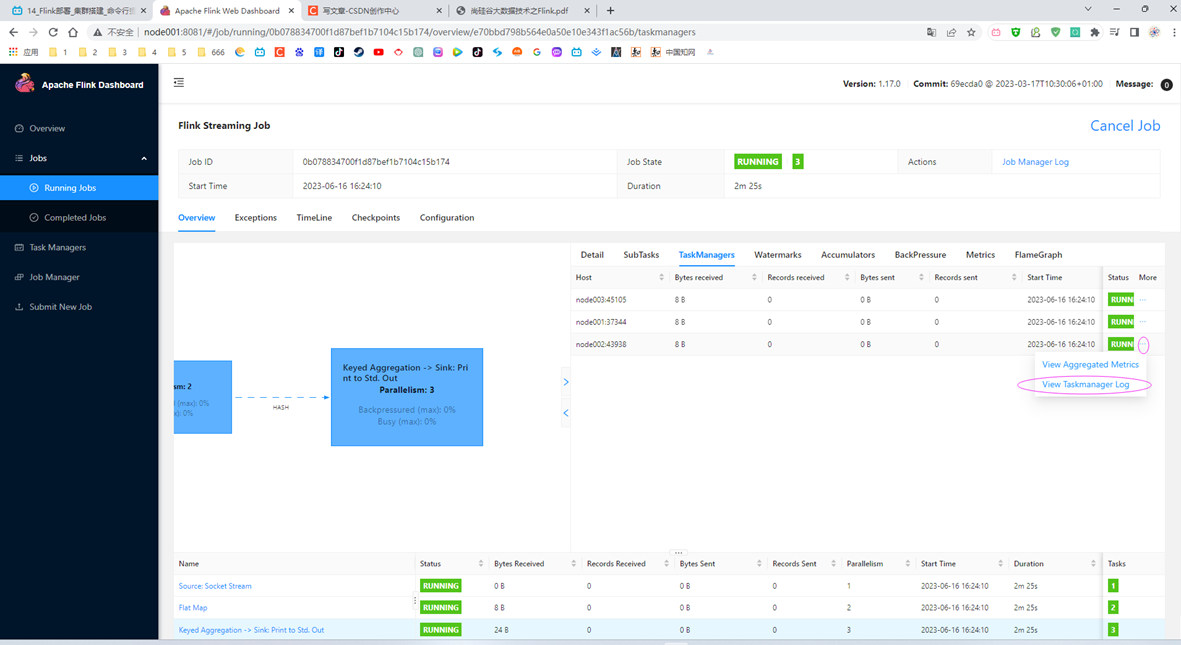

4.1【flink】

- 尚硅谷大数据Flink1.17实战教程-笔记01【Flink概述、Flink快速上手】

- 尚硅谷大数据Flink1.17实战教程-笔记02【Flink部署】