Python爬虫:抓取数据的实用技巧

如果您是一名数字营销从业者,那么您一定知道SEO的重要性。SEO是一项复杂的工作,但是其中包含了一个非常关键的步骤,就是通过爬虫从网站中抓取数据。Python是一个非常强大的工具,可以帮助您高效地完成这项任务。在本文中,我们将介绍Python进行数据抓取的实用技巧。

第一步:了解网站内容

在进行数据抓取之前,您需要了解自己要访问的网站的内容和结构。这样能够帮助您快速定位需要的信息和数据。您可以使用浏览器的开发工具和命令行工具来检查网站的HTML源代码和CSS代码,以了解网站的结构和响应内容。

第二步:选择合适的爬虫库

Python拥有众多优秀的爬虫库和框架,如Beautiful Soup、Scrapy等。选择合适的库和框架可以帮助您更快速地完成数据抓取。例如,使用Scrapy框架可以自动化许多网站抓取过程,大大提高效率。

第三步:编写代码

在进行数据抓取之前,您需要使用Python库进行安装和导入。然后,您需要编写访问网站并抓取数据的代码。以下是一个简单的示例代码,用于从目标网站中抓取文本数据:

import requests

from bs4 import BeautifulSoup

url = 'https://www.example.com'

response = requests.get(url)

soup = BeautifulSoup(response.content, 'html.parser')

data = soup.find('div', {'class': 'example-class'})

print(data.text)

第四步:数据清洗和处理

抓取的数据可能包含大量不必要的内容,或者需要进行处理和筛选。对数据进行清洗和处理可以帮助您更好地利用这些数据。例如,您可以移除HTML标签或者对数据进行转换和格式化。

第五步:数据存储和分析

最后,在完成数据抓取和清洗之后,您需要将数据存储在本地或者云端,以备后续分析和使用。对于大规模的数据,建议使用云存储服务,如Amazon S3或Google Cloud Storage。同时,使用数据分析工具,如Pandas等,可以帮助您更好地理解和利用这些数据。

总结:

Python作为一种程序语言,具有强大的可重复或可扩展性是它受到欢迎的一个重要原因。我们讨论了如何使用Python从网站中抓取数据的实用技巧,这将为数字营销人员带来极大的效益。数据是SEO的关键,了解如何使用Python从网站中抓取数据将为您提供极大的帮助。

最后的最后

本文由chatgpt生成,文章没有在chatgpt生成的基础上进行任何的修改。以上只是chatgpt能力的冰山一角。作为通用的Aigc大模型,只是展现它原本的实力。

对于颠覆工作方式的ChatGPT,应该选择拥抱而不是抗拒,未来属于“会用”AI的人。

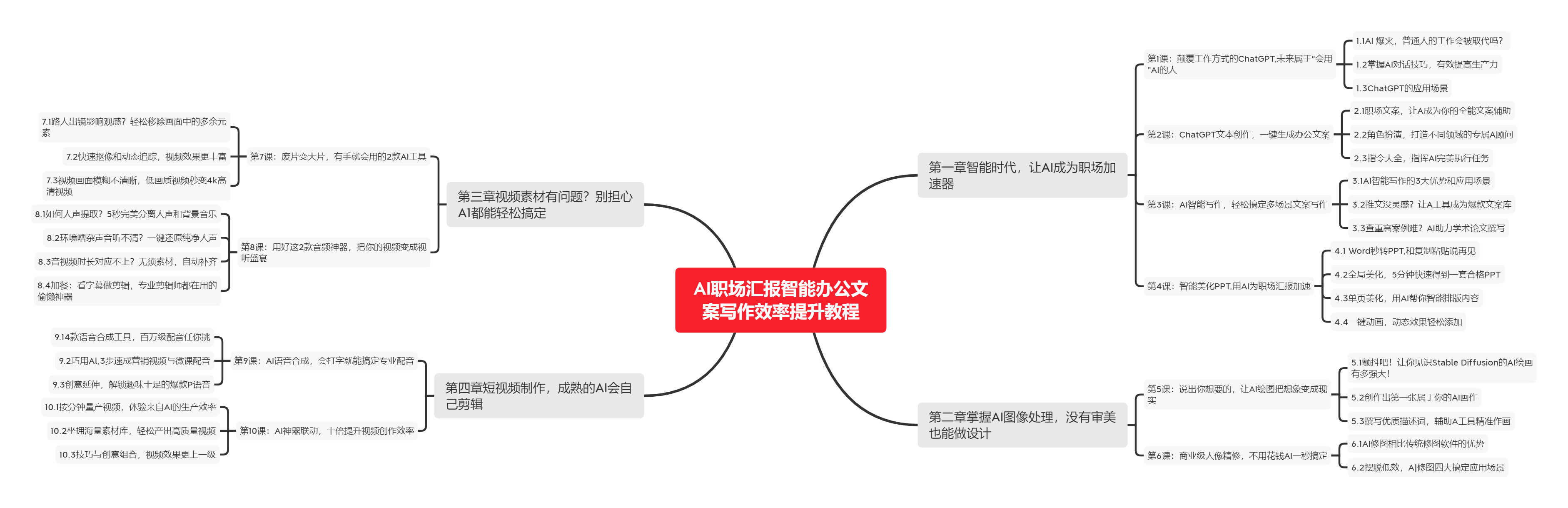

🧡AI职场汇报智能办公文案写作效率提升教程 🧡 专注于AI+职场+办公方向。

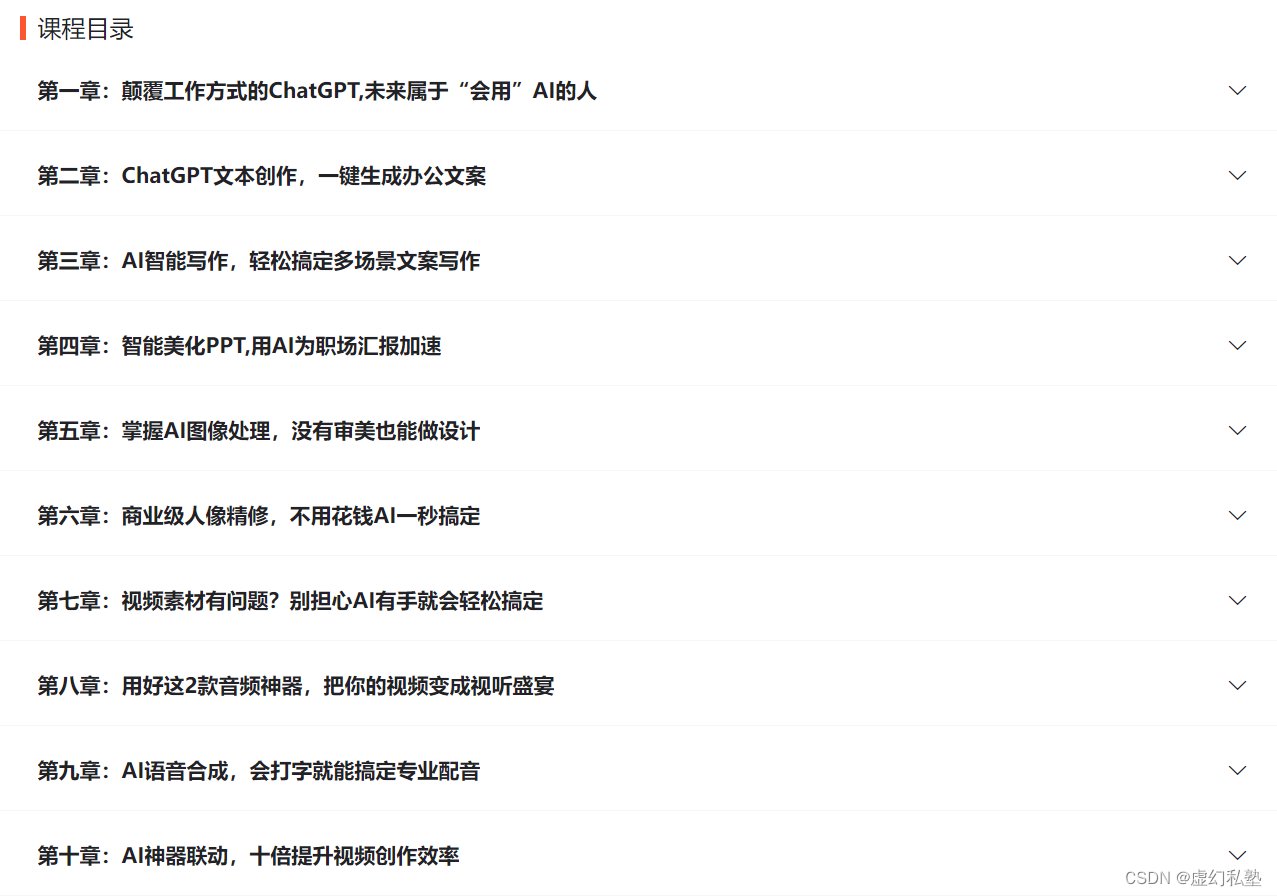

下图是课程的整体大纲

下图是AI职场汇报智能办公文案写作效率提升教程中用到的ai工具

🚀 优质教程分享 🚀

- 🎄可以学习更多的关于人工只能/Python的相关内容哦!直接点击下面颜色字体就可以跳转啦!

| 学习路线指引(点击解锁) | 知识定位 | 人群定位 |

|---|---|---|

| 🧡 AI职场汇报智能办公文案写作效率提升教程 🧡 | 进阶级 | 本课程是AI+职场+办公的完美结合,通过ChatGPT文本创作,一键生成办公文案,结合AI智能写作,轻松搞定多场景文案写作。智能美化PPT,用AI为职场汇报加速。AI神器联动,十倍提升视频创作效率 |

| 💛Python量化交易实战 💛 | 入门级 | 手把手带你打造一个易扩展、更安全、效率更高的量化交易系统 |

| 🧡 Python实战微信订餐小程序 🧡 | 进阶级 | 本课程是python flask+微信小程序的完美结合,从项目搭建到腾讯云部署上线,打造一个全栈订餐系统。 |

![[论文阅读笔记77]LoRA:Low-Rank Adaptation of Large Language Models](https://img-blog.csdnimg.cn/img_convert/c88690bbfe314d783d3f9204f5c75783.png)