上进小菜猪,沈工大软件工程专业,爱好敲代码,持续输出干货。

大数据分析与机器学习已成为当今商业决策和科学研究中的关键组成部分。本文将深入探讨大数据技术的背景和原则,并结合实例介绍一些常见的大数据分析和机器学习技术。

随着互联网和计算能力的飞速发展,大数据成为了各行业面临的重要挑战和机遇。通过大数据分析,我们可以挖掘出隐藏在海量数据中的有价值信息,为企业决策提供有力支持。机器学习作为大数据分析的重要工具,可以帮助我们从数据中学习模式、预测趋势和进行智能决策。下面我们将通过技术深度的介绍和代码实例的演示,带领读者深入了解大数据分析与机器学习的关键技术。

一、数据处理与存储

在进行大数据分析之前,我们首先需要解决数据的处理和存储问题。常见的大数据处理框架如Hadoop和Spark可以帮助我们高效地处理大规模数据。下面是一个使用Spark进行数据处理的示例代码:

from pyspark import SparkContext

from pyspark.sql import SparkSession

# 创建SparkContext和SparkSession

sc = SparkContext("local", "DataProcessingApp")

spark = SparkSession(sc)

# 读取数据

data = spark.read.csv("data.csv", header=True)

# 数据处理

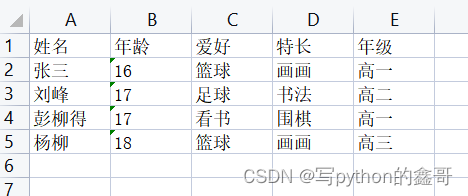

processed_data = data.filter(data["age"] > 18)

# 结果展示

processed_data.show()

二、特征提取与选择

在进行机器学习之前,我们需要对原始数据进行特征提取和选择。特征提取的目标是将原始数据转换为机器学习算法可以理解的形式。下面是一个使用Scikit-learn进行特征提取的示例代码:

from sklearn.feature_extraction.text import CountVectorizer

# 创建CountVectorizer对象

vectorizer = CountVectorizer()

# 文本数据

corpus = [

'This is the first document.',

'This document is the second document.',

'And this is the third one.',

'Is this the first document?'

]

# 特征提取

X = vectorizer.fit_transform(corpus)

# 特征词汇

feature_names = vectorizer.get_feature_names()

# 结果展示

print("Feature names:", feature_names)

print("Feature matrix:")

print(X.toarray())

三、模型训练与评估

特征提取完成后,我们可以使用机器学习算法进行模型训练和评估。下面是一个使用Scikit-learn进行分类任务的示例代码:

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

from sklearn.svm import SVC

from sklearn.metrics import accuracy_score

# 加载Iris数据集

iris = load_iris()

# 划分数据集

X_train, X_test, y_train, y_test = train_test_split(

iris.data, iris.target, test_size=0.2, random_state=42)

# 创建SVC分类器

clf = SVC()

# 模型训练

clf.fit(X_train, y_train)

# 模型预测

y_pred = clf.predict(X_test)

# 准确率评估

accuracy = accuracy_score(y_test, y_pred)

# 结果展示

print("Accuracy:", accuracy)

四、模型优化与调参

在机器学习中,模型的性能和准确度可以通过优化和调参来提升。下面是一个使用网格搜索(GridSearch)进行模型调参的示例代码:

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split, GridSearchCV

from sklearn.svm import SVC

from sklearn.metrics import accuracy_score

# 加载Iris数据集

iris = load_iris()

# 划分数据集

X_train, X_test, y_train, y_test = train_test_split(

iris.data, iris.target, test_size=0.2, random_state=42)

# 创建SVC分类器

svc = SVC()

# 定义参数网格

param_grid = {'C': [0.1, 1, 10], 'kernel': ['linear', 'rbf']}

# 创建网格搜索对象

grid_search = GridSearchCV(svc, param_grid, cv=5)

# 模型训练与参数搜索

grid_search.fit(X_train, y_train)

# 最佳参数和模型

best_params = grid_search.best_params_

best_model = grid_search.best_estimator_

# 模型预测

y_pred = best_model.predict(X_test)

# 准确率评估

accuracy = accuracy_score(y_test, y_pred)

# 结果展示

print("Best parameters:", best_params)

print("Accuracy:", accuracy)

通过网格搜索(GridSearch)技术,我们可以自动化地寻找最佳的模型参数组合,从而提高模型的性能和准确度。

五、可视化与结果解释

在大数据分析和机器学习中,可视化是理解和解释结果的重要工具。下面是一个使用Matplotlib进行数据可视化的示例代码:

import matplotlib.pyplot as plt

import numpy as np

# 生成随机数据

x = np.linspace(0, 10, 100)

y = np.sin(x)

# 创建图形

plt.figure(figsize=(8, 6))

# 绘制曲线

plt.plot(x, y, label='sin(x)')

# 设置标题和标签

plt.title('Sine Function')

plt.xlabel('x')

plt.ylabel('sin(x)')

# 添加图例

plt.legend()

# 显示图形

plt.show()

通过数据可视化,我们可以更加直观地理解数据的分布、模型的拟合程度和结果的解释。

六、实时大数据处理与流式计算

除了离线的大数据分析,实时大数据处理和流式计算也成为了重要的技术领域。下面是一个使用Apache Kafka和Apache Spark进行实时数据处理的示例代码:

from pyspark import SparkContext

from pyspark.streaming import StreamingContext

from pyspark.streaming.kafka import KafkaUtils

# 创建SparkContext和StreamingContext

sc = SparkContext("local[2]", "RealTimeProcessingApp")

ssc = StreamingContext(sc, 1)

# Kafka配置

kafka_params = {

"bootstrap.servers": "localhost:9092",

"key.deserializer": "org.apache.kafka.common.serialization.StringDeserializer",

"value.deserializer": "org.apache.kafka.common.serialization.StringDeserializer",

"group.id": "test-group",

"auto.offset.reset": "latest"

}

# 创建Kafka数据流

kafka_stream = KafkaUtils.createDirectStream(ssc, ["test-topic"], kafka_params)

# 实时数据处理

processed_stream = kafka_stream.map(lambda x: x[1].split(" ")) \

.flatMap(lambda x: x) \

.map(lambda x: (x, 1)) \

.reduceByKey(lambda x, y: x + y)

# 结果展示

processed_stream.pprint()

# 启动流式计算

ssc.start()

ssc.awaitTermination()

通过结合流式计算和实时数据源(如Apache Kafka),我们可以对数据流进行实时处理和分析,从而及时获取有关数据的洞察和信息。

七、大数据安全与隐私保护

在大数据分析过程中,数据安全和隐私保护是不可忽视的重要问题。以下是一个使用加密技术保护敏感数据的示例代码:

from cryptography.fernet import Fernet

# 生成密钥

key = Fernet.generate_key()

# 创建加密对象

cipher = Fernet(key)

# 待加密数据

data = "sensitive data"

# 数据加密

encrypted_data = cipher.encrypt(data.encode())

# 数据解密

decrypted_data = cipher.decrypt(encrypted_data).decode()

# 结果展示

print("Encrypted data:", encrypted_data)

print("Decrypted data:", decrypted_data)

通过使用加密算法对敏感数据进行保护,我们可以确保数据在传输和存储过程中的安全性和隐私性。

结论:

本文介绍了大数据分析与机器学习的关键技术,包括数据处理与存储、特征提取与选择以及模型训练与评估。通过代码实例的演示,读者可以更加深入地理解和应用这些技术。大数据分析和机器学习的结合为我们提供了处理和挖掘海量数据的能力,将为企业决策和科学研究带来新的突破和机遇。