简介

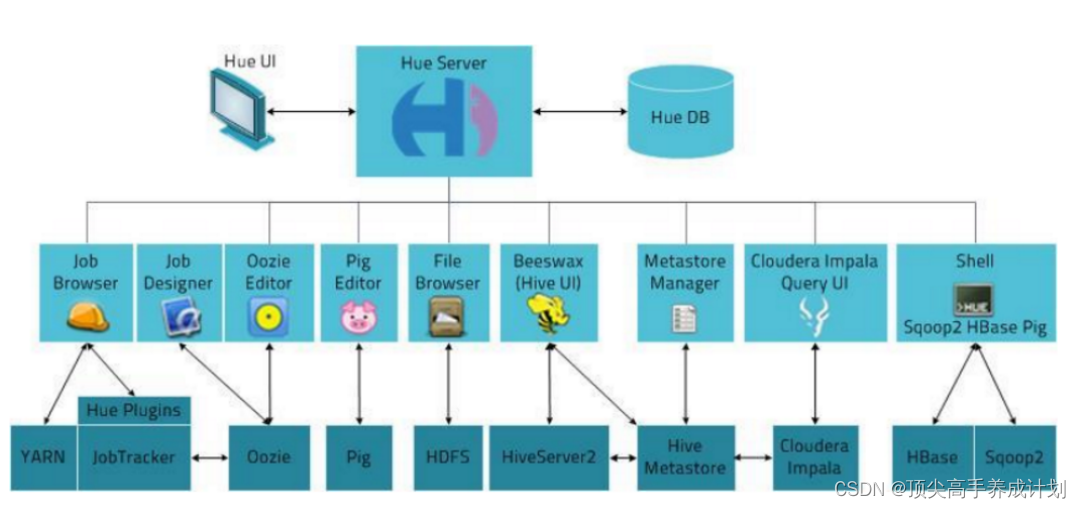

由于大数据框架很多,为了解决某个问题,一般来说会用到多个框架,但是每个框架又都有自己的web UI监控界面,对应着不同的端口号。比如HDFS(9870)、YARN(8088)、MapReduce(19888)等。这个时候有一个统一的web UI界面去管理各个大数据常用框架是非常方便的。这就使得对大数据的开发、监控和运维更加的方便。由此Hue诞生就是为了解决每个框架都有自己的Web界面的问题。

编译安装

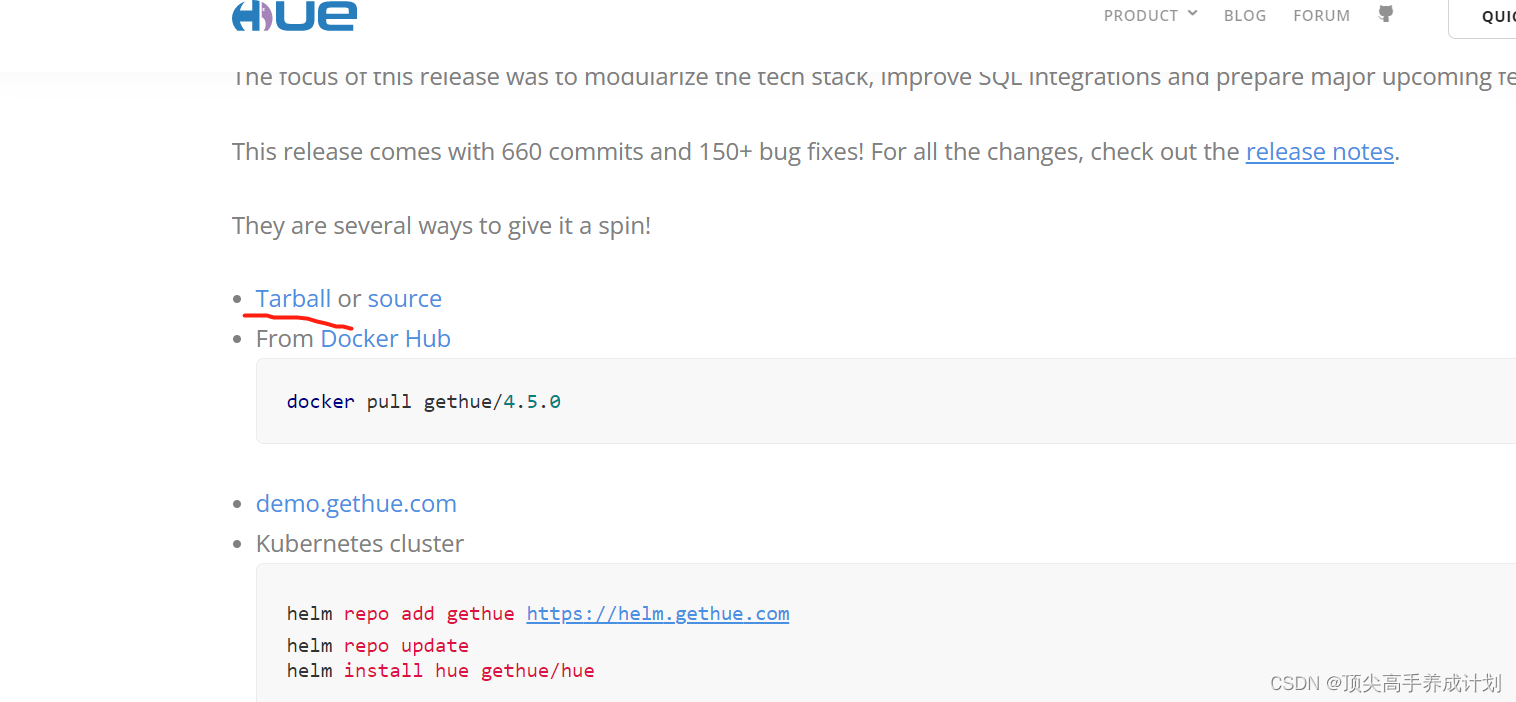

Hue官方网站:https://gethue.com/

HUE官方用户手册:https://docs.gethue.com/

官方安装文档:https://docs.gethue.com/administrator/installation/install/

HUE下载地址:https://docs.gethue.com/releases/

下载

Hue - The open source SQL Assistant for Data Warehouses

相关安装包

maven

链接:https://pan.baidu.com/s/12sk07DOkoWE-L_citfcKeQ

提取码:yyds

--来自百度网盘超级会员V5的分享

hue源码包

链接:https://pan.baidu.com/s/10UPgRfejKpwdV6qT4WuJog

提取码:yyds

--来自百度网盘超级会员V5的分享

npm

先下载npm,安装,这里我就不具体了(记得加环境变量)

wget https://nodejs.org/dist/v14.15.4/node-v14.15.4-linux-x64.tar.xz

tar -xf node-v14.15.4-linux-x64.tar.xz配置环境变量

sudo vi /etc/profile.d/my_env.sh#NPM_HOME

NPM_HOME=/home/bigdata/node-v14.15.4-linux-x64

export PATH=$PATH:$NPM_HOME/bin:$NPM_HOME/sbin source /etc/profile.d/my_env.sh配置淘宝镜像

npm config set registry https://registry.npm.taobao.org查看是否切换成功

npm config get registry如果npm不好使,使用cnpm

npm install -g cnpm --registry=https://registry.npm.taobao.org

cd /usr/bin

ln -s /usr/local/node/bin/cnpm cnpm编译

安装maven并且配置加速

<!-- 阿里云镜像仓库 -->

<mirror>

<id>alimaven</id>

<mirrorOf>central</mirrorOf>

<name>aliyun maven</name>

<url>http://maven.aliyun.com/nexus/content/repositories/central/</url>

</mirror>解压Hue

tar -zxvf hue-4.5.0.tgz安装依赖包

# 需要Python支持(Python 2.7+ / Python 3.5+)

python --version

# 在 CentOS 系统中安装编译 Hue 需要的依赖库

sudo yum install ant asciidoc cyrus-sasl-devel cyrus-sasl-gssapi cyrus-sasl-plain gcc gcc-c++ krb5-devel libffi-devel libxml2-devel libxslt-devel make mysql mysql-devel openldap-devel python-devel sqlite-devel gmp-devel

以上依赖仅适用CentOS/RHEL 7.X,其他情况请参考https://docs.gethue.com/administrator/installation/dependencies/

安装Hue的节点上最好没有安装过MySQL,否则可能有版本冲突

安装过程中需要联网,网络不好会有各种奇怪的问题

修改hue.ini文件

# [desktop]

http_host=node2

http_port=8000

time_zone=Asia/Shanghai

server_user=bigdata

server_group=bigdata

default_user=bigdata

app_blacklist=search

# [[database]]。Hue默认使用SQLite数据库记录相关元数据,替换为mysql

engine=mysql

host=master

port=3306

user=root

password=root

#数据库名称

name=hue

# 1003行左右,Hadoop配置文件的路径

hadoop_conf_dir=/home/bigdata/hadoop/hadoop/etc/hadoop

hue编译

# 进入 hue 源码目录,进行编译。 使用 PREFIX 指定安装 Hue 的路径

cd hue-4.5.0

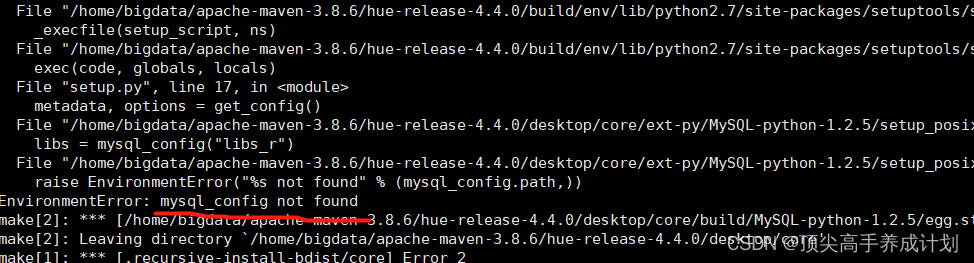

make apps如果遇到下列问题

yum install mysql-devel然后删除上面指定编译目录的target里面的文件

PREFIX=/home/bigdata/apache-maven-3.8.6/hue-release-4.4.0/target

cd /home/bigdata/apache-maven-3.8.6/hue-release-4.4.0/target

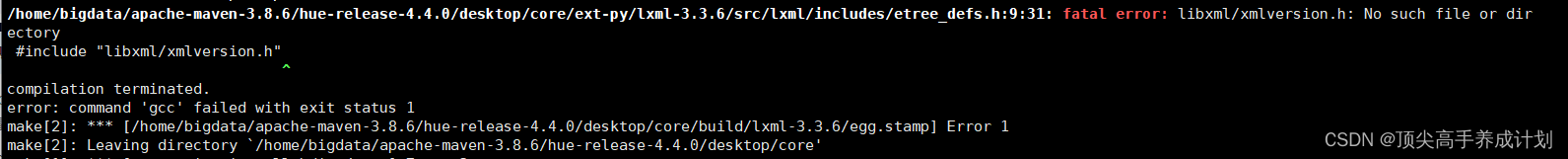

rm -rf ./*如果出现下面的错误

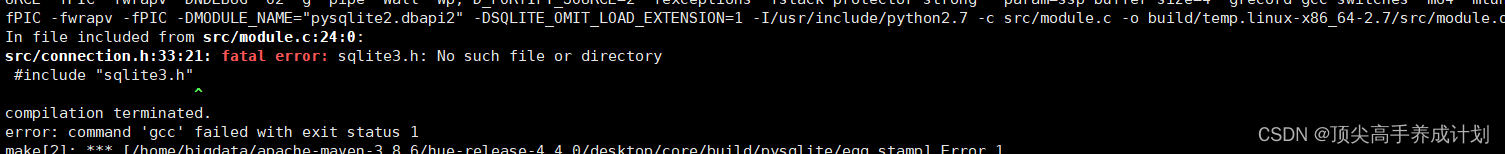

sudo yum install -y libxslt-devel如果出现下面的错误

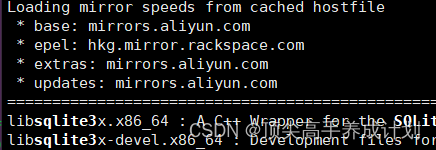

查找对应的依赖

sudo yum search sqlite3

找到对应的依赖进行安装

sudo yum install -y libsqlite3x.x86_64

sudo yum install -y libsqlite3x-devel.x86_64

sudo yum install -y gmp-devel.x86_64再次编译

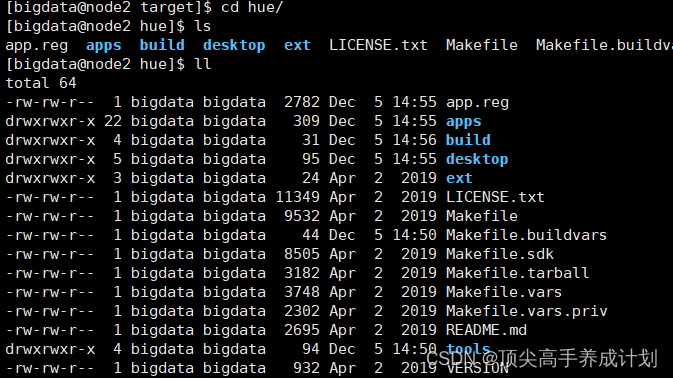

PREFIX=/home/bigdata/apache-maven-3.8.6/hue-release-4.4.0/target make install稍微的等待.......恭喜编译成功!

打一个tar包以后用

tar -zcvf hue.tar.gz hue整合

HDFS

修改hadoop配置

在 hdfs-site.xml 中增加配置

<!-- HUE -->

<property>

<name>dfs.webhdfs.enabled</name>

<value>true</value>

</property>

<property>

<name>dfs.permissions.enabled</name>

<value>false</value>

</property>

在 core-site.xml 中增加配置

<!-- HUE -->

<property>

<name>hadoop.proxyuser.bigdata.hosts</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.bigdata.groups</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.hdfs.hosts</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.hdfs.groups</name>

<value>*</value>

</property>

增加 httpfs-site.xml 文件,加入配置

<configuration>

<!-- HUE -->

<property>

<name>httpfs.proxyuser.bigdata.hosts</name>

<value>*</value>

</property>

<property>

<name>httpfs.proxyuser.bigdata.groups</name>

<value>*</value>

</property>

</configuration>

备注:修改完HDFS相关配置后,需要把配置scp给集群中每台机器,重启hdfs服务。

修改hue配置

cd /home/bigdata/apache-maven-3.8.6/hue-4.5.0/desktop/conf

vi hue.ini修改pseudo-distributed.ini

# [desktop]

http_host=node2

http_port=8000

time_zone=Asia/Shanghai

server_user=bigdata

server_group=bigdata

default_user=bigdata

app_blacklist=search

# [[database]]。Hue默认使用SQLite数据库记录相关元数据,替换为mysql

engine=mysql

host=master

port=3306

user=root

password=root

#数据库名称

name=hue

# 1003行左右,Hadoop配置文件的路径

hadoop_conf_dir=/home/bigdata/hadoop/hadoop/etc/hadoop创建数据库

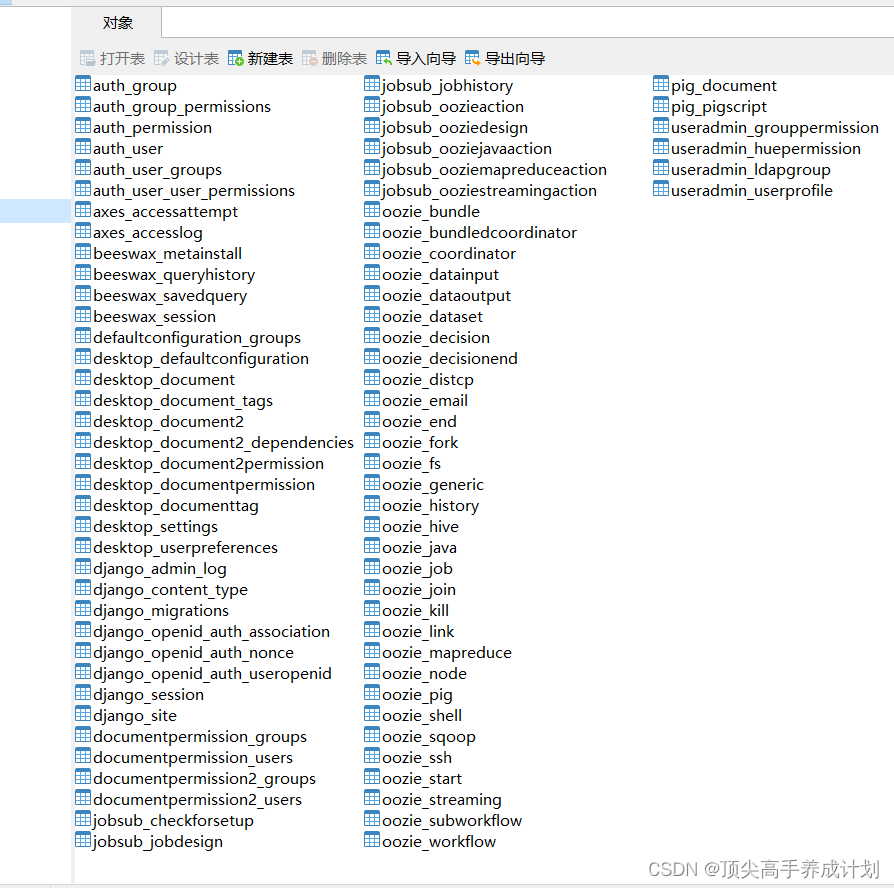

create database hue;Hue初始化数据库

# 初始化数据库

cd /home/bigdata/apache-maven-3.8.6/hue-release-4.4.0/target/hue/build/env/bin

./hue syncdb

./hue migrate

# 检查数据

参考文章

Hue编译安装_Endless在路上的博客-CSDN博客_hue编译安装

hue的编译与安装_聆听金生的博客-CSDN博客_hue编译

![[附源码]Python计算机毕业设计Django酒店物联网平台系统](https://img-blog.csdnimg.cn/4ae069ba4c634d789d13f94019738230.png)

![[附源码]计算机毕业设计室内设计类网站Springboot程序](https://img-blog.csdnimg.cn/2c7a6c15c3b742a686b8b5b1ff0b535f.png)