本期为TechBeat人工智能社区第504期线上Talk!

北京时间6月8日(周四)20:00,北卡罗来纳州立大学在读博士生—唐圣坤与浙江大学硕士生—张磊的Talk将准时在TechBeat人工智能社区开播!

他们与大家分享的主题是: “数据为中心的高效视觉语言学习—动态退出与数据蒸馏”,届时将介绍和探讨统一视觉语言模型及其应用与结果。

Talk·信息

▼

主题:数据为中心的高效视觉语言学习—动态退出与数据蒸馏

嘉宾:北卡罗来纳州立大学在读博士生 唐圣坤

浙江大学硕士生 张磊

时间:北京时间 6月8日 (周四) 20:00

地点:TechBeat人工智能社区

http://www.techbeat.net/

长按识别二维码,一键预约TALK!

Talk·介绍

▼

(上)

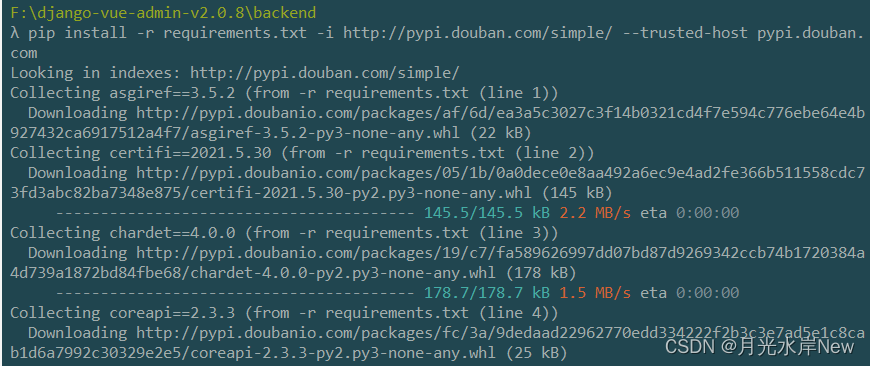

目前,对于视觉语言模型的研究,业界趋向于应用统一的模型架构到不同的视觉语言任务。这些统一的模型表现出比单模态和单任务的优越性,在很多的公开数据集上面取得了SOTA的结果。但是这些统一的视觉语言模型在推理的时候需要消耗很多的计算资源,导致推理的速度变慢。我们的方法提出使用提前退出的方案,在尽量保证了模型在不同数据集和不同任务上面表现的同时,最大程度上降低了模型对计算资源的消耗,提升模型对推理速度。

Talk大纲

1.总体介绍统一视觉语言模型

2.介绍我们工作的出发点

3.介绍我们工作的具体方法

4.展示我们对实验结果和分析

(下)

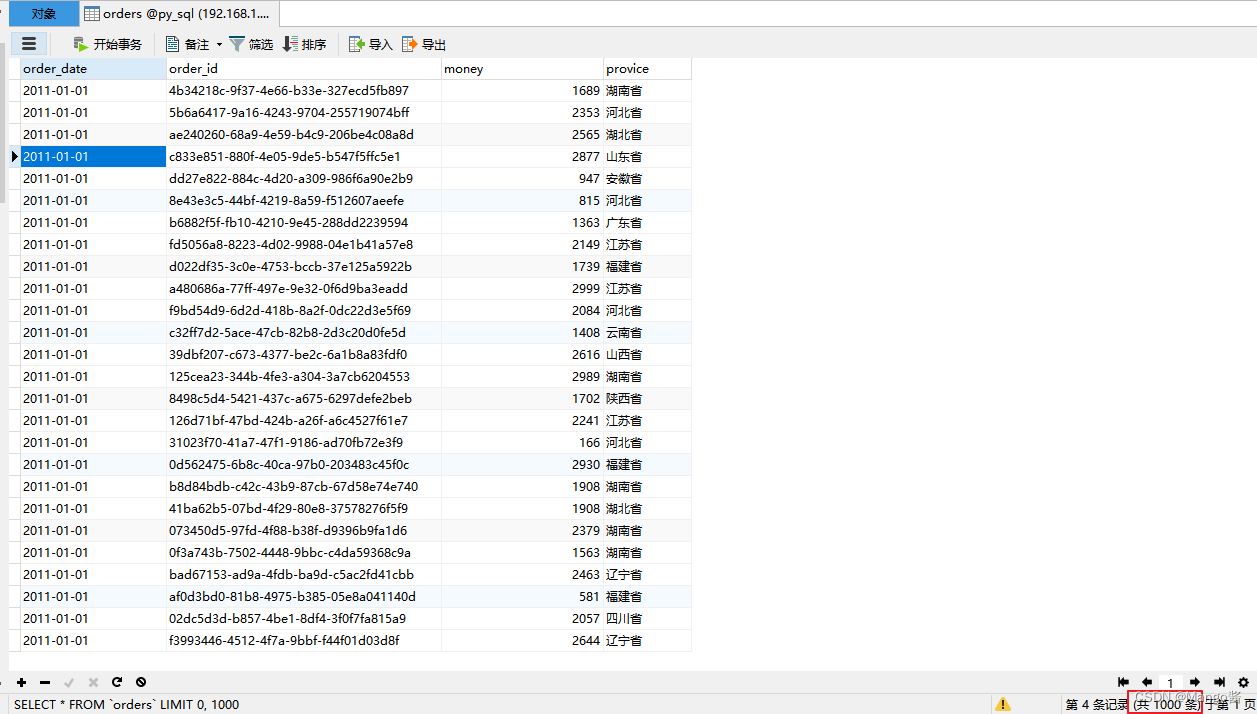

有关深度学习的研究和应用从过去几年到现在正如火如荼地进行,深度学习的成果无一不归功于在大规模数据集进行训练。然后,如此大量的数据不仅给存储带来巨大压力,还给模型训练带来极大开销。关注于这一问题,数据集蒸馏在近年来得到关注。通过对原始大数据集的蒸馏,得到浓缩的小型数据集,使得在这一小数据集上训练出的模型,和在原数据集上训练得到的模型表现相似。但是数据集蒸馏本身也需要耗费大量时间,减少了这一方法本身的高效性。

Talk大纲

1. 数据集蒸馏的效率分析

2. 通过模型增强提升数据集蒸馏速率

3. 高效蒸馏CIFAR,ImageNet数据集

Talk·预习资料

▼

paper链接:

https://arxiv.org/pdf/2211.11152.pdf

Talk·提问交流

▼

在Talk界面下的【交流区】参与互动!留下你的打call🤟和问题🙋,和更多小伙伴们共同讨论,被讲者直接翻牌解答!

你的每一次贡献,我们都会给予你相应的i豆积分,还会有惊喜奖励哦!

Talk·嘉宾介绍

▼

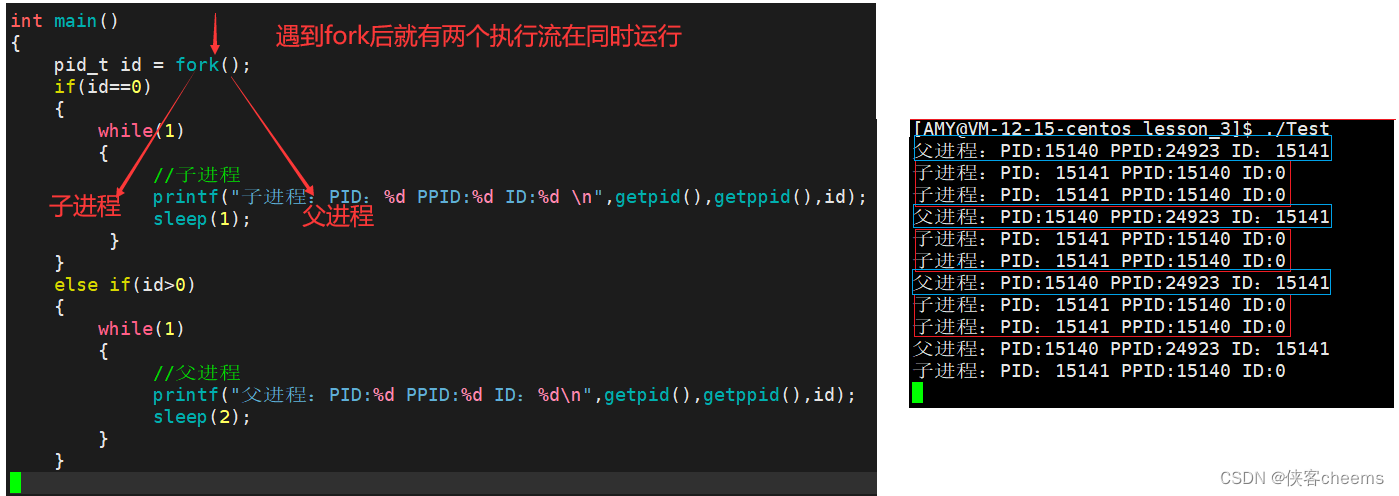

唐圣坤

北卡罗来纳州立大学 在读博士生

本科毕业于武汉大学遥感科学与技术。在本科期间,从事三维重建和遥感图像建筑提取的研究。在2023年秋季加入北卡州立大学胥栋宽教授研究组攻读博士学位,从事高效与可靠人工智能方面的研究。目前的研究主要集中在多模态学习领域。

Github:

https://tangshengku.github.io/

张磊

浙江大学 硕士生

浙江大学硕士。主要研究方向,数据集蒸馏,模型蒸馏,高效训练。

长按识别二维码,一键预约TALK!

-The End-