用Python建立Pipeline - 优化你的数据处理流程

如果你是一位数据科学家或是数据工程师,那么你一定知道数据处理流程的重要性。数据流程不只是数据的处理和清洗,还包括数据来源的获取以及对数据进行可视化、建模和验证。这个流程可以十分复杂,需要协调众多的工具和技术。但是,如果你使用Python建立数据管道(Pipeline),你可以很大程度地简化这个过程。在下面的文章中,我们将会介绍Python Pipeline是什么,它怎样工作以及为什么Python是一个优秀的选择。

什么是Python Pipeline?

Python Pipeline是多个任务串联在一起的数据流程。为了高效地处理数据,数据科学家和数据工程师都需要能够自动化地执行多个任务,而不是一个个手动接触数据。 Python Pipeline就是为了让这个流程变得更加自然和高效。

Python Pipeline 可以分为三个不同的模块:

- 数据的获取和转换

- 数据的机器学习或是其他分析处理

- 可视化或输出结果

这些模块可以有自己的Python代码文件和单独的容器,也可以是在一个文件中定义的函数,这取决于你的个人偏好和实际运用场景。

Python Pipeline的工作原理

在Python中,把Pipeline定义为一个函数是比较合适的处理方式。这个函数将会有多个处理步骤,每步在数据流程中完成一个任务。

以一个简单的图片分类例子来说明Python的Pipeline工作过程:

- 获取图片和标签数据。

- 将像素数据转换为机器学习模型可接受的格式。

- 定义模型。

- 在模型上训练数据并验证结果。

- 模型预测,输出分类结果并进行可视化。

使用Pipeline,每个步骤将会在下一个步骤开始之前结束。这意味着在实际处理中,你可以根据需要添加或删除任务步骤。

Python为什么是建立Pipeline的优秀选择?

Python是数据科学家和数据工程师们最喜欢的工具之一。这个语言与许多数据科学领域常用的机器学习库(如Pandas和Scikit-Learn)紧密集成在一起,使得处理流程更加容易实现。

另外,Python Pipeline也可以快速地在生产环境中进行部署。在使用Compose或Kubernetes时,你可以轻松地将Pipeline容器化并部署在云端或是独立服务器上。

最后,Python Pipeline还涵盖了大量的数据清洗和预处理库,如NumPy、SciPy、Pandas和Scikit-Learn,可以让你在一个流程中完成所有的数据处理任务,从而使你的流程变得更加高效。

结论

Python Pipeline为处理复杂的数据处理和机器学习挑战提供了一种简单的方式,并使得数据科学家和数据工程师能够更加轻松地实现高效的数据流程。使用Python建立Pipeline,你可以集成多种数据处理技术库,从而在一个流程中完成多个任务,节省时间和大量重复性劳动。

最后的最后

本文由chatgpt生成,文章没有在chatgpt生成的基础上进行任何的修改。以上只是chatgpt能力的冰山一角。作为通用的Aigc大模型,只是展现它原本的实力。

对于颠覆工作方式的ChatGPT,应该选择拥抱而不是抗拒,未来属于“会用”AI的人。

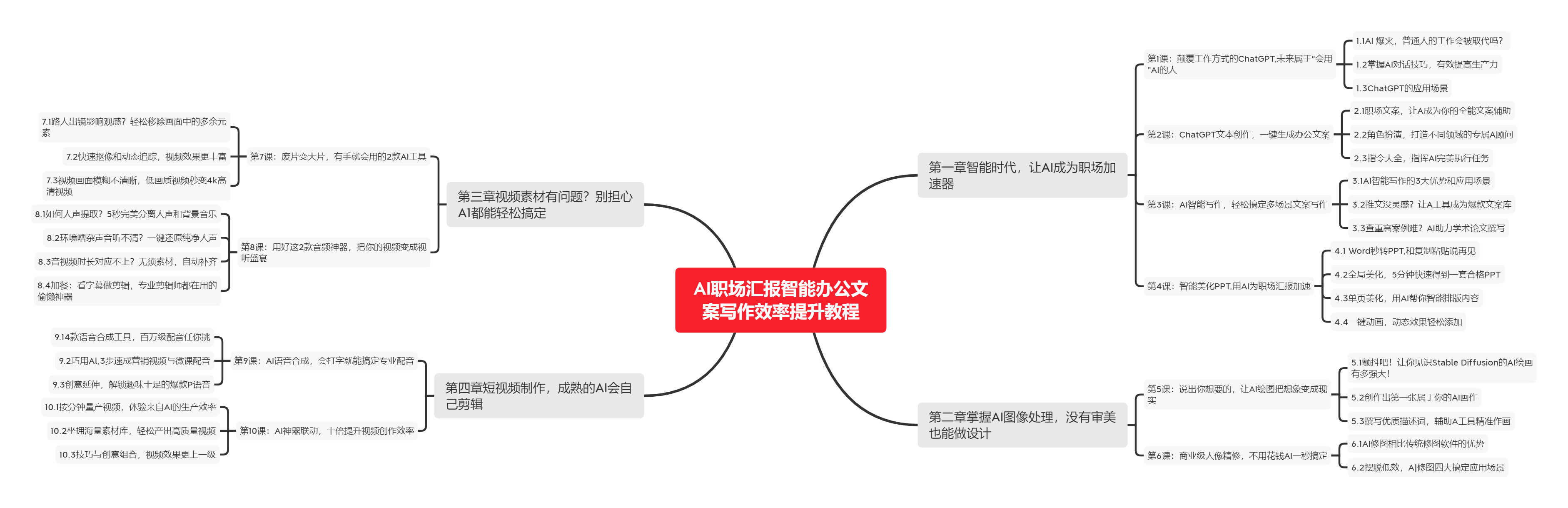

🧡AI职场汇报智能办公文案写作效率提升教程 🧡 专注于AI+职场+办公方向。

下图是课程的整体大纲

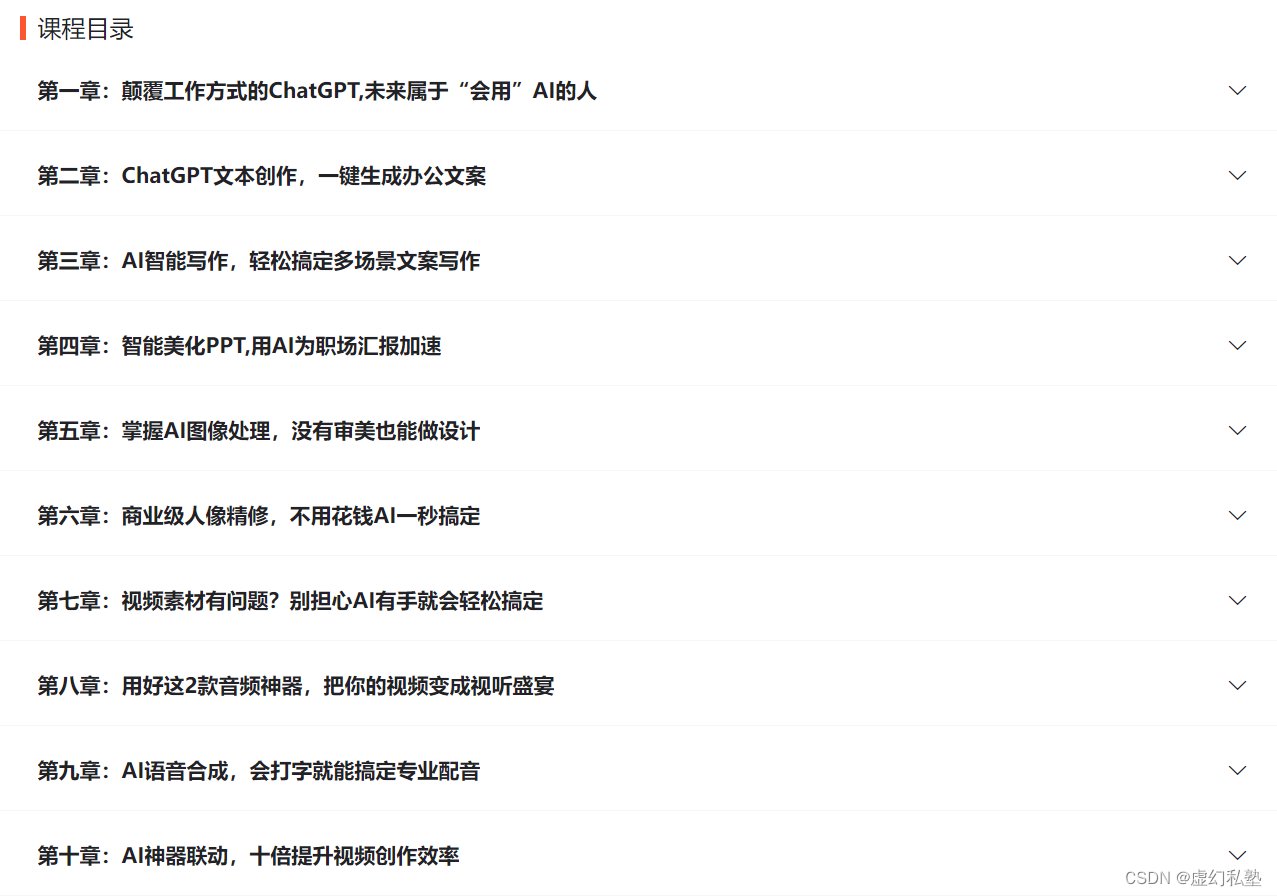

下图是AI职场汇报智能办公文案写作效率提升教程中用到的ai工具

🚀 优质教程分享 🚀

- 🎄可以学习更多的关于人工只能/Python的相关内容哦!直接点击下面颜色字体就可以跳转啦!

| 学习路线指引(点击解锁) | 知识定位 | 人群定位 |

|---|---|---|

| 🧡 AI职场汇报智能办公文案写作效率提升教程 🧡 | 进阶级 | 本课程是AI+职场+办公的完美结合,通过ChatGPT文本创作,一键生成办公文案,结合AI智能写作,轻松搞定多场景文案写作。智能美化PPT,用AI为职场汇报加速。AI神器联动,十倍提升视频创作效率 |

| 💛Python量化交易实战 💛 | 入门级 | 手把手带你打造一个易扩展、更安全、效率更高的量化交易系统 |

| 🧡 Python实战微信订餐小程序 🧡 | 进阶级 | 本课程是python flask+微信小程序的完美结合,从项目搭建到腾讯云部署上线,打造一个全栈订餐系统。 |