随着互联网的发展,爬虫技术也越来越成熟,越来越多的网站开始采取反爬虫策略来保护自己的数据和资源。以下是网站反爬虫策略的分析与研究:

-

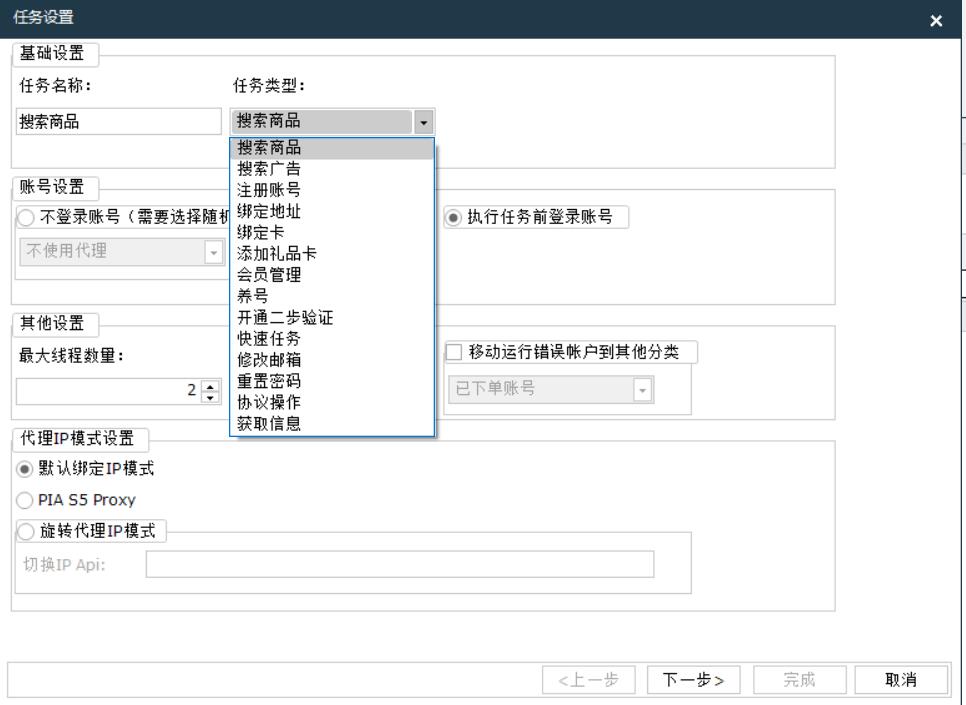

IP封禁:网站可以通过封禁某些IP地址来防止爬虫的访问。这种方法比较简单,但是容易误伤正常用户,因为很多用户可能使用的是动态IP地址。

-

User-Agent识别:网站可以通过识别User-Agent来判断是否是爬虫访问。爬虫可以通过修改User-Agent来伪装成浏览器访问,所以这种方法并不是很可靠。

-

验证码:网站可以在登录、注册、评论等操作时添加验证码,以防止爬虫自动化操作。但是这种方法会增加用户的操作成本,影响用户体验。

-

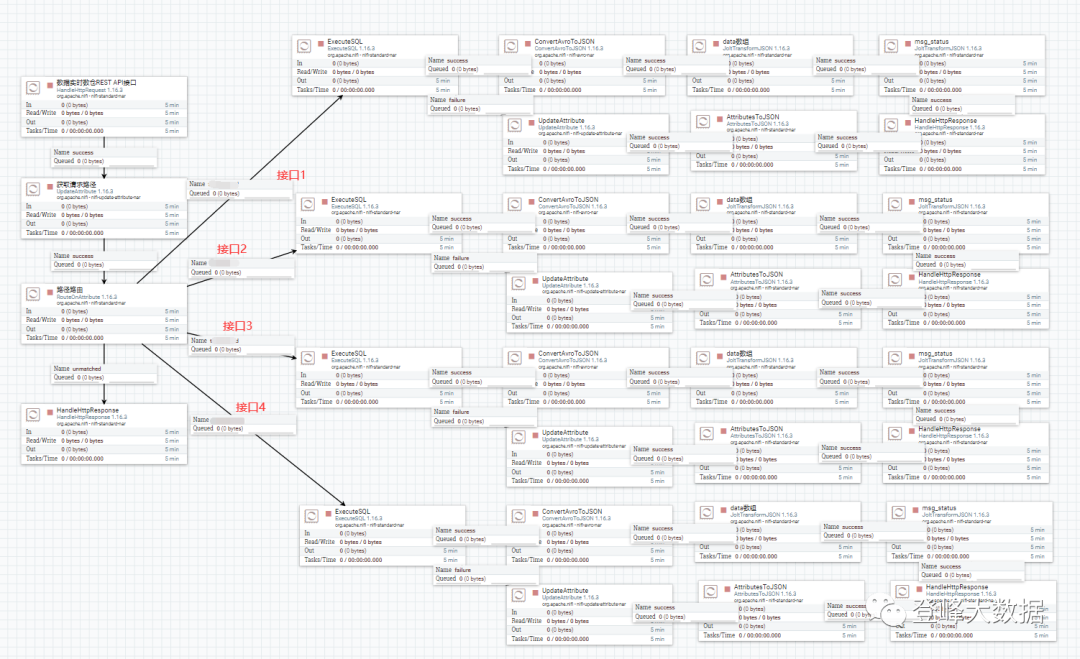

动态页面:网站可以采用动态页面技术,将数据通过Ajax等方式异步加载,以防止爬虫直接获取数据。但是这种方法会增加网站的开发成本和服务器负担。

-

限制访问频率:网站可以限制同一IP地址的访问频率,以防止爬虫过度访问。但是这种方法也容易误伤正常用户,因为有些用户可能需要频繁访问网站。

以下是一些反爬虫的方法: -

验证码:在网站的登录或注册页面添加验证码,要求用户输入正确的验证码才能进行操作。这可以有效防止机器人自动注册或登录。

-

IP限制:限制同一IP地址的访问频率,如果访问频率过高,则可能是爬虫在作祟,可以禁止该IP地址的访问。

-

User-Agent限制:检查HTTP请求头中的User-Agent字段,如果该字段不是常见的浏览器User-Agent,则可能是爬虫在作祟,可以禁止该User-Agent的访问。

-

隐藏数据:将数据分散到多个页面或接口中,使得爬虫需要访问多个页面或接口才能获取完整的数据。

-

动态页面:使用JavaScript等技术生成动态页面,使得爬虫无法直接获取完整的页面内容。

-

限制访问频率:限制同一用户或同一IP地址的访问频率,如果访问频率过高,则可能是爬虫在作祟,可以禁止该用户或IP地址的访问。

-

反爬虫策略:使用反爬虫策略,如随机延时、随机User-Agent、随机代理等,使得爬虫无法轻易地识别和规避反爬虫措施。