系列文章目录

Ubuntu常见基本问题

Hadoop3.1.3安装(单机、伪分布)

Hadoop集群搭建

文章目录

- 系列文章目录

- 一、环境

- 1、创建hadoop用户

- 二、更新apt

- 三、安装SSH、配置SSH无密码登陆

- 四、安装Java环境

- 五、安装 Hadoop3.1.3

- 六、Hadoop单机配置(非分布式)

- 七、Hadoop伪分布式配置

- 1、修改配置文件

- ① core-site.xml

- ② hdfs-site.xml

- 2、启动

- 3、问题

- ① Could not resolve hostname

- ② DataNode 没有启动

- 4、运行Hadoop伪分布式实例

一、环境

1、创建hadoop用户

- ctrl+alt+t 打开终端窗口,输入如下命令创建新用户

sudo useradd -m hadoop -s /bin/bash

- 接着使用如下命令设置密码,按提示输入两次密码

sudo passwd hadoop

- 为 hadoop 用户增加管理员权限

sudo adduser hadoop sudo

- 注销当前用户,返回登陆界面。在登陆界面中选择刚创建的 hadoop 用户进行登陆。

二、更新apt

- 按 ctrl+alt+t 打开终端窗口,执行如下命令,更新 apt

sudo apt-get update

- 安装 vim

sudo apt-get install vim

安装软件时若需要确认,在提示处输入 y 即可。

三、安装SSH、配置SSH无密码登陆

- Ubuntu 默认已安装了 SSH client,此外还需要安装 SSH server

sudo apt-get install openssh-server

- 安装后,可以使用如下命令登陆本机

ssh localhost

此时会有如下提示(SSH首次登陆提示),输入 yes 。然后按提示输入密码,这样就登陆到 本机了

- 退出刚才的 ssh localhost

exit

- 若没有该目录,请先执行一次ssh localhost

cd ~/.ssh/

- 会有提示,都按回车就可以

ssh-keygen -t rsa

- 加入授权

cat ./id_rsa.pub >> ./authorized_keys

此时再使用 ssh localhost,无需输入密码就可以直接登陆了:

四、安装Java环境

- 先把压缩格式的文件jdk-8u162-linux-x64.tar.gz下载到本地电脑,然后保存在“下载”中

- 移动到想存放jdk的目录

cd /usr/lib

- 创建/usr/lib/jvm目录用来存放JDK文件

sudo mkdir jvm

- 进入hadoop用户的主目录

cd ~

- 注意区分大小写字母,刚才已经通过FTP软件把JDK安装包jdk-8u162-linux-x64.tar.gz上传到该目录下

cd 下载

- 把JDK文件解压到/usr/lib/jvm目录下

sudo tar -zxvf ./jdk-8u162-linux-x64.tar.gz -C /usr/lib/jvm

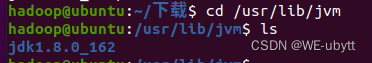

- JDK文件解压缩以后,可以执行如下命令到/usr/lib/jvm目录查看一下

cd /usr/lib/jvm

ls

- 下面继续执行如下命令,设置环境变量

cd ~

vim ~/.bashrc

增加如下配置:

export JAVA_HOME=/usr/lib/jvm/jdk1.8.0_162

export JRE_HOME=${JAVA_HOME}/jre

export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib

export PATH=${JAVA_HOME}/bin:$PATH

- 保存.bashrc文件并退出vim编辑器。然后,继续执行如下命令让.bashrc文件的配置立即生效

source ~/.bashrc

- 可以使用如下命令查看是否安装成功

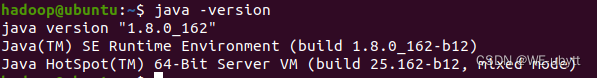

java -version

安装成功!!!

五、安装 Hadoop3.1.3

- 先把压缩格式的文件hadoop-3.1.3.tar.gz下载到本地电脑,然后保存在“下载”中

- 解压到想存放Hadoop的目录中

sudo tar -zxf ~/下载/hadoop-3.1.3.tar.gz -C /usr/local

- 移动到想存放Hadoop的目录

cd /usr/local/

- 将文件夹名改为hadoop

sudo mv ./hadoop-3.1.3/ ./hadoop

- 修改文件权限

sudo chown -R hadoop ./hadoop

- 输入如下命令来检查 Hadoop 是否可用

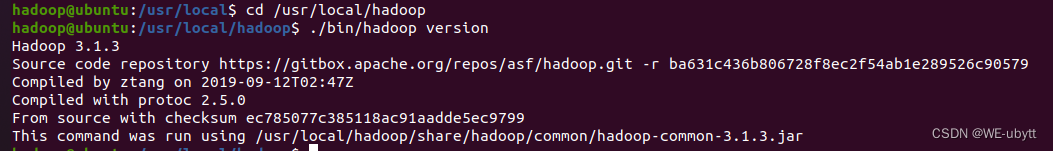

cd /usr/local/hadoop

./bin/hadoop version

安装成功!!!

六、Hadoop单机配置(非分布式)

- 移动到Hadoop目录

cd /usr/local/hadoop

- 创建输出文件

mkdir ./input

- 将配置文件作为输入文件

cp ./etc/hadoop/*.xml ./input

- 筛选当中符合正则表达式 dfs[a-z.]+ 的单词并统计出现的次数,最后输出结果到 output 文件夹中

./bin/hadoop jar ./share/hadoop/mapreduce/hadoop-mapreduce-examples-3.1.3.jar grep ./input ./output 'dfs[a-z.]+'

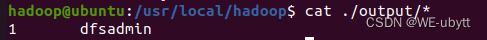

- 查看运行结果

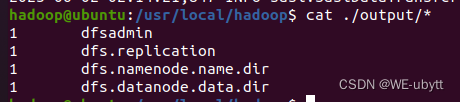

cat ./output/*

成功啦!!!

注意,Hadoop 默认不会覆盖结果文件,因此再次运行上面实例会提示出错,需要先将 ./output 删除。

rm -r ./output

七、Hadoop伪分布式配置

1、修改配置文件

① core-site.xml

cd /usr/local/hadoop/etc/hadoop/

sudo vim core-site.xml

修改为:

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/usr/local/hadoop/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

② hdfs-site.xml

cd /usr/local/hadoop/etc/hadoop/

sudo vim hdfs-site.xml

修改为:

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/data</value>

</property>

</configuration>

2、启动

配置完成后,执行 NameNode 的格式化

cd /usr/local/hadoop

./bin/hdfs namenode -format

成功!!!

接着开启 NameNode 和 DataNode 守护进程

cd /usr/local/hadoop

./sbin/start-dfs.sh

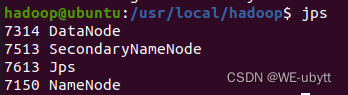

启动完成后,可以通过命令 jps 来判断是否成功启动,若成功启动则会列出如下进程:

“NameNode”、”DataNode” 和 “SecondaryNameNode”

成功啦!!!

3、问题

① Could not resolve hostname

首先按键盘的 ctrl + c 中断启动,然后在 ~/.bashrc 中,增加如下两行内容(设置过程与 JAVA_HOME 变量一样,其中 HADOOP_HOME 为 Hadoop 的安装目录)

export HADOOP_HOME=/usr/local/hadoop

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

然后执行 source ~/.bashrc 使变量设置生效,再次执行 ./sbin/start-dfs.sh 启动 Hadoop

② DataNode 没有启动

cd /usr/local/hadoop

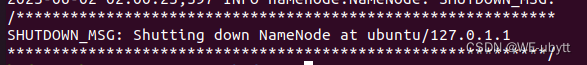

./sbin/stop-dfs.sh # 关闭

rm -r ./tmp # 删除 tmp 文件,注意这会删除 HDFS 中原有的所有数据

./bin/hdfs namenode -format # 重新格式化 NameNode

./sbin/start-dfs.sh # 重启

4、运行Hadoop伪分布式实例

- 在 HDFS 中创建用户目录

./bin/hdfs dfs -mkdir -p /user/hadoop

- 将 ./etc/hadoop 中的 xml 文件作为输入文件复制到分布式文件系统中,即将 /usr/local/hadoop/etc/hadoop 复制到分布式文件系统中的 /user/hadoop/input 中

./bin/hdfs dfs -mkdir input

./bin/hdfs dfs -put ./etc/hadoop/*.xml input

- 复制完成后,可以通过如下命令查看文件列表

./bin/hdfs dfs -ls input

- 测试

./bin/hadoop jar ./share/hadoop/mapreduce/hadoop-mapreduce-examples-3.1.3.jar grep input output 'dfs[a-z.]+'

./bin/hdfs dfs -cat output/*

- 先删除本地的 output 文件夹(如果存在)

rm -r ./output

- 将 HDFS 上的 output 文件夹拷贝到本机

./bin/hdfs dfs -get output ./output

- 展示

cat ./output/*

成功了!!!

Hadoop 运行程序时,输出目录不能存在,否则会提示错误

“org.apache.hadoop.mapred.FileAlreadyExistsException: Output directory

hdfs://localhost:9000/user/hadoop/output already exists”,

因此若要再次执行,需要执行如下命 令删除 output 文件夹

./bin/hdfs dfs -rm -r output

若要关闭 Hadoop,则运行

./sbin/stop-dfs.sh

下次启动 hadoop 时,无需进行 NameNode 的初始化,只需要运行 ./sbin/start-dfs.sh 就可以!