随着Linux的不断普及,使用Linux的人也越来越多了。然而在Linux中如何进行程序设计,用什么样的开发工具好呢?本文就以我初学Linux编程的一点心得体会,和大家共同探讨。

在Linux中进行程序设计,可以使用各种编程语言和开发工具,以下是一些常用的方法:

1、C/C++编程

C/C++是Linux系统中最常用的编程语言之一,可以使用gcc/g++编译器进行编译和调试。

2、Python编程

Python是一种高级编程语言,也是Linux系统中常用的编程语言之一,可以使用Python解释器进行编写和调试。

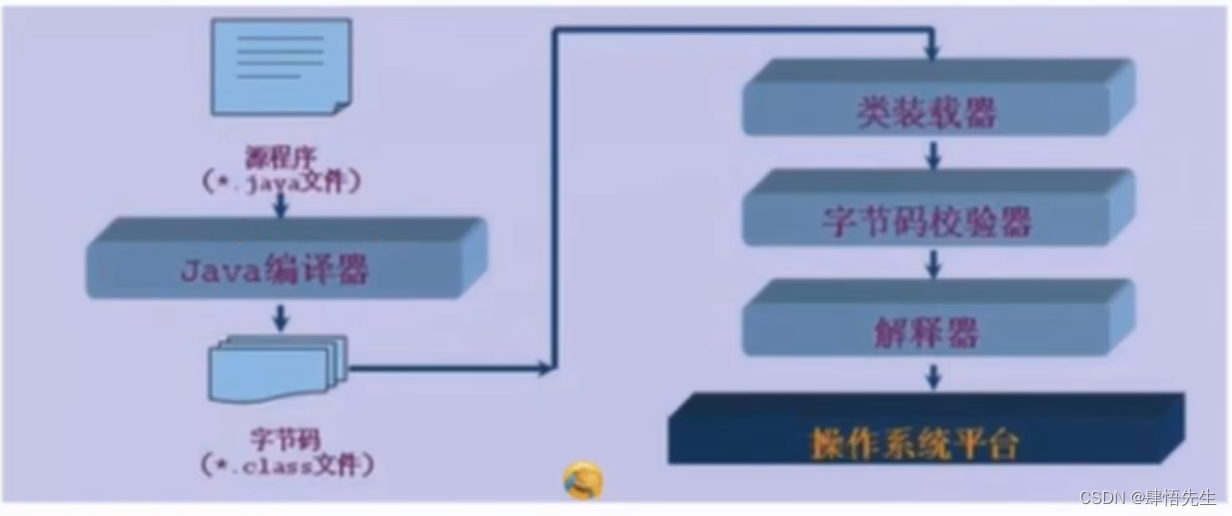

3、Java编程

Java是一种跨平台的编程语言,也可以在Linux系统中进行编写和调试,可以使用JDK和Eclipse等开发工具。

4、Shell脚本编程

Shell脚本是Linux系统中常用的脚本语言,可以使用vi或nano等编辑器进行编写和调试。

5、使用集成开发环境(IDE)

Linux系统中也有一些集成开发环境,如Eclipse、NetBeans等,可以方便地进行程序设计和调试。

总之,在Linux系统中进行程序设计,需要掌握一些基本的编程语言和开发工具,以及Linux系统的基本操作和命令。

Linux是一个开源的操作系统,具有高度的可定制性和灵活性,可以根据用户的需求进行自定义配置和优化。同时,Linux系统具有较高的稳定性和安全性,可以有效地保护爬虫程序的稳定性和安全性。此外,Linux系统还提供了丰富的命令行工具和脚本语言,如Python、Perl等,可以方便地编写和运行爬虫程序。因此,Linux系统成为了爬虫开发者的首选操作系统之一。

C语言爬虫程序

以下是一个用C语言写的简单网络爬虫程序,可以爬取指定 URL 的 HTML 页面。本示例基于Linux系统和POSIX标准库,使用了 socket、string、stdlib 和 unistd 库。

#include <stdio.h>

#include <stdlib.h>

#include <unistd.h>

#include <string.h>

#include <sys/socket.h>

#include <netinet/in.h>

#include <arpa/inet.h>

#include <netdb.h>

#define BUFSIZE 4096

int main(int argc, char **argv) {

if (argc < 2) {

fprintf(stderr, "Usage: %s <url>\n", argv[0]);

exit(-1);

}

char *url = argv[1];

char *tok = strtok(url, "/");

struct hostent *host = gethostbyname(tok);

if (host == NULL) {

perror("gethostbyname failed");

exit(-1);

}

// 创建socket并连接到指定地址

int sockfd = socket(AF_INET, SOCK_STREAM, IPPROTO_TCP);

if (sockfd < 0) {

perror("socket failed");

exit(-1);

}

struct sockaddr_in addr = {0};

addr.sin_family = AF_INET;

memcpy(&addr.sin_addr.s_addr, host->h_addr, sizeof(addr.sin_addr.s_addr));

addr.sin_port = htons(80);

if (connect(sockfd, (struct sockaddr *)&addr, sizeof(addr)) < 0) {

perror("connect failed");

exit(-1);

}

// 发送 HTTP 请求

char request[BUFSIZE] = {0};

snprintf(request, BUFSIZE, "GET /%s HTTP/1.1\r\n", strstr(url, "/"));

ncat(request, "User-Agent: Mozilla/5.0\r\n", BUFSIZE-strlen(request));

strncat(request, "Accept: */*\r\n", BUFSIZE-strlen(request));

strncat(request, "Connection: close\r\n", BUFSIZE-strlen(request));

strncat-strlen(request));

strncat(request, host->h_name, BUFSIZE-strlen(request));

strncat(request, "\r\n\r\n", BUFSIZE-strlen(request));

if (send(sockfd, request, strlen(request), 0) < 0) {

perror("send failed");

exit(-1);

}

// 接收响应并打印

char response[BUFSIZE] = {0};

int nrecv = recv(sockfd, response, BUFSIZE-1, 0);

while (nrecv > 0) {

response[nrecv] = '\0';

printf("%s", response);

nrecv = recv(sockfd, response, BUFSIZE-1, 0);

}

close(sockfd);

return 0;

}

本程序使用 HTTP GET 请求从指定的 URL 获取 HTML 内,并将其打印到控制台上。注意:实际使用爬虫要遵守网站规则,不会对他人的内容进行未经允许的访问和抓取。

Python爬虫程序

Python爬虫程序是一种自动化程序,用于从互联网上获取数据。以下是一个简单的Python爬虫程序的示例:

import requests

from bs4 import BeautifulSoup

url = 'https://www.example.com'

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

# 获取页面标题

title = soup.title.string

print(title)

# 获取页面所有链接

links = []

for link in soup.find_all('a'):

links.append(link.get('href'))

print(links)

这个程序使用了requests库和BeautifulSoup库来获取网页内容和解析HTML。它首先发送一个GET请求到指定的URL,然后使用BeautifulSoup解析响应文本。最后,它获取页面标题和所有链接,并将它们打印出来。