l1l2正则和dropout正则化[https://youzipi.blog.csdn.net/article/details/75307522]

LN和BN归一化 [深度学习:批归一化Batch Normalization]

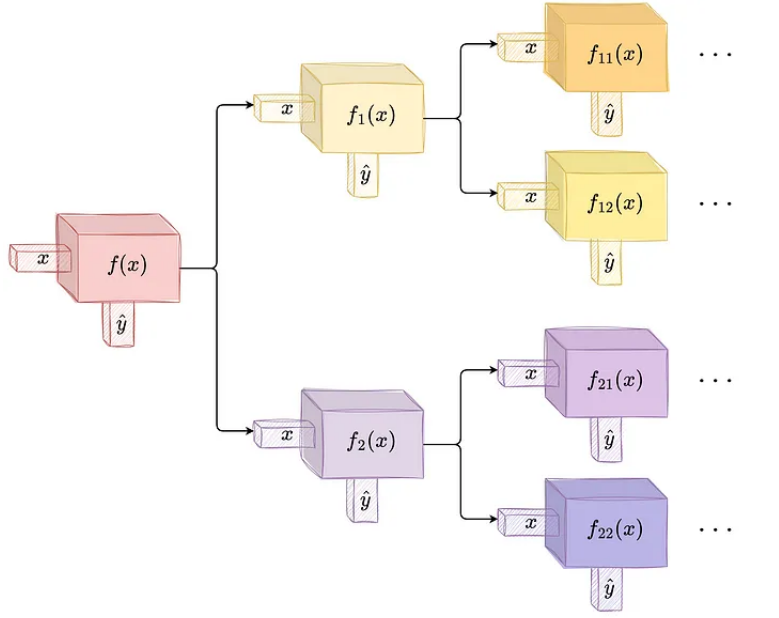

主流大模型使用的Normalization主要有三类,分别是Layer Norm,RMS Norm,以及Deep Norm。

Post-Norm和Pre-Norm

根据Normalization在结构中的位置,也可分为Post-Norm和Pre-Norm。

一般认为,Post-Norm在残差之后做归一化,对参数正则化的效果更强,进而模型的收敛性也会更好;

而Pre-Norm有一部分参数直接加在了后面,没有对这部分参数进行正则化,可以在反向时防止梯度爆炸或者梯度消失,大模型的训练难度大,因而使用Pre-Norm较多。

Pre-Norm可能更容易训练,因为它可以更好地避

![Linux [权限]](https://img-blog.csdnimg.cn/3d399d3cb3e94394bfc8cb8209bf7738.png)