多线程爬虫是指通过多个线程并发地请求网页和解析响应,以提高爬虫的效率和速度。在 Python 中可以使用 threading、Queue 和 requests 等模块来实现。

并行编程是一种利用多个处理器/内核/线程来同时执行代码的编程方式。它可以解决以下几个问题:

提升程序的性能

在多任务或多进程场景下,使用并行编程可以有效地提高程序的运行效率和响应速度,充分利用计算资源,使得程序能够更快地完成任务。

解决单点故障

传统的串行程序在出现 bug 或崩溃时可能会导致整个程序停止运行。而通过并行编程,将任务分割成多个子任务,即便其中某一个任务出现问题,也不会影响整个程序的正常运行。

解决数据共享和同步问题

在多进程或多线程的环境下,多个任务可能会共享同一个数据资源,因此需要使用锁或信号量等机制来确保数据的正确性、可靠性和同步性,避免数据竞争、死锁、饥饿等问题。

支持大规模分布式计算

在云计算和大数据领域,数据量巨大,单机处理能力有限,需要大规模分布式计算框框架来支持海量数据的存储、处理和分析,因此并行编程是实现这些架的重要手段。

总之,并行编程能够提高程序的性能、可靠性和扩展性,适用于多任务、多进程、多线程、分布式计算等场景,并且是现代计算机编程领域中不可或缺的技术。

多线程编程

多线程编程是指在一个程序中同时运行多个线程,每个线程都可以独立执行不同的任务。多线程编程可以提高程序的性能和响应速度,特别是在处理大量数据或需要同时执行多个任务的情况下。

在多线程编程中,需要注意以下几点:

1、线程安全

多个线程同时访问共享资源时,需要确保数据的一致性和正确性,避免出现竞态条件等问题。

2、同步机制

为了保证线程安全,需要使用同步机制,如锁、信号量、条件变量等。

3、线程调度

多个线程同时运行时,需要合理地分配CPU时间片,避免某个线程长时间占用CPU资源,导致其他线程无法运行。

4、线程池

为了避免频繁地创建和销毁线程,可以使用线程池来管理线程,提高程序的性能和效率。

在实际编程中,可以使用多种编程语言和框架来实现多线程编程,如Java的Thread类、Python的threading模块、C++的std::thread库等。同时,也可以使用多种工具和技术来调试和优化多线程程序,如调试器、性能分析工具、多线程编程模型等。

多线程编程详解

多线程编程是一种利用多个线程(并发执行流)来同时执行代码和完成任务的编程方式。它具有如下特点:

并发执行:多个线程可以并发执行,使用 CPU 和其他资源。

共享内存:多个线程共享进程的地址空间和内存资源,包括全局变量、代码段、数据段等,因此需要注意对共享数据的访问和修改。

轻量级:每一个线程都是一个轻量级的执行流,从而便于线程的创建、销毁和切换。

复杂性高:由于多线程存在竞态、死锁等问题,因此开发和调试复杂度高。

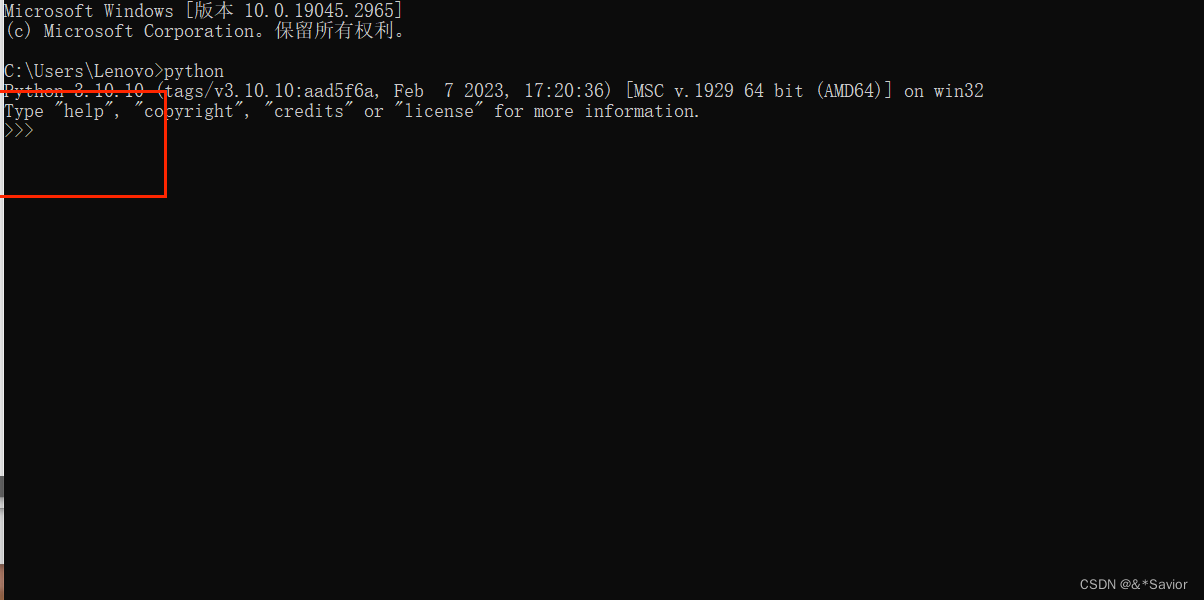

在 Python 中,可以使用 threading 模块实现多线程编程。常用的方法包括:

创建线程:通过 threading.Thread 类来创建新的线程对象并安排其运行。

import threading

def worker():

"""线程执行函数"""

print('Hello, world!')

# 创建新的线程并启动

t = threading.Thread(target=worker)

t.start()

线程同步:Python 提供了多个线程同步机制(例如 Lock、Event、Semaphore、Condition 等),可以协调不同线程之间的行为。

import threading

# 创建一个信号量,初始值为 1

sem = threading.Semaphore(1)

def worker():

sem.acquire()

try:

"""操作共享资源"""

finally:

sem.release()

线程池为了避免线程频繁创建和销毁的开销,可以使用线程池技术(例如 concurrent.futures 模块)来复用线程,提高程序效率。

from concurrent.futures import ThreadPoolExecutor

def worker():

"""线程执行函数"""

print('Hello, world!')

# 创建线程池

with ThreadPoolExecutor(max_workers=4) as executor:

for i in range(10):

executor.submit(worker)

需要注意的是,在进行多线程编程时需要注意线程之间共享数据的原子、线程的启停和同步等问题,避免出现数据竞争、死锁等相关问题。

以下是一个简单的多线程爬虫示例:

import requests

from queue import Queue

import threading

# 定义线程数量和目标网址

thread_num = 4

url = 'http://www.example.com'

# 创建队列用于存放待下载的 URL

url_queue = Queue()

# 将网址入队

for i in range(100):

url_queue.put(url)

# 定义线程执行函数

def worker():

while True:

try:

# 获取待下载的 URL

url = url_queue.get(block=False)

# 下载并解析响应

response = requests.get(url)

content = response.text

# 接下来可以进行数据处理或保存等操作

except Exception as e:

print(e)

break

# 创建多个线程并启动

threads = []

for i in range(thread_num):

t = threading.Thread(target=worker)

threads.append(t)

t.start()

# 等待所有线程执行完毕

for t in threads:

t.join()

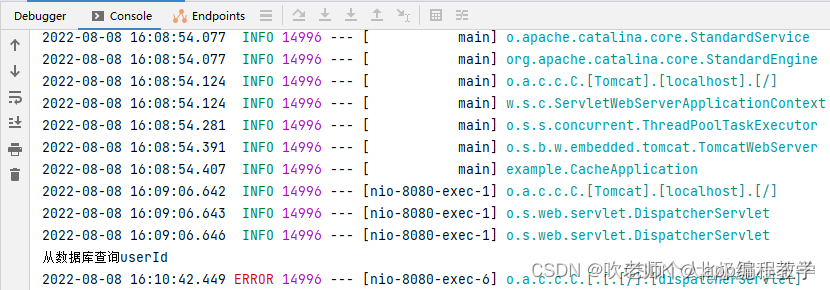

在这个示例中,我们首先定义了线程数量和目标网址,并创建了一个存放待下载网址的队列。随后,我们创建多个线程,每个线程都从队列中取出待下载的网址,并利用 requests 库进行下载和解析。需要注意,在多线程爬虫中我们需要注意对数据的同步处理,避免出现数据竞争等问题。最后,我们等待所有线程执行完毕,并输出相关信息。