论文地址:《Automated Phrase Mining from Massive Text Corpora》

git地址:

GitHub - shangjingbo1226/AutoPhrase: AutoPhrase: Automated Phrase Mining from Massive Text Corpora

目录

简介:

1.短语需要满足什么条件?

2.算法流程

1)生成候选短语:

2)候选短语的质量预估

3)切分句子

4)重新进行短语质量预估

3.研究方法

1)Robust Positive-Only Distant Training

2)POS-Guided Phrasal Segmentation

目录

简介:

1.短语需要满足什么条件?

2.算法流程

1)生成候选短语:

2)候选短语的质量预估

3)切分句子

4)重新进行短语质量预估

3.研究方法

1)Robust Positive-Only Distant Training

2)POS-Guided Phrasal Segmentation(基于词性标注的短语切分)

4.实验效果

简介:

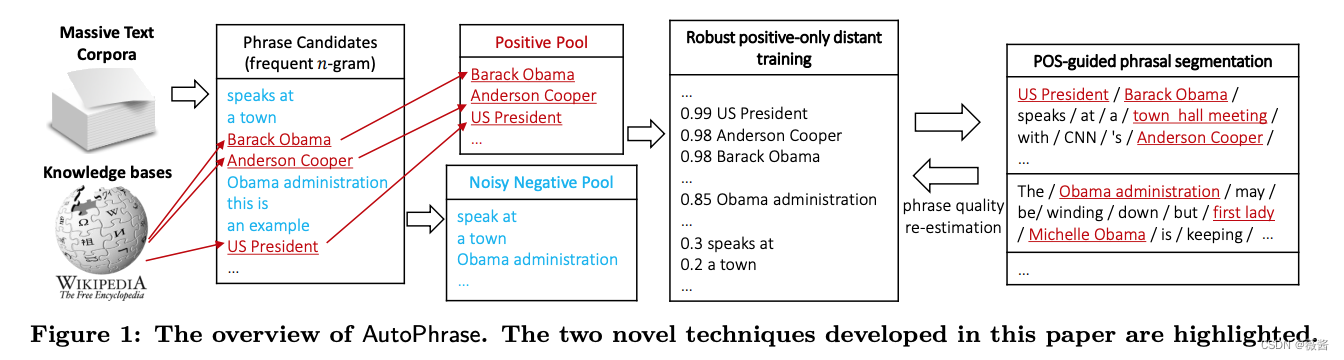

autophrase是一种半监督的新词发现的研究,是韩家炜团队在短语挖掘中的又一力作。它利用现有通用知识库(例如wiki)中出现的高质量短语,使用远程训练(减少人力投入)和a POS-guided短语切分(提升模型表现),仅需要极少人力就可以适应各个领域。

1.短语需要满足什么条件?

1)流行度,出现过一定次数

2)一致性,P(AB)>P(A)*P(B)

3)有信息量的

4)完备性,比如“机器学”其实不是一个完整的短语,因为它一般是作为“机器学习”的一部分出现的。

2.算法流程

1)生成候选短语:

使用n-grams挖掘可能存在的短语候选名单,可以设定最小支持度(例如30)和最大长度(例如6),生成一批满足条件的短语

2)候选短语的质量预估

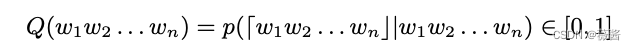

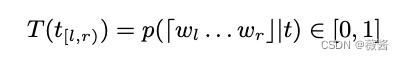

其中,「w1,w2...wn」表示这些词能否形成一个短语,Q(·)则是质量评估器,初始Q从数据的统计特征中学习,例如点间互信息(point-wise mutual information),point-wise KL divergence(点间KL散度)和IDF(逆文档频率),用这些信息来刻画之前提到的一致性和信息度。

对于unigrams,我们设置它的短语质量为1

3)切分句子

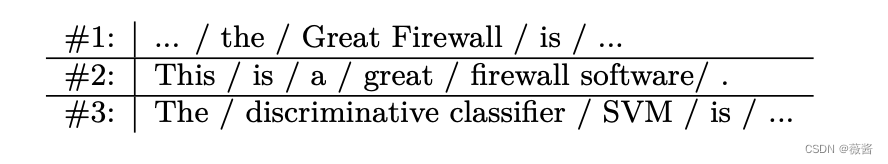

根据完备性,短语切分为每个句子选择最合适的切分方式,如下图

4)重新进行短语质量预估

根据新的切分方式,重新计算相关的短语频率以及短语质量,

重新计算短语频率:比如上图中的Great Firewall原先的频率是2(1和2中出现),但是修正过的词频是1(只有1中出现,2中被切分开了)

整合了重新分割后的词频,质量评估器Q(·)除了可以刻画之前提到的一致性和信息度,也可以对前面提到的完备性进行建模。

3.研究方法

1)Robust Positive-Only Distant Training

a)标签池

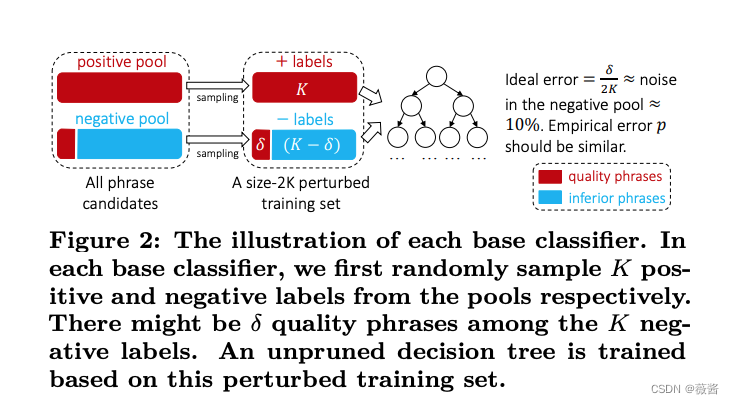

如整体流程图所示,我们将语料中命中wiki title/keywords和内链的候选短语视作高质量短语,作为正标签池,将剩余的候选短语作为负标签池,注意这里的负标签池是有噪声的,大概10%的高质量短语是被归为了负标签池,所以第二步就是要降噪。

b)降噪

直接在正负标签池中进行训练的话是不明智的,会错失一部分的正例,所以autophrase中使用集成模型(随机森林)来降低这部分误差。

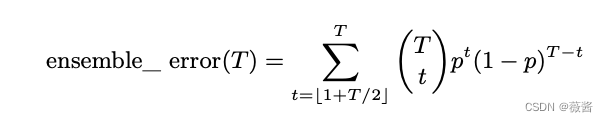

如图所示,每次从训练集中有放回的抽取K个样本作为“扰动训练集”,然后训练T棵树,集成模型的误差就是一半树预测错误的概率:

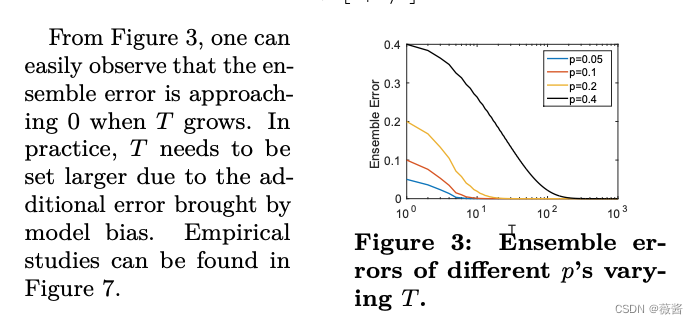

随着树的增加,整体误差随着p的变化情况(由于模型本身存在的偏差,T要设置的再大一些)

2)POS-Guided Phrasal Segmentation(基于词性标注的短语切分)

短语切分的一大挑战就是词语的完备性,我们利用浅层语义信息pos tagging来帮助我们解决这一问题。

先将语料集分为n个词性标注后的序列:Ω = Ω1Ω2 . . . Ωn

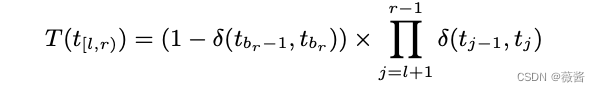

其中Ωi=<wi, ti>,wi是第i个单词,ti是第i个单词的词性标注,基于词性标注的短语切分就是指将一段这么一个序列切分成m个片段,B = {b1, b2, . . . , bm+1} ,其中1 = b1 < b2 < . . . < bm+1 = n+1,第i个片段就是ΩbiΩbi+1 . . . Ωbi+1−1,词性标注质量评估器:T(t[l,r))

对于一个词性标注序列:NN NN NN VB DT NN,一个好的词性标注评估器会返回:

T(NN NN NN) ≈ 1 并且T(NN VB) ≈ 0

公式为:

δ(tx, ty) 表示tx和ty在短语中相邻且tx在ty之前的概率,公式的前半部分表示在br-1和br之间切分的概率,后半部分表示t[l,r) 同属一个短语的概率。整个公式更倾向于长的分词结果,因为对于

任意的i>1,总会乘上δ(ti−1, ti) 或者 (1 −δ(ti−1, ti)) 其中之一的结果。

在数学上,δ(tx, ty) 表示为:

δ(tx, ty) = p(「. . . w1w2 . . .」|Ω,tag(w1) = tx ∧ tag(w2) = ty),随着短语分割而不断学习。

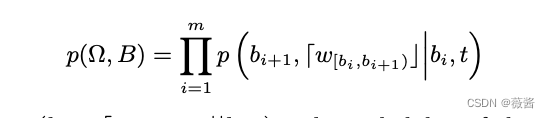

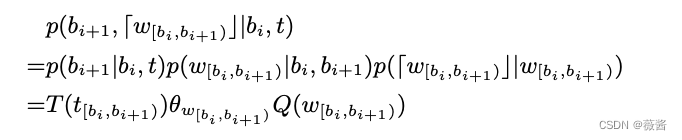

我们现在有了短语质量评估器Q和词性标注质量评估器T,定义基于词性标注序列Ω 和分割索引序列B = {b1, b2, . . . , bm+1} 的联合概率分布为:

给定pos tag序列t和开始索引bi,以如下过程生成:

1.根据词性标注质量,生成结束索引bi+1

p(bi+1|bi, t) = T(t[bi,bi+1))

2.根据首尾两端的索引,根据多项式分布,生成w[bi,bi+1)

p(w[bi,bi+1)|bi, bi+1) = p(w[bi,bi+1)|bi+1 − bi)

3.根据短语质量,判断 w[bi,bi+1)是否是一个高质量的短语

p(dw[bi,bi+1)c|w[bi,bi+1)) = Q(w[bi,bi+1))

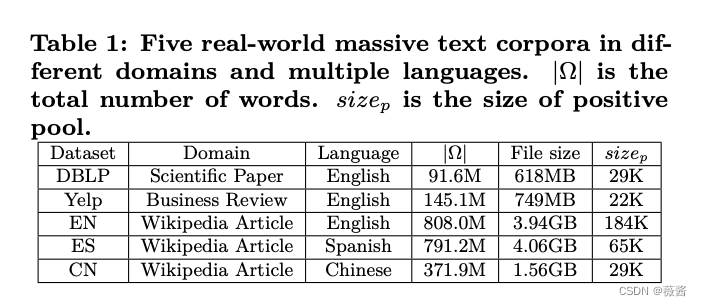

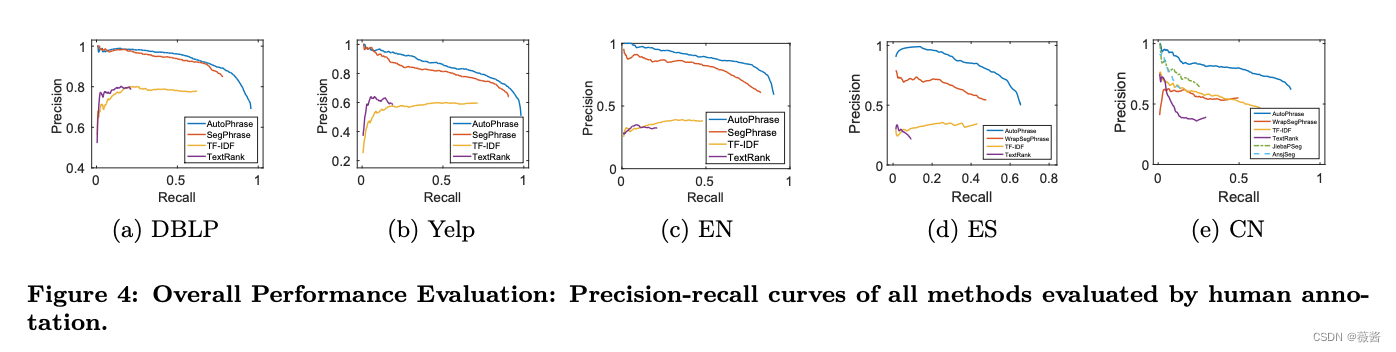

4.实验效果

在多领域多语言的环境下,都取得了sota的结果,且相比于他们之前的segphrase,需要更少的人工标注。