目录

摘要

论文阅读

1、标题和现存问题

2、使用GNN进行文本分类

3、INDUCT-GCN

4、实验准备

5、实验结果

深度学习

1、时空图的种类

2、图在环境中的应用

3、STGNN

总结

摘要

本周在论文阅读上,阅读了一篇InducT-GCN:归纳图卷积文本分类网络的论文。基于训练文档的统计量构造一个图,并将文档向量用单词向量的加权和表示。然后在测试过程中进行单向GCN传播。实验证明,文章模型优于最先进的方法。在深度学习上,继续对图相关知识进行学习,在下周计划开始研究论文写法。

This week,in terms of thesis reading,perusaling a paper on InducT-GCN: Inductive Graph Convolutional Text Classification Network.Constructing a graph based on the statistics of the training document and representing the document vector as a weighted sum of word vectors.Then conducting one-way GCN propagation during the testing process.Experiments have shown that the article model outperforms state-of-the-art methods.In deep learning,continue learning about graph related knowledge and planning to start researching paper writing methods next week

论文阅读

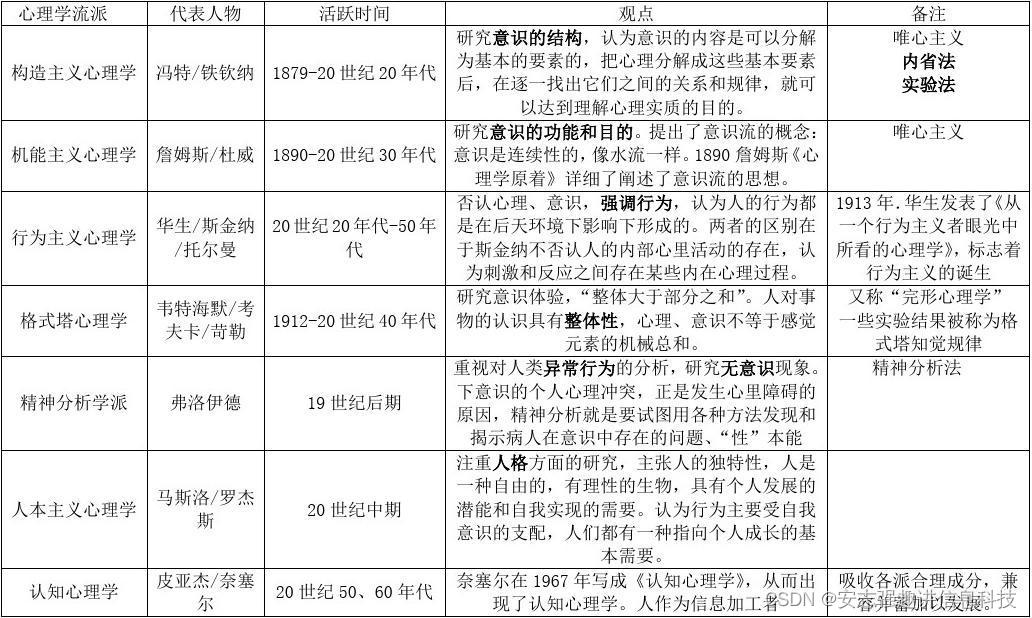

1、标题和现存问题

标题:InducT-GCN:归纳图卷积文本分类网络

现存问题:大多数图模型本质上是转换的。单词/文档的学习节点表示/嵌入并不能自然地推广到未见过的单词/文档,这使得它很难应用到现实世界中。当语料库规模较大时,这些基于图的学习模型的转导性质需要相对较大的计算空间。因此,需要一个归纳模型。将基于图变换的文本分类扩展为归纳模型。

要求:1、归纳学习模型在训练过程中不能包含任何测试集信息。

2、归纳模型在学习一个新的样本时,不能在整个新的图上重新训练模型。

3、利用语料库级基于图的文本分类方法建立归纳模型。

2、使用GNN进行文本分类

gnn在各种NLP任务中得到了运用,包括文本分类。基于gnn的文本分类模型可以分为两种类型,文档级和语料库级方法。在一些基于图的文本分类模型以单词为节点为每个文档构建一个图。单词节点由外部资源和预先训练的嵌入表示,这些边要么使用词共现信息要么仅仅连接句子中的概念词。因此,在模型训练/学习过程中,没有考虑到一个语料库/整个数据集的显式全局结构信息。

文章提出了文本分类 textcn中的语料库级 GNN,以文档和单词为节点构建整个文本语料库的图。它捕获整个语料库的全局信息,并进行节点(文档)分类。

文章中的模型InducT-GCN是一个基于归纳图的文本分类框架,它构建了一个语料库级的图,但采用了归纳学习的性质,自然地归纳到看不见的节点。

3、INDUCT-GCN

文章提出了一种用于文本分类的归纳图卷积网络(归纳图卷积网络),命名为“InducT-GCN”,它可以是传统的基于转导式GCN的文本分类模型的扩展。采用传统的基于gcn转导的文本分类模型,包括TextGCN[6]和SGC,并重点将其扩展为高效的归纳学习模型。

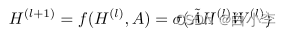

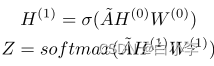

在GCN模型中,每个隐含层的传播规律为:

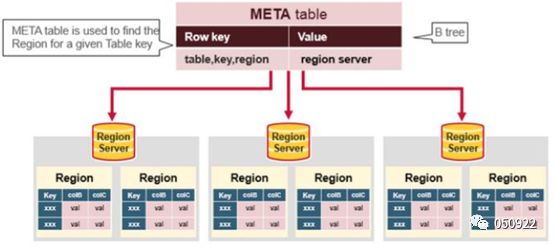

在GCN之后,TextGCN构建了一个大型语料库级图,但以文本信息、文档和单词作为节点,因此可以对全局词-文档共现进行建模。所构造的图包含训练集和测试集的文档和单词节点。TextGCN的目标是用两个主要边来建模全局的word-document发生:1)word-word边缘:由共现信息点互信息(PMI)计算,2)文档-word边缘:TF-IDF。将一热向量输入两层GCN模型,共同学习文档和单词的嵌入。训练集中文档节点的表示用于训练分类模型,而测试集中文档节点的表示用于预测。

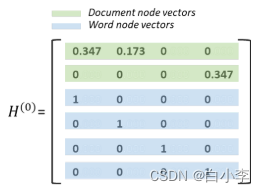

基于归纳gcn的文本分类模型InducT-GCN严格不考虑来自测试集的任何信息或统计数据,这些信息或统计数据被认为是看不见的节点。相反,只使用训练文档信息来构造节点。考虑一组节点V = {Vtrain, Vword}, Vword是训练文档中唯一的单词。为了定义InducT-GCN图中图节点的输入向量H(0),考虑两个要求:

(1)在传播阶段,将图视为同构图,即将所有节点视为同一类型,而不检查它们是文字节点还是文档节点。然后,文档节点和word节点的所有输入向量应相互对齐。

(2)我们的InducT-GCN不能使用一个热向量来表示文档节点,以避免在训练过程中学习测试文档的任何表示。

为InducT-GCN图定义了两边类型:

(1)带有PMI的WordWord和

(2)带有TF-IDF的Word-Doc边。

注意,每个节点也连接到自己。PMI是根据切片窗口中一对单词的共现来计算的。

当两个输入文档为“word1 word1 word2 word3”和“word3 word4”时的表示:

在构建完图之后,使用两层GCN来训练它。第一个GCN层学习单词嵌入。第二层GCN层的维数是数据集的类数,输出被输入softmax激活函数。例如,一个二元分类任务将导致第二层GCN层的维数为2。训练文档上的节点表示用于交叉熵损失计算和反向传播。在形式上,传播可以描述为:

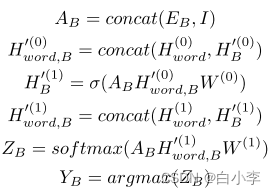

在GCN中,每一层的传播是通过节点的一阶邻居和节点本身的加权和来更新节点。为了对测试集做出预测,每个测试文档的一阶和二阶邻居表示应该被聚合。注意,我们只在测试阶段使用测试文档,因此在传播期间不需要更新图中的所有节点。

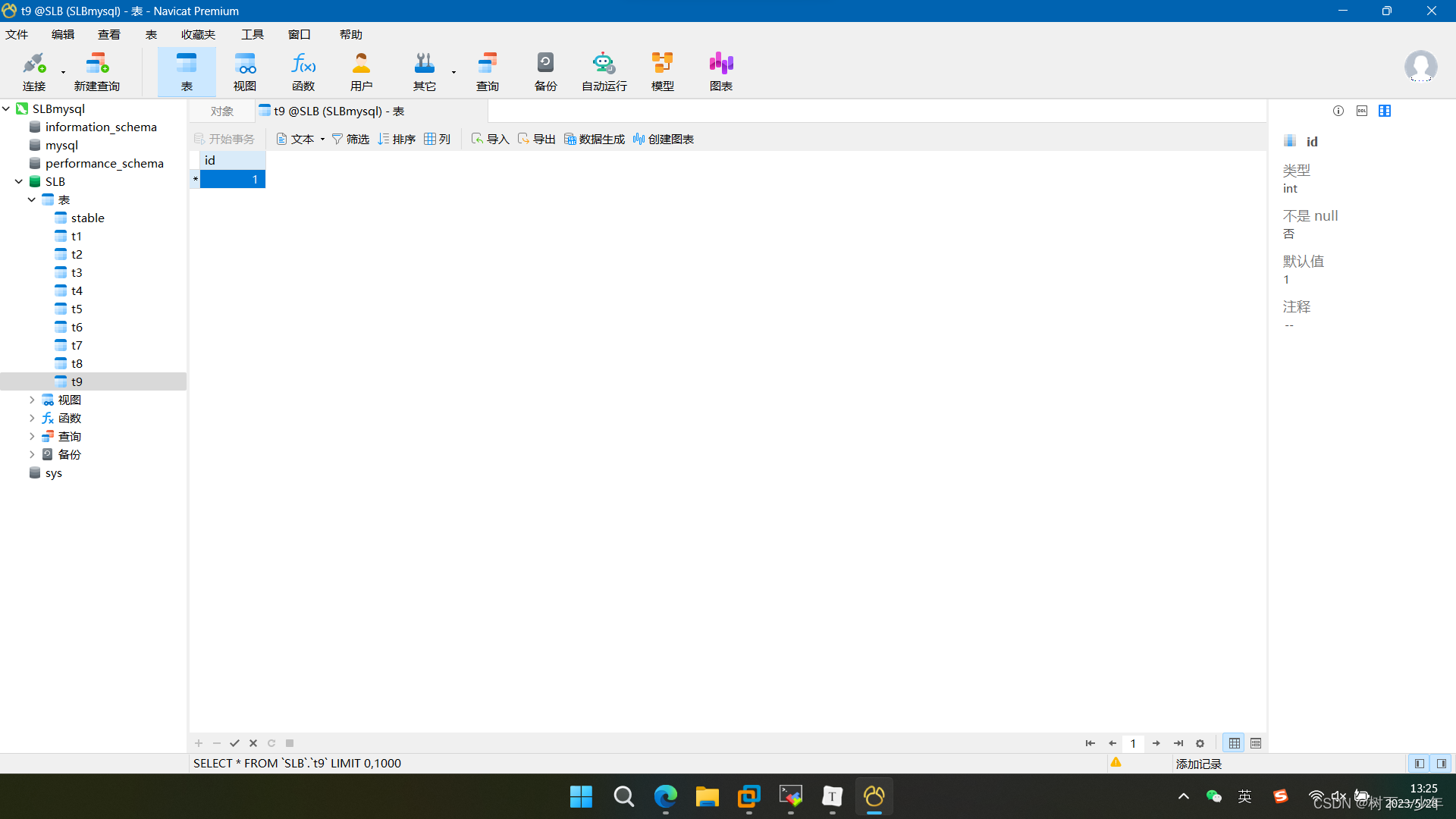

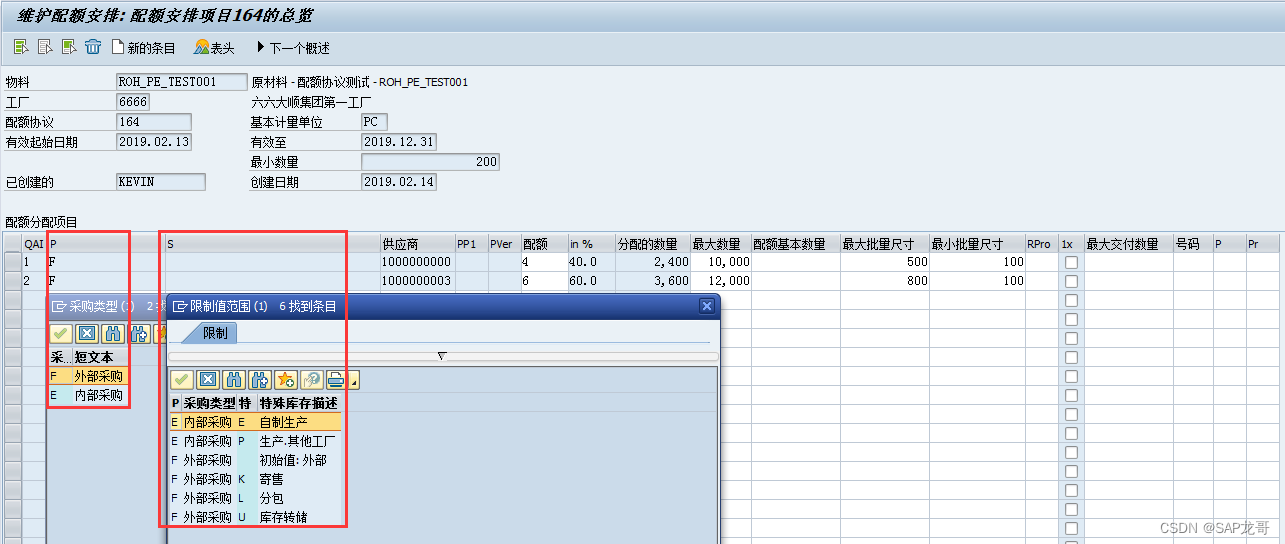

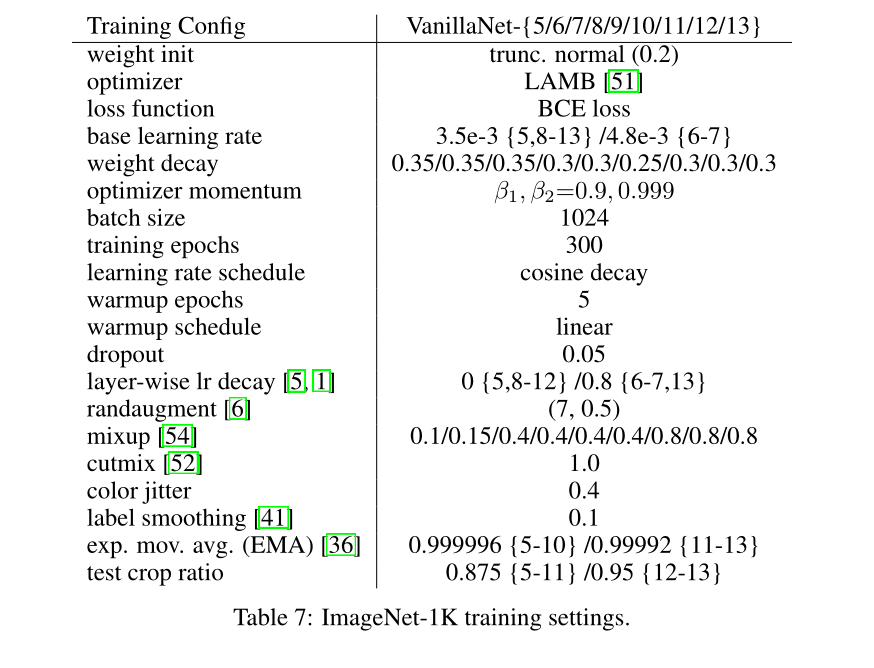

4、实验准备

导入- gcn培训和测试阶段:

测试阶段可以描述为:

数据集准备:R8, R52, Ohsumed, 20NG,mr。

所有数据集都进行预处理。如果在训练文档中出现的单词少于两次,我们将删除这些单词,因为只出现一次的单词不能作为两个文档节点之间的桥梁。NLTK停止词列表中列出的词也被删除。对所有的实验都采用相同的预处理方法。

将同一组超参数应用于所有数据集,而不进行超参数调优,以便进行公平的比较。对于TextGCN , SGC,我们的InducT-GCN和InducT-SGC,采用了两层图卷积,隐维为200。学习速率为0.02的Adam优化器用于训练。每次实验之后,设200个epoch为最大的epoch数,提前停止10个epoch。随机选取训练集的10%作为验证集。通过使用默认的超参数,其他基线模型也应用了早期停止机制。然后,我们使用精度作为评价指标,并对每个测试结果产生10次运行结果的平均值和标准差。

5、实验结果

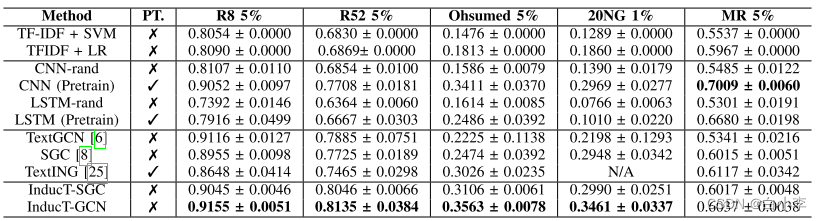

下表显示了原始的转导SGC模型和我们的InducT-SGC模型的对比。如表所示,当标记数据有限时,我们的InducTSGC比原始的SGC产生更高的性能。原始的和我们的归纳模型textgcn - induct - gcn和SGCto-InductSGC之间的性能改进,清楚地显示了我们所提出的归纳框架的泛化能力。它也可以应用到其他语料库级的基于图的文本分类模型中

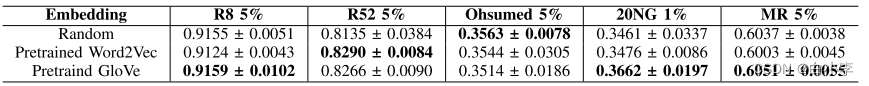

不同初始化嵌入方法的测试精度:

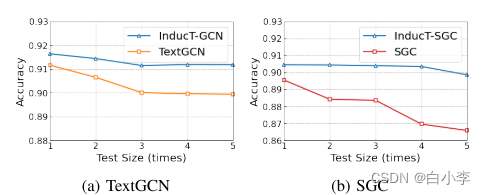

TextGCN和InducT-GCN、SGC在不同测试尺寸下的对比:

测试规模越大,TextGCN与InducT-GCN之间的差距越大。当测试大小最大时,TextGCN的性能会更差。这主要是因为只有一小部分文档节点会在较大的测试集下对TextGCN中的梯度做出贡献。特别是在训练阶段,TextGCN很难通过反向传播来学习与word节点连接较少的测试文档节点的嵌入。此外,测试大小增加时,InducT-GCN的性能只下降了一点点(小于0.5)。将归纳图构建和学习框架InducT-SGC应用于SGC,也在SGC上进行了同样的评估。就像我们的InducT-GCN产生的结果一样,InducT-SGC提供了比原来的SGC更高的性能。性能趋势显示了我们的归纳学习框架如何完美地适应归纳学习的本质。

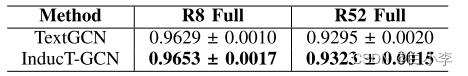

还使用完整的数据集评估了我们的InducT-GCN的性能,就像评估TextGCN一样。从表中可以看出,当使用具有相同超参数的整个数据集时,InducT-GCN和TextGCN在R8和R52上的性能是可以比较的。可以得出结论,InducT-GCN在性能和计算上都优于TextGCN,不仅在更小的空间和更少的参数,而且在整个数据集设置。

深度学习

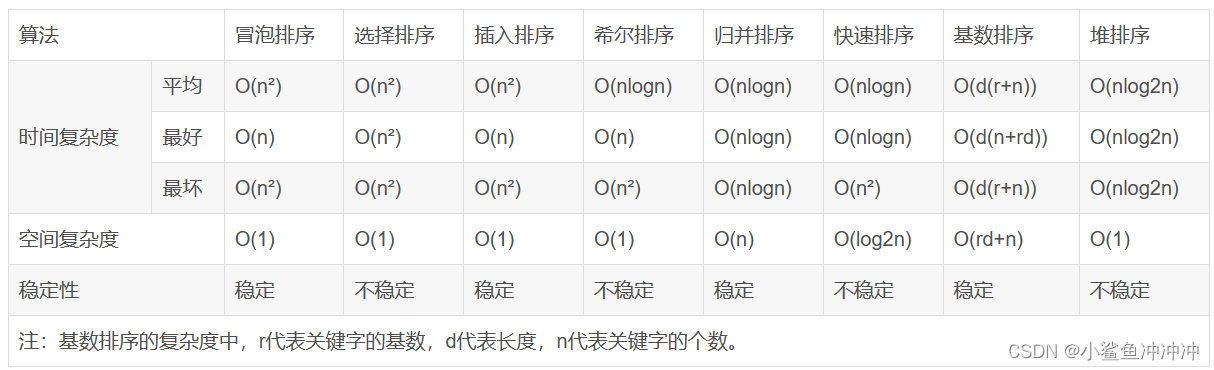

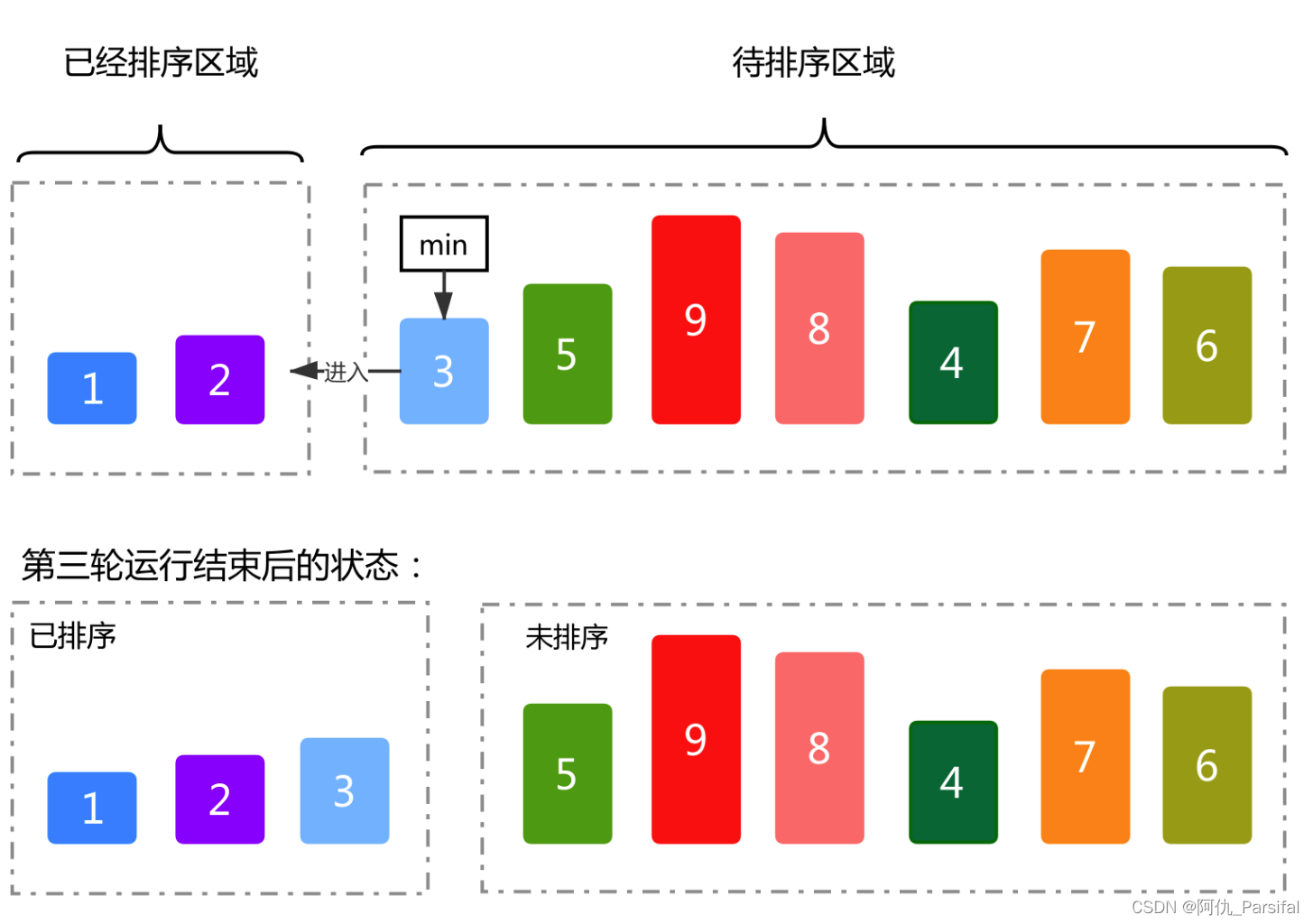

1、时空图的种类

基于拓扑的时空图

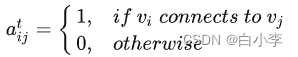

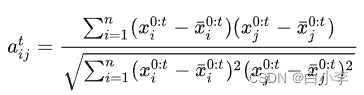

邻接矩阵公式化:

其中 a_t 表示时刻t邻接矩阵中的元素。由于拓扑结构中的连接可以是对称的或非对称的,因此基于拓扑的图可以是有向的或无向的。拓扑只表示非欧几里得空间中的连接,因此基于拓扑的图是未加权的。此外,社会系统中的拓扑结构通常在相当长的一段时间内是固定的,所以我们可以将它们视为静态图。

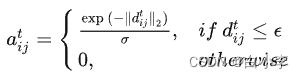

基于距离的时空图

基于距离的时空图是一种用于表示时间和空间关系的图形结构,其中节点之间的连接关系是基于它们之间的距离或空间关系而建立的。这种图形结构可以用于描述空间中的邻近性、距离、路径等信息,并结合时间维度来展示时空上的变化。

在基于距离的时空图中,节点表示空间位置或地点,边表示空间位置之间的距离或连接关系。可以使用欧氏距离、曼哈顿距离、最短路径距离等度量方法来计算节点之间的距离。边的权重可以反映空间位置之间的距离程度,或者表示它们之间的邻近性。

基于相似性的时空图

基于相似性的时空图是一种用于表示时间和空间关系的图形结构,其中节点之间的连接关系是基于它们之间的相似性或相关性而建立的。这种图形结构可以用于描述空间中的相似性、关联性、模式等信息,并结合时间维度来展示时空上的变化。

在基于相似性的时空图中,节点表示空间位置或对象,边表示节点之间的相似性或相关性。相似性可以基于不同的度量方法计算,例如距离度量、相关系数、相似性指数等。边的权重可以反映节点之间的相似程度,或者表示它们之间的关联强度。

2、图在环境中的应用

空气质量预测 Air Quality Prediction

空间质量指数(AQI)、PM2.5和排放量是我们关心的指标,这些相关数据有城市级或国家级观测站收集,由于空气流动性,距离较近或风向相同的观测站可能收集到相关的结果。构建基于时空图的深度学习模型不仅可以建立这种空间相关性,还可以捕捉空气质量的时变动态性。

-

空间相关性建模:时空图可以展示不同空间位置之间的相关性和相互影响。通过分析历史空气质量数据,可以构建时空图来捕捉不同地点之间的空间相关性。这样可以利用邻近地点的信息来预测目标地点的空气质量,并提高预测的准确性。

-

时间序列预测:时空图可以用于建模和分析时间序列上的空气质量数据。通过将不同时间点的数据连接起来,形成时空图,可以捕捉到空气质量随时间变化的模式和趋势。这样可以利用时间序列分析和预测方法,预测未来时间点的空气质量水平。

-

空间插值和填补:时空图可以用于进行空间插值和填补,填补缺失的空气质量数据。通过分析相邻地点的数据和空间相关性,可以利用时空图的结构来预测缺失位置的空气质量值,从而提供完整的数据集用于预测和分析。

-

空气污染扩散模拟:时空图可以用于建立空气污染扩散模型。通过考虑空间位置之间的相对位置和空气流动的影响,可以构建时空图来模拟和预测空气污染物的传播和扩散情况。这样可以帮助预测污染物的扩散范围和潜在的影响区域。

气象预测 Meteorological Prediction

与空气质量数据类似,气象数据也由分布的观测站收集。然而,不同站点之间的相关性可能更加复杂,并且容易受到更多因素的影响。

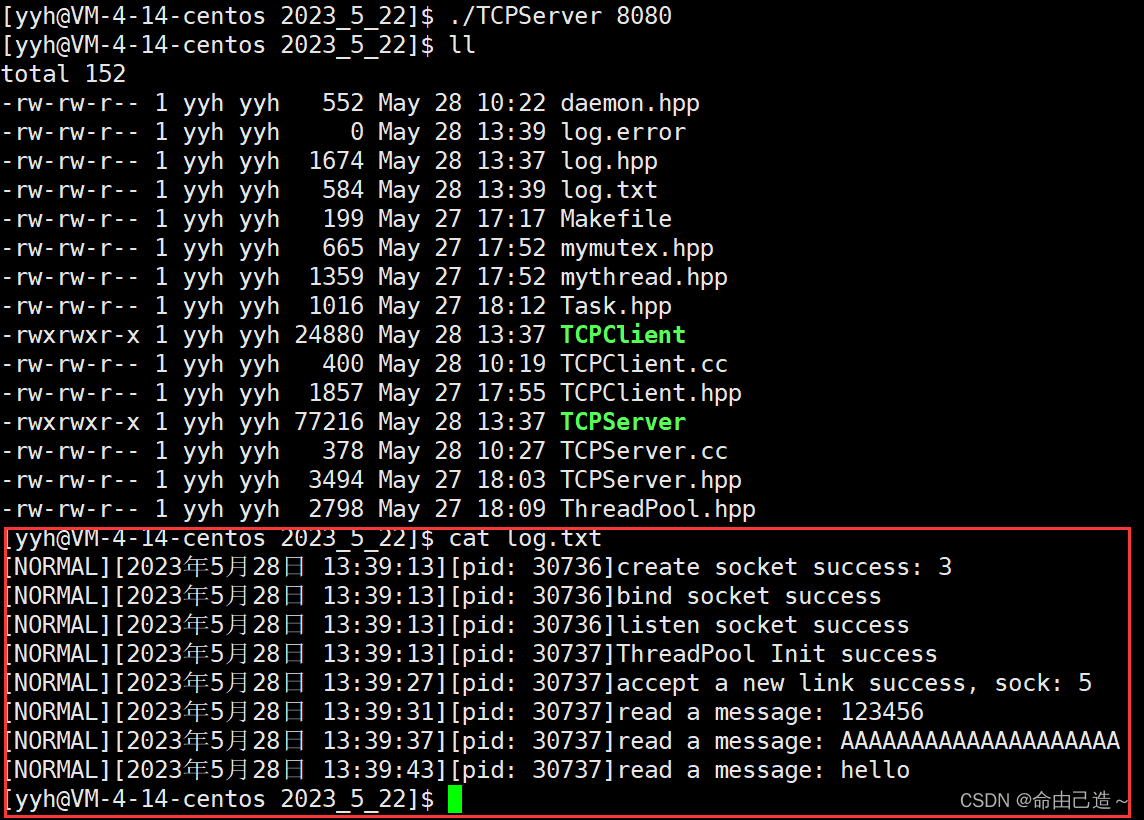

3、STGNN

STGNN是指时空图神经网络。它是一种用于处理时空数据的神经网络模型,能够有效地对时空图数据进行建模和预测。STGNN结合了图神经网络(Graph Neural Network,GNN)和时间序列建模的技术,具备处理时空图数据的能力。它适用于具有复杂时空关系的数据集,如交通流量、气象数据、空气质量数据等。

STGNN的主要思想是将时空数据表示为图结构,并利用图神经网络的方法对图数据进行建模和分析。它能够同时考虑节点之间的空间关系和时间关系,以捕捉节点在时空维度上的动态变化。

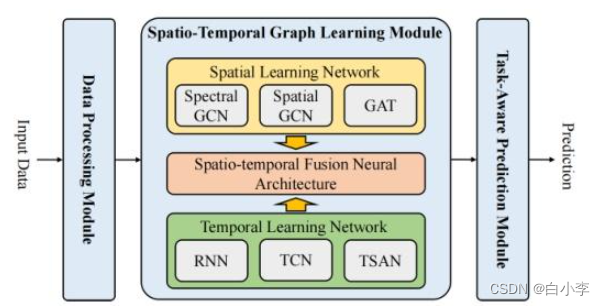

STGNN主要由3个模块构成。数据处理模块,从原始数据中构建时空图数据。时空学习模块,捕获复杂的社会系统中隐藏的时空依赖关系。任务感知预测模块:将STGLM中的时空隐藏表示映射到下游预测任务的空间中。

通常通过一定的时空融合神经网络架构将空间学习网络和时间学习网络有机结合在一起。对于空间学习网络,可以选择谱域图卷积网络、空间图卷积网络、图注意力网络GAT;对于时间学习网络,可以选择循环神经网络RNN、时间卷积网络TCN、时间自注意力网络TSAN。

总结

在结束本周的学习后,下周计划开展论文的工作,尽量将论文框架搭建起来,确定思路和逻辑,早日动工。